Se vähän mitä casuaalina pelailen Fornitea niin UE5 siirtyminen on moninkertaistanut tehovaatimukset ja AINA kun tulee uusi "Chapter" niin FPS kyykkää tai "droppailee" vaikka mikään ei koneessa muutu eikä pelissäkään näytä oikein mitään visuaalisesti muuttuneen.

Väitänkin että Fortnite on UEnginen testialusta ja siellä on vaikki mitä juttuja valikoivasti eri laumoille kokeilussa. Ainakin EAC jaottelee pelaajia eri ryhmiin joille tehdään eri tarkistuksia.

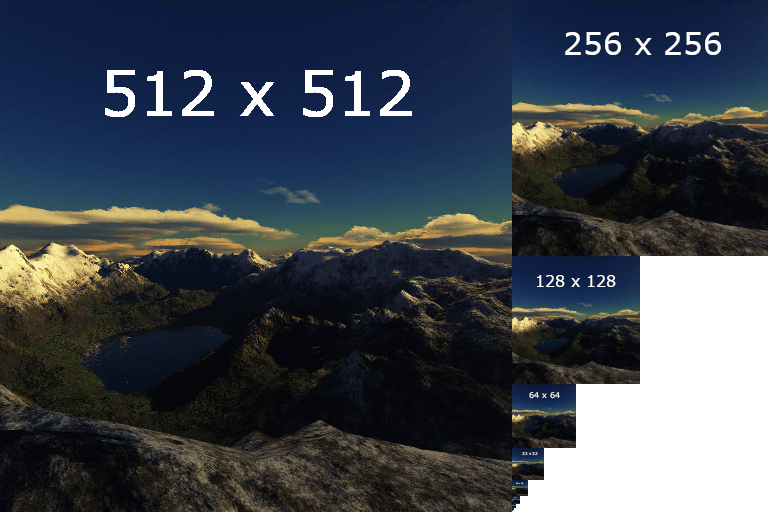

Noista asetuksista: minullakun on kustannustehokkaita koneita käytössä ja varsinkin kun on kasvanut Pong-aikakaudella niin kaikki resoluutiot kelpaa, kunhan FPS on aina vähintään 60, eikä mitään droppeja ole sen alle ja latenssit on kunnossa. Fortnitessa itselläni on etäisyys epic ja kaikki muut minimissä kun FPS tuntuu kyykkäilevän vähemmän.

En paljoa aiheesta ymmärrä mutta tää oli aikas mielenkiintoinen video "Epic's Unreal Optimization Disaster | Why Nanite Tanks Performance!"