Onko UE5 ainoa pelimoottori?Miten teet pelistä paremman näköisen isommilla tekstuureilla kun UE5 jo tukee 8k tekstuureita per objekti + striimaus+pakkaus ja myös keskusmuistin käyttäminen cachena? Ongelma ue5:en kanssa ei enää ole niinkään muistinmäärä vaan se paljonko levytilaa on varaa käyttää pelin asennukseen.

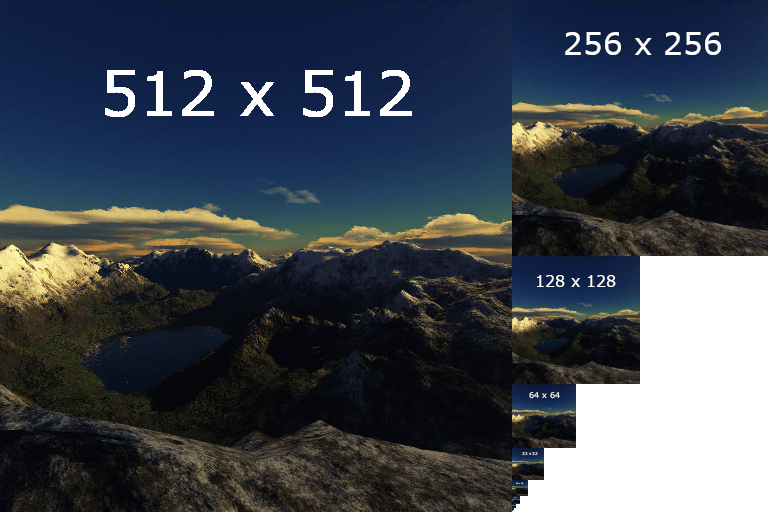

Ruudulla jos objekti kattaa 128x128 pikseliä niin siihen käytetään soveltuvaa mipmap tasoa piirtämiseen eikä 8k tekstuuria. UE5 osaa striimata oikeat mipmap tasot gpu:n muistiin ilman, että tarvii pitää originaalia muistissa.

Why you really should be using mipmapping in your graphics applications - Imagination

Mipmapping is key to increased image quality and better performance. Find out what mipmaps are and why you should be using it.blog.imaginationtech.com

Miksi pelikorttiin kuten 5090 laitetaan yli 4 gigatavua muistia, jos sillä ei ole enää merkitystä?

" ketjut on lähinnä räbän heiniä. Ainoa mitä en oo omistanut on sininen näyttis ja vihreä prossu.

" ketjut on lähinnä räbän heiniä. Ainoa mitä en oo omistanut on sininen näyttis ja vihreä prossu.