Lare

Error 404

- Liittynyt

- 13.11.2016

- Viestejä

- 5 216

Riippuu käyttäjästä. Jotkut eivät huomaa, vaikka tekstuurit eivät lataudu kunnolla. Itse taas fiilistelen peleissä hyvin tehtyjä yksityiskohtia. Esimerkiksi The Last of Us Part 1 on nyt menossa ja siinä on panostettu valtavasti yksityiskohtiin ja tykkään lukea julisteita ja vaikka levyjen ja kirjojen kansia. Noista irtoaa jopa uutta lorea. Kyllä se vähän häiritsisi, jos kaikki olisi niin puuroa, ettei saa selvää. Hiljattain pelasin Metro Exodus Enhanced Editionia ja kirosin jatkuvasti sumeita tekstuureita muuten upeassa pelissä ja googlasin, jos ongelmaan olisi joku ratkaisu.Se, ettei löydä pelien asetuksista sitä säätöä, jolla tekstuureista valitaan vähän vähemmän tarkat versiot on kyllä melko käyttäjän oma ongelma.

Sen, että seinä näyttää vähän epätarkemmalta kun sitä menee metrin päästä paikallaan tuijottelemaan, ei pitäisi olla oieka ongelma jonka takia tarvii näyttistä vaihtaa

Mitä höpö höpöä se on, jos sanon sekä säteenseurannan että DLSS 3:n lisäävän muistin kulutusta. Tuo on ihan fakta, jonka voi kokeilla ja todeta itsekinHöpöhöpö.

Siinä vaiheessa kun peli tehdään täysin säteenjäljityksellä, se muistintarve putoaa merkittävästi, koska ei tarvi olla ziljoona purkkavalopuskuria muistissa.

En usko, että pelejä ihan heti ruvetaan tekemään rasterointi täysin unohtaen. Ihmisten vanha rauta ja konsolit on yhä taakkana.

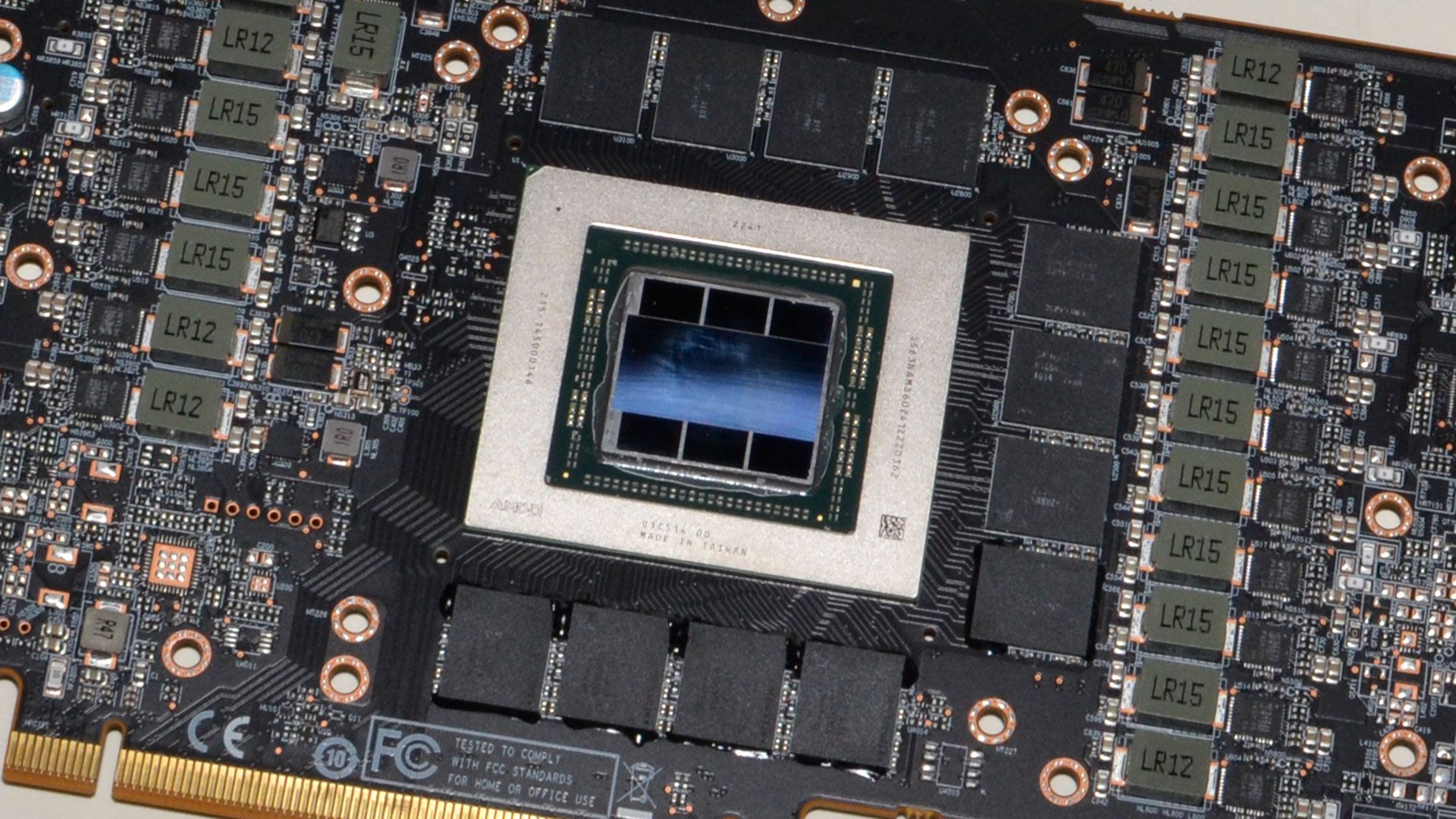

En usko, että pelejä ihan heti ruvetaan tekemään rasterointi täysin unohtaen. Ihmisten vanha rauta ja konsolit on yhä taakkana.Omalla 8GB RTX 3070 Ti kortilla ei yksinkertaisesti meinannut löytyä asetuksia moniin uusiin peleihin, joilla kuva ei näyttänyt puurolta tai saisi tasaiset frametimet, vaikka kyseessä oli tehokas ja hyvin kellottuva kortti. Esimerkiksi HU:lla oli Hogwart's Legacyssa ja The Last of Us Part 1:ssä 1080p Medium asetuksillakin frametimejen kanssa ongelmaa. Vielä hetki sitten noita mainostettiin 1440p High-Ultra korteiksi. Moni varoitti, että 8GB ei tule riittämään, mutta suurin osa, kuten itse, en uskonut. Useasta pelistä katosi kaikki FPS dropit ja ongelmat korttia vaihtamalla. Ja esimerkiksi Forspokenissa ja Deathloopissa näyttis ei vain välillä suostunut lataamaan tekstuureita, vaikka seisoisi päällään."huoletta tappiin" on typerä asenne. Ne asetukset on säädettäviä sen takia, että ne säädetään sen raudan mukaan millä pelataan. Se, että maksetaan satoja euroja lisää näyttiksestä sen takia että voi "huoletta laittaa tappiin" on vaan typeryyttä.

Ja jos se vaiva on siinä se ongelma, ja haluaa sitä "huolettomuutta" niin melkein joka pelistä löytyy asetuksista toiminto, jolla peli itse arpoo itse itselleen sellaiset asetukset, että se pyörii sillä raudalla hyvin.

Onhan se vähän suolaista, että Nvidialla pitää laittaa melkein 1.5 tonnia rahaa tiskiin, jotta saa kortin, jossa on vasta monen suosittelema määrä VRAMia 1440p-resoluutiolle ja jota AMD ja Intel tarjoaa 400-500€ kortteihin. Aika harvalla on varaa semmoiseen lopulta. Itse arvoin pariin kertaan tonnin RX 7900 XT ostoskorissa ja en lopulta pystynyt, vaan ostin 709€ RX 6950 XT:n.Jos haluaa sen isomman muistin ja tarkemmat tekstuurit, sitten ostaa sen kalliimman 4080n. Mikä tässä on niin vaikeaa ymmärtää?

Itse koin juuri kantapään kautta sen, että 8GB muisti ei yhtäkkiä riitä mihinkään ja melkein jokaisessa uudessa ja myös vanhemmassa pelissä on ongelmia, jotka eivät välttämättä korjaannu edes asetuksia säätämällä. Useiden YouTube-kanavien, tekniikkasivustojen ja pelaajien mielipide oli, että Nvidia laski tarkkaan, mikä muistimäärä riittää juuri sen sukupolven ajan ja itse uskon samaan. 12GB on nyt vielä ihan kivasti 1440p-resoluutiolla. Toki esimerkiksi RTX 4070 Ti on hyvin tehokas kortti ja etenkin frame generationin päällä pyörittää pelejä varmasti vielä vuosien päästä. Lähivuosina voi kuitenkin tulla pelejä, joissa kortin teho riittäisi vaikka näyttävään säteenseurantaan ja FG päällä pyörisi hyvin, mutta 12GB muisti ei riitä. Ja jos kyseisessä pelissä FG hörppää esimerkiksi gigan näyttömuistia ja RT useamman, niin sitä ei voi ohittaa sanomalla höpö höpö. Esimerkiksi The Last of Us Part 1 vetää 1440p-resoluutiolla asetuksista riippuen 10-12GB pelkällä rasteroinnilla, niin jos PC:lle tuotaisiin RT ja DLSS3 siihen, voisi käydä huonosti. Itse olen sitä mieltä, että RTX 4070 korttiin 12GB on vielä hyväksyttävä, mutta vähän niukasti, mutta tehokkaampiin liian vähän. 8GB RTX 4060 -sarja ja RX 7600 taas on yksi vitsi.

Tuossa HU:n videolla näkee vielä, miten RTX 3070 yskii 1080p resoluutiolla ja kaikki mediumilla ja 16GB RX 6800 sen kuin porskuttaa vaikka kaikki ultralla. Samoin Forspokenissa näytetään, miten tekstuurit ovat oikeasti ihan puuroa, kun muistiin ei mahdu. Muistan todenneeni omalla kortilla samassa pelissä, että tekstuurien asetuksien vaihtaminen ei tuohon auttanut. Resident Evil 4:ssä RTX 3070 yskii jopa vaatimattomilla 1GB tekstuureilla, kun RX 6800 painelee 8GB tekstuureilla, eli paha tuossa enää sanoa "Pudota tekstuureita, niin mitään ongelmaa ei ole". En yhtään ihmettelisi, jos lähivuosina tulisi vastaavilla tuloksilla vastaava video "RTX 4070 12GB vs RX 7900 XT". Toki konsolisukupolvi ei välttämättä heti vaihdu, mutta konsoleilla datan striimaus on älyttömän nopeaa ja PC:lle voidaan tuoda ekslusiivisia ominaisuuksia, jotka lisäävät muistin käyttöä.

Eli tiivistäen voisin sanoa, että 8GB RTX 3070 Ti kortin VRAM-ongelmista oppineena huolehdin, että seuraavassa kortissa on vähintään 16GB muistia. 8GB muistista varoiteltiin, kun se alkoi olla jo rajoilla, mutta varoituksia ei kuunneltu. Moni väitti kovasti, ettei ongelmia tule, mutta toisin kävi. 12GB muistille voi käydä lähivuosina samoin etenkin tehokkaampien korttien kanssa ja RT ja DLSS 3 päällä. Tai sitten ei käy, mutta itse en ottanut riskiä.

Viimeksi muokattu: