Pääosin taiwanissa. Usassa on (tai ainakin on rakenteilla) jokunen tehdas. Olisikohan kiinassakin ollut joku tehdas jolla tuotetaan halpoja piisiruja.Missäs tsmc:n tehtaat ovatkaan?

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2024 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Virallinen: NVIDIA vs AMD (vs Intel) keskustelu- ja väittelyketju

- Keskustelun aloittaja Sampsa

- Aloitettu

- Liittynyt

- 13.11.2018

- Viestejä

- 77

Ihan pieni googlettaminen ei olisi pahasta https://www.tsmc.com/english/aboutTSMC/TSMC_Fabs

Sitten voi olla oikein fiksua miettiä noita valmistusvaihtoehtoja. Jos Kiina päättää hyökätä Taiwaniin, niin sieltä ei välttämättä lähde yhtään piiriä.. Ja se on täysin mahdollista...Pääosin taiwanissa. Usassa on (tai ainakin on rakenteilla) jokunen tehdas. Olisikohan kiinassakin ollut joku tehdas jolla tuotetaan halpoja piisiruja.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 812

Olen samaa mieltä siinä, että piirituotannon osittainenkin siirtäminen Yhdysvaltoihin tuo omaa vakuttavuuttaan yrityksen toimintakyvylle myös kriisitilanteissa.Sitten voi olla oikein fiksua miettiä noita valmistusvaihtoehtoja. Jos Kiina päättää hyökätä Taiwaniin, niin sieltä ei välttämättä lähde yhtään piiriä.. Ja se on täysin mahdollista...

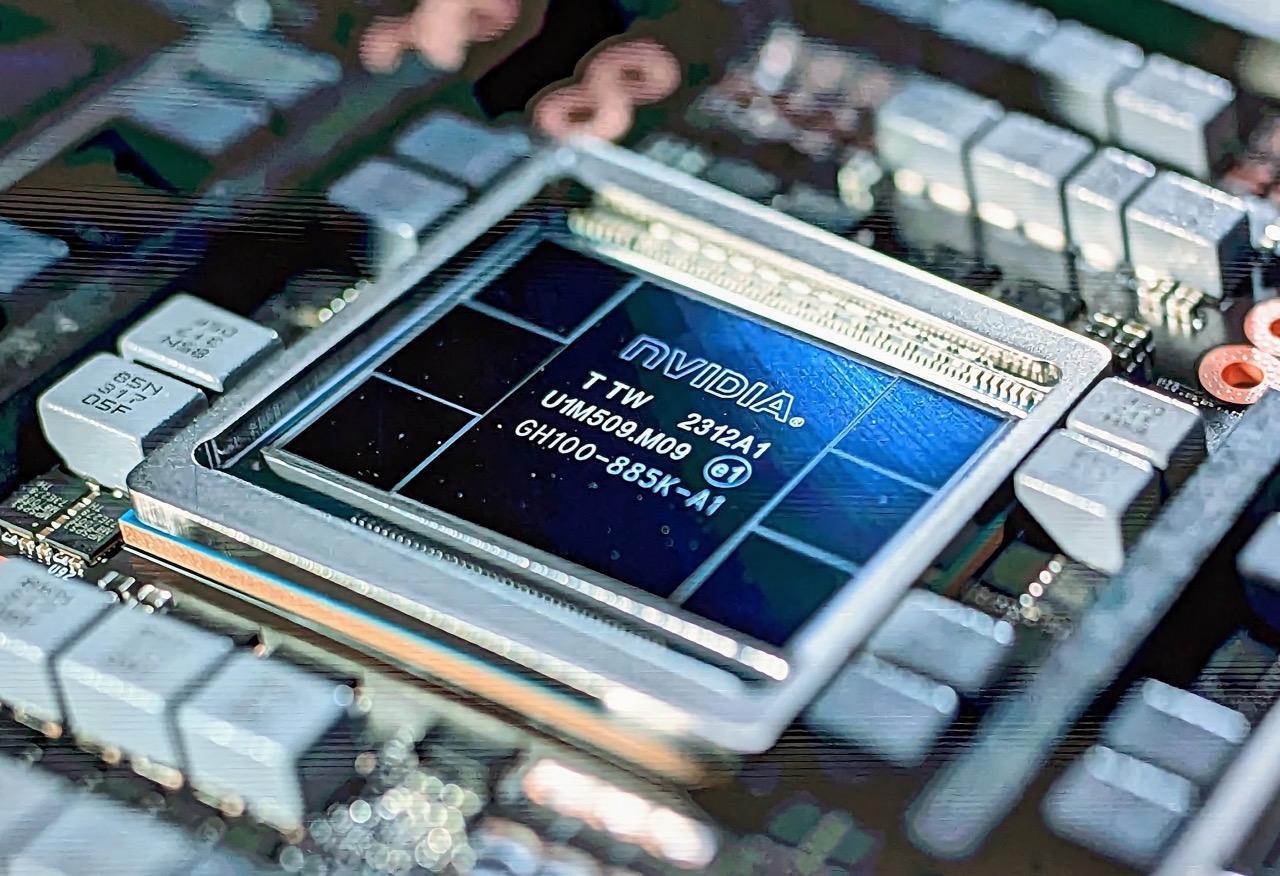

Toisaalta, kun katsoo esim. nVidian HGX H100 laskenta/AI-moduulin (8x Hopper) komponenttimäärää (35 000 komponttia), niin kaikkien noiden saatavuus kriisitilanteissa ilman Kiinasta/Taiwanista tapahtuvaa hankintaa voi olla - en sano mahdotonta - mutta jonkin verran haastavanpaa.

'Something else that was a fun nugget is that the NVIDIA HGX H100 is $200,000, weighs 60lbs, and has over 35,000 components. '

NVIDIA Computex 2023 Keynote with NVIDIA DGX GH200 MGX and Spectrum 4

We are covering the NVIDIA Computex 2023 keynote and the NVIDIA DGX GH200 Grace-Hopper launch, MGX, Spectrum-X, Spectrum-4, and more

Niin.. Jos Kiina hyökkää Taiwaniin ja länsimaat yrittävät kiukutella Kiinalle pakotteilla, niin Euroopassa voidaan sen jälkeen valmistaa vain sirppejä ja vasaroita Venäjän myyntiin..Olen samaa mieltä siinä, että piirituotannon osittainenkin siirtäminen Yhdysvaltoihin tuo omaa vakuttavuuttaan yrityksen toimintakyvylle myös kriisitilanteissa.

Toisaalta, kun katsoo esim. nVidian HGX H100 laskenta/AI-moduulin (8x Hopper) komponenttimäärää (35 000 komponttia), niin kaikkien noiden saatavuus kriisitilanteissa ilman Kiinasta/Taiwanista tapahtuvaa hankintaa voi olla - en sano mahdotonta - mutta jonkin verran haastavanpaa.

'Something else that was a fun nugget is that the NVIDIA HGX H100 is $200,000, weighs 60lbs, and has over 35,000 components. '

NVIDIA Computex 2023 Keynote with NVIDIA DGX GH200 MGX and Spectrum 4

We are covering the NVIDIA Computex 2023 keynote and the NVIDIA DGX GH200 Grace-Hopper launch, MGX, Spectrum-X, Spectrum-4, and morewww.servethehome.com

- Liittynyt

- 12.09.2020

- Viestejä

- 1 969

Ja TSMC tehtaisiin on ostetettu ASML ja Zeissin kamaa europaasta? Eli ei enää uusia tehtaita tulisi Taiwaniin uusilla tekniikoilla. En sitten tiedä miten kävisi nykyisille tehtaille sodan aikana/jälkeen...Niin.. Jos Kiina hyökkää Taiwaniin ja länsimaat yrittävät kiukutella Kiinalle pakotteilla, niin Euroopassa voidaan sen jälkeen valmistaa vain sirppejä ja vasaroita Venäjän myyntiin..

Ongelmissa oltaisiin kaikki elektroniikan kanssa, se on totta.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 10 337

Mielenkiintoista nähdä mitä nvidia tekee sram:in skaalautumattomuuden kanssa. Yllätyksenä se tuskin tulee nvidian insinööreille.

Nvidia pystyisi jakamaan tuoteperheet useammalle eri prosessille. Kuitenkin aika monta piiriä kuluttajarautaa, erillinen konesali gpu ja konesali cpu ja autopuolen piirit. Autopuolen orin piiri 8nm samsung. Konesalipiirit ja pelipuolen lippulaiva joista voi pyytää isoa hintaa eri prosessilla kuin muut piirit joissa hinta on kriittinen tekijä?

2022 vuodelta esitys nvidialta missä puhuvat chipleteistä ja pinotuista muisteista. Varsinkin tuo gpu:n päälle pinottu muisti idea on vinkeä, mutta kuten heppu sanoo ei tulossa tuotteisiin tällä hetkellä, kun ongelmia riittää ratkaistavasti monella eri saralla. Ilmeisesti kuitenkin prototyyppejä ovat rakentaneet.

Linkki aikaleimalla:

Parit kuvat videolta avaamaan sisältöä

Samassa videossa on chiplettien välisestä kommunikaatiosta myös paljon asiaa.

Nvidia pystyisi jakamaan tuoteperheet useammalle eri prosessille. Kuitenkin aika monta piiriä kuluttajarautaa, erillinen konesali gpu ja konesali cpu ja autopuolen piirit. Autopuolen orin piiri 8nm samsung. Konesalipiirit ja pelipuolen lippulaiva joista voi pyytää isoa hintaa eri prosessilla kuin muut piirit joissa hinta on kriittinen tekijä?

2022 vuodelta esitys nvidialta missä puhuvat chipleteistä ja pinotuista muisteista. Varsinkin tuo gpu:n päälle pinottu muisti idea on vinkeä, mutta kuten heppu sanoo ei tulossa tuotteisiin tällä hetkellä, kun ongelmia riittää ratkaistavasti monella eri saralla. Ilmeisesti kuitenkin prototyyppejä ovat rakentaneet.

Linkki aikaleimalla:

Parit kuvat videolta avaamaan sisältöä

Samassa videossa on chiplettien välisestä kommunikaatiosta myös paljon asiaa.

Viimeksi muokattu:

- Liittynyt

- 14.05.2021

- Viestejä

- 664

3070 persauksessa vipu mistä vaihdetaan 8/16gb muistin määrää, tulee melkein vanhan ajan turbonapit mieleen

videocardz.com

videocardz.com

This GeForce RTX 3070 comes with a physical 8GB/16GB memory switch - VideoCardz.com

NVIDIA RTX 3070 features a physical memory capacity switch A video from Casual Gamers shows a graphics card NVIDIA would never make. Paulo Gomes team and Casual Gamers have teamed up for an interesting project. Brazilian modders have been making some crazy alterations to GeForce and Radeon GPUs...

- Liittynyt

- 17.10.2016

- Viestejä

- 1 896

Omalla kohdalla myös edellisen kerran törmännyt ajuriongelmiin AMD:n hd 7970 ja Nvidian GTX 780 korttien kanssa. Sen jälkeen GTX 1080, RTX 3060ti ja RX 6800xt ei ole ajuriongelmia ollut millään. Joskin oma käyttöni on käytännössä pelaamista, joten mitään kovin spesiaalia nuo ei ole joutunut suorittamaan. Tästä voisi päätellä, että ajurikehitys on parantunut molemmilla valmistajilla viimevuosina. Otanta toki pieni.

On se luultavasti. Äskettäin kun vaihdoin 1070 Ti:stä 6950 XT:hen niin meni Win 10 sisään sukkana kuin mitään ei olisi tapahtunut. Vaikka vaihtui 2 sukupolvea vanhemmasta vihreästä leiristä punaiseen. Sikäli nuo BSODit on ihan toisessa ääripäässä.Tästä voisi päätellä, että ajurikehitys on parantunut molemmilla valmistajilla viimevuosina. Otanta toki pieni.

Toki vetelin sitten koko windowsin uusiksi, vaikka edes AMD:n ajureita ei tarvinnut toimiakseen työpöytä/nettikäytössä.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 357

Omalla kohdalla myös edellisen kerran törmännyt ajuriongelmiin AMD:n hd 7970 ja Nvidian GTX 780 korttien kanssa. Sen jälkeen GTX 1080, RTX 3060ti ja RX 6800xt ei ole ajuriongelmia ollut millään. Joskin oma käyttöni on käytännössä pelaamista, joten mitään kovin spesiaalia nuo ei ole joutunut suorittamaan. Tästä voisi päätellä, että ajurikehitys on parantunut molemmilla valmistajilla viimevuosina. Otanta toki pieni.

Tässä mielestäni aika hyvä video asiasta.

Kaverilla siis ollut nvidian kortti aina. Mielestäni varsin hyvin kertoo erot.

Ja sitten toiseen asiaan. Der8auer pääsi kuvaamaan melko vapaasti GPU tuotantoa tehtaalle.

- Liittynyt

- 13.12.2016

- Viestejä

- 5 171

Tuossa videossa ei ole kyllä oikein mitään "hyvää". No ihan hyvin esitteli AMD ajurisoftan pööllisin puolin.

Mutta muuten taas perinteinen, millään missä NVIDIA on parempi, ei ole mitään väliä, vollotus.

Miksi ei voisi suoraan ja pelkästään vaan sanoa, että nämä on huonompaa ja joudut tekemään niiden osalta kompromissin, jos haluat AMD korttia käyttää. Aina pitää kuitenkin se sama "ei sitä kukaan käytä/huomaa" itkuvirsi pistää mukaan. Se tuo mukaan semmosen vähän oudon "AMD fanboy" vivahteen, vaikka tämäkin kaveri muka on olevinaan neutraali. Sanoisi että ne asiat ei ole minulle tärkeitä, enkä minä huomaa, mutta aina pitää tunkea se täydellinen yleistys sinne mukaan.

Videon alku jo kyllä kertoi täysin, että tämmöinen täysi "muka asiallinen" ylistysvideo sieltä on tulossa. Niin juustoista kamaa oli alku, että huh hah hei.

Mutta muuten taas perinteinen, millään missä NVIDIA on parempi, ei ole mitään väliä, vollotus.

Miksi ei voisi suoraan ja pelkästään vaan sanoa, että nämä on huonompaa ja joudut tekemään niiden osalta kompromissin, jos haluat AMD korttia käyttää. Aina pitää kuitenkin se sama "ei sitä kukaan käytä/huomaa" itkuvirsi pistää mukaan. Se tuo mukaan semmosen vähän oudon "AMD fanboy" vivahteen, vaikka tämäkin kaveri muka on olevinaan neutraali. Sanoisi että ne asiat ei ole minulle tärkeitä, enkä minä huomaa, mutta aina pitää tunkea se täydellinen yleistys sinne mukaan.

Videon alku jo kyllä kertoi täysin, että tämmöinen täysi "muka asiallinen" ylistysvideo sieltä on tulossa. Niin juustoista kamaa oli alku, että huh hah hei.

- Liittynyt

- 14.10.2016

- Viestejä

- 23 489

Sulta unohtui se osuus "että nämä on huonompaa ja joudut tekemään niiden osalta kompromissin, jos haluat NVIDIAn korttia käyttää". Ja sekään ei ole ilmeisesti mahdollista, että neutraalista näkökulmasta jokin asia joka on yhdellä valmistajalla parempi tai huonompi olisi merkityksetöntä?Mutta muuten taas perinteinen, millään missä NVIDIA on parempi, ei ole mitään väliä, vollotus.

Miksi ei voisi suoraan ja pelkästään vaan sanoa, että nämä on huonompaa ja joudut tekemään niiden osalta kompromissin, jos haluat AMD korttia käyttää. Aina pitää kuitenkin se sama "ei sitä kukaan käytä/huomaa" itkuvirsi pistää mukaan. Se tuo mukaan semmosen vähän oudon "AMD fanboy" vivahteen, vaikka tämäkin kaveri muka on olevinaan neutraali. Sanoisi että ne asiat ei ole minulle tärkeitä, enkä minä huomaa, mutta aina pitää tunkea se täydellinen yleistys sinne mukaan.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 738

Onhan se selvä että jos nvidian poropietariominaisuuksia käyttää eikä mikään avoin vaihtoehto kelpaa niin pakkohan se on silloin nvidia valita. Jos taas kevyempi säteenseuranta, FSR/XeSS ja OpenCL riittää niin kannattaa valita kortti sen mukaan missä muut ominaisuudet vastaa paremmin omia tarpeita. Esim. monen näytön tuki on AMD:lla kehittyneempi kuluttajalaitteissa (Eyefinityyn voit laittaa 6 ruutua ja vaikka jokaiseen eri resoluutiot ja virkistystaajuudet).

- Liittynyt

- 08.08.2019

- Viestejä

- 2 507

Kun ei viesti kelpaa, niin ammutaan viestinviejä. Ja pata kattilaa soimaa. Henkilöt jotka ei itse pysty katsomaan eroja neutraalisti, kritisoi kuinka videon tekijä X ei pysty katsomaan eroja neutraalisti. Sama Redditissä, Hardware Unboxed on AMD:n sylikoira vaikka julkaisee videoita jossa korostetaan DLSS paremmuutta FSR nähden ja HWU antaa jatkuvasti kritiikkiä AMD:nkin suuntaan. Edit: En viitannut ylläoleviin käyttäjiin, vaan yleiseen ilmapiiriin.

Ja nimenomaan niitä kompromisseja Nvidiankin korteilla joutuu tehdä esim. säteenseurannan kanssa. Pienempiä toki kuin AMD kanssa. Säteenseuranta on hyvä keppihevonen Nvidian faneille.

Ja nimenomaan niitä kompromisseja Nvidiankin korteilla joutuu tehdä esim. säteenseurannan kanssa. Pienempiä toki kuin AMD kanssa. Säteenseuranta on hyvä keppihevonen Nvidian faneille.

Viimeksi muokattu:

- Liittynyt

- 13.12.2016

- Viestejä

- 5 171

Minä katson asiaa täysin neutraalisti. Olen ensimmäisenä ostamassa AMD:n kortin jos ja kun he saavat yhtä hyvän tai paremman tuotteen markkinoille vs NVIDIA, koska haluan tukea kilpailua. Tällä hetkellä AMD on omiin mieltymyksiin/tarpeisiin nähden jäljessä ja aivan selkeästi. Itse asiassa Vegan odotuksesta asti ollut itsellä se tilanne, että heti kun AMD saa vaan yhtä hyvän/paremman kortin ulos, niin ostan sen. Ei ole vaan tämä skenaario toteutunut. Valitettavasti.

Toki todelliset "periaatteen miehet" ostaisi AMD:tä sen takia, että AMD:llä olisi enemmän rahaa pistää korttien/ominaisuuksien kehitykseen, mutta itseltä ei kyllä löydy niin paljoa periaatetta, että käyttäisin rahaa tuotteeseen, joka ei täytä kunnolla omia toiveita.

Prossupuolella oli sama tilanne ja ostin heti AMD:n prossun, kun olivat rinnalla pelikäytössä Intelin kanssa. No 3700x ei ihan kyllä pärjännyt parhaille inteleille, mutta oli tarpeeksi lähellä ja prossupuolella ei ihan niin kriittistä ile ollut se teho.

Miksi pitää koittaa pakottaa omaa mielipidettä käyttämällä yleistäviä ilmaisuja, "ei ketään kiinnosta"/"ei sitä kukaan käytä". Yhtään noita latteuksia latovaa YT -pelleä ei voi ottaa vakavasti. Sama toki toimii toisen suuntaan myös. Eli jos joku ylistää DLSS:n tai RT perffin olevan kaikille tärkeintä ja parasta ilman varauksia, niin ei se kovin neutraalia kuvaa anna. Ja jos joku pitää tällaista videota hyvänä, niin se kertoo minun mielestä tämän henkilön selvistä preferensseistä.

Objektiivisesti katsoen AMD kortit on tällä hetkellä miltei joka alueella heikompia, jos hintaa ei oteta huomioon. Toki jos itse en välittäisi RT:sta, VR:stä, tai en kokisi että DLSS2/3 on tärkeitä, niin ihan hyvin voisin ostaa esim. 7900XTX:n. Toki se rahapuoli on monella tässä myös iso tekijä. Jos olisi tiukka budjetti, niin varmasti AMD:n tuotteet houkuttelisi itseäkin ihan eri lailla, kun nyt.

Toki todelliset "periaatteen miehet" ostaisi AMD:tä sen takia, että AMD:llä olisi enemmän rahaa pistää korttien/ominaisuuksien kehitykseen, mutta itseltä ei kyllä löydy niin paljoa periaatetta, että käyttäisin rahaa tuotteeseen, joka ei täytä kunnolla omia toiveita.

Prossupuolella oli sama tilanne ja ostin heti AMD:n prossun, kun olivat rinnalla pelikäytössä Intelin kanssa. No 3700x ei ihan kyllä pärjännyt parhaille inteleille, mutta oli tarpeeksi lähellä ja prossupuolella ei ihan niin kriittistä ile ollut se teho.

Miksi pitää koittaa pakottaa omaa mielipidettä käyttämällä yleistäviä ilmaisuja, "ei ketään kiinnosta"/"ei sitä kukaan käytä". Yhtään noita latteuksia latovaa YT -pelleä ei voi ottaa vakavasti. Sama toki toimii toisen suuntaan myös. Eli jos joku ylistää DLSS:n tai RT perffin olevan kaikille tärkeintä ja parasta ilman varauksia, niin ei se kovin neutraalia kuvaa anna. Ja jos joku pitää tällaista videota hyvänä, niin se kertoo minun mielestä tämän henkilön selvistä preferensseistä.

Objektiivisesti katsoen AMD kortit on tällä hetkellä miltei joka alueella heikompia, jos hintaa ei oteta huomioon. Toki jos itse en välittäisi RT:sta, VR:stä, tai en kokisi että DLSS2/3 on tärkeitä, niin ihan hyvin voisin ostaa esim. 7900XTX:n. Toki se rahapuoli on monella tässä myös iso tekijä. Jos olisi tiukka budjetti, niin varmasti AMD:n tuotteet houkuttelisi itseäkin ihan eri lailla, kun nyt.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 507

Objektiivisesti katsoen AMD kortit on tällä hetkellä miltei joka alueella heikompia, jos hintaa ei oteta huomioon. Toki jos itse en välittäisi RT:sta, VR:stä, tai en kokisi että DLSS2/3 on tärkeitä, niin ihan hyvin voisin ostaa esim. 7900XTX:n.

Hinta kannattaa ottaa huomioon. Toki on niitäkin jolle se ei merkitse mitään, vähemmistöä kenties nämä. Itse ostin AMD vs Nvidia hinnan erotuksella 2 lippua kesän festareille, ei siis ihan pikkusumma ollut eroa. Mainitsemissasi asioissa AMD on kiistatta jäljessä, mutta millä muilla osa-alueilla AMD on jäljessä kuin säteenseurannassa ja FSR vs DLSS?

Itse päätin unohtaa koko säteenseurannan toistaiseksi, ja hyvin pyörineet pelit AMD kortilla eikä ole tarvinut FSR vielä yhdessäkään pelissä. Katson säteenseurannan tilannetta sitten uudestaan, kun se oikeasti mullistaa pelikokemusta.

Noin muuten nyt kun satoja tunteja jo AMD- kortilla pelaamista takana, niin mullistavia eroja ei kummankaan näytönohjaimilla tule. Pelikokemus on lopulta muusta kiinni kuin 25% hienommista heijastuksista tms. Myös FPS kanssa itse pystyn vielä tekemään kompromisseja, ainakin hidastempoisissa singleplayer peleissä. Nykyisellä kortilla ei onneksi tarvi, paitsi jos alkaa RT kanssa vehtaamaan.

Lare

Error 404

- Liittynyt

- 13.11.2016

- Viestejä

- 4 736

Itse päädyin AMD:n korttiin juuri Nvidian VRAM-pihtaamisen kanssa. Tuli fiilis, että Nvidia nuukaili tahallaan muistin määrän kanssa, jotta pelaajien on pakko päivittää korttia muutaman vuoden päästä. Tuo taisi olla ihan fakta. Jos RTX 4070 Ti:ssä olisi 16GB muistia, olisi se varmaan ollut oma valinta. Pelkäsin kuitenkin, että 12GB muistin kanssa käy sama kuin kävi oman 8GB RTX 3070 Ti:n kanssa.

RX 6950 XT oli siitä houkutteleva, että hinta oli samalla tasolla RTX 4070:n kanssa, mutta raakaa tehoa 15-20% ja muistia 33% enemmän. Lisääntynyt teho on mukavaa ja isommasta muistista on nyt jo ollut hyötyä 1440p-resoluutiolla. Lähivuosina voi tulla lisää pelejä, joille 12GB on niukasti. Tavallaan myös tykkään, kun on massiivinen jäähy ison virrankulutuksen kesyttämiseksi. Etenkin edullisemmat RTX 4070:t olivat muovisia ja pienikokoisia ja näyttäisivät Noctua NH-D15:n rinnalla rimpuloilta. RX 6950 XT Red Devil on paljon katu-uskottavamman näköinen. Ja tämän mukana tuli hyvin mieluinen peli

Ajuriongelmia ei käytännössä ole ollut. Kaikki toimii AMD:lla kuin junan vessa. Päänäytön satunnainen vilkkuminen ja kakkosnäytön pikselöityminen, jotka olivat tälläkin foorumilla todettuja Nvidian ajuriongelmia, katosivat heti. Paljon eri pelejä ladannut ja todennut toimivaksi ja hyvin pyöriväksi. Ainoa ongelma oli 110C Hot Spot lämmöt, jotka ovat etenkin PowerColorin kiusa. Takuuseen lähettämisen sijaan vaihdoin itse tahnat ja kortti rokkaa nyt hyvin viileänä. Sain tuon myötä Power Limittiä ylös, mikä tarkoittaa isompia kelloja peleissä.

1440p-resoluutiolla voi heittää pääasiassa kaikki grafiikat tappiin ja pelit pyörivät silti hyvin ison muistin ja raa'an tehon vuoksi. RT-suorituskykykin yllätti. Metro Exodus Enhaned Editionia tullut pelailtua paljon ilman skaalaimia ja RT High -asetuksilla ja FPS huitelee usein 100:n tuntumassa. Samoin uudessa Witcher 3:ssa sai FSR 2.1 Qualityllä 3/4 RT-efekteistä päälle ja FPS ei ikinä tipu alle 60:n. Cyberpunk on ainoa, missä oikeasti ehkä kaipaisi enemmän potkua etenkin, kun FSR on siinä nyt rikki. Intel XeSS Quality näyttää tosi hyvältä, mutta sen kanssa voi pitää vain RT GI:n, AO:n ja auringonvarjot päällä, jotta pysyy yli 60 FPS. Toki nuokin ovat tuntuva parannus kuvanlaatuun.

UE5:n toteutus säteenseurannalle vaikuttaa siitä lupaavalta, että AMD:n suorituskyky on sillä hyvä. Samoin on myös toivoa, että ajurit kehittyvät vielä. Hiljattain tuli ajuripäivitys, joka nosti ainakin raakaa RT-suorituskykyä. Esimerkiksi IO-Techin testissä RX 6950 XT sai Port Royalin DirectX Ray Tracing testissä jonkun 30 FPS, kun itse rykäisen omalla kortilla 42 FPS. Vielä kun saisi peleihin vastaavan tehonlisäyksen. Sitten taas esimerkiksi uudessta Star Warsissa on UE4 pelimoottorina, Global Illumination ja heijastukset toteutettu säteenseurannalla ja silti AMD pärjää siinä yllättävän hyvin. Toki peli taisi olla jossain määrin rikki ainakin julkaisussa.

RX 6950 XT oli siitä houkutteleva, että hinta oli samalla tasolla RTX 4070:n kanssa, mutta raakaa tehoa 15-20% ja muistia 33% enemmän. Lisääntynyt teho on mukavaa ja isommasta muistista on nyt jo ollut hyötyä 1440p-resoluutiolla. Lähivuosina voi tulla lisää pelejä, joille 12GB on niukasti. Tavallaan myös tykkään, kun on massiivinen jäähy ison virrankulutuksen kesyttämiseksi. Etenkin edullisemmat RTX 4070:t olivat muovisia ja pienikokoisia ja näyttäisivät Noctua NH-D15:n rinnalla rimpuloilta. RX 6950 XT Red Devil on paljon katu-uskottavamman näköinen. Ja tämän mukana tuli hyvin mieluinen peli

Ajuriongelmia ei käytännössä ole ollut. Kaikki toimii AMD:lla kuin junan vessa. Päänäytön satunnainen vilkkuminen ja kakkosnäytön pikselöityminen, jotka olivat tälläkin foorumilla todettuja Nvidian ajuriongelmia, katosivat heti. Paljon eri pelejä ladannut ja todennut toimivaksi ja hyvin pyöriväksi. Ainoa ongelma oli 110C Hot Spot lämmöt, jotka ovat etenkin PowerColorin kiusa. Takuuseen lähettämisen sijaan vaihdoin itse tahnat ja kortti rokkaa nyt hyvin viileänä. Sain tuon myötä Power Limittiä ylös, mikä tarkoittaa isompia kelloja peleissä.

1440p-resoluutiolla voi heittää pääasiassa kaikki grafiikat tappiin ja pelit pyörivät silti hyvin ison muistin ja raa'an tehon vuoksi. RT-suorituskykykin yllätti. Metro Exodus Enhaned Editionia tullut pelailtua paljon ilman skaalaimia ja RT High -asetuksilla ja FPS huitelee usein 100:n tuntumassa. Samoin uudessa Witcher 3:ssa sai FSR 2.1 Qualityllä 3/4 RT-efekteistä päälle ja FPS ei ikinä tipu alle 60:n. Cyberpunk on ainoa, missä oikeasti ehkä kaipaisi enemmän potkua etenkin, kun FSR on siinä nyt rikki. Intel XeSS Quality näyttää tosi hyvältä, mutta sen kanssa voi pitää vain RT GI:n, AO:n ja auringonvarjot päällä, jotta pysyy yli 60 FPS. Toki nuokin ovat tuntuva parannus kuvanlaatuun.

UE5:n toteutus säteenseurannalle vaikuttaa siitä lupaavalta, että AMD:n suorituskyky on sillä hyvä. Samoin on myös toivoa, että ajurit kehittyvät vielä. Hiljattain tuli ajuripäivitys, joka nosti ainakin raakaa RT-suorituskykyä. Esimerkiksi IO-Techin testissä RX 6950 XT sai Port Royalin DirectX Ray Tracing testissä jonkun 30 FPS, kun itse rykäisen omalla kortilla 42 FPS. Vielä kun saisi peleihin vastaavan tehonlisäyksen. Sitten taas esimerkiksi uudessta Star Warsissa on UE4 pelimoottorina, Global Illumination ja heijastukset toteutettu säteenseurannalla ja silti AMD pärjää siinä yllättävän hyvin. Toki peli taisi olla jossain määrin rikki ainakin julkaisussa.

Viimeksi muokattu:

- Liittynyt

- 22.10.2016

- Viestejä

- 12 155

Itse päädyin AMD:n korttiin juuri Nvidian VRAM-pihtaamisen kanssa. Tuli fiilis, että Nvidia nuukaili tahallaan muistin määrän kanssa, jotta pelaajien on pakko päivittää korttia muutaman vuoden päästä. Tuo taisi olla ihan fakta. Jos RTX 4070 Ti:ssä olisi 16GB muistia, olisi se varmaan ollut oma valinta. Pelkäsin kuitenkin, että 12GB muistin kanssa käy sama kuin kävi oman 8GB RTX 3070 Ti:n kanssa.

Kannattaisi ehkä yrittää ymmärtää asioita vähän enemmän sen sijaan että lähtee kehittelemään salaliittoteorioita tarkoituksellisesta cripplaamisesta.

Ei siihen AD104-piiriin olisi voinut (järkevästi, hyvällä suorituskyvyllä) kytkeä 12 gigaa muistia, kun sen muistiväylä on 192-bittinen.

Jotta 16 gigaa muistia olisi ollut mahdollinen, olisi muistiväylä pitänyt leventää 256 bittiin. Ja se olisi tarkoittanut myös itse piirille selvästi lisää kokoa, koska enemmän PHYitä.

Ja lisäksi PCB olisi ollut paljon kalliimpi. Tähän päälle niiden muistipiirien hinta.

Se 16 gigaa muistia olisi tullut paljon kalliimmaksi valmistaa.

Jos haluaa isomman ja kalliimman kortin, sitten ostaa 4080n, jossa on isompi AD103-piiri jossa se 256-bittinen muistiväylä.

RX 6950 XT oli siitä houkutteleva, että hinta oli samalla tasolla RTX 4070:n kanssa, mutta raakaa tehoa 15-20% ja muistia 33% enemmän. Lisääntynyt teho on mukavaa ja isommasta muistista on nyt jo ollut hyötyä 1440p-resoluutiolla. Lähivuosina voi tulla lisää pelejä, joille 12GB on niukasti.

Onko se 12 GiB niukasti riippuu täysin siitä, onko pakkomielle valita asetuksista "texture quality: ultra" vai onko järkeä siihen, että välillä valitseekin "texture quality: medium" jonka vaikutus kuvanlaatuun useimmissa peleissä jää melko pieneksi jos pelissä oikeasti pelaa sitä peliä eikä mene vaan tuijottelemaan seiniä metrin päästä.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 738

Itse päädyin AMD:n korttiin juuri Nvidian VRAM-pihtaamisen kanssa. Tuli fiilis, että Nvidia nuukaili tahallaan muistin määrän kanssa, jotta pelaajien on pakko päivittää korttia muutaman vuoden päästä. Tuo taisi olla ihan fakta. Jos RTX 4070 Ti:ssä olisi 16GB muistia, olisi se varmaan ollut oma valinta. Pelkäsin kuitenkin, että 12GB muistin kanssa käy sama kuin kävi oman 8GB RTX 3070 Ti:n kanssa.

RX 6950 XT oli siitä houkutteleva, että hinta oli samalla tasolla RTX 4070:n kanssa, mutta raakaa tehoa 15-20% ja muistia 33% enemmän. Lisääntynyt teho on mukavaa ja isommasta muistista on nyt jo ollut hyötyä 1440p-resoluutiolla. Lähivuosina voi tulla lisää pelejä, joille 12GB on niukasti. Tavallaan myös tykkään, kun on massiivinen jäähy ison virrankulutuksen kesyttämiseksi. Etenkin edullisemmat RTX 4070:t olivat muovisia ja pienikokoisia ja näyttäisivät Noctua NH-D15:n rinnalla rimpuloilta. RX 6950 XT Red Devil on paljon katu-uskottavamman näköinen. Ja tämän mukana tuli hyvin mieluinen peli

Ajuriongelmia ei käytännössä ole ollut. Kaikki toimii AMD:lla kuin junan vessa. Päänäytön satunnainen vilkkuminen ja kakkosnäytön pikselöityminen, jotka olivat tälläkin foorumilla todettuja Nvidian ajuriongelmia, katosivat heti. Paljon eri pelejä ladannut ja todennut toimivaksi ja hyvin pyöriväksi. Ainoa ongelma oli 110C Hot Spot lämmöt, jotka ovat etenkin PowerColorin kiusa. Takuuseen lähettämisen sijaan vaihdoin itse tahnat ja kortti rokkaa nyt hyvin viileänä. Sain tuon myötä Power Limittiä ylös, mikä tarkoittaa isompia kelloja peleissä.

1440p-resoluutiolla voi heittää pääasiassa kaikki grafiikat tappiin ja pelit pyörivät silti hyvin ison muistin ja raa'an tehon vuoksi. RT-suorituskykykin yllätti. Metro Exodus Enhaned Editionia tullut pelailtua paljon ilman skaalaimia ja RT High -asetuksilla ja FPS huitelee usein 100:n tuntumassa. Samoin uudessa Witcher 3:ssa sai FSR 2.1 Qualityllä 3/4 RT-efekteistä päälle ja FPS ei ikinä tipu alle 60:n. Cyberpunk on ainoa, missä oikeasti ehkä kaipaisi enemmän potkua etenkin, kun FSR on siinä nyt rikki. Intel XeSS Quality näyttää tosi hyvältä, mutta sen kanssa voi pitää vain RT GI:n, AO:n ja auringonvarjot päällä, jotta pysyy yli 60 FPS. Toki nuokin ovat tuntuva parannus kuvanlaatuun.

UE5:n toteutus säteenseurannalle vaikuttaa siitä lupaavalta, että AMD:n suorituskyky on sillä hyvä. Samoin on myös toivoa, että ajurit kehittyvät vielä. Hiljattain tuli ajuripäivitys, joka nosti ainakin raakaa RT-suorituskykyä. Esimerkiksi IO-Techin testissä RX 6950 XT sai Port Royalin DirectX Ray Tracing testissä jonkun 30 FPS, kun itse rykäisen omalla kortilla 42 FPS. Vielä kun saisi peleihin vastaavan tehonlisäyksen. Sitten taas esimerkiksi uudessta Star Warsissa on UE4 pelimoottorina, Global Illumination ja heijastukset toteutettu säteenseurannalla ja silti AMD pärjää siinä yllättävän hyvin. Toki peli taisi olla jossain määrin rikki ainakin julkaisussa.

Päädyin aika lailla samanlaisen ajatusketjun jälkeen Radeoniin. En halua sitoutua poropietariominaisuuksiin vaan käytän mieluummin avoimia rajapintoja. En pelaa Minecraftia enkä Quakea niin nyky-RT:lläkään ei ole liiemmälti merkitystä, ja sen verran mitä pelit sitä hyödyntää niin 6950XT pystyy toimittamaan. Tuo 16 gigan muisti ja isompi laskentateho vie todennäköisesti paremmin tulevaisuuteen UE5:n kanssa kuin 4070:n 12Gt + poropietarihilavitkuttimet.

- Liittynyt

- 13.11.2018

- Viestejä

- 77

Tässä olisi muuta kun vain pelejä. TLDR 4060ti on kuraa.

www.pugetsystems.com

www.pugetsystems.com

Tossa olisi sitten enemmän radeonijuttuja

www.pugetsystems.com

www.pugetsystems.com

NVIDIA RTX 4070 and 4060 Ti (8GB) Content Creation Review

The NVIDIA GeForce RTX 4070 and 4060 Ti (8GB) are the most recent additions to NVIDIAs consumer family of GPUs on their Ada Lovelace Architecture. How do they compare for content creation against their previous generation counterparts?

www.pugetsystems.com

www.pugetsystems.com

Tossa olisi sitten enemmän radeonijuttuja

NVIDIA GeForce 40 Series vs AMD Radeon 7000 for Content Creation

With the RTX 4070 Ti joining the RTX 4080 and 4090, NVIDIA has now completed the launch of the initial trio of their GeForce RTX 40 series of GPUs. How do these cards compare for various content creation workflows versus the previous generation RTX cards, and their competition from AMD?

www.pugetsystems.com

www.pugetsystems.com

- Liittynyt

- 17.10.2016

- Viestejä

- 2 923

Itse en koe, että pärjäisin ilman DLSS:ää 4K-näyttölaitteella. FSR:n jälki ei ole hääviä ja 4K:lla suuri osa peleistä ei pyöri riittävän hyvin alle 1000€ näytönohjaimella. Lisäksi tykkään RT:stä. Jos nämä asiat saataisiin jotenkin hanskaan AMD:llä, niin voisin harkita vaihtoa. VRAM:ista kyllä iso plussa, mutta se ei yksinään riitä.

Lare

Error 404

- Liittynyt

- 13.11.2016

- Viestejä

- 4 736

Eikö tuo ole aika monen toimijan kohdalla todettu, että Nvidia laski tarkkaan, kuinka paljon muistia riittää nykyisen sukupolven ajaksi ja onnistuikin siinä? Nyt esimerkiksi paskamyrskyn seurauksena on tulossa 16GB RTX 4060 Ti. Sen tiedostan, että muistiväylä rajoittaa käytettävän muistin määrää. Kuitenkin AMD ja Intel ovat saaneet hieman edullisemmankin pään kortteihin 12GB ja 16GB muistia. Ei luulisi olevan mahdoton paikka Nvidiallekaan.Kannattaisi ehkä yrittää ymmärtää asioita vähän enemmän sen sijaan että lähtee kehittelemään salaliittoteorioita tarkoituksellisesta cripplaamisesta.

Ei siihen AD104-piiriin olisi voinut (järkevästi, hyvällä suorituskyvyllä) kytkeä 12 gigaa muistia, kun sen muistiväylä on 192-bittinen.

Jotta 16 gigaa muistia olisi ollut mahdollinen, olisi muistiväylä pitänyt leventää 256 bittiin. Ja se olisi tarkoittanut myös itse piirille selvästi lisää kokoa, koska enemmän PHYitä.

Ja lisäksi PCB olisi ollut paljon kalliimpi. Tähän päälle niiden muistipiirien hinta.

Se 16 gigaa muistia olisi tullut paljon kalliimmaksi valmistaa.

Jos haluaa isomman ja kalliimman kortin, sitten ostaa 4080n, jossa on isompi AD103-piiri jossa se 256-bittinen muistiväylä.

Onko se 12 GiB niukasti riippuu täysin siitä, onko pakkomielle valita asetuksista "texture quality: ultra" vai onko järkeä siihen, että välillä valitseekin "texture quality: medium" jonka vaikutus kuvanlaatuun useimmissa peleissä jää melko pieneksi jos pelissä oikeasti pelaa sitä peliä eikä mene vaan tuijottelemaan seiniä metrin päästä.

12GB riittää tällä hetkellä. Kuitenkin oma pelko oli siinä, että muutaman vuoden päästä tulee taas tilanne, että kortin teho riittää, mutta muisti ei. En halua, että käy samaa kuin kävi oman 8GB RTX 3070 Ti:n kanssa. Jos tuossa kortissa olisi ollut enemmän muistia, olisin varmaan jatkanut sillä pidempään. Lisäksi esimerkiksi DLSS 3 FG nostaa VRAM:n käyttöä yli gigalla ja RT-efektit jopa useammalla. Voi hyvinkin tulla vastaan tilanne, jossa joku peli näyttäisi upealta ja pyörisi Frame Generationin kanssa hyvin, mutta muisti ei meinaa riittää. Nvidian RT:n ja DLSS 3:n markkinoinnilla ratsastaminen voi nousta ongelmaksi, jos muisti ei riitä niihin. Etenkin 8GB RTX 4060 -sarjaan tuo voi iskeä kovasti.

Aina voi toki laskea asetuksia, mutta jos ostan tonnin RTX 4070 Ti:n, oletan, että peleissä voi lyödä huoletta grafiikat tappiin 1440p-resoluutiolla, eikä pudotella asetuksia mediumille. Nvidia on valinnut, että tuo muistin määrä on nyt jo rajoilla ja lähivuosina tilanne voi pahentua. 12GB muistia siihen on niukasti ja 16GB taas olisi turvallisempi tulevaisuuden kannalta. 8GB korteilla tilanne meni niin pahaksi, että edes reilu grafiikoiden pudottelu ei meinannut auttaa. Samoin tekstuurit saattoivat olla mössöä, oli niillä mikä tahansa asetus päällä.

Viimeksi muokattu:

bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 3 980

En ole itse vertaillut, mutta onko isokin ero 4k:lla DLSS quality vs. FSR2.1 quality? Huomaako ihan pelatessa selviä eroja?Itse en koe, että pärjäisin ilman DLSS:ää 4K-näyttölaitteella. FSR:n jälki ei ole hääviä ja 4K:lla suuri osa peleistä ei pyöri riittävän hyvin alle 1000€ näytönohjaimella. Lisäksi tykkään RT:stä. Jos nämä asiat saataisiin jotenkin hanskaan AMD:llä, niin voisin harkita vaihtoa. VRAM:ista kyllä iso plussa, mutta se ei yksinään riitä.

- Liittynyt

- 28.11.2016

- Viestejä

- 384

Vanhaa rutinaa takarivistä, mutta Linux-puolella Radeon on aika lailla selvästi huolivapain valinta joka tilanteessa, mistä pisteet AMD:lle. Nvidia ja Intel (ARC) ajurituki laahaa pingviinipuolella vähän perässä koska (suhteessa Windowsiin) vähäisen käyttäjämäärän takia kummankin firman intressi kehittää edes suljettujakaan ajureita Linuxille on vähän niin ja näin. AMD sen sijaan valitsi suoraan avoimen lähdekoodin tien ja sen ajurituki Linuxilla on nykyisin todella kattava. Onhan AMD:llä proprietary-ajuritkin tarjolla Linuxille, mutta niitä ei keskivertokäyttäjä tarvi mihinkään.

En ole nykyisellä Fedora-distrollani koskenut millään tavalla itse OS:n asennuksen jälkeen GPU-ajureihin ja RX 6800 XT porskuttaa oikein sutjakasti peleissä avoimen koodin amdgpu-ajurilla. Jos olisin valinnut suht modernin NVidian kortin, olisi minun jo kättelyssä joko kannattanut huolella valita distro joka asentaa räätälöidyt ajurit valmiiksi (esim. POP!_OS, Nobara) tai metsästää jonkun muun valitsemani distron repoista Nvidian suljetut ajurit ja sormet ristissä toivoa että kaikki pelaa ilman ongelmia.

En ole nykyisellä Fedora-distrollani koskenut millään tavalla itse OS:n asennuksen jälkeen GPU-ajureihin ja RX 6800 XT porskuttaa oikein sutjakasti peleissä avoimen koodin amdgpu-ajurilla. Jos olisin valinnut suht modernin NVidian kortin, olisi minun jo kättelyssä joko kannattanut huolella valita distro joka asentaa räätälöidyt ajurit valmiiksi (esim. POP!_OS, Nobara) tai metsästää jonkun muun valitsemani distron repoista Nvidian suljetut ajurit ja sormet ristissä toivoa että kaikki pelaa ilman ongelmia.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 923

En ole itse vertaillut, mutta onko isokin ero 4k:lla DLSS quality vs. FSR2.1 quality? Huomaako ihan pelatessa selviä eroja?

Kyllä eron huomaan ihan selvästi pelatessa.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 738

Ehkä seuraavilla laneilla pääsen näkemään rinnatusten vierekkäisistä monitoreista DLSS ja FSR -kuvaa. Itsellä nyt kun on vaan tämä yksi Radeoni jolla ei DLSS:ää voi käyttää, niin ei ole verrokkia. Mitä nyt nopeasti Last of ussissa testasin FSR Qualityä niin ei se kyllä laadullisesti haitannut. Toki mieluummin pelaan natiivilla kun siihen tehot kerta riittää.

XeSS Ultra qualityllä on noista kuvanpaskomis jutuista se paras mitä tulee kuvanlaatuun.

Sen ongelma on että AMD korteilla tuppaa tiputtamaan fpsiä, Nvidialla toimii kuten pitäisikin ja sitten Intelin korteilla homma romuttuu jo ajuri ongelmiin pelejen suhteen.

FSR ja XeSS eivät myöskään hukkaa ykstyiskohtia mitä DLSS vaikuttais tekevän.

Ja kannattaako noita käyttää?

No ei, koska vähän riippuen kortista ja pelistä paremmat fps boosti saat graffa asetuksia tiputtamalla pykälällä. Ja näin kuvanlaatu ei heikkene yhtään ja grafiikoissa tuskin huomaat eroa.

Asia taas erikseen jos on typeriä periaatteita että asetuksiahan ei tiputeta.

Sen ongelma on että AMD korteilla tuppaa tiputtamaan fpsiä, Nvidialla toimii kuten pitäisikin ja sitten Intelin korteilla homma romuttuu jo ajuri ongelmiin pelejen suhteen.

FSR ja XeSS eivät myöskään hukkaa ykstyiskohtia mitä DLSS vaikuttais tekevän.

Ja kannattaako noita käyttää?

No ei, koska vähän riippuen kortista ja pelistä paremmat fps boosti saat graffa asetuksia tiputtamalla pykälällä. Ja näin kuvanlaatu ei heikkene yhtään ja grafiikoissa tuskin huomaat eroa.

Asia taas erikseen jos on typeriä periaatteita että asetuksiahan ei tiputeta.

bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 3 980

Taitaa monella olla enemmänkin siitä kiinni ettei ole mielenkiintoa testailla kaikkien mahdollisten asetusyhdistelmien laatua vs. suorituskyky. Helpompi pitää asetukset maksimissa ja laittaa DLSS / FSR päälle.XeSS Ultra qualityllä on noista kuvanpaskomis jutuista se paras mitä tulee kuvanlaatuun.

Sen ongelma on että AMD korteilla tuppaa tiputtamaan fpsiä, Nvidialla toimii kuten pitäisikin ja sitten Intelin korteilla homma romuttuu jo ajuri ongelmiin pelejen suhteen.

FSR ja XeSS eivät myöskään hukkaa ykstyiskohtia mitä DLSS vaikuttais tekevän.

Ja kannattaako noita käyttää?

No ei, koska vähän riippuen kortista ja pelistä paremmat fps boosti saat graffa asetuksia tiputtamalla pykälällä. Ja näin kuvanlaatu ei heikkene yhtään ja grafiikoissa tuskin huomaat eroa.

Asia taas erikseen jos on typeriä periaatteita että asetuksiahan ei tiputeta.

Taitaa monella olla enemmänkin siitä kiinni ettei ole mielenkiintoa testailla kaikkien mahdollisten asetusyhdistelmien laatua vs. suorituskyky. Helpompi pitää asetukset maksimissa ja laittaa DLSS / FSR päälle.

Ööö peleissä ollut jo vuosia quality presetit eli laatu esiasetukset.

Joten vaikka Ultralta -> Very High tiputuksessa menee ihan samanverran aikaa kuin kytkeä FSR tai DLSS päälle.

Ja jos tommonen on liian haastavaa, niin kannattaa ihan oikeasti miettiä siirtymistä konsoli pelaajaksi. Sitten ei tarvitse asetuksia säädellä ei niin yhtään.

Kun PC pelaamisessa on juuri se että pystyt asetukset itse muuttamaan, eli saa vaikka motion blurnin pois.

Tai uutuus pelinkin saa pyörimään pelattavasti yllättävänkin heikolla/vanhalla raudalla.

Siksi esim. nämä muisti loppuu höpötykset ihan höpö höpöä.

Ja jos tuommoinen asia niin rassaa, niin eikö kannattais jättää kortit vaan kauppaan ? Näin menis varmasti valmistajalle/valmistajille viesti perille.

Mutta ei niin ei. Aina tuijotetaan vaan fps ja millään muulla ei tunnu olevan merkitystä. Minkä todistaa hyvin näiden DLSS, XeSS ja FSR käyttäminen.

Ensin höpötetään että pakko olla textuurit maksimilla kun pykälää matalemmilla ovat muka jo suttua.

Sitten kuitenkin lyödään se DLSS päälle ja pehmennetään niin ne tarkat textuurit kuin koko kuva.

Eli oikeasti tarkemman kuvan ja ne textuurit ois saanut tiputtamalla asetuksia pykälällä, eikä kytkemällä DLSS päälle.

Toinen ihme aihe on tämä säteenseuranta. Kyllä sillä toteutetut pelit ja pelien modit ovat hienoja kuin mitkä.

Kuten Quake 2 RTX ja Doomin sekä Quake 1 säteenseuranta modit.

Mutta nämä pelit joihin RT effektejä on liimattu vaan rasteroinnin päälle ovat kaikkea muuta kuin mitenkään vakuuttavia.

Kun rasteroinnilla kaikki nuo heijastukset, varjot ym. on voitu jo vuosia toteuttaa tarpeeksi uskottavasti.

Eli vois sanoa että koko säteenseuranta jutut ovat vielä aivan turhake jollei tykkää pelata noita vanhojen pelejen säteenseuranta versioita/modeja.

Itse ihmettelen joidenkin suoranaista vihaa Dlss&Fsr&Xess teknologioita kohtaan.

Jos joku kokee että 4k resoluutiolla Dlss quality näyttää paremmalta kuin tiputtaa asetuksia high niin miksi se on niin väärin?

Toki esimerkiksi itse olen ottanut Hardware Unboxed kanavan optimoidut asetukset Red dead redemption 2 pelissä kun Dlss näytti siinä huonolta jostain syystä.

Jos joku kokee että 4k resoluutiolla Dlss quality näyttää paremmalta kuin tiputtaa asetuksia high niin miksi se on niin väärin?

Toki esimerkiksi itse olen ottanut Hardware Unboxed kanavan optimoidut asetukset Red dead redemption 2 pelissä kun Dlss näytti siinä huonolta jostain syystä.

Itse ihmettelen joidenkin suoranaista vihaa Dlss&Fsr&Xess teknologioita kohtaan.

Jos joku kokee että 4k resoluutiolla Dlss quality näyttää paremmalta kuin tiputtaa asetuksia high niin miksi se on niin väärin?

Toki esimerkiksi itse olen ottanut Hardware Unboxed kanavan optimoidut asetukset Red dead redemption 2 pelissä kun Dlss näytti siinä huonolta jostain syystä.

Paitsi RTX 4060 ti julkaisun yhteydessä alettiin hehkuttamaan DLSS3 1080p kortilla.

Nuo menevät kyllä 4k quality asetuksilla, mutta 1080p ja 1440p ne ovat No No.

Itseäni noissa ärtsyttää se kun väitetään että kuvalaatu ei mukamas muutu tai muuttuu niin vähän että eroa ei huomaa natiivi kuvaan nähden.

Sekä se että AMD FSR3:lla ja Nvidia DLSS3:lla hehkuttaa uusia korttejaan kun ilman eivät eroa tarpeeksi edeltäjistään.

Eli suomeksi yritetään kusettaa kuluttajia minkä keretään.

Itse en ole vielä päässyt kokeilemaan frame generationia mutta arvostelujen perusteella nykyversio siitä heikentää kuvanlaatua reilusti.Paitsi RTX 4060 ti julkaisun yhteydessä alettiin hehkuttamaan DLSS3 1080p kortilla.

Nuo menevät kyllä 4k quality asetuksilla, mutta 1080p ja 1440p ne ovat No No.

Itseäni noissa ärtsyttää se kun väitetään että kuvalaatu ei mukamas muutu tai muuttuu niin vähän että eroa ei huomaa natiivi kuvaan nähden.

Sekä se että AMD FSR3:lla ja Nvidia DLSS3:lla hehkuttaa uusia korttejaan kun ilman eivät eroa tarpeeksi edeltäjistään.

Eli suomeksi yritetään kusettaa kuluttajia minkä keretään.

- Liittynyt

- 14.10.2016

- Viestejä

- 23 489

Missäs kohtaa on sanottu että FSR3 olisi sidottu RDNA3:een?Sekä se että AMD FSR3:lla ja Nvidia DLSS3:lla hehkuttaa uusia korttejaan kun ilman eivät eroa tarpeeksi edeltäjistään.

Eli suomeksi yritetään kusettaa kuluttajia minkä keretään.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 738

Varsinkin nuo frame generation -kikkareet ovat kyllä semmoista huttua että enpä olisi kuvitellut näkeväni. Tosiaan jos pelataan 4K-ruudulla DLSS tai FSR performance-asetuksella, eli peli rendataan sisäisesti 1080p resolla ja sitten vielä FG-päällä, niin se informaatio mitä näyttö sinulle näyttää on suurimmaksi osaksi algoritmien keksimää. Todellista pelimoottorin tuottamaa dataa on resoluutiosta 1:4 ja joka toinen frame interpoloitu, eli 1:8 on oikeasti pelimoottorin tuottamaa kuvaa.

Missäs kohtaa on sanottu että FSR3 olisi sidottu RDNA3:een?

Ei se olekkaan, enkä niin väittänytkään. Tarkoitin kun hehkutettiin RX 7900 julkistuksessa suorituskyky juttuja jatkuvasti FSR päällä plus sitä FSR3:sta.

Ihan huijaamista sanoa että pelaa 4k:lla jos FSR (tai DLSS tai XeSS) on käytössä.

Et silloin pelaa oikeasti 4k:lla vaan jollain 1080p ja 4k väliltä. Siksi myöskään noita ei pitäis missään tapauksessa ottaa mihinkään benchmarkki ym. vertailuihin mukaan.

Paras oli RX 7900:n julkkarissa kun AMD hehkutti 8k pelaamista ja tietenkin FSR päällä. Eli se ei ollut 8k nähnytkään.

- Liittynyt

- 14.10.2016

- Viestejä

- 23 489

Katsoin juuri AMD:n RX 7900 -julkaisudiat läpi:Ei se olekkaan, enkä niin väittänytkään. Tarkoitin kun hehkutettiin RX 7900 julkistuksessa suorituskyky juttuja jatkuvasti FSR päällä plus sitä FSR3:sta.

Ihan huijaamista sanoa että pelaa 4k:lla jos FSR (tai DLSS tai XeSS) on käytössä.

Et silloin pelaa oikeasti 4k:lla vaan jollain 1080p ja 4k väliltä. Siksi myöskään noita ei pitäis missään tapauksessa ottaa mihinkään benchmarkki ym. vertailuihin mukaan.

Paras oli RX 7900:n julkkarissa kun AMD hehkutti 8k pelaamista ja tietenkin FSR päällä. Eli se ei ollut 8k nähnytkään.

- FSR oli 4K RT -vertailussa RX 6900 vastaan, mutta se oli päällä kummallakin

- FSR oli päällä "high refresh rate 4K" testeissä puolessa peleistä, mutta siinä ei vertailtu näytönohjainta mihinkään toiseen

- 8K-resoluutiolla pelaamista ei mainosteta (eikä ole testejä), mutta mukana on ensimmäisen(?) 8K-pelinäytön mainos, jonka lisäksi 8K esiintyy videoiden transkoodauksesta puhuttaessa

- Liittynyt

- 17.10.2016

- Viestejä

- 1 926

Brute forcella suorituskyvyn parantaminen sukupolvesta toiseen on jo historiaa, softatemput on se millä jatkossa kehitystä nähdään. Nvidia on tämän sanonut ja AMDkin tietää sen.Siksi myöskään noita ei pitäis missään tapauksessa ottaa mihinkään benchmarkki ym. vertailuihin mukaan.

Niin, mikäs siinä jos haluaa maksaa 700€ näytönohjaimesta ja SILTI joutua karsimaan grafiikka asetuksista.. Minusta se ei ole kohtuullista ainakaan 1440p resolla. Eikä varmaan kovin monen muunkaan mielestä.

Ja vastaavasti AMD:llä on heikompi RT, eli asetuksia pitää sielläkin karsia. Lisäksi ei ole dlss3:ta eli asetuksia joutuu tiputtamaan vielä lisää jne. Ei tässä mitään täydellistä ratkaisua ole olemassa.

Itse arvostan avoimia ratkaisuja (softa ja ajurit) sen verran paljon että edelliset kortit ovat olleet AMD tuotoksia (toki ajuritkin ovat paremmat, varsinkin Linuxin puolella kun ei tarvitse säätää kuten NVIDIAn kanssa). Toki Windowsin puolellakin on kaikkea kivaa (kuten AMD link ja näyttiksen suorituskyvyn seuraaminen kännykän näytöltä yms.), mutta kun noista en ole NVIDIAn kohdalla perillä niin hyvin niin en lähde vertailemaan.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 357

Brute forcella suorituskyvyn parantaminen sukupolvesta toiseen on jo historiaa, softatemput on se millä jatkossa kehitystä nähdään. Nvidia on tämän sanonut ja AMDkin tietää sen.

Eikä ole. Se on vaan Papa J propagandaa joka on näemmä sinuunkin uponnut varsin tehokkaasti. Papa J vaan haluaa lihottaa lompakkoaan. Softa kikkailu on halvempaa kuin panostaa siihen oikeaan tehoon jolloin voidaan ottaa entistä enemmän rahaa kuluttajilta kun valmistuskustannukset ei ole niin suuret.

Mielestäni kehityksen tarttis alkaa nyt kulkea sellaiseen suuntaan että toi normi rasterointi pistettäisiin pakettiin, sitä tehoa on jo ihan riittävästi ja kaikki paukut RT tehoon jos siitä se graalin malja halutaan leipoa.

- Liittynyt

- 22.10.2016

- Viestejä

- 12 155

Brute forcella suorituskyvyn parantaminen sukupolvesta toiseen on jo historiaa, softatemput on se millä jatkossa kehitystä nähdään. Nvidia on tämän sanonut ja AMDkin tietää sen.

AMD tosin juuri tuplasti graffaytimiensä kertolaskimien määrän, ilman että tuplasi keinoja ruokkia niitä kertolaskimia tehokkaasti.

Mutta Mooren lain antama ilmainen lounas on tosiaan ohi, ei voida vaan jatkaa sitä että parin vuoden välein tuplataan kaiken määrä, koska uusilla valmistustekniikoilla transistorit eivät enää ole halvempia kuin vanhoilla, hyöty uusista valmistusprosesseista jää käytännössä siihen että virrankulutusta saa hiukan alas ja/tai kelloa hiukan ylös.

Ei heikennä. Sekä monessa pelissä sitä voi käyttää ihan natiiviresoluutiolla.Itse en ole vielä päässyt kokeilemaan frame generationia mutta arvostelujen perusteella nykyversio siitä heikentää kuvanlaatua reilusti.

Helppo on valita haluaako pelata vaikka 60fps aavistuksen paremmalla kuvanlaadulla vai 100fps niin että satunnaisesti on jotiain grafiikkavirheitä joita ei huomaa kuin etsimällä etsimällä.

- Liittynyt

- 22.10.2016

- Viestejä

- 12 155

Ei heikennä. Sekä monessa pelissä sitä voi käyttää ihan natiiviresoluutiolla.

Helppo on valita haluaako pelata vaikka 60fps aavistuksen paremmalla kuvanlaadulla vai 100fps niin että satunnaisesti on jotiain grafiikkavirheitä joita ei huomaa kuin etsimällä etsimällä.

Itselle valinta on helppo: mielummin (v-sync päällä) natiivi 60 FPS (joka on suora moninkerta näytön virkistystaajuudesta) pienemmällä viiveellä eikä pelimoottori hitaamalla 50 FPSllä intepoloiduilla frameilla selvästi suuremmalla viiveellä "100 FPSllä" FPSn ollessa vielä epäsynkassa näytön frameraten kanssa.

Viimeksi muokattu:

Niin no en ainakaa itse huomaa mitään viivettä fg päällä, saati sitten mitään ihmeellistä vaikka fps ei olisi suoraan jaollinen näytön virkistystaajuuden kanssa, mutta huomaan ison eron kyllä kun fps on huomattavasti korkeampi. Mutta hyvä, että on vaihtoehtoja ja jokaiselle löytyy se mieluisa.Itselle valinta on helppo: mielummin (v-sync päällä) natiivi 60 FPS (joka on suora moninkerta näytön virkistystaajuudesta) pienemmällä viiveellä eikä pelimoottori hitaamalla 50 FPSllä intepoloiduilla frameilla selvästi suuremmalla viiveellä "100 FPSllä" FPSn ollessa vielä epäsynkassa näytön frameraten kanssa.

Uutiset

-

AOC julkaisi U27G4R-pelinäytön kaksoisresoluutiotuella ja muita uutuuksia

9.5.2025 15:04

-

Live: io-techin Tekniikkapodcast (19/2025)

9.5.2025 14:58

-

Kiinalainen Hygon valmistelee jopa 128-ytimistä ja 512 säiettä suorittavaa prosessoria

9.5.2025 02:08

-

Razer julkaisi pelituoliin liitettävän Clio-kaiutintyynyn ja näppäimistön sekä hiiren mobiilipelaamiseen

9.5.2025 01:20

-

AMD julkaisi AMD Software 25.5.1 -ajurit näytönohjaimilleen ja prosessoreilleen

8.5.2025 14:00