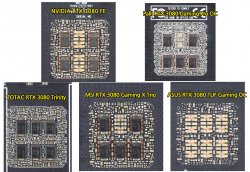

Paljonko vielä maksaa enemmä latoo 60 konkkaa vs 6 konkkaa.

Tuskin niin paljon enemmän edes aikana, että sillä on oikeastaan väliä. Sitä käytetään mikä parhaaks nähdään. MLCC omat hyvät jutut ja SP-CAP omat hyvät jutut. Voit myös ajatella että se on 60 kohtaa mistä se kortti voi mennä paskaks versus 6 kestävää kohtaa.

Loputon suo vertailla noita. Ehkä parempi vaan kattoo sitä, että toimiiko kortti vai ei.

. No refua vaan sit vaikka olisihan tuo tuf kelvannu

. No refua vaan sit vaikka olisihan tuo tuf kelvannu Ei mielestäni pahan hintainen tuo kun kerta vielä mukaan tulee backplate. Tuohan on nickelöityä cuparia, no joo, eiköhän se ihan hyvä ole... Tuffin tietoja kattelin.

Ei mielestäni pahan hintainen tuo kun kerta vielä mukaan tulee backplate. Tuohan on nickelöityä cuparia, no joo, eiköhän se ihan hyvä ole... Tuffin tietoja kattelin. Alphacoolin kamat on ihan laadukkaita, ei pitäisi sen puoleen olla huolta. Vaikka kama tulee Kiinasta, se ei tietääkseni ole alihankittua skeidaa, vaan heillä on oma tehdas. Toki EK:n made in EU -leima houkuttelee, mut hintalappukin on sen mukainen.

Alphacoolin kamat on ihan laadukkaita, ei pitäisi sen puoleen olla huolta. Vaikka kama tulee Kiinasta, se ei tietääkseni ole alihankittua skeidaa, vaan heillä on oma tehdas. Toki EK:n made in EU -leima houkuttelee, mut hintalappukin on sen mukainen.