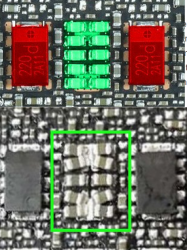

Mitäs eroa noilla MLCC ja Poscat konkilla on? Kesto? Lämpö?

Techpowerupin kommenteissa oli yksi vakuuttavan oloinen

kuittaus:

"

So, as an Electronics Engineer and PCB Designer I feel I have to react here.

The point that Igor makes about improper power design causing instability is a very plausible one. Especially with first production runs where it indeed could be the case that they did not have the time/equipment/driver etc to do proper design verification.

However, concluding from this that a POSCAP = bad and MLCC = good is waaay to harsh and a conclusion you cannot make.

Both POSCAPS (or any other 'solid polymer caps' and MLCC's have there own characteristics and use cases.

Some (not all) are ('+' = pos, '-' = neg):

MLCC:

+ cheap

+ small

+ high voltage rating in small package

+ high current rating

+ high temperature rating

+ high capacitance in small package

+ good at high frequencies

- prone to cracking

- prone to piezo effect

- bad temperature characteristics

- DC bias (capacitance changes a lot under different voltages)

POSCAP:

- more expensive

- bigger

- lower voltage rating

+ high current rating

+ high temperature rating

- less good at high frequencies

+ mechanically very strong (no MLCC cracking)

+ not prone to piezo effect

+ very stable over temperature

+ no DC bias (capacitance very stable at different voltages)

As you can see, both have there strengths and weaknesses and one is not particularly better or worse then the other. It all depends.

In this case, most of these 3080 and 3090 boards may use the same GPU (with its requirements) but they also have very different power circuits driving the chips on the cards.

Each power solution has its own characteristics and behavior and thus its own requirements in terms of capacitors used.

Thus, you cannot simply say: I want the card with only MLCC's because that is a good design.

It is far more likely they just could/would not have enough time and/or resources to properly verify their designs and thus where not able to do proper adjustments to their initial component choices.

This will very likely work itself out in time. For now, just buy the card that you like and if it fails, simply claim warranty. Let them fix the problem and down draw to many conclusions based on incomplete information and (educated) guess work. "

Harmi kun ei ollut eilen vielä saatavilla.

Harmi kun ei ollut eilen vielä saatavilla.