Tähän vielä tuo hirmuiset kellot-hullutus....viruukohan sinne 2400mhz?Nvidian korteille ilmoitetaan TGP ei TBP...

Eli jos tuo STRIX oli 255W/289W niin se on todella paljon vähemmän kuin 3080:n 340W...

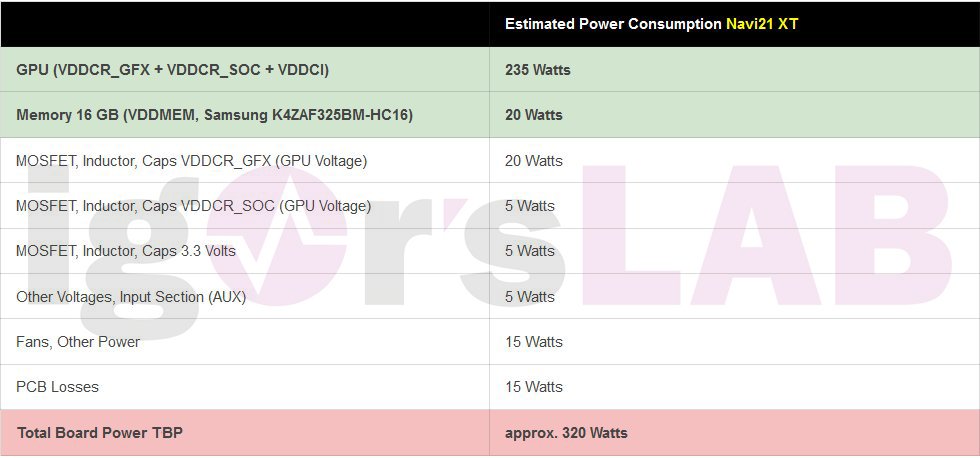

Ota näistä selvää kun kaikki käyttää erilaisia arvoja...

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2025 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

AMD-spekulaatioketju (RDNA:n ja CDNA:n tulevat sukupolvet)

Tähän vielä tuo hirmuiset kellot-hullutus....viruukohan sinne 2400mhz?

Jos tähän uskominen, niin pitäs virua. Pääosa ajasta ollu 2300-2400MHz välissä.

- Liittynyt

- 22.10.2016

- Viestejä

- 12 697

Nvidian kohdalla kehitys ei kylläkään ole lakannut, vaan Nvidiahan otti Ampereen high endissä suunnilleen isoimman hyppäyksen ikinä (vs. ed. high end julkaisu), eli kyllä tässä kohtaa jos AMD haastaa edes 3080, niin voi antaa ison peukun AMD:lle. AMD todennäköisesti pienemmillä käytetyillä resursseilla luonut arkkitehtuurin, jolla on potentiaali haastaa erinomainen Nvidia jokaisessa teho/hinta -segmentissä. Hyvä suoritus minusta.

Väittäisin, että Turing oli arkkitehtuuriltaan selvästi suurempi hyppäys kuin Ampere.

Ja arkkitehtuuri ja valmistustekniikka on toisistaan erillisiä asioita.

nVidia teki bisnespäätöksen säästää valmistuskustannuksissa ja käyttää halvempaa ja huonompaa valmistusprosessia. Ja nyt tämä tuntuisi kostautuvan.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Olen kyllä tietoinen noista, mutta se ei selitä miten nuo "ylimääräiset" kulutukset olisivat kasvaneet yli 40% vrt 5700XT

Tossa on tuo Igorin laskelma Navi21 XT:lle.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 246

5700 XT:n kohdalla ero TGP vs TDP oli ulkomuistista 35 tai 45w, nyt olisi 65w? Toki raskaampi rauta ja virransyöttö voinee hukata enemmän mutta että 20 tai 30 wattia enemmän?

Sitä itseasiassa _roggame ihmetteli myös. En nyt löydä sen twittiä, mutta sekin ihmetteli miten häviöt loikkaa 20-30w vs navi, vaikka kulutus on aika lähellä. Parempi silti huudella noita yli 300W lukemia, kuin tuota TGP arvoa, jossa on vain gpu ja muistit, mutta ei muuta rautaa.

- Liittynyt

- 07.01.2020

- Viestejä

- 1 330

Vähän ot mutta tämän mukaan kolmanneksi huonoin hyppäys GTX280 lähtien. Ja sitä vielä verrataan huonoimman hyppäyksen tehneeseen 2080Ti:hin.Nvidian kohdalla kehitys ei kylläkään ole lakannut, vaan Nvidiahan otti Ampereen high endissä suunnilleen isoimman hyppäyksen ikinä (vs. ed. high end julkaisu), eli kyllä tässä kohtaa jos AMD haastaa edes 3080, niin voi antaa ison peukun AMD:lle. AMD todennäköisesti pienemmillä käytetyillä resursseilla luonut arkkitehtuurin, jolla on potentiaali haastaa erinomainen Nvidia jokaisessa teho/hinta -segmentissä. Hyvä suoritus minusta.

Siinä mielessä ei ihme, että parin "laiskan" sukupolven aikana kilpailijia pääsee mukaan.

Innolla ja toiveikkaana kyllä odotan AMD:n julkaisua

Kaikissa vuodoissa/huhuissa lienee stokki RX 6xxx vs RTX 3xxx?

Tup3x

ツ

- Liittynyt

- 18.10.2016

- Viestejä

- 2 481

Vaikka RDNA2 kiinnostaa, niin luultavasti AMD:n ajurit on se ratkaiseva tekijä, minkä takia jää ostamatta. Avian onnetoomat videon säätömahdollisuudet voisin vielä antaa anteeksi (Navi, Renoir), muuta ilmeisesti anisotrooppinen suodatus ei toimi DX12 ohjelmissa.

Aikoinaan myös harmitti MSAA:n tehostuksen puute (eli jo pelistä löytyy vaikka vain 4xMSAA, niin NVIDIA pystyy tehostamaan sen 8xMSAA:ksi - oli kätevä muutaman pelin kohdalla; uusien pelien kanssa ei juurikaan merkitystä). Sitten vielä AMD:n aivan onneton v-sync asetus, mikä varsin harmittava jos on peli, joka sattuu lukitsemaan hertsit alas ja joka ei tarjoa kunnollista v-sync asetusta (ja adaptive sync käytössä). NVIDIAlla vain v-sync päälle, niin menee päälle vain jos sattuisi niin kivasti, että näytönohjain piirtäisi enemmän ruutuja kuin mitä VRR ikkuna mahdollistaa, kun adaptive sync käytössä.

MLAA oli myös aivan surkea viritys vs. NVIDIA:n ajuri FXAA:han (mikä on selvästi parempi, kuin minkään pelin oma FXAA). Myös Intelin CMAA on parempi. Tuokin on ihan kätevä, jos haluaa korvata pelin oman rupu FXAA:n paremmalla.

Aikoinaan myös harmitti MSAA:n tehostuksen puute (eli jo pelistä löytyy vaikka vain 4xMSAA, niin NVIDIA pystyy tehostamaan sen 8xMSAA:ksi - oli kätevä muutaman pelin kohdalla; uusien pelien kanssa ei juurikaan merkitystä). Sitten vielä AMD:n aivan onneton v-sync asetus, mikä varsin harmittava jos on peli, joka sattuu lukitsemaan hertsit alas ja joka ei tarjoa kunnollista v-sync asetusta (ja adaptive sync käytössä). NVIDIAlla vain v-sync päälle, niin menee päälle vain jos sattuisi niin kivasti, että näytönohjain piirtäisi enemmän ruutuja kuin mitä VRR ikkuna mahdollistaa, kun adaptive sync käytössä.

MLAA oli myös aivan surkea viritys vs. NVIDIA:n ajuri FXAA:han (mikä on selvästi parempi, kuin minkään pelin oma FXAA). Myös Intelin CMAA on parempi. Tuokin on ihan kätevä, jos haluaa korvata pelin oman rupu FXAA:n paremmalla.

- Liittynyt

- 16.10.2016

- Viestejä

- 624

Siis eikö tossa ole grafiikkapiirin ja muistien yhteinen kulutus noussut noin 40% verrattuna 5700XT:n grafiikkapiiri + muistit niin olisi loogista että virransyötön kulutus olisi noussut myös sen 40%.Olen kyllä tietoinen noista, mutta se ei selitä miten nuo "ylimääräiset" kulutukset olisivat kasvaneet yli 40% vrt 5700XT

- Liittynyt

- 03.01.2018

- Viestejä

- 576

Siis eikö tossa ole grafiikkapiirin ja muistien yhteinen kulutus noussut noin 40% verrattuna 5700XT:n grafiikkapiiri + muistit niin olisi loogista että virransyötön kulutus olisi noussut myös sen 40%.

Jep, jos virransyötön hyötysuhde pysyy samana niin häviöt kasvavat samassa suhteessa tehonkulutuksen kanssa.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Vähän ot mutta tämän mukaan kolmanneksi huonoin hyppäys GTX280 lähtien. Ja sitä vielä verrataan huonoimman hyppäyksen tehneeseen 2080Ti:hin.

Kiitos korjauksesta! Ei se tosiaan niin iso hyppy ollutkaan.

Siinä mielessä ei ihme, että parin "laiskan" sukupolven aikana kilpailijia pääsee mukaan.

Joo kilpailu tekee aina hyvää, mutta kyllä itse pidän Nvidiaa erinomaisena GPU-valmistajana teknisessä osaamisessa, ja noiden entistä nopeampien GPU:den valmistus taitaa olla haasteellisempaa vuosi vuodelta. Ei tässä pelkästään laiskuudesta ole kyse. Nvidia on myös tuonut RT:tä, DLSS:ää yms. vaikka kilpailua ei ole ollut. Mutta varmaan AMD:n tuoma kilpailu high-endiin tekee myös hyvää Nvidialle. Jos toiminta ei ole ollut tuossa segmentissä 100% tapissa, niin nyt on aika laittaa.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Aikoinaan myös harmitti MSAA:n tehostuksen puute (eli jo pelistä löytyy vaikka vain 4xMSAA, niin NVIDIA pystyy tehostamaan sen 8xMSAA:ksi - oli kätevä muutaman pelin kohdalla; uusien pelien kanssa ei juurikaan merkitystä).

AMD:lta löytyy nykyisin Adaptive MSAA joka kai on jonkin verran parempi kuin pelkkä MSAA, ja sitten löytyy vielä tarkempi Supersampling (SSAA). Viimeksi mainittu taitaa jo jonkin verran hörpätä FPS:iä, en ole testannut.

Löytyyhän sieltä Nvidian Control Panelista kaikenlaista joo. Molempien kortteja olen käytellyt, ja pidän noita säätöjä kyllä marginaalisina suuntaan ja toiseen, mutta onko sinne Nvidialle sitten 2000/3000-sarjan korteille tullut jotain oikeasti merkittäviä? Ne erot pitäisi havaita silmällä myös, pelkkä ''tämä on parempi asetus'' -teksti ei paranna vielä mitään..

Onhan siellä AMD:llakin nykyisin Image Sharpeningia, pintakuvoinnin suodatuslaadun säädintä jne, mutta itse en ole jaksanut noita vertailla kuva vs kuva.

Sitten vielä AMD:n aivan onneton v-sync asetus, mikä varsin harmittava jos on peli, joka sattuu lukitsemaan hertsit alas ja joka ei tarjoa kunnollista v-sync asetusta (ja adaptive sync käytössä).

Mikä vika Freesync + AMD Enhanced sync -kombossa on? Tuo viimeksi mainittu käsittääkseni ''paranneltu V-sync''. Oli mikä oli, niin itse joudun nimenomaan alle 60fps jossain peleissä vetämään kun GPU käynyt vanhaksi, mutta hyvin nuo Freesync + Enhanced sync on ylimääräisen stutteroinnin ja repeilyn kyllä poistanut. Freesyncin range alhaalla taitaa olla 44 vai 48 asti, ja se riittää hyvin. Edit: Siinä vaiheessa kun mennään alle tuon, niin pelikokemus alkaa olla jo enemmän tai vähemmän kuraa eli -> Uutta GPU:ta. Freesync toimii kuin junan vessa.

Viimeksi muokattu:

Vähän ot mutta tämän mukaan kolmanneksi huonoin hyppäys GTX280 lähtien. Ja sitä vielä verrataan huonoimman hyppäyksen tehneeseen 2080Ti:hin.

Siinä mielessä ei ihme, että parin "laiskan" sukupolven aikana kilpailijia pääsee mukaan.

Innolla ja toiveikkaana kyllä odotan AMD:n julkaisua

Kaikissa vuodoissa/huhuissa lienee stokki RX 6xxx vs RTX 3xxx?

Äläs ny. Jokainen tekniikkavlogisti rummuttaa yhteen ääneen, kuinka hyvä hintalaatu on eioolla!

Katoin noita pylväsdiagrammeja, joissa vertailtiin esim 3070 tehoja, ja vertailussa luonnollisesti 2070, eikä suinkaan 2070 super. Saadaan generational leap näyttämään huikealta!

- Liittynyt

- 22.10.2016

- Viestejä

- 12 697

AMD:lta löytyy nykyisin Adaptive MSAA joka kai on jonkin verran parempi kuin pelkkä MSAA, ja sitten löytyy vielä tarkempi Supersampling (SSAA). Viimeksi mainittu taitaa jo jonkin verran hörpätä FPS:iä, en ole testannut.

Ei tällä ole "tarkkuuden" kanssa mitään tekemistä.

Vaan sen kanssa, että MSAA toimii ainoastaan kolmioiden reunoille, mutta ei toimi esim. alpha-tekstuureille ollenkaan. Tuo adaptive ilmeisesti vaihtaa SSAA:han alpha-tekstuureita sisältävielle kolmioille (tosin en ole varma tästä).

Ja MSAA ei myöskään toimi monien nykypelien käyttämän deferred renderingin kanssa ollenkaan, eli siis ei toimi ollenkaan monilla nykypeleillä.

SSAA tarkoittaa käytännössä koko kuvan renderöimistä moninkertaisemmalla resoluutiolla sen jälkeen skaalaamista pienemmälle resoluutiolle. 1920x1080 4xSSAA tarkoittaa samaa määrää työtä kuin renderöiminen 3840x2160-resoluutiolla ilman SSAA:ta.

Ei se hörppää vain "jonkin verran" FPSää vaan vaatii todella paljon lisää työtä kortilta

- Liittynyt

- 22.10.2016

- Viestejä

- 12 697

Vaikka RDNA2 kiinnostaa, niin luultavasti AMD:n ajurit on se ratkaiseva tekijä, minkä takia jää ostamatta. Avian onnetoomat videon säätömahdollisuudet voisin vielä antaa anteeksi (Navi, Renoir), muuta ilmeisesti anisotrooppinen suodatus ei toimi DX12 ohjelmissa.

Jotain lähdettä tälle väitteelle?

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Ainut mitä keksin tuollaisen väärinkäsityksen lähteeksi on Radeon Software missä Anisotropic Filtering -asetuksessa lukee että koskee vain DirectX 9 -rajapintaa, mutta se ei selitä väitettä että vain DX12-ohjelmissa ei toimi kun se koskee myös 10 ja 11. Ja kyseisessä asetuksessahan on siis kyse anisotrooppisen filtteröinnin pakottamisesta päälle, ei siitä toimiiko anisotrooppinen filtteröinti.Jotain lähdettä tälle väitteelle?

Lyhyt googlettelu myös tukisi tätä väitettä, kun tuloksena on ketjuja missä purnataan kun ei vieläkään voi pakottaa muissa kuin DX9:ssä sitä AF:ää ajureista.

radeon290.llä toimii af 16 asetus hyvin täällä?Ainut mitä keksin tuollaisen väärinkäsityksen lähteeksi on Radeon Software missä Anisotropic Filtering -asetuksessa lukee että koskee vain DirectX 9 -rajapintaa, mutta se ei selitä väitettä että vain DX12-ohjelmissa ei toimi kun se koskee myös 10 ja 11. Ja kyseisessä asetuksessahan on siis kyse anisotrooppisen filtteröinnin pakottamisesta päälle, ei siitä toimiiko anisotrooppinen filtteröinti.

Lyhyt googlettelu myös tukisi tätä väitettä, kun tuloksena on ketjuja missä purnataan kun ei vieläkään voi pakottaa muissa kuin DX9:ssä sitä AF:ää ajureista.

edit.se on maksimi.

ajuri on kyllä puukotettu, koska uudet ei ole vuoteen toiminut.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Niin siis voi sen ajureista pistää päälle, mutta se asetus koskee vain DirectX 9 -sovelluksia. DX10, 11 ja 12 -rajapinnoilla AF on asetettavissa vain sovelluksesta itsestään. (tai ainakin niin sen pitäisi olla)radeon290.llä toimii af 16 asetus hyvin täällä?

edit.se on maksimi.

ajuri on kyllä puukotettu, koska uudet ei ole vuoteen toiminut.

Suurempi tekijä lienee arkkitehtuurivalinta: nVidia lähti käyttämään täysin uusia GDDR6X-piirejä ja leveämpää muistiväylää; saatavuus heikkoa, vain yksi valmistaja ja hinnat korkeita. Heikko muistipiirien saatavuus tarkoittaa myös sitä, että myytyjen korttien määrän maksimoimiseksi täytyy muistin määrää kortilla rajoittaa.nVidia teki bisnespäätöksen säästää valmistuskustannuksissa ja käyttää halvempaa ja huonompaa valmistusprosessia. Ja nyt tämä tuntuisi kostautuvan.

AMD näyttää lähteneen linjalle, jossa piiriin viedään sisälle suuri välimuisti ja tämä mahdollistaa kapeamman muistiväylän sekä halvempien GDDR6-muistipiirien käytön: Parempi saatavuus ja mahdollisuus kilpailuttaa muistipiirien valmistajia.

Jos AMD:n valinnalla päästään samaan suorituskykyyn kuin nVidian, on se selkeästi ollut oikea valinta. nVidia ei mitenkään pysty vastaamaan AMD:n asettamaan hintatasoon siedettävällä katteella.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

NVIDIA käyttää myös GDDR6-muisteja mm 3070:ssä, jota jouduttiin jo lykkäämäänkin, eli tuskin se muistien saatavuudesta on kiinni.Suurempi tekijä lienee arkkitehtuurivalinta: nVidia lähti käyttämään täysin uusia GDDR6X-piirejä ja leveämpää muistiväylää; saatavuus heikkoa, vain yksi valmistaja ja hinnat korkeita. Heikko muistipiirien saatavuus tarkoittaa myös sitä, että myytyjen korttien määrän maksimoimiseksi täytyy muistin määrää kortilla rajoittaa.

AMD näyttää lähteneen linjalle, jossa piiriin viedään sisälle suuri välimuisti ja tämä mahdollistaa kapeamman muistiväylän sekä halvempien GDDR6-muistipiirien käytön: Parempi saatavuus ja mahdollisuus kilpailuttaa muistipiirien valmistajia.

Jos AMD:n valinnalla päästään samaan suorituskykyyn kuin nVidian, on se selkeästi ollut oikea valinta. nVidia ei mitenkään pysty vastaamaan AMD:n asettamaan hintatasoon siedettävällä katteella.

AMD:n "suuri välimuisti" on tässä vaiheessa pelkkää spekulaatiota, ainakaan Xboxin RDNA2-grafiikkaohjaimessa ei ole mitään "ylimääräisiä" tai merkittävän isoja välimuisteja.

Konsoleiden siruissa ei kustannusten vuoksi voi kovin suuria välimuisteja edes harkita - eikä sellaisella ole tarvettakaan. Konsolin suorituskykytarve hoituu kyllä ilmankin.NVIDIA käyttää myös GDDR6-muisteja mm 3070:ssä, jota jouduttiin jo lykkäämäänkin, eli tuskin se muistien saatavuudesta on kiinni.

AMD:n "suuri välimuisti" on tässä vaiheessa pelkkää spekulaatiota, ainakaan Xboxin RDNA2-grafiikkaohjaimessa ei ole mitään "ylimääräisiä" tai merkittävän isoja välimuisteja.

Mutta jos Radeon 6000-sarja todella tarjoaa parhaimmillaan 3080:n suorituskykytasoa, niin huhujen mukaisella muistiväylällä (256 bit / GDDR6) ei tarvittavaa suorituskykyä saavuteta ilman jotain luovaa teknologista ratkaisua, jolla riippuvuutta muistiväylän suorituskyvystä saadaan vähennettyä. Huhuttu "Infinity Cache" voisi olla tällainen. Huhujen mukaan tämä olisi 128 MB (1) high-end-malleissa:

AMD Infinity Cache patent hints at RDNA 2 secret sauce

Sizeable unified cache will minimise drawbacks of the rumoured memory/bus configs?

(1) Tosin kun miettii miten paljon 128 MB veisi tilaa piipalalta nykyisellä 7nm prosessilla, niin tuskin kuitenkaan ihan näin suuri.

Viimeksi muokattu:

AMDn uusimmat prossut on tosi isolla cachella, ja taajuuksia nostettu. Samat temput gpu-puolella?Konsoleiden siruissa ei kustannusten vuoksi voi kovin suuria välimuisteja edes harkita - eikä sellaisella ole tarvettakaan. Konsolin suorituskykytarve hoituu kyllä ilmankin.

Mutta jos Radeon 6000-sarja todella tarjoaa parhaimmillaan 3080:n suorituskykytasoa, niin huhujen mukaisella muistiväylällä (256 bit / GDDR6) ei tarvittavaa suorituskykyä saavuteta ilman jotain luovaa teknologista ratkaisua, jolla riippuvuutta muistiväylän suorituskyvystä saadaan vähennettyä. Huhuttu "Infinity Cache" voisi olla tällainen. Huhujen mukaan tämä olisi 128 MB high-end-malleissa:

AMD Infinity Cache patent hints at RDNA 2 secret sauce

Sizeable unified cache will minimise drawbacks of the rumoured memory/bus configs?hexus.net

Asiakkaiden goodwill Nvidian suuntaan koki kolauksen. Varsinkin HC-pelaajat ovat trendsettereitä, vaikka firmat luulevat että homma hoituu YouTuben "staroilla". Kuluttajien suuntaan nostetun keskisormen tunnistan ja selitykset tuotantovaikeuksista eivät mene läpi. 3080 on huonon katteen tuote, ja mieluummin myyvät 3090 ja 3070-kortteja, joissa on parempi kate. 3080 on "myynnissä" , mutta lähinnä teoreettisena vaihtoehtona.

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 383

Todennäköisin vastaus on että ei mikään malli. Kyseessä on tuotteiden julkistus, ei myyntiintulo.Mikäs malli se nyt näistä tulee ylihuomenna myyntiin ja mihin aikaan? Itellä mennyt vähän ohi ko asia...

- Liittynyt

- 16.11.2016

- Viestejä

- 4 254

Nii nii että ei voikkaa vielä ostella tai edes yrittää mitään. Olikos tuosta ajankohdasta tarkempaa tietoa?Todennäköisin vastaus on että ei mikään malli. Kyseessä on tuotteiden julkistus, ei myyntiintulo.

Ylihuomenna tulee tarkempaa tietoa.Nii nii että ei voikkaa vielä ostella tai edes yrittää mitään. Olikos tuosta ajankohdasta tarkempaa tietoa?

- Liittynyt

- 17.10.2016

- Viestejä

- 1 998

Mutta huhuja on siis että 6800, 6800 XT ja 6900 XT olisi tulossa. Ehkäpä tavoitteena sama 5.11. kuin prosessoreilla, tosin tulisi testaajille aika hoppu jos ei vielä ole jo testattavana noita.Mikäs malli se nyt näistä tulee ylihuomenna myyntiin ja mihin aikaan? Itellä mennyt vähän ohi ko asia...

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 383

No ei kun huomenna se kerrotaan vasta. Mutta heitän AMD:n siihen skalpeerauksenestosokumenttiin ja johonkin muuhun randomluettuun juttuun perustuvan arvauksen että AMD yllättää positiivisesti ja 5.11. ryzen 5000 myyntipäivä on myös näiden myyntipäivä.Nii nii että ei voikkaa vielä ostella tai edes yrittää mitään. Olikos tuosta ajankohdasta tarkempaa tietoa?

- Liittynyt

- 13.11.2017

- Viestejä

- 155

Veikkaan että välissä on sama kolme viikkoa kuin julkaisupäivissä. 26.11 tulevat myyntiin.

Myös: Ryzen 5 -sarja → 5.11, RDNA2 6 -sarja → 26.11

Myös: Ryzen 5 -sarja → 5.11, RDNA2 6 -sarja → 26.11

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Päivää ennen Black Fridayta? Aika epätodennäköiseltä kuulostaa, että käytännössä ekoina myyntipäivinä kaikkea muuta myytäisiin polkuhinnoin mikä veisi kaiken huomionVeikkaan että välissä on sama kolme viikkoa kuin julkaisupäivissä. 26.11 tulevat myyntiin.

Myös: Ryzen 5 -sarja → 5.11, RDNA2 6 -sarja → 26.11

- Liittynyt

- 13.11.2017

- Viestejä

- 155

Päivää ennen Black Fridayta? Aika epätodennäköiseltä kuulostaa, että käytännössä ekoina myyntipäivinä kaikkea muuta myytäisiin polkuhinnoin mikä veisi kaiken huomion

Perhana pilasit teoriani logiikallasi

Tup3x

ツ

- Liittynyt

- 18.10.2016

- Viestejä

- 2 481

Ei välttämättä toimi SSAA oikein peleissä pakotettuna. Eikös Adaptive MSAA on aivan eri asia ja käytännössä sama juttu kuin NVIDIAn transparency AA.AMD:lta löytyy nykyisin Adaptive MSAA joka kai on jonkin verran parempi kuin pelkkä MSAA, ja sitten löytyy vielä tarkempi Supersampling (SSAA). Viimeksi mainittu taitaa jo jonkin verran hörpätä FPS:iä, en ole testannut.

Löytyyhän sieltä Nvidian Control Panelista kaikenlaista joo. Molempien kortteja olen käytellyt, ja pidän noita säätöjä kyllä marginaalisina suuntaan ja toiseen, mutta onko sinne Nvidialle sitten 2000/3000-sarjan korteille tullut jotain oikeasti merkittäviä? Ne erot pitäisi havaita silmällä myös, pelkkä ''tämä on parempi asetus'' -teksti ei paranna vielä mitään..

Onhan siellä AMD:llakin nykyisin Image Sharpeningia, pintakuvoinnin suodatuslaadun säädintä jne, mutta itse en ole jaksanut noita vertailla kuva vs kuva.

Mikä vika Freesync + AMD Enhanced sync -kombossa on? Tuo viimeksi mainittu käsittääkseni ''paranneltu V-sync''. Oli mikä oli, niin itse joudun nimenomaan alle 60fps jossain peleissä vetämään kun GPU käynyt vanhaksi, mutta hyvin nuo Freesync + Enhanced sync on ylimääräisen stutteroinnin ja repeilyn kyllä poistanut. Freesyncin range alhaalla taitaa olla 44 vai 48 asti, ja se riittää hyvin. Edit: Siinä vaiheessa kun mennään alle tuon, niin pelikokemus alkaa olla jo enemmän tai vähemmän kuraa eli -> Uutta GPU:ta. Freesync toimii kuin junan vessa.

Enahcned syncissä on sama vika kuin NVIDIAn fast syncissä - nykiminen.

Täytyy myös tunnustaa, että en saanut Freesynciä toimimaan omalla Renoir läppärillä vaikka täppä päällä.

Tuli sattumalta silmään toisaalla. Ilmeisesti se kyllä toimii DX10 & DX11 peleissä (tai sitten ei - DX12 oli vain puhe). Jos toimii vain DX9 peleissä, niin sitten on kyllä vielä heikompi homma...Jotain lähdettä tälle väitteelle?

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Siis kyse on mahdollisuudesta pakottaa AF ajureista päälle, mikä on tuettu vain DX9-peleissä. Kyllä se Anisotropic Filtering toimii myös DX10, 11 ja 12, mutta se pitää pistää päälle pelistä.Tuli sattumalta silmään toisaalla. Ilmeisesti se kyllä toimii DX10 & DX11 peleissä (tai sitten ei - DX12 oli vain puhe). Jos toimii vain DX9 peleissä, niin sitten on kyllä vielä heikompi homma...

Tup3x

ツ

- Liittynyt

- 18.10.2016

- Viestejä

- 2 481

Niin, siis puhe on nyt siitä, että toimiiko ajureista pakotus vai ei. Siitä nyt ei ole epäilystäkään, etteikö peleissä toimisi jos vain devaajat ovat sen laittaneet päälle (noh, joissain se implementointi on todella kuraa, mutta...).Siis kyse on mahdollisuudesta pakottaa AF ajureista päälle, mikä on tuettu vain DX9-peleissä. Kyllä se Anisotropic Filtering toimii myös DX10, 11 ja 12, mutta se pitää pistää päälle pelistä.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 701

Alkuperäinen väite oli ettei Anisotropic Filtering toimisi lainkaan DirectX 12 -rajapinnalla, vasta Googletuksen perusteella selvisi että kyse olikin todellisuudessa tuosta pakotuksesta mikä ei toimi myöskään 10 ja 11.Niin, siis puhe on nyt siitä, että toimiiko ajureista pakotus vai ei. Siitä nyt ei ole epäilystäkään, etteikö peleissä toimisi jos vain devaajat ovat sen laittaneet päälle (noh, joissain se implementointi on todella kuraa, mutta...).

Tup3x

ツ

- Liittynyt

- 18.10.2016

- Viestejä

- 2 481

Ei ollut, mutta hieman epäselvästi ilmaistu. Puhe oli koko ajan ajurin tarjoamista säädöistä. En nyt tiedä miten kukaan voisi edes kuvitella, että nykyaikainen kortti ei muka tukisi anisotrooppista suodatusta peleissä. Varmaan pakollinen ominaisuus kaikissa paitsi muinaisimmissa rajapinnoissa.Alkuperäinen väite oli ettei Anisotropic Filtering toimisi lainkaan DirectX 12 -rajapinnalla, vasta Googletuksen perusteella selvisi että kyse olikin todellisuudessa tuosta pakotuksesta mikä ei toimi myöskään 10 ja 11.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Enahcned syncissä on sama vika kuin NVIDIAn fast syncissä - nykiminen.

Joo nykiihän se kun alle 50fps mennään, kun inputlagit yms. kasvaa. Itse en ole mitään ekstra-nykimisiä tai repeilyä nähnyt. Toki n. 99,9% ajasta olen FPS:ssä Freesyncin rangessa. Kun alle 48 fps mennään niin inputlagit yms. alkaa kasvamaan jo sen verran että nykiihän se, ja tuossa kohtaa katselisin kyllä uutta korttia koneeseen.

Mutta alkuperäiseen viestiisi viitaten, jos haluat RDNA2 välttää noiden mainitsemiesi seikkojen vuoksi, niin sitten vältät. Huonoja syitä mun mielestä, mutta kukin toki valitsee sen GPU-brändinsä miten haluaa. Vaikea noista Nvidia vs AMD pelissä X -videoista on eroja löytää suuntaan tai toiseen, mutta sitä en tiedä käytetäänkö noissa niitä mainitsemiasi Nvidian kuvanlaatu gimmickkejä.

Nyt on pakko jo kysyä, mikä sai mielen näin äkkiä muuttumaan, että kynnyskysymykseksi on muutamassa päivässä muodostunut esim. anistrooppisen suodatuksen kytkeminen päälle ajureista jne.?Itselle lähtee ostoon se joka tarjoaa parhaan nopeus/€ (ja W) suhteen. Myös muistin määrä painaa vaakakupissa. 8GB:n kortteja en edes harkitse. Tässä vaiheessa saisi jo olla tuplat - johan noita 8GB kortteja on ollut jo aivan liian kauan.

- Liittynyt

- 17.10.2016

- Viestejä

- 10 671

Itse ainakin (tähän saakka) olen jokaisen pelin omista valikoista tehnyt ne säädöt ja valinnat peliin enkä mitään yleisvalintoja (TM) jostain näytönohjainvalmistajan omasta paneelista.

En koe sitä niin suureksi uhraukseksi ja samalla kun kuitenkin tulee ajettua suorituskykytestejä niin samalla teen säätöjä ja katson miten se vaikuttaa siihen FPS:n ja myös kuvan laatuun.

Ehkä asia on sitten eri henkilöillä jotka ostavat aina sen kalleimman näytönohjaimen ja pienimmällä resoluutiolla sekä max 60Hz taipuvalla näytöllä pelaavat niin ei tarvitse erikseen katsoa pelin asetuksia vaan voi luottaa siihen että kun ne kerran on ajureiden asennuksen yhteydessä (samalla kun näytönohjaimen ostanut) laittanut niitä ei tarvitse enää ikinä katsoa ellei softa sitten ärsyttävästi päivitä itseään ennenkuin uudempi "kallein näytönohjain" taas julkaistaan.

En koe sitä niin suureksi uhraukseksi ja samalla kun kuitenkin tulee ajettua suorituskykytestejä niin samalla teen säätöjä ja katson miten se vaikuttaa siihen FPS:n ja myös kuvan laatuun.

Ehkä asia on sitten eri henkilöillä jotka ostavat aina sen kalleimman näytönohjaimen ja pienimmällä resoluutiolla sekä max 60Hz taipuvalla näytöllä pelaavat niin ei tarvitse erikseen katsoa pelin asetuksia vaan voi luottaa siihen että kun ne kerran on ajureiden asennuksen yhteydessä (samalla kun näytönohjaimen ostanut) laittanut niitä ei tarvitse enää ikinä katsoa ellei softa sitten ärsyttävästi päivitä itseään ennenkuin uudempi "kallein näytönohjain" taas julkaistaan.

varakreivi de Valmont

cunning linguist

- Liittynyt

- 16.10.2016

- Viestejä

- 1 379

e: väärä alue

- Liittynyt

- 20.10.2016

- Viestejä

- 4 246

Infinity cache 128mb taitaa olla vahvistettu.

- Liittynyt

- 26.10.2016

- Viestejä

- 1 086

Saatan kysyä tyhmiä, mutta on tuolla tekniikalla mitään haittaa missään? Esimerkiksi työkäytössä?Infinity cache 128mb taitaa olla vahvistettu.

nVidian malli on enemmän "brute force"-ratkaisu ja suurempi muistikapasiteetti on käytössä kaikilla työkuormilla.Saatan kysyä tyhmiä, mutta on tuolla tekniikalla mitään haittaa missään? Esimerkiksi työkäytössä?

Jos huhuttu AMD:n Infinity Cache pitää paikkansa, saattaa tällainen cache-pohjainen ratkaisu olla voimakkaammin riippuvainen käytetyn työkuorman tavasta tehdä muistihakuja: Cachen hyöty ei välttämättä ole kaikenlaisilla työkuormilla yhtä suuri.

Mutta käytännön testit tulevina viikkoina tulevat kertomaan ratkaisun hyvät ja huonot puolet.

Onhan sillä, hinta nousee verrattuna tilanteeseen jossa kyseistä välimuistia ei ole piirillä. Lisäksi tehonkulutus on korkeampi verrattuna tilanteeseen jossa sitä ei ole. Eli jos lähinnä istut desktopilla, niin sun sähkölasku ja kortista maksettu hinta on korkeammat. Käytännön suorituskyky tuskin missään tilanteessa laskee tuon takia, jotkut muistihaut voi toteutuksesta riippuen olla marginaalisesti hitaammat joillain epätyypillisillä kuormilla, mutta ei niillä GPU puolella ole niin väliä.Saatan kysyä tyhmiä, mutta on tuolla tekniikalla mitään haittaa missään? Esimerkiksi työkäytössä?

- Liittynyt

- 17.10.2016

- Viestejä

- 10 671

Onhan sillä, hinta nousee verrattuna tilanteeseen jossa kyseistä välimuistia ei ole piirillä. Lisäksi tehonkulutus on korkeampi verrattuna tilanteeseen jossa sitä ei ole. Eli jos lähinnä istut desktopilla, niin sun sähkölasku ja kortista maksettu hinta on korkeammat.

En usko että kysyjä tarkoitti ihan tuota. Samat "haittapuolet" voisi esittää myös jos ostaa erillisen GPU:n vs prosessoriin integroitu (eli hinta nousee ja tehonkulutus on myös korkeampi vs että ostaisi pelkän CPU:n).

Toki jos AMD tuo myyntiin kortin ilman tuota välimuistia JA välimuistin kanssa näemme onko hinnannousua 100% samanlaisissa korteissa vai ei..

- Liittynyt

- 26.10.2016

- Viestejä

- 1 086

Juu siis lähinnä nuo Davinci resolve, Blender, yms.. suorituskyvyt. Ne käyttää korttia hieman eri tavalla mitä pelit.En usko että kysyjä tarkoitti ihan tuota. Samat "haittapuolet" voisi esittää myös jos ostaa erillisen GPU:n vs prosessoriin integroitu (eli hinta nousee ja tehonkulutus on myös korkeampi vs että ostaisi pelkän CPU:n).

Toki jos AMD tuo myyntiin kortin ilman tuota välimuistia JA välimuistin kanssa näemme onko hinnannousua 100% samanlaisissa korteissa vai ei..

No muitakaan haittapuolia ei ole ja noi on periaatteessa ihan konkreettisia asioita.En usko että kysyjä tarkoitti ihan tuota. Samat "haittapuolet" voisi esittää myös jos ostaa erillisen GPU:n vs prosessoriin integroitu (eli hinta nousee ja tehonkulutus on myös korkeampi vs että ostaisi pelkän CPU:n).

Toki jos AMD tuo myyntiin kortin ilman tuota välimuistia JA välimuistin kanssa näemme onko hinnannousua 100% samanlaisissa korteissa vai ei..

Ei se cache tule noiden suorituskykyä laskemaan, mutta ei välttämättä sitä kauheasti nostakkaan. Joissain softissa olisi varmasti eduksi jos sama piirin pinta-ala oltaisiin käytetty johonkin muuhun, ja toisissa olisi eduksi jos se cache voisi olla vielä isompi laskentayksiköiden kustannuksella.Juu siis lähinnä nuo Davinci resolve, Blender, yms.. suorituskyvyt. Ne käyttää korttia hieman eri tavalla mitä pelit.

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 383

Se suunnittelupäätös jolla cacheen JA kapeaan muistiväylään sen sijaan voi vaikuttaa suorituskykyyn. Vielä ei ole tiedossa korvaako cache sushteellisen onnettoman muistikaistan kaikissa mahdollisissa tilanteissa.Ei se cache tule noiden suorituskykyä laskemaan, mutta ei välttämättä sitä kauheasti nostakkaan. Joissain softissa olisi varmasti eduksi jos sama piirin pinta-ala oltaisiin käytetty johonkin muuhun.

Kyllä, mutta Eternal kysyi nimenomaan cachesta syntyviä haittoja.Se suunnittelupäätös jolla cacheen JA kapeaan muistiväylään sen sijaan voi vaikuttaa suorituskykyyn. Vielä ei ole tiedossa korvaako cache sushteellisen onnettoman muistikaistan kaikissa mahdollisissa tilanteissa.

Kaikkien piirien kohdalla voidaan haitaksi katsoa liian pieni piiri, matala kellontaajuus, korkea virrankulutus ja liian kapea muistiväylä jne.

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 383

Tuskinpa kysyi. Tai ehkä lukemalla kuin piru raamattua, mutta luulen että muut, lukuunottamatta sinua, tajusi kyllä mitä kysyttiin.Kyllä, mutta Eternal kysyi nimenomaan cachesta syntyviä haittoja.

Kaikkien piirien kohdalla voidaan haitaksi katsoa liian pieni piiri, matala kellontaajuus, korkea virrankulutus ja liian kapea muistiväylä jne.

Ja toinenkin pointtisi on taas aivan omituista lässytystä. Tämän tuotteen muistikaistan balanssia eri kuormilla suhteessa muuhun voidaan arvioida ihan normaalisti. Cache ratkaisun toimiessa kaikessa hyvin ei ole sen kummmein valittamista, mutta jos tulee hittiä suhteessa amd:n edellisiin tai kilpailijoihin joissakin mainituissa työsovelluksissa, niin asiasta voidaan amdtä moittia.

Uutiset

-

Qualcommin tuleva Snapdragon 8 Elite Gen 6 Pro vilahtaa vuotokuvassa Samsungin jäähdytysratkaisun kera

9.2.2026 23:42

-

Qualcomm ylsi ennätysliikevaihtoon päättyneellä neljänneksellä

6.2.2026 13:06

-

ASRock antoi lopulta virallisen lausunnon sen emolevyillä palaneista Ryzen-prosessoreista

6.2.2026 13:04

-

Nikkei: Muistikriisi ajaa tietokonevalmistajia kiinalaisyritysten syliin

6.2.2026 12:57

-

Noctua on toimittanut asiakkailleen jo 500 000 coolerin päivitettyä asennussarjaa

6.2.2026 12:55

Uusimmat viestit

-

-

-

-

-

Yhdysvaltain 45. ja 47. presidentti Donald J. Trump

- Viimeisin: FarColdDistance