Pelikohtaista toki, mutta kyllä se 60fps on tarpeeksi nopea yleensä. Siihen vaan ei tahdo päästä nykyraudalla kuin 1080p resolla.

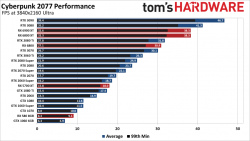

Esimerkiksi Gamers Nexus testien mukaan Cyberpunkissa 3080 jää alle 60fps keskivarvolle ja low menee lähellä 30fps 4k/DLSS Performance (eli 1080p reso käytännössä)

Kaikki pelit ei varmasti ole Nvidian sponsoroimia eli ei voida laskea sen varaan että DLSS tulee löytymään kaikista.

1440p resolle ei 3080 oikein riitä Cyberpunkkiin säteenjäljitys päällä. 4k/DLSS Quality ~42fps avg. (renderöintiresoluutio 1440p)

Tuo 60fps jää haaveeksi natiivina ihan ilman että RT on mukana kuvioissa. Mitenkäs sitten tehdään 4K ruutujen omistajien keskuudessa? Jätetään peli ostamatta ja pelataan ehkä joskus ensi tai sitä seuraavan sukupolven arkkitehtuureilla?