Jos teet testejä jälkijunassa vs muut, jolloin kortit olivat relevantteja eli tuoreita julkaisuja, niin toki ne arvosteltiin sen hetkisen tilanteen mukaan, ajurit ja pelit ovat kehittyneet/päivittyneet niistä testeistä. Enkä suoraan sanottuna luota sinun tuntemuksiin, kun menit kehumaan: "Referenssi on parempi kuin 3rd party aftermarket jäähy".

Ja onko yllättävää, että itsekin Youtube testaajana vierastat ns. kilpailijoita?

Ainiin ja unohtui se Lacsativen Nvidia fanipoika lainaus lisätä, niin lisään sen tähän uusimpaan viestiin.

Itse testaan siis prossuja enimmäkseen ja näytönohjain jutut tulee aina vaan tuossa pelikone juttujen yhteydessä. Mainittakoon että meinasin tehdä näytönohjain testejä, mutta aikaa ja rahaa minulla ei ollut siihen.

Ja se minun usko GN ja HWU tyyppeihin meni kun ovat suorittaneet noita SER testejä (esim GN: PLEXHD X79 emolevy testi ja HWU: LGA1366 testi)

Ensin kumpikaan ei tiedostanut että niille kyseisille alustoilla (LGA2011 ja LGA1366) KUULUU ostaa Xeoni, ei ylihintaisia Core i7, eivätkä edes Xeoneista mainitteen.

Varsinkin HWU:n LGA1366 testissä lyötiin muisteiksi jotain kasa paskaa, kellotettiin koko setti aivan väärin ja näin päästiin haukkumaan se että on kallis (Core i7 malli on vieläkin 100€ kun Xeoni 10€) ja hidas romu.

Eli kummatkin haukkuivat nuo jutut sen takia koska eivät ITSE TIENNEET asioita, eivätkä viittineet ottaa asioista selvää. Ja tämä on syy miksi en kumpaakaan lähdettä enää seuraa kun usko meni täysin.

Muista suurista tubettamista ennen seurasin JayTwoCenttiä ja vaikka oli täys Nvidia fan boy, mutta ei se minua haitannut ja sen materiaali oli parasta kun teki videoitaan vieä kotonaan.

Sittemmin kun hommasin studion, niin se joku siitä katosi samassa ja nykyään en tilaa enää sen kanavaa.

Vierastan kilpailijoita ? En minä kilpaile kenenkään kanssa, ei minua se asia kiinnosta. Tykkään leikkiä vanhan raudan kanssa että paljon siitä saa puristettua ulos ja Youtube kanavan (ja BitTube kanavan) avulla vaan haluan näyttää muillekkin mihin ne kykenee. Ja tämä on minulle harrastus ja tulee pysymäänkin tulevaisuudessakin.

Mitä referenssi coolereihin niin minä tykkään niistä kun puhaltavat kuuman ilman ulos ja ovat paljon paremman näköisiä kuin nuo 3rd party ledi häkkyrä viritelmät.

Edelleen lempparini on Nvidian referenssi desing minkä ne otti käyttöön GTX 690:n yhteydessä, mutta ne uusi sitä GTX 1000-sarjan kohdalla siitä en jostain syystä enää niin tykkää ja RTX:n mukana tullut viimeisin olikin jo aika kauhea.

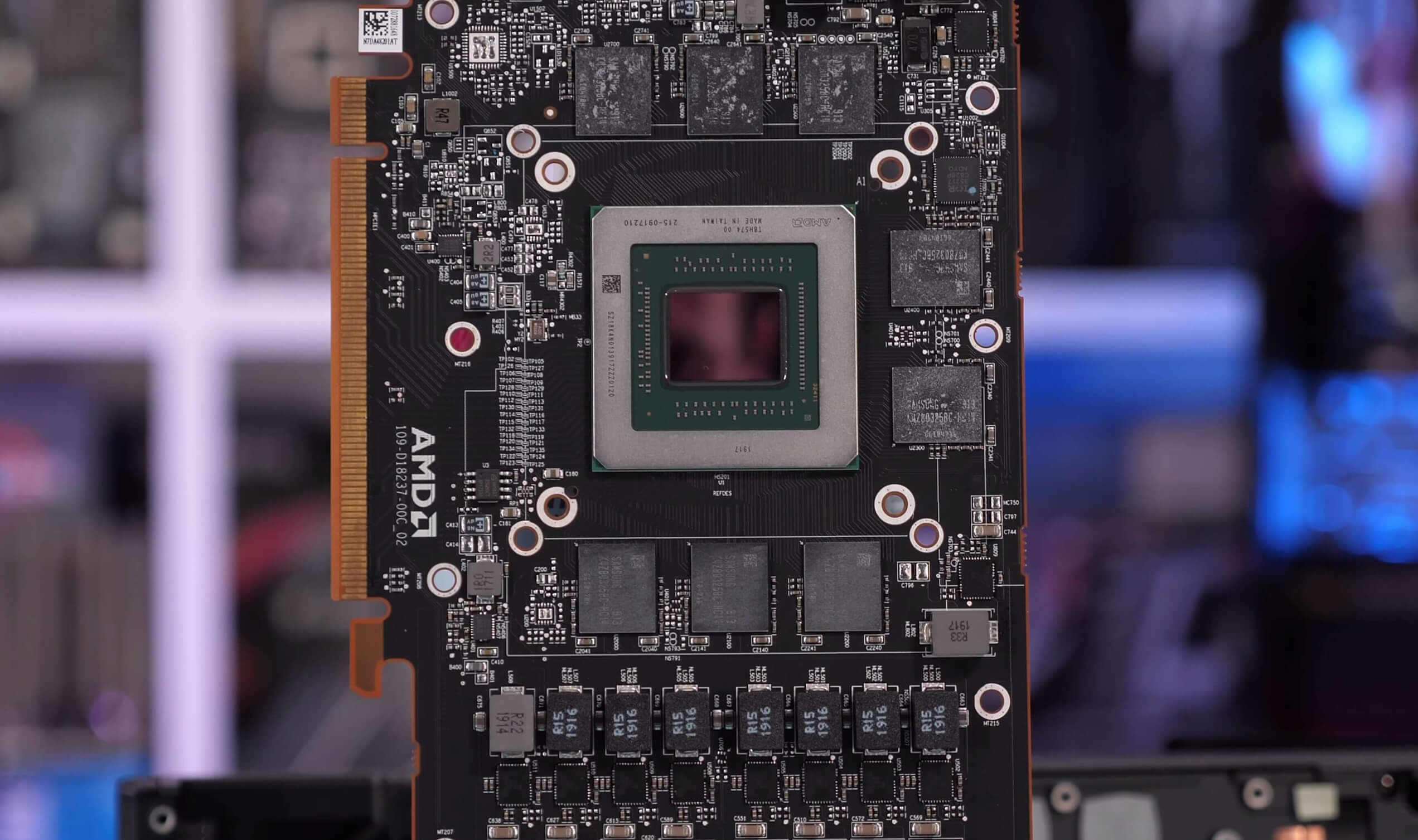

Furyjen, Vegojen ja RX 5700 (XT) referenssit ovat myös iloa silmälle, eli simppeliä desingiä ja se siitä.

Toki ei nuo äänettömiä ole, minkä huomaa oikein hyvin kun testipenkissä niitä pitää kiinni. Mutta kun vähänkään hyvään koteloon laittaa sisälle, niin eipä niistä kuulu pahemmin kotelon ulkopuolelle.

Tämä toki riippuu mistä blower jäähystä puhutaan, kun Nvidian mallit ovat olleet aina suht hiljaisia ja AMD:llä taas R9 200-sarjan vehkeet olivat vielä aika äänekkäitä.

Sinä et luota minun tuntemuksiini ? Kuule ole luottamatta ei ole minulta pois. Luota vaan itseesi ja mesoa Nvidian puolesta ja AMD:tä vastaan lisää kun sen ainakin osaat