Koetappas nykyisin jotain CSGO:ta jollain roskaresolla ja paskalla fps:llä, ei siitä tule mitään. Melkeen tuntuu, että 50+ pingikin antaa selkeän altavastaaja aseman. Huvittaa kun joskus aikanaan foorumeilla kiisteltiin tekikö yli 30 fps mitään, kun silmä ei muka huomannut eroa. Itse vanhana puusilmänäkin huomaan 60hz ja 144Hz näytön eron helposti. Samoiten jos fps putoaa jostain 120+ -> 80 sen huomaa pykimisenä. Yksinpelit sitten asia erikseen, niissä vastustajat eivät ammut suoraan silmään 0,1 sekunnissa.Enpä ole itse kokenut ongelmana, varsinkaan jossain yksinpeleissä. Mut tääkin on taas näitä, nykyään ei kuulemma pysty pelaamaan 30 FPS, mutta voi silloin kun minä olin nuori niin pelattiin hypernopeita moninpeliräiskintöjä kuten vaikka QuakeWorldia jollain 640x480 resolla, 20 FPS ja +100 ms pingillä ja _silti_ pwnattiin.

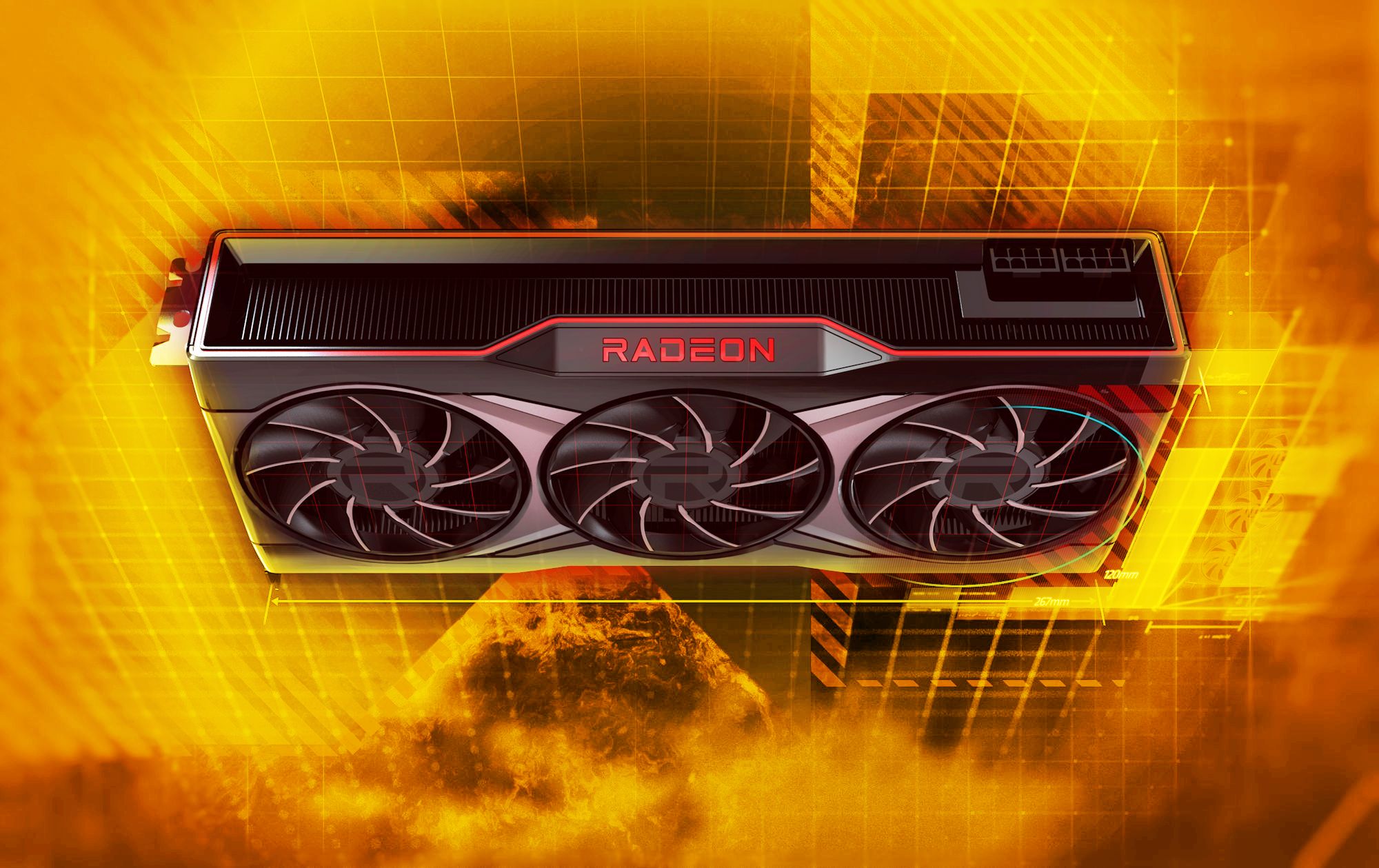

Edelliseen liittyen tuntuu, että 1660TI ei riitä millään nykykynärin pelaamiseen 1440p resolla. Detailit minimissäänkin dps on jotain 120 paikkeilla ja droppailee siitä alas. Resoa laskiessa taas vihuja ei erota niin selkeästi. Pakko varmaankin kääntyä taas Nvidian puoleen kun tuo DLSS vaikuttaisi niin houkuttelevalta ominaisuudelta. Kun uusi kortti alkaa joskus tulevaisuudessa nykyimään, niin sillä saisi vähän lisäaikaa detailien kustannuksella. Kunhan tuo 3060ti:n hinta putoaa vielä jonkun 50e niin aika painaa tilausnappia.