-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2024 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA-spekulaatioketju (Lovelace ja tulevat sukupolvet)

Miksi hinta olisi 740e..?Jos 4080 tarjoaa 50% lisätehoa hintaan 740€, homma olis jees. 1080->2080->3080 tehot kasvaneet noin 50% per geni. Mallinumerot ovat triviaaleja, ja hinta-perf on se joka kiinnostaa.

Eiköhän 4080 oli luokkaa 1000e+

Juuri tätä samaa kirjoitin, eli mallinumerot ovat triviaaleja, ja hinta-perf on se, mihin pitää katsoa. Muuten on porukka liian vahvasti hypejunassa, ja vanhoja "mummokortteja" myydään alihintaan, kun nahkatakin hihasta tipahtaa überlupauksia.Miksi hinta olisi 740e..?

Eiköhän 4080 oli luokkaa 1000e+

Itse hyödyin paljon tuosta ylihypestä, lähinnä kuitenkin kauppojen tappioksi, yksityisiä en niistänyt. Toivon että porukka ei mene tähän hypeen kuten viimeksi, eli "ostoilmoitus, ostan vanhan ja tehottoman RTX 3080 hintaan 400€, koska pian tulee 4080 joka maksaa x ja on niin paljon parempi..." Totuus on sitten aivan jotain muuta. Aika näyttää.

Pelle Ethanol

Team R&T

- Liittynyt

- 18.10.2016

- Viestejä

- 226

Itselle ihan ok hinta 4080 on 1000-1500€, veikkaisin sen olevan lähempänä tuota yläpäätä. Mutta minkäs teet kun olet VR-junassa simujen kanssa ja 3080, eikä 3090 riitä.

Eiköhän nuo kortit mene kuin kuumille kiville noilla em. Hinnoilla.

Eiköhän nuo kortit mene kuin kuumille kiville noilla em. Hinnoilla.

Voisihan louhintaan ja laskentaan tehdä ihan omat piirit, joissa ei ole sille hommalle turhia yksiköitä. Saisi paljon suorituskykyisempiä piirejä ja jos niille on kerran menekkiä, niin varmaankin kannattasikin tehdä. Hintaakin voi lätkäistä sitten suorituskyvun mukaan (Eli reippasti enemmän, kuin saman piialan vievälle peli GPU:lle).Toivottavasti nvidia ei tee nuihin louhinnanestosirua tai mitään. Menisi paljon hyvää potenttiaalia hukkaan.

PeliGPUhun kannatttaa ehdottomasti pistää mahdollisimman tiukat rajoitukset, jolloin se ei haittaa pelaajia, mutta saadaan myytyä sitten enemmän ja parempaan hintaan tuotteita louhijoille..

Jos esim peliGPU:issa saadaan tiputettua suorituskyky 1/4 osaan louhinnassa ja laskennassa, niin laskentakortteja voidaan myydä jo sen johdosta 3 kertaiseen hintaan ja niillä saadaan senemmän, kuin sama suorituskyky louhinnassa.. Jos niissä on vielä piirin rakenne optimoitu, niin hintaa voidaan todennäköisesti siitäkin esim tuplata ja silti suorituskyky /hinta peittoaa pelinäyttikset, eikä sotketa pelinäyttisten kauppoja..

- Liittynyt

- 13.12.2016

- Viestejä

- 4 881

Toivottavasti nvidia ei tee nuihin louhinnanestosirua tai mitään. Menisi paljon hyvää potenttiaalia hukkaan.

Toivottavasti pelikorteilla ei pystyisi louhinnan ollenkaan (juu ei tule valitettavasti onnistumaan tämmöinen esto). "Kaivosmiehille" voisi sitten olla ihan omat tuotteensa, jotka maksaa alkaen 2k€.

- Liittynyt

- 13.12.2016

- Viestejä

- 4 881

Jos 4080 tarjoaa 50% lisätehoa hintaan 740€, homma olis jees. 1080->2080->3080 tehot kasvaneet noin 50% per geni. Mallinumerot ovat triviaaleja, ja hinta-perf on se joka kiinnostaa.

2080 --> 3080 oli kyllä 80-90% hyppy

- Liittynyt

- 21.02.2017

- Viestejä

- 5 391

Ehkä jossain cherry pickatussa RT skenaariossa (esim. q2rtx).2080 --> 3080 oli kyllä 80-90% hyppy

TPU:n 3080 FE revikassa 67% nopeampi @ 4K.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 391

Hopper julkistus tiistaille aikalailla confirmed

Tuossa kun mainitsin jo vesijäähyilyn.. Vesijäähyt ovat mutkikkaita, kalleita, vikaherkkiä, hankalampia asentaa ja voivat aiheuttaa helpommin takuuongelmia.

Esim kun (ei siis jos) jäähy vuotaa, niin

Jos vesijäähdytetyt koneet olisi keksitty ennen ilmajäähdytteisiä, kotelot olisi suunniteltu eri tavalla, jotta satunnaiset vuodot ei rikkoisi konetta. Emolevy olisi esim ruuvattu vaakamallisen kotelon kattoon, prosu ja näytönohjain olisi emolevyn alapuolella. Kopan pohjassa olisi viemäröinti viereiseen kukkaruukkuun parketin suojaamiseksi. Ja ilmankierto ehkä vähän eri tavalla ajateltu.

(Eli meinaan että oikkareille altis asennustapa johtuu siitä polusta jolla nykyiseen tilanteeseen on tultu, ja kenellekään ei tule mieleen kyseenalaistaa, semmoista se monesti on. Kunnes sitten joku keksii yksinkertaisen idean ja tekee sillä hyvää bisnestä kunnes se on valtavirtaa)

Viimeksi muokattu:

4080 ei ilmeisesti ole varmuutta millä piirillä olisi tulossa? Samaten 4070 koska huhuissa on myös ad103?

ja jos 4080 on ad103 piirillä ero cuda core määrässä esim. 4090 on todella iso...

Lisänä on kiinnostava tuo GH202 piiri, koska datacenter malli näyttäisi perustuvan GH100 piiriin.....

ja jos 4080 on ad103 piirillä ero cuda core määrässä esim. 4090 on todella iso...

Lisänä on kiinnostava tuo GH202 piiri, koska datacenter malli näyttäisi perustuvan GH100 piiriin.....

Viimeksi muokattu:

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 257

Olen miettinyt niitä huhuttuja 600W ja 800W virrankulutuksia. 30x sarjahan taitaa olla aika muistikaistarajotteinen ja siten ei säteenseuranta ja tensoriytimet voi mennä täyttä laukkaa kun compute shadereita käytetään. Itse asiassa tensoriytimet kai voivat yksinäänkin syödä kaiken muistikaistan.

Voisikohan osa huhutusta 40x0 lämmöntuotosta johtua siitä, että kiitos ison cachen noita erillisiä yksiköitä voidaan pitää paremmin päällä yhtä aikaa? Tyyliin BVH puu mahtuu cacheen ja muistikaistaa vapautuu toisille yksiköille tms. Voi toki olla myös ihan vain kilpailun vuoksi. Osa korttimalleista kellotetaan tappiin, koska nvidia olettaa amd:lta tulevan erittäin suorituskykyistä rautaa.

Voisikohan osa huhutusta 40x0 lämmöntuotosta johtua siitä, että kiitos ison cachen noita erillisiä yksiköitä voidaan pitää paremmin päällä yhtä aikaa? Tyyliin BVH puu mahtuu cacheen ja muistikaistaa vapautuu toisille yksiköille tms. Voi toki olla myös ihan vain kilpailun vuoksi. Osa korttimalleista kellotetaan tappiin, koska nvidia olettaa amd:lta tulevan erittäin suorituskykyistä rautaa.

Viimeksi muokattu:

- Liittynyt

- 17.10.2016

- Viestejä

- 4 751

No jos sieltä tulee jotain yli 450w TDP rautaa niin mun rahat on tässä selityksessä. Jos muistelee tässä aikasempia rautajulkasuja niin ekana tulee mieleen et noi virrankulutukset on lähteny käsistä siinä vaiheessa kun ollaan ns. kusessa kilpailijaan nähden ja se tiedetään. Esimerkiks se AMD:n FX-9590 prossu joka oli vaan äärimmilleen venytetty 8350 kohtalaisen jäätävällä virrankulutuksella, joka siltikin otti pataan Inteliltä. Toisaalta samaa efektiä on näkyny Intelinkin leirissä, ainakin 11900k vielä imeskeli virtaa aika antaumuksella ja kävi kuumana. Yhteistä näillä molemmilla on se et ne on julkastu siinä vaiheessa kun on tilanne vähän ikävä.Voi toki olla myös ihan vain kilpailun vuoksi. Osa korttimalleisga kellotetaan tappiin, koska nvidia olettaa amd:lta tulevan erittäin suorituskykyistä rautaa.

Ei tohon käsiin levinneeseen virrankulutukseen oikeastaan koskaan taida kovinkaan paljon monimutkasempaa selitystä olla kun se et yritetään pysyä kilpailussa mukana. Ainakin näissä kuluttajapuolen vehkeissä.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 257

No jos sieltä tulee jotain yli 450w TDP rautaa niin mun rahat on tässä selityksessä. Jos muistelee tässä aikasempia rautajulkasuja niin ekana tulee mieleen et noi virrankulutukset on lähteny käsistä siinä vaiheessa kun ollaan ns. kusessa kilpailijaan nähden ja se tiedetään. Esimerkiks se AMD:n FX-9590 prossu joka oli vaan äärimmilleen venytetty 8350 kohtalaisen jäätävällä virrankulutuksella, joka siltikin otti pataan Inteliltä. Toisaalta samaa efektiä on näkyny Intelinkin leirissä, ainakin 11900k vielä imeskeli virtaa aika antaumuksella ja kävi kuumana. Yhteistä näillä molemmilla on se et ne on julkastu siinä vaiheessa kun on tilanne vähän ikävä.

Ei tohon käsiin levinneeseen virrankulutukseen oikeastaan koskaan taida kovinkaan paljon monimutkasempaa selitystä olla kun se et yritetään pysyä kilpailussa mukana. Ainakin näissä kuluttajapuolen vehkeissä.

Sinällään 30x0 ja oletettavasti 40x0 sarja on uniikkeja, kun niissä on ne dedikoitut tensoriytimet ja säteenseurantayksikkö. Etenkin se tensoriydin tahtoo imaista kaiken muistikaistan. kun tensoriydintä käytetään niin säteenseuranta/compute ei käytännössä etene kuin madellen, koska muistikaista ei riitä niiden syöttämiseen. Iso cache voisi auttaa tässä paljon.

Mutta toki se paras ja loogisin selitys on ihan vain kilpailu ja tarve kellottaa piirit tappiin. Mielenkiinnolla odotan ensi syksyä ja arvosteluita. Kiinnostaa paljon miten amd:n chiplet ratkaisu toimii(samanlainen kuin apple?) ja mitä nvidia saa aikaan huhutulla isolla 96MB cachella.

Viimeksi muokattu:

Ja miten tää maastoutuu käytännön suorituskykyyn? Mitä pelit tarjoavat kapasiteetin vastineeksi?Sinällään 30x0 ja oletettavasti 40x0 sarja on uniikkeja, kun niissä on ne dedikoitut tensoriytimet ja säteenseurantayksikkö. Etenkin se tensoriydin tahtoo imaista kaiken muistikaistan. Silloin tensriydintä käytetään niin säteenseuranta/compute ei käytännössä etene kuin madellen, kun muistikaista ei riitä niiden syöttämiseen. Iso cache voisi auttaa tässä paljon.

Mutta toki se paras ja loogisin selitys on ihan vain kilpailu ja tarve kellottaa piirit tappiin. Mielenkiinnolla odotan ensi syksyä ja arvosteluita. Kiinnostaa paljon miten amd:n chiplet ratkaisu toimii(samanlainen kuin apple?) ja mitä nvidia saa aikaan huhutulla isolla 96MB cachella.

Nyt tuntuu olo aasilta, kun noilla top-end -näyttiksillä saa lähinnä lisättyä varjojen yksityiskohtaisuutta.

Mun on käytännön syistä vaikea nähdä syytä päivittää näyttiksiäni (RTX 3080 ja 3070ti).

Top end näyttiksillä on aina ollut sama idea:Ja miten tää maastoutuu käytännön suorituskykyyn? Mitä pelit tarjoavat kapasiteetin vastineeksi?

Nyt tuntuu olo aasilta, kun noilla top-end -näyttiksillä saa lähinnä lisättyä varjojen yksityiskohtaisuutta.

Mun on käytännön syistä vaikea nähdä syytä päivittää näyttiksiäni (RTX 3080 ja 3070ti).

Pelit saa näyttämään hieman paremmilta ja / tai saa enemmän FPS:ää..

Ei tässä ole kertakaikkisen yhtään mitään uutta. Näin on ollut aina uusien näyttisten julkaisun aikoihin.

Hyväpuolikin asiassa on: Ei ole yhtään mikään pakko ostaa niitä top-end näyttiksiä, jos "se tuntuu aasilta". Voi ostaa vaikka low end näyttiksen ja pistää pelin asetukset ja reson pienemmälle. Itse pelistä se ei jätä ulkoasun lisäksi mitään pois.

Hyvin monet tosin haluavat esim FPS !!!!!MAX MAX MAX MAX!!!!!! tai mahdollisimman hyvännäköisen lopputuloksen (= nopea säteenseuranta on täysin pakollinen), jolloin sen top-end näyttiksen ostaminen on avain tyytyväisyyteen.

Top end näyttiksillä on aina ollut sama idea:

Pelit saa näyttämään hieman paremmilta ja / tai saa enemmän FPS:ää..

Plus jokunen harva vakaumuksellinen jotka uusii koko konepaketin aina 6 v välein, niin se tarvitaan, jotta pelit pyörähtää vielä vuonna 6.

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 5 703

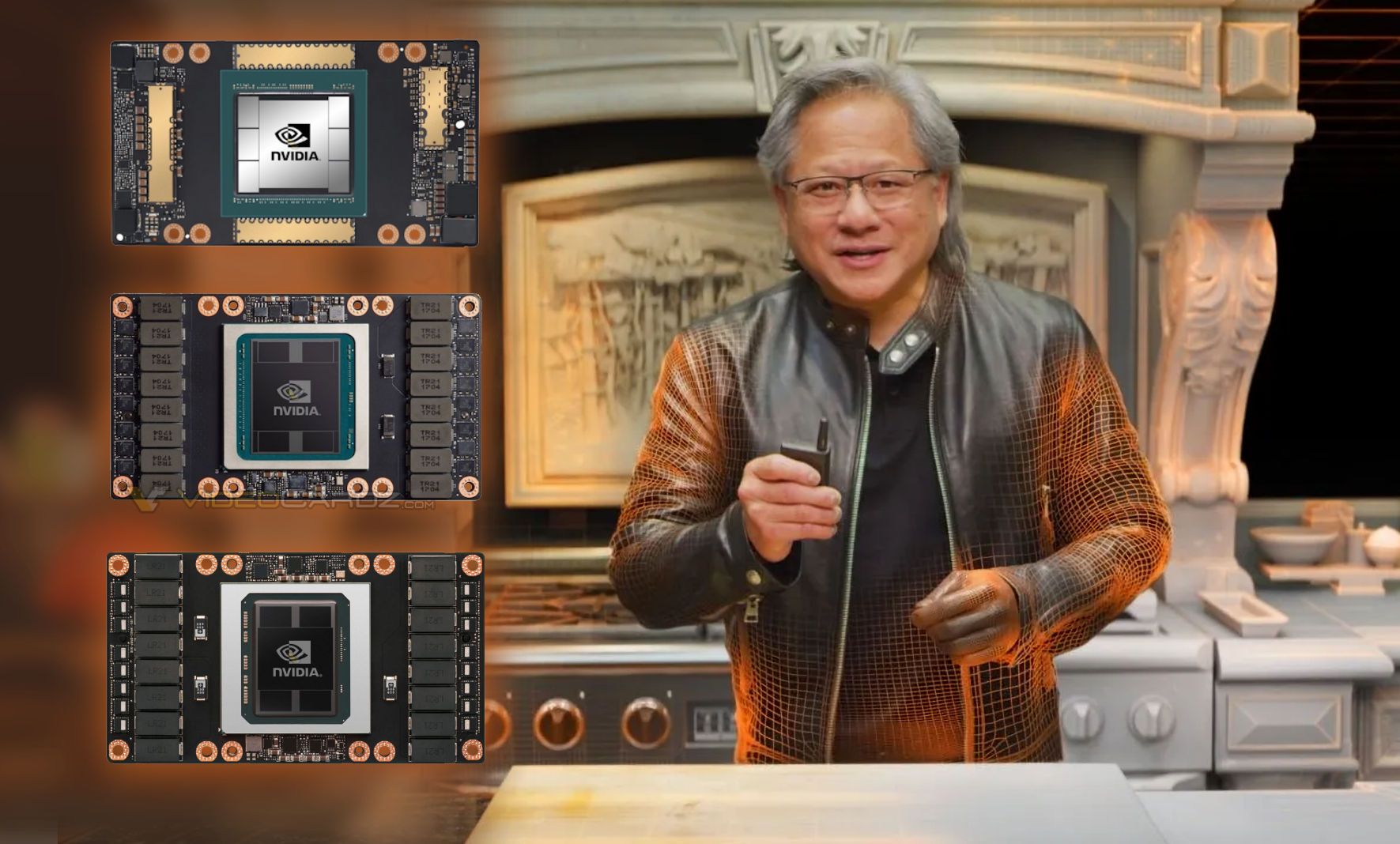

Olikos huomenna Jenssenin GTC keynote jossa ehkä nähdään jo ammattikäyttöön se uusi sukupolvi?

EDIT: Heti guugle tarjosikin premiereä. Pitääpä katsoa tuleeko tässä mitään mielenkiintoista.

EDIT: Heti guugle tarjosikin premiereä. Pitääpä katsoa tuleeko tässä mitään mielenkiintoista.

Viimeksi muokattu:

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 257

Olikos huomenna Jenssenin GTC keynote jossa ehkä nähdään jo ammattikäyttöön se uusi sukupolvi?

EDIT: Heti guugle tarjosikin premiereä. Pitääpä katsoa tuleeko tässä mitään mielenkiintoista.

Kai se hopper tulee perustuen nvidian blogi-kiusoitteluun

NVIDIA 'hopped up' for GTC 2022, the company set to announce Hopper GPU architecture next week - VideoCardz.com

NVIDIA teases Hopper architecture announcement at GTC 2022 Jensen Huang, the CEO of NVIDIA, will host a keynote on March 22nd. GTC 2022 teaser, Source: NVIDIA The Hopper graphics architecture is more than likely to be announced next week during NVIDIA CEO keynote. This has been long awaited and...

- Liittynyt

- 21.02.2017

- Viestejä

- 5 391

H100 TSMC 4nm prosessi, HBM3 muistit ja 700W TDP

videocardz.com

videocardz.com

Keynote klo 17.00 btw

NVIDIA H100 GPU features TSMC N4 process, HBM3 memory, PCIe Gen5, 700W TDP - VideoCardz.com

NVIDIA H100 Specs Some details on NVIDIA’s next-gen AI accelerator have leaked just an hour ahead of the announcement. Contrary to the rumors that NVIDIA H100 based on Hopper architecture will be using TSMC N5, NVIDIA today announced that its latest accelerator will be using a custom TSMC N4...

Keynote klo 17.00 btw

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 5 703

Lupailevat 60TFLOP FP32 hopperilla siinä missä Amprerella päästiin 20TFLOPS. Saapa nähdä miten peilaantuu pelikortteihin.

- Liittynyt

- 16.10.2016

- Viestejä

- 3 180

Lupailevat 60TFLOP FP32 hopperilla siinä missä Amprerella päästiin 20TFLOPS. Saapa nähdä miten peilaantuu pelikortteihin.

PCIe versio on 48TFLOP ja 350W

Hyvä kommentti.Top end näyttiksillä on aina ollut sama idea:

Pelit saa näyttämään hieman paremmilta ja / tai saa enemmän FPS:ää..

Ei tässä ole kertakaikkisen yhtään mitään uutta. Näin on ollut aina uusien näyttisten julkaisun aikoihin.

Hyväpuolikin asiassa on: Ei ole yhtään mikään pakko ostaa niitä top-end näyttiksiä, jos "se tuntuu aasilta". Voi ostaa vaikka low end näyttiksen ja pistää pelin asetukset ja reson pienemmälle. Itse pelistä se ei jätä ulkoasun lisäksi mitään pois.

Hyvin monet tosin haluavat esim FPS !!!!!MAX MAX MAX MAX!!!!!! tai mahdollisimman hyvännäköisen lopputuloksen (= nopea säteenseuranta on täysin pakollinen), jolloin sen top-end näyttiksen ostaminen on avain tyytyväisyyteen.

Pitkälti samaa mieltä.

Jotenkin pelisuunnittelu muotoutuu aina uuden konsolisukupolven tullessa vielä pari vuotta last-gen -konsoleiden tehoihin. Tällä omalla raudalla saa varmasti pelata sen 6 vuotta hyvin rauhassa.

Ymmärrän liian hyvin harrastusvälineiden merkityksen ja hifistelyn. Ymmärrän myös sen yli menevän. Että tietyn ekstran jälkeen rahalla saa kovin merkityksettömiä etuja.

Raudan kanssa ruuvaaminen oli hauskaa 1,5 v ja se tuli nähtyä tässä vaiheessa. En vaihtaisi pois. Tällä foorumilla on saanut täydentävää vinkkiä, vaikka olen ns. itseoppinut.

Next-gen GPU-hypen aaltojen iskiessä, kehotan laittamaan jäitä hattuun (erityisesti niille, jotka ovat innolla myymässä Ampere-sarjan näyttiksiään). Pörssiyhtiöiden tehtävä on tehdä rahaa. Ylimenevä hype on markkinointia, ja luvatut tehot eivät pitäneet paikkaansa Amperessa. Saatavuudesta puhumattakaan, tai hintatasosta.

Eli jos on näyttis, jonka kanssa voi elää, älä myy, vaikka nahkatakkimies lupaisi 300% tehot ja Nigeriasta kultaa lento-onnettomuudessa kuolleelta sedältä.

Hypejunassa on hauskaa, mutta on hyvä olla varovainen ja pelata omien pelimerkkien mukaan. Ei muuta tällä kertaa.

- Liittynyt

- 18.12.2020

- Viestejä

- 307

Lämmöntuotto alkaa olemaan iso ongelma, kun mennään 500 wattiin ja yli. Huhujen perusteella next-genissä ihan mahdollista. 3090 Ti tekee sitä jo nyt. Siksi olisi kiva, jos sais ajureihin sellaisen option, jossa on 2 eri power limittiä ja korkeampi kytkeytyisi päälle, jos peli dippaa jonkun FPS lukeman alle. FPS lukko ajaa vähän samaa asiaa, mutta eri power limiteillä voisi nauttia kovemmista ruudunpäivitysnopeuksista siten, ettei huone muutu saunaksi parin tunnin pelailun jälkeen. Laittaa vaikka alemman power limitin 350W ja sitten kun dippaa FPS alle 60 otetaan vasta kaikki mehut irti.

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 283

Luulisi että herran vuonna 2022 alkaisi maailmaa kiinnostamaan myös näyttisten kulutus, nyt kun hehkulamputkin on saatu vaihdettua pois. Viiden sadan watin näyttiksen kulutuksella saisi pitää aika montaa hehkulamppua päällä...

Itse jätän kauppaan kaikki joita ei saa helposti alle 300 W (mielummin 250 W) ilman merkittävää suorituskyvyn tippumista. Toisaalta, jos sieltä tulee selvästi 3080:stä tehokkaampi kortti joka kuluttaa alle 250 W, maksan siitä mielelläni vaikka tonnin.

Itse jätän kauppaan kaikki joita ei saa helposti alle 300 W (mielummin 250 W) ilman merkittävää suorituskyvyn tippumista. Toisaalta, jos sieltä tulee selvästi 3080:stä tehokkaampi kortti joka kuluttaa alle 250 W, maksan siitä mielelläni vaikka tonnin.

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 5 703

Kyllähän tehonkulutus testit on lähes jokaisessa näytönohjainvertailussa esillä.Onkos kukaan koskaan laskenut/mitannut kuinka paljon intensiivinen pelaaminen kuluttaa sähköä jos omistaa juuri tuollaisen virtasyöpän näytönohjaimen?

Se myös riippuu piirin luonteesta ja siitä miten PL on tehtaalla asetettu.Onkos kukaan koskaan laskenut/mitannut kuinka paljon intensiivinen pelaaminen kuluttaa sähköä jos omistaa juuri tuollaisen virtasyöpän näytönohjaimen?

Luullakseni esim. 6900XT hakkaa PL vasten vakiona aika aktiiviseti. Itselläni on 6900XTX ja asetettu 400W PL ei koskaan täyty. Parhaillaan pelatessa kuorma 1440p olen saanut 340W luokkaa. Jossain menuvalikossa ilman FPS limittiä on saattanut käydä 350W.

Eli tuo huhuttu 600W voi olla joko rajoittava tekijä tai sitten ei.

Clarenz

Tukijäsen

- Liittynyt

- 17.10.2016

- Viestejä

- 1 800

Tähän nyt moni jo vastasikin, mutta en ainakaan itse aio palata enää isoihin tuhnupönttöihin, vaan max 15 litrasella (nyt alle 10 litrasella) kotelolla pitää pärjätä. Aivan mainiosti jäähtyy vielä 6800 XT, mutta kyllä jos tuon päälle vielä 100-150w lyödään alkaa tekemään tiukkaa. Lisäksi kesäkeleillä ja talvellakin pidemmissä sessioissa alkaa kyllä huonekin lämpenemään jos jatkuvasti nousee virrankulutus. Esimerkiksi tuo huhuttu 600w xx90 näyttiksellä.Ihan oikeastikko joku miettii näytönohjaimen sähkönkulutusta kun kortista on maksanut vaikkapa 1500-2500€?

Ihan oikeasti kyselen, mietityttänyt useasti kun pc-tavaroiden tehonkulutuksia listaillaan. Ymmärrän että jäähdytystehoa joutuu miettimään, mutta että sähkönkulutusta.

Monella on 6-10 kW kiukaitakin jotka lämpenee lähes joka päivä, puhumattakaan okt:n lämmityksestä.

Kaipaan aikoja, kun samalla tai jopa matalammalla virrankäytöllä saatiin reilusti tehoa lisää. Viimeisessä kahdessa sukupolvessa tehonlisäys tullut suurimmilta osin nousseen virrankulutuksen avulla. Eikä huhut näistä uusista varsinaisesti rohkaise odottamaan muuta seuraavistakaan.

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 5 703

4070 kortissa samaa tasoa tehonkulutus mitä 3090 kortissa?

Voi pojat.

- Liittynyt

- 20.10.2016

- Viestejä

- 3 658

4070 kortissa samaa tasoa tehonkulutus mitä 3090 kortissa?

Voi pojat.

Huhujahan ne vielä on, mutta piirikoot kasvaa takuuvarmasti. Ei ne transistorit ilmaiseksi töitä tee, kellojakin viilataan taatusti sen verran mitä uusi prosessi antaa helposti myöten (eli pidetään hyvät saannit, mutta kulutus nousee).

Edit: Vähän huono muotoilu. Mutta ajatus oli, että vaikka prosessi paranee, niin niin sen hyödyt käytetään taatusti siihen, että kello/volttikäyrä vedetään sopivaksi, jotta saannit on hyvät. Uuden prosessin perffihyödyt menee siis isompiin piireihin ja kelloihin, eikä tippuneeseen kokonaiskulutukseen.

Koska on syytä odottaa, että tulee 4070, <4070Ti, <4080, <4080Ti, <4090, <4090Ti virrankulutukseltaan, joten on sitten monella aika vaihtaa isompi poweri..4070 kortissa samaa tasoa tehonkulutus mitä 3090 kortissa?

Voi pojat.

Olennaista on vastaus kysymykseen: Saadaanko minkäverran suorituskykyä lisää /W? vai onko niin, että nyt on tullut perinteisen piivalmistustekniikan rajat vastaan kyseisellä alueella ja lisäsuorituskyky ssaadaan optimoimalla rautaa ja ohjelmia, eikä lisätransistoreilla..

Tosin tuo on todentamaton huhu, ei tieto, joten käytännössä merkityksetöntä.

- Liittynyt

- 20.10.2016

- Viestejä

- 3 658

Tässä vanha vertailutaulukko, jossa on laskettu kuluja tällä piirillä:

" The model is based on an imaginary 5nm chip the size of Nvidia's P100 GPU (610 mm2, 90.7 billion transistors at 148.2 MTr/mm2). "

Oleellisinta tuossa on, että 7nm asti iso piirin valmistuskustannukset laski, nyt alkaa taas nousu. Uudet piirit nostaa transistorimäärää, joten ne on kalliimpia valmistaa uudesta prosessista huolimata. Joten odottaisin, että syksyllä ei tapahdu isoa €/fps hyppäystä, tehoissa noustaan kummasti, mutta lippulaivapiirit maksaa sen mitä Amperet piiripulan aikana trokarilta ostettuna ihan kaupan normihintoina.

" The model is based on an imaginary 5nm chip the size of Nvidia's P100 GPU (610 mm2, 90.7 billion transistors at 148.2 MTr/mm2). "

Oleellisinta tuossa on, että 7nm asti iso piirin valmistuskustannukset laski, nyt alkaa taas nousu. Uudet piirit nostaa transistorimäärää, joten ne on kalliimpia valmistaa uudesta prosessista huolimata. Joten odottaisin, että syksyllä ei tapahdu isoa €/fps hyppäystä, tehoissa noustaan kummasti, mutta lippulaivapiirit maksaa sen mitä Amperet piiripulan aikana trokarilta ostettuna ihan kaupan normihintoina.

Tänään mietin viisi sekuntia ostaisinko 3080ti:n hintaan 1259€.

En ostanut.

Todella huono ajallinen hinta-suorituskyky.

Itse pelaan tasan tarkkaan 4k resolla, ja Ampere oli hyvä askel omaan suuntaan. Odotan kuitenkin Linda Lovelacea kovasti ja syvästi.

En ostanut.

Todella huono ajallinen hinta-suorituskyky.

Itse pelaan tasan tarkkaan 4k resolla, ja Ampere oli hyvä askel omaan suuntaan. Odotan kuitenkin Linda Lovelacea kovasti ja syvästi.

- Liittynyt

- 24.06.2020

- Viestejä

- 1 229

Olikos huomenna Jenssenin GTC keynote jossa ehkä nähdään jo ammattikäyttöön se uusi sukupolvi?

EDIT: Heti guugle tarjosikin premiereä. Pitääpä katsoa tuleeko tässä mitään mielenkiintoista.

Aloin katsomaan tuota Nvidian kanavalta. Kuva näytti suttuiselta ja sitten tajusin, että hemmetti sehän on max 1080p resoluutiolla :-D Luulisi, että graffufirma voisi laittaa tuollaiset videot kanssa vähän paremmilla resoilla Youtubeen.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 257

Seuraavan sukupolven huhutusta virrankulutuksesta tulee elävästi mieleen 1080ti/pascal vs. vega aika. Mä oletan, että kilpailu tulee olemaan niin kovaa, että ainakin halo-piirit tykitetään maksimikelloille jo tehtaalla. Mikään ole niin tärkeää kuin benchmark voitot? Onneksi virrankulutus/lämpö skaalaa exponentiaalisesti. Alikellottamalla tuskin menettää paljoa suorituskykyä. Alikellottamalla saa virrankulutuksen/lämmöt alaspäin takaisin järkevälle tasolle. Jos tää menee näin niin syksyn isoin itku on, että kortit ei ylikellotu, kun ne on kellotettu jo maksimiin tehtaalla

Viimeksi muokattu:

Amperessa oli vähän jo samaa vikaa. Virtaa piti syöttää aika huolella, että benchmarkit nousivat. Tässä genissä alivoltitus oli pop, mikä on aika meh.Seuraavan sukupolven huhutusta virrankulutuksesta tulee elävästi mieleen 1080ti/pascal vs. vega aika. Mä oletan, että kilpailu tulee olemaan niin kovaa, että ainakin halo-piirit tykitetään maksimikelloille jo tehtaalla. Mikään ole niin tärkeää kuin benchmark voitot? Onneksi virrankulutus/lämpö skaalaa exponentiaalisesti. Alikellottamalla tuskin menettää paljoa suorituskykyä. Alikellottamalla saa virrankulutuksen/lämmöt alaspäin takaisin järkevälle tasolle. Jos tää menee näin niin syksyn isoin itku on, että kortit ei ylikellotu, kun ne on kellotettu jo maksimiin tehtaalla

Ja rautahorona odotan innolla uutta, mutta en hypejunassa. Hyvä ilmiö on 4k-pelaamisen kehittyminen. Pelaan PC:llä TV-ruudulla, ja sujuva 4k on perusvaatimus.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 257

Mooren laki ei tunnu riittävän niin suorituskyky otetaan brute forcella. Ainoa joka tuntuu wattipelissä pärjäävän on apple. Toisaalta applella ei varsinaisesti ole kilpailijaa niin m1 pohjaiset laitteet on voitu kellottaa virrankulutuksen kannalta optimaalisesti.Amperessa oli vähän jo samaa vikaa.

- Liittynyt

- 20.10.2016

- Viestejä

- 3 658

Mooren laki ei tunnu riittävän niin suorituskyky otetaan brute forcella. Ainoa joka tuntuu wattipelissä pärjäävän on apple. Toisaalta applella ei varsinaisesti ole kilpailijaa niin m1 pohjaiset laitteet on voitu kellottaa virrankulutuksen kannalta optimaalisesti.

Ei mooren laki ole mihinkään muuttunut, brute forcea se on ollut ennenkin. Se mikä uhkaa muuttua omasta mielestä on teho/€ kehitys, kun uusi prosessi ei olekkaan automaattisesti halvempi.

Kellot nousi oikeastaan vain pascaliin asti. GPU:t skaalatuu hyvin, joten yksiköiden lisääminen ja cachen kasvattaminen on oikeasti tehokas tapa lisätä vääntöä. Sitähän nuo prosessipäivitykset ovat mahdollistaneet, samalla rahalla on saatu enemmän transitoreja ulos ja ne on käytetty hyväksi.

Esim nykyisissä huhuissa taitaa olla 80% lisää coreja. Sillä se voima tulee, se kello tai ipc boosti on näpertelyä tuonkaltaisiin lisäyksiin verrattuna.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 391

Kesällä Kopite7kimin mukaan olis tulossa uusi sukupolvi:

- Liittynyt

- 19.10.2016

- Viestejä

- 887

Huh, aika kova väite. Omiin suunnitelmiin ei kyllä ole kuulunut päivittää kuin aikaisintaan loppuvuodesta, mutta ainahan sitä on oltava valmis joustamaan raudan kanssa...

En viitsi uskoa että sieltä tulee mitään konkreettista infoa vielä Computexin aikaan, mutta toisaalta Gamescom onkin sitten jo elokuussa.

En viitsi uskoa että sieltä tulee mitään konkreettista infoa vielä Computexin aikaan, mutta toisaalta Gamescom onkin sitten jo elokuussa.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 391

Juu tuskin Computexissa, kun ei ole Jensen lavalla. Eikä taida olla Nvidialla tapana antaa edes sneak peekkejä kuten esim. AMD tekee aina välillä.En viitsi uskoa että sieltä tulee mitään konkreettista infoa vielä Computexin aikaan, mutta toisaalta Gamescom onkin sitten jo elokuussa.

- Liittynyt

- 13.12.2016

- Viestejä

- 4 881

"Helposti" pitäis irrota 2x perffi Ämpäriin verrattuna.

- Liittynyt

- 03.01.2017

- Viestejä

- 285

Nvidialla saattaa olla pelko siitä että mainaajat ovat dumppaamassa markkinoille laivalasteittain käytettyjä Ampereja. Kun paperijulkaistaan uusi mallisto suurilla lupauksilla niin jengi jää mielummin odottelemaan niitä kuin ostaa vanhoja käytettynä.Mitä nuo muuten hyötyvät noista julkaisuista jonkun kissanristiäisen yhteydessä?

Pistäisivät vain myyntiin ja halukkaille kolmansille osapuolille muutamia kymmeniä testeihin. Jos tuote on hyvä, niin porukka kyllä ostaa sitä..

Jos verkkis yhyttyy lähettämään 1,5v myöhässä olevan näyttiksen (Rtx 3080) vrk sisään ilman tilaajan hyväksyntää mallin vaihdosta, täytyy tilanteen olla aika relevantti ja next-gen lähellä.Huh, aika kova väite. Omiin suunnitelmiin ei kyllä ole kuulunut päivittää kuin aikaisintaan loppuvuodesta, mutta ainahan sitä on oltava valmis joustamaan raudan kanssa...

En viitsi uskoa että sieltä tulee mitään konkreettista infoa vielä Computexin aikaan, mutta toisaalta Gamescom onkin sitten jo elokuussa.

Sanoisin että next-gen tarjoaa hyvää sekä RT-pelaamiseen että 4k pelaajille. Pelisuunnittelu on pitkälti liitetty konsoleihin, jotka ovat kaikesta huolimatta aika tehottomia (vrt. high-end PC:t). Mitä suorituskyky tarjoaa pelisuunnittelun puitteissa - reso, RT ja FPS. Ei huono, mutta ei mullistavaa.

Uutiset

-

Lenovon erikoiset CES-uutuuskannettavat vuotivat julki ennakkoon

20.12.2024 15:23

-

Joulun 2024 piparkakkutalokilpailu on käynnistynyt TechBBS-foorumilla!

20.12.2024 14:42

-

Lenovo valmistelee SteamOS:llä varustettuja käsikonsoliluokan Legion Go -tietokoneita

20.12.2024 14:05

-

Live: io-techin Tekniikkapodcast (51/2024)

20.12.2024 13:50

-

Asus julkisti uuden NUC 14 Pro AI -minitietokoneensa

20.12.2024 11:56

Uutisia lyhyesti

-

Taittuvanäyttöinen OnePlus Open 2 saatetaan nähdä vasta odotettua myöhemmin

- Juha Kokkonen

- Vastauksia: 0

-

Sony on saavuttanut 20 miljardin toimitetun kamerasensorin rajapyykin

- Kaotik

- Vastauksia: 4

-

-

-