-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA GeForce RTX 3080 / 3080 Ti / 3090 -ketju (GA102)

- Keskustelun aloittaja Kaotik

- Aloitettu

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Olisko jollain jakaa jotain f5 scriptiä tuolla nvidian sivulle, joka ilmottaa jos on tullutki sivulle saldoa?

Visualping: #1 Website change detection, monitoring and alerts

Monitor any website for changes with Visualping. Get instant alerts via email, SMS, API or Slack when a web page changes. Try it free today!

visualping.io

Toimiskos?

- Liittynyt

- 06.09.2017

- Viestejä

- 1 618

uskoisin että tuo toimisi, MUTTA:

Visualping: #1 Website change detection, monitoring and alerts

Monitor any website for changes with Visualping. Get instant alerts via email, SMS, API or Slack when a web page changes. Try it free today!visualping.io

Toimiskos?

"5, 15 and 30 min checks are only available to paying plans "

Älä turhaan vaivaidu, botit ostaa kortit pois sekunneissa, minuuttien reagointiajalla ei mitään toivoa.uskoisin että tuo toimisi, MUTTA:

"5, 15 and 30 min checks are only available to paying plans "

- Liittynyt

- 17.10.2016

- Viestejä

- 4 970

En tiiä miten ne nvidian fiksit sinne storen puolelle sit loppujenlopuks vaikutti. Tuskin kauheasti, sillä 3090 foundersia ei tainnu kovinkaan moni saada ostettua. Eli mahikset aika ohuet siihen et sellasen kortin sieltä saa, porukalla on kuitenkin vähintään vahdit siellä venaamassa jotka pingaa sit heti kun tulee saataville.

Mut rehellisesti sanottuna nykyhetkellä ei kannata muuta oikeastaan edes tilaukseen laittaakkaan jos tälle vuodelle kortin haluaa. Tai no, kai tän konkkagaten jälkeen niitä muutamaa valittua mallia voi pistää tilaten.

Mut rehellisesti sanottuna nykyhetkellä ei kannata muuta oikeastaan edes tilaukseen laittaakkaan jos tälle vuodelle kortin haluaa. Tai no, kai tän konkkagaten jälkeen niitä muutamaa valittua mallia voi pistää tilaten.

- Liittynyt

- 19.10.2016

- Viestejä

- 1 512

MSI on kaikessa hiljaisuudessa vaihtanut tuotekuvat konkkien osalta Gaming X Triosta ja Ventuksesta.

videocardz.com

videocardz.com

Myös asus on vaihtanut tuotekuvia konkkien osalta

videocardz.com

videocardz.com

MSI quietly changes GeForce RTX 3080 GAMING X TRIO design amid stability concerns - VideoCardz.com

MSI became aware of reports from customers, reviewers, and system integrators that there may be instability when GeForce RTX 30 Series graphics cards core clocks exceeded a certain amount. The latest GeForce driver (456.55) includes fixes for the issue. As such, MSI recommends owners of GeForce...

Myös asus on vaihtanut tuotekuvia konkkien osalta

ASUS also caught modifying GeForce RTX 3080 TUF and ROG STRIX PCB designs - VideoCardz.com

ASUS released a statement on Instagram: All retail ROG Strix and TUF Gaming GeForce RTX 3080 and 3090 graphics cards use only MLCC capacitors for decoupling close to the GPU. During development, we discovered the improvement this makes to RTX 3090 and 3080 overclocking headroom, so we made...

- Liittynyt

- 17.10.2016

- Viestejä

- 4 970

Tuskin. 3080 tilanneet on vaan kerinny jo unohtamaan asian tässä vähän alle kahden viikon aikana, tai sitten ovat jo saaneet korttinsa. 3090 tilanneet on vielä kriisitilassa saatavuuden suhteen, mutta kyllä se todellisuus kohta valkenee ja hiljasempi odottelu alkaa.Kuvittelenko vai onko tällä foorumilla enemmän 3090 tilanneita kuin 3080 tilanneita?

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Curvet vaihtelee lämpöjen mukaan. Ehkäpä katsot kahta käyrää eri lämmöiltä?En tiiä kuinka hyvin tosta näkee mutta itellä hävisi viimeine pykälä pois tosta curvelta kun päivitin ajurit, max voltage nyt n 1.080v ja ennen oli 1.120v:

Itellä on pysynyt curvet samana ajuripäivityksen jälkeen ja boostaa edelleen 2055MHz BFV menussa (kylmällä kortilla).

Postasin aiemmin ketjuun curven jossa oli 2085MHz max ja luulin sen olevan kylmimmästä tilasta. Tämä vielä kylmemmiltä lämmöiltä (28C, kone juuri käynnistetty, sama käyrä nähty sekä ennen että jälkeen ajuripäivityksen):

PS. tais olla tosiaan aika rapeat ylikellot se sinun 1905MHz @900mV, ei ihme että kaatuili

PPS. Käyrät ei vaihtele tasan tarkkaan core lämmön mukaan, saatan nähdä kaksi eri käyrää @30C riippuen siitä onko kone juuri käynnistetty ja tultu 24C->30C vai ollaanko käytetty korttia ja tultu 72C->30C. Näissähän on ties mitä lämpösensoreita joita käyttäjä ei näe ja vakio tuuletinkäyräkään ei noudata yksinomaan käyttäjälle näkyvää core lämpöä ainakaan FE:llä.

Viimeksi muokattu:

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Oliko se sinun omaa informaatiota jostain ja kirjoitit sen ketjuihin? Ja nuo muut sivstot ei olekaan olleet tietoisia?

En löytänyt sitä aiempaa mistä tämä tuli.

edit joo ei. Joku muu posti se oli tässä ketjussa.

Mulla on suorat kontaktit valmistajiin kuten myös Nvidialle ja AMD:lle, niin PR-puolelle kuin joissain tapauksissa insinööritasolle. Pyrin omissa kirjoituksissa pohjautumaan mahdollisimman pitkälle omiin testeihin ja ensikäden tietoihin suoraan valmistajilta enkä muiden sivustojen kirjoituksiin, spekulointeihin tai muuten vaan mutuun. Jotkut keskustelut käydään luottamuksella, jotkin asiat ovat konkreettisesti salassapitosopimuksen alaisia, mutta auttavat ymmärtämään kokonaistilannetta.

Sama kotelo, MSI Ventus sujahti sisään ongelmitta. Näkösuoja on mulla paikoillaan.Mitenhän tuo gigabyten 3080 gaming oc tulee mahtumaan tähän fractalin define r6 koteloon jos toiveena on pitää kovalevyjen kotelo/näkösuoja paikoillaan?

Liekkö toivoakaan kun tähän toiseen koneeseen olisi sitten tulossa 3090 strixi, vai pitääkö tuosta pellin palasta nyt luopua näyttiksen takia.

- Liittynyt

- 24.06.2019

- Viestejä

- 524

Mittanauha tai viivotin käteen ja mittaamaan. Turha niitä on pähkäillä, mitat korteista kun tuppaa löytymään googlella

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Kiitos, 50A jatkuvalle virralle näköjään luokiteltu molemmissa Gigabyten 3080 ja 3090 Gaming OC:ssa mosfetit. Päivitetty artikkeliin.

MSI on kaikessa hiljaisuudessa vaihtanut tuotekuvat konkkien osalta Gaming X Triosta ja Ventuksesta.

MSI quietly changes GeForce RTX 3080 GAMING X TRIO design amid stability concerns - VideoCardz.com

MSI became aware of reports from customers, reviewers, and system integrators that there may be instability when GeForce RTX 30 Series graphics cards core clocks exceeded a certain amount. The latest GeForce driver (456.55) includes fixes for the issue. As such, MSI recommends owners of GeForce...videocardz.com

MSI oli kyllä tehnyt tuon jo aikoja sitten, kaikki tuotannosta tulleet Ventukset ovat tuolla "uudemmalla" designilla. Sinänsä siis kuvien vaihtaminen on ihan ymmärrettävää. Joku idea siellä toki on ollut kun ovat vaihtaneet speksiä aika loppuvaiheessa.

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Noniin, testailin tänään Gigabyten GeForce RTX 3080 Gaming OC:lla, joka meidän testeissä toimi korkeimmalla kellotaajuudella, miten resoluutio vaikuttaa Boost-kellotaajuuteen ja onhan siinä tolkuton ero 4k:n 1935-1950 MHz vs 1080p 2040-2055 MHz.

Johtuu osittain siitä, että Battlefied V:n pelimoottorissa 200 FPS:n rajoitin ja 3080 on niin suorituskykyinen, että GPU:n käyttöaste jää alhaiseksi -> Boost-algoritmi nostaa kellot maksimiin, mutta samaa saattaa toki esiintyä muissakin peleissä, joten tämä on hyvä esimerkki käytöksestä.

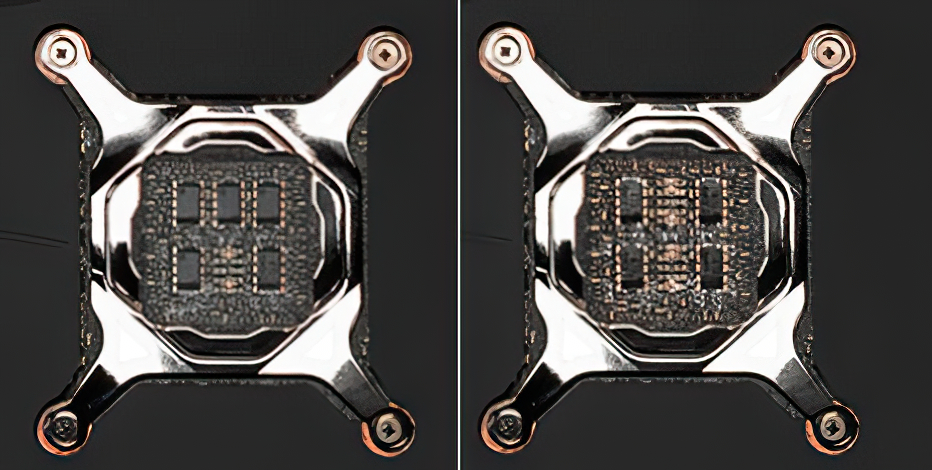

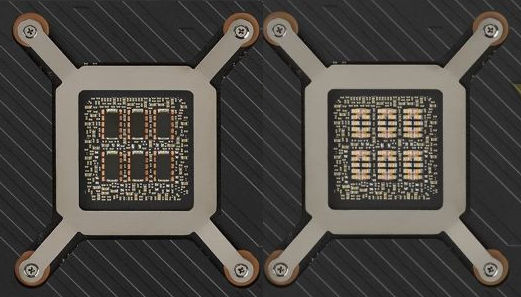

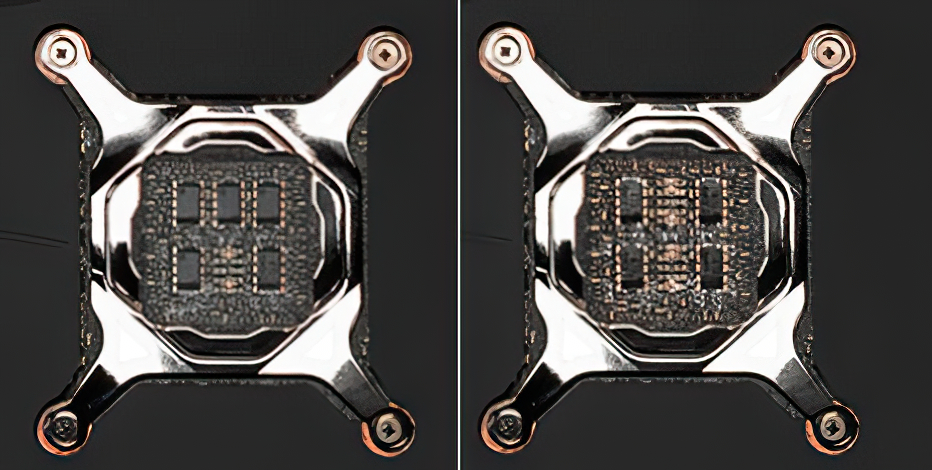

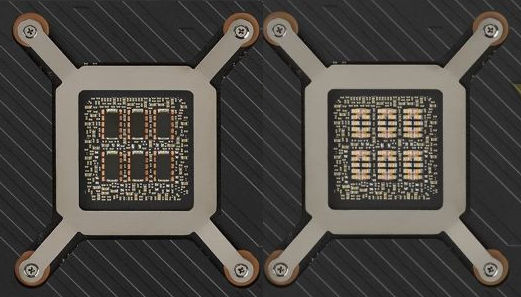

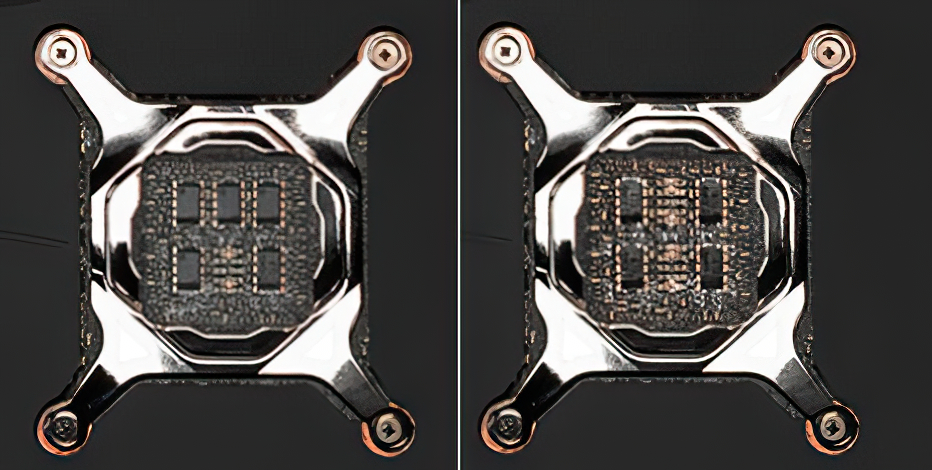

Lisäksi tähän konkkagateen liittyen olen saanut selviteltyä, että kyse on tosiaankin siitä, että grafiikkapiirin takapuolen kondensaattorit suodattavat sisääntulojännitettä ja joista grafiikkapiiri ottaa tarvitsemansa kuormavirran. Korkeilla kellotaajuuksilla pelkät SP-Capsit eivät ilmeisesti kykene riittävän nopeasti reagoimaan kuormavirran muutoksiin, kun taas pienemmät MLCC-konkat kykenevät. Ei ole kyse niinkään, että toiset olisi laadukkaampia tai kalliimpia, vaan sopivat tähän kyseiseen hommaan paremmin.

Ilmeisesti tuo Asuksen kaikki MLCC konkkia on overkill ja ongelma ratkeaa jo että ihan 1-2 konkista on toteuttu niillä. Osa valmistajista oli havainnut ongelmat aiemmin (Asus), osa selkeästi myöhemmin (EVGA).

MSI ja Gigabyte ovat käyttäneet sitten taas referenssisuunnitteluun ja esim. Zotac Trinityyn verrattuna isompia SP-Capseja (470 vs 220 uF), Gigabytessä kaikki kuusi ovat näitä, MSI:n 3080 Gaming X Triossa on 1 x MLCC + 5 x SP-Caps ja 3090:ssä 2 x MLCC + 4 x SP-Caps.

Uusi 456.55-ajuri säätää tosiaan Frequency/Voltage-käyrää. Yläpäästä 2055 MHz:n enemmän käyttöjännitettä kellotaajuutta kohti, käyrä saattaa olla muuttunut 5 pykälää. 1950 MHz:n tienoilla taas käyttöjännitettä 1 pykälä vähemmän :

Vanha ajuri 456.38 (2055 MHz / 1,031V)

Uusi ajuri 456.55 (2055 MHz / 1,062V)

Vanha ajuri 456.38 (1935 MHz / 0,962V)

Uusi ajuri 456.55 (1935 MHz / 0,956V)

Uusi ajuri 456.55 (2055 MHz / 1,062V)

Vanha ajuri 456.38 (1935 MHz / 0,962V)

Uusi ajuri 456.55 (1935 MHz / 0,956V)

Käytännössä nyt Battlefield V:ssä 1080p-resoluutiolla GPU-kellotaajuus boostasi edelleen 2040 MHz, mutta käyttöjännite oli korkeampi 1,062 -> 1,081V.

1440p-resoluutiolla GPU-kellotaajuus boostasi edelleen 1995 MHz, mutta käyttöjännite oli alhaisempi 1,062 -> 1,037V.

4k-resoluutiolla GPU-kellotaajuus boostasi edelleen 1935 MHz, mutta käyttöjännite oli alhaisempi 0,981 -> 0,.962V.

Suorituskykyyn ei siis mitään vaikutusta, enemmänkin hienosäätöä grafiikkapiirin kellotaajuuteen/käyttöjännitteen käyttäytymiseen eri taajuusalueilla.

Viimeksi muokattu:

- Liittynyt

- 17.10.2016

- Viestejä

- 4 970

Oliko kumpi BIOS käytössä näissä vedoissa?Suorituskykyyn ei siis mitään vaikutusta, enemmänkin hienosäätöä grafiikkapiirin kellotaajuuteen/käyttöjännitteen käyttäytymiseen eri taajuusalueilla.

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Oliko kumpi BIOS käytössä näissä vedoissa?

Vakio eli OC Mode.

- Liittynyt

- 03.06.2017

- Viestejä

- 70

Kiitoksia, nuo kortit mitä itse tilasin näyttää googlen mukaan vähän pidemmiltä, mutta sen kai näkee vasta sitten kun joskus kortin saa.Sama kotelo, MSI Ventus sujahti sisään ongelmitta. Näkösuoja on mulla paikoillaan.

Näin toimin, jää vain pääteltäväksi että millä etäisyydellä ne virtaliittimet on. Lisäksi mietityttää että lasketaanko pituus/leveys tietoihin myös se backplate.Mittanauha tai viivotin käteen ja mittaamaan. Turha niitä on pähkäillä, mitat korteista kun tuppaa löytymään googlella

- Liittynyt

- 17.10.2016

- Viestejä

- 4 970

Kulutus jää kuitenkin about 20w vajaaks siitä 370w TDP:stä 4K:lla ja 1440p:llä? Samaa vikaahan itelläkin oli et kulutus pyöri jossain 345-350w nurkilla peleissä ja GPU-Z sano perfcapiks pwr, mutta TDP:ks raportoi jotain 92% muistaakseni.Vakio eli OC Mode.

- Liittynyt

- 19.10.2016

- Viestejä

- 1 512

Olisikohan biossissa joku bitti vinossa että ei anna 370wKulutus jää kuitenkin about 20w vajaaks siitä 370w TDP:stä 4K:lla ja 1440p:llä? Samaa vikaahan itelläkin oli et kulutus pyöri jossain 345-350w nurkilla peleissä ja GPU-Z sano perfcapiks pwr, mutta TDP:ks raportoi jotain 92% muistaakseni.

Ot: Kokeilin B9S Far Cry 5 new dawn ja ai että kun näytti hyvältä

- Liittynyt

- 18.10.2016

- Viestejä

- 405

Nvidian puolelta kommentoitu nyt myös hyvin lyhyesti kondensaattoriasiaa ilmeisesti ensimmäisen kerran. Ei tietysti mitään yllättävää, virallisesti konkka-asetelmalla ei ole niinkään merkitystä vakauteen.

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Curvet vaihtelee lämpöjen mukaan. Ehkäpä katsot kahta käyrää eri lämmöiltä?

Itellä on pysynyt curvet samana ajuripäivityksen jälkeen ja boostaa edelleen 2055MHz BFV menussa (kylmällä kortilla).

Postasin aiemmin ketjuun curven jossa oli 2085MHz max ja luulin sen olevan kylmimmästä tilasta. Tämä vielä kylmemmiltä lämmöiltä (28C, kone juuri käynnistetty, sama käyrä nähty sekä ennen että jälkeen ajuripäivityksen):

PS. tais olla tosiaan aika rapeat ylikellot se sinun 1905MHz @900mV, ei ihme että kaatuili

PPS. Käyrät ei vaihtele tasan tarkkaan core lämmön mukaan, saatan nähdä kaksi eri käyrää @30C riippuen siitä onko kone juuri käynnistetty ja tultu 24C->30C vai ollaanko käytetty korttia ja tultu 72C->30C. Näissähän on ties mitä lämpösensoreita joita käyttäjä ei näe ja vakio tuuletinkäyräkään ei noudata yksinomaan käyttäjälle näkyvää core lämpöä ainakaan FE:llä.

Vai onko tuo puhdasta vaihtelua kuten Halpuuttajan tapauksessa?Uusi 456.55-ajuri säätää tosiaan Frequency/Voltage-käyrää. Yläpäästä 2055 MHz:n enemmän käyttöjännitettä kellotaajuutta kohti, käyrä saattaa olla muuttunut 5 pykälää. 1950 MHz:n tienoilla taas käyttöjännitettä 1 pykälä vähemmän :

Vanha ajuri 456.38 (2055 MHz / 1,031V)

Uusi ajuri 456.55 (2055 MHz / 1,062V)

Vanha ajuri 456.38 (1935 MHz / 0,962V)

Uusi ajuri 456.55 (1935 MHz / 0,956V)

Käytännössä nyt Battlefield V:ssä 1080p-resoluutiolla GPU-kellotaajuus boostasi edelleen 2040 MHz, mutta käyttöjännite oli korkeampi 1,062 -> 1,081V.

1440p-resoluutiolla GPU-kellotaajuus boostasi edelleen 1995 MHz, mutta käyttöjännite oli alhaisempi 1,062 -> 1,037V.

4k-resoluutiolla GPU-kellotaajuus boostasi edelleen 1935 MHz, mutta käyttöjännite oli alhaisempi 0,981 -> 0,.962V.

Suorituskykyyn ei siis mitään vaikutusta, enemmänkin hienosäätöä grafiikkapiirin kellotaajuuteen/käyttöjännitteen käyttäytymiseen eri taajuusalueilla.

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Mun täytyy kyllä sanoa etten tarkistanut tarkkoja jännitearvoja uusilla vs vanhoilla ajureilla. Eli siis maksimikellot käyrällä ja pikaisessa BFV testissä samat kuin ennenkin, mutta jännitteet voi olla muuttuneet.Vai onko tuo puhdasta vaihtelua kuten Halpuuttajan tapauksessa?

Pitääpä tarkistaa myöhemmin kun pystyn.

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Vai onko tuo puhdasta vaihtelua kuten Halpuuttajan tapauksessa?

Mitähän mahdat selittää, josko vaikka katsoisit käyriä joissa eri jännitearvot kellotaajuuksilla, ei kyse ole mistään vaihtelusta

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Lueppas ajatuksella tuo Halpuuttajan viesti jota lainasin, eli jännitekäyrät vaihtelisi lämpötilan mukaan. En tosin tuollaista ole huomannut 2xxx-sarjan kanssa.Mitähän mahdat selittää, josko vaikka katsoisit käyriä joissa eri jännitearvot kellotaajuuksilla, ei kyse ole mistään vaihtelusta

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Lueppas ajatuksella tuo Halpuuttajan viesti jota lainasin, eli jännitekäyrät vaihtelisi lämpötilan mukaan. En tosin tuollaista ole huomannut 2xxx-sarjan kanssa.

Kyllä mulla noissa testeissä on lämmötkin samat ja eri jännitteet, en ole huomannut että käyrät vaihtelisi lämmön mukaan

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Se siitä sitten. Halusin vain kyseenalaista kerran tuollaista väitettiin että muuttuisi lämpöjen mukaan.Kyllä mulla noissa testeissä on lämmötkin samat ja eri jännitteet, en ole huomannut että käyrät vaihtelisi lämmön mukaan

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Kyllä se afterburner erilaisia käyriä piirtelee lämpöjen mukaan. Katot sen käyrän kun kone käynnistetty ja viileä. Lämmität pelillä ja painat afterburnerista reset nappia ja avaat käyrän. Tällä näyttää 3080 FE:llä eri käyriä.

Tiedä sitten toimiiko muut kortit erilailla, mutta muistaakseni myös 2080:llä homma toimi näin.

Tiedä sitten toimiiko muut kortit erilailla, mutta muistaakseni myös 2080:llä homma toimi näin.

- Liittynyt

- 24.09.2020

- Viestejä

- 68

Jaksaisitko postaa ne käyrät niin voisi vähän vertailla että paljonko siinä sit on eroja loppujen lopuksi, luulis ainaki ettei siinä perus 40-70 astee akselilla kovin isoja eroja pitäis olla. Sit jos alkaa leikkii ln2 niin tiedän kyl että eroja muodostuu jo enemmän.Kyllä se afterburner erilaisia käyriä piirtelee lämpöjen mukaan. Katot sen käyrän kun kone käynnistetty ja viileä. Lämmität pelillä ja painat afterburnerista reset nappia ja avaat käyrän. Tällä näyttää 3080 FE:llä eri käyriä.

Tiedä sitten toimiiko muut kortit erilailla, mutta muistaakseni myös 2080:llä homma toimi näin.

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Lueppas ajatuksella tuo Halpuuttajan viesti jota lainasin, eli jännitekäyrät vaihtelisi lämpötilan mukaan. En tosin tuollaista ole huomannut 2xxx-sarjan kanssa.

Kyllä se afterburner erilaisia käyriä piirtelee lämpöjen mukaan. Katot sen käyrän kun kone käynnistetty ja viileä. Lämmität pelillä ja painat afterburnerista reset nappia ja avaat käyrän. Tällä näyttää 3080 FE:llä eri käyriä.

Tiedä sitten toimiiko muut kortit erilailla, mutta muistaakseni myös 2080:llä homma toimi näin.

Pahoittelut liian nopeasta ja kärkkäästä kommentoinnista, kyllä se käyrä itseasiassa hieman vaihtuu suhteessa lämpötilaan nyt kun testasin ensin laittamalla tuulettimen puhaltamaan 100% ja grafiikkapiirin lämpötila laski alle 30 asteeseen. Sen jälkeen rasitettuna 63-asteiseksi. Eroa on pari pykälää.

30 astetta:

63 astetta:

Noissa mun aiemmissa testeissä oli eri ajureiden välillä kuitenkin samat lämmöt ja GPU load ja testiympäristö

Rane

Coordinator @ Diablo 4 clan "iotech"

- Liittynyt

- 01.11.2016

- Viestejä

- 3 419

Siitä porvarikorttia:

videocardz.com

videocardz.com

Mitähän kaikkea tuohon flip-up -näytölle saa näkyviin?

EVGA flagship GeForce RTX 3090 KINGPIN HYBRID pictured in full - VideoCardz.com

EVGA RTX 3090 KINGPIN gets AIO cooling and a flip-up screen EVGA is upping its game with RTX 3090 KINGPIN HYBRID. We recently covered a new world record by Vince “K|NGP|N” Lucido, who broke a 2.58 GHz barrier with the EVGA graphics card based on NVIDIA Ampere architecture. Vince is an extreme...

Mitähän kaikkea tuohon flip-up -näytölle saa näkyviin?

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Eipä mitään, hyvä että Halpuuttajalla tuli havaittua tuollainen vaihtelu ja nostin esille, ei tuo tietenkään poista sitä etteikö uudet ajurit tuota myös muuttaisi vs. edelliseen. Onhan täälläkin jo raportoitu ongelmian poistumisesta uusien ajureiden myötä, joten jotain positiivista ne tekee ja todennäköisesti juuri tuota käyrää muuttamalla.Pahoittelut liian nopeasta ja kärkkäästä kommentoinnista, kyllä se käyrä itseasiassa hieman vaihtuu suhteessa lämpötilaan nyt kun testasin ensin laittamalla tuulettimen puhaltamaan 100% ja grafiikkapiirin lämpötila laski alle 30 asteeseen. Sen jälkeen rasitettuna 63-asteiseksi. Eroa on pari pykälää.

30 astetta:

63 astetta:

Noissa mun aiemmissa testeissä oli eri ajureiden välillä kuitenkin samat lämmöt ja GPU load ja testiympäristö

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

TUF OC jos löytyy malttia odotella korttia pitkään, tällä hetkellä ei oikein muita osaa suositella edes.Te aihetta tarkemmin seuranneet. Jos tuo ~20e ei haittaa, niin kummalla menisitte TUF tai TUF OC? Vai jokin muu malli?

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Eipä mitään, hyvä että Halpuuttajalla tuli havaittua tuollainen vaihtelu ja nostin esille, ei tuo tietenkään poista sitä etteikö uudet ajurit tuota myös muuttaisi vs. edelliseen. Onhan täälläkin jo raportoitu ongelmian poistumisesta uusien ajureiden myötä, joten jotain positiivista ne tekee ja todennäköisesti juuri tuota käyrää muuttamalla.

Vastaavia raportteja alkaa tulla myös muualta:

escalibur

"Random Tech Channel" @ YouTube

- Liittynyt

- 17.10.2016

- Viestejä

- 9 467

Edit: MSI julkais virallisen tiedotteen koskien asiaa. Propsit siitä.

Graphics card makers respond to RTX 30-series capacitor controversy (updated)

For those who don't know, we've seen numerous reports of factory overclocked aftermarket RTX 3080 and RTX 3090 cards suffering from crashes and stability issues when they...

Viimeksi muokattu:

- Liittynyt

- 15.03.2019

- Viestejä

- 891

MSI:n mukaan mitään konkkaongelmaa ei ikinä ollutkaan.

Graphics card makers respond to RTX 30-series capacitor controversy (updated)

For those who don't know, we've seen numerous reports of factory overclocked aftermarket RTX 3080 and RTX 3090 cards suffering from crashes and stability issues when they...www.techspot.com

MSIn Ventusissa on ollut alusta saakka 1+5 array eikä sitä ole "hiljaisuudessa vaihdettu" niikuin tuossa vihjataan.

Oma Ventus ei myöskään stockina kaatunut kertaakaan +2GHz kelloista huolimatta.

- Liittynyt

- 17.09.2020

- Viestejä

- 311

TUF OC jos löytyy malttia odotella korttia pitkään, tällä hetkellä ei oikein muita osaa suositella edes.

Eipä noilla TUF ja TUF OC taida olla eroa mitään muuta kuin biossiin laitettu eri kellot, itse tilasin normi TUF:in. Olisiko siellä sitten binnattu piirejä tästä +75Mhz ylikellotusta varten, siitä voisi ehkä toinen ero löytyä?

OC Mode - 1740 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1710 MHz , GPU Base Clock : 1440 MHz

vs.

OC Mode - 1815 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1785 MHz , GPU Base Clock : 1440 MHz

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Gigabyteltä lausunto aiheesta:

Statement Regarding the SP-CAP and MLCC Capacitor on GeForce RTX 3080 Graphics Cards

In response to the recent reports speculating that the use of POSCAP capacitors on the GeForce RTX 3080 graphics cards could lead to stability issues and crashes, we would like to clarify the issue with the following statement:

It is false that POSCAP capacitors independently could cause a hardware crash. Whether a graphics card is stable or not requires a comprehensive evaluation of the overall circuit and power delivery design, not just the difference in capacitor types. POSCAPs and MLCCs have different characteristics and uses, thus it is not true to assert that one capacitor type is better than the other.

The GIGABYTE GeForce RTX 30 graphics cards are designed in accordance with NVIDIA specifications, and have passed all required testing, thus the product quality is guaranteed. GIGABYTE GeForce RTX 3080 GAMING OC and EAGLE OC series graphics cards use high-quality, low-ESR 470uF SP-CAP capacitors, which meet the specifications set by NVIDIA and provide a total capacity of 2820u in terms of GPU core power, higher than the industry’s average. The cost of SP-CAP capacitors is not lower than that of MLCCs. GIGABYTE values product integrity highly and definitely does not reduce costs by using cheap materials.

NVIDIA has released a driver (version 456.55) on September 28, 2020 that improves stability. Users are advised to update to the latest driver for optimized performance. For users who have any concern, please contact our local service centers or representatives.

GIGABYTE has been constantly improving and optimizing product quality, especially in terms of thermal designs, to provide the best gaming experience to the consumers for decades. For the latest AORUS GeForce RTX 30 graphics card series, we have also paid extra attention to the cooling performance and introduced industry-leading solutions such as MAX-Covered Cooling to ensure that the operation of each component is stable.

Statement Regarding the SP-CAP and MLCC Capacitor on GeForce RTX 3080 Graphics Cards

In response to the recent reports speculating that the use of POSCAP capacitors on the GeForce RTX 3080 graphics cards could lead to stability issues and crashes, we would like to clarify the issue with the following statement:

It is false that POSCAP capacitors independently could cause a hardware crash. Whether a graphics card is stable or not requires a comprehensive evaluation of the overall circuit and power delivery design, not just the difference in capacitor types. POSCAPs and MLCCs have different characteristics and uses, thus it is not true to assert that one capacitor type is better than the other.

The GIGABYTE GeForce RTX 30 graphics cards are designed in accordance with NVIDIA specifications, and have passed all required testing, thus the product quality is guaranteed. GIGABYTE GeForce RTX 3080 GAMING OC and EAGLE OC series graphics cards use high-quality, low-ESR 470uF SP-CAP capacitors, which meet the specifications set by NVIDIA and provide a total capacity of 2820u in terms of GPU core power, higher than the industry’s average. The cost of SP-CAP capacitors is not lower than that of MLCCs. GIGABYTE values product integrity highly and definitely does not reduce costs by using cheap materials.

NVIDIA has released a driver (version 456.55) on September 28, 2020 that improves stability. Users are advised to update to the latest driver for optimized performance. For users who have any concern, please contact our local service centers or representatives.

GIGABYTE has been constantly improving and optimizing product quality, especially in terms of thermal designs, to provide the best gaming experience to the consumers for decades. For the latest AORUS GeForce RTX 30 graphics card series, we have also paid extra attention to the cooling performance and introduced industry-leading solutions such as MAX-Covered Cooling to ensure that the operation of each component is stable.

- Liittynyt

- 13.10.2016

- Viestejä

- 14 108

Eipä noilla TUF ja TUF OC taida olla eroa mitään muuta kuin biossiin laitettu eri kellot, itse tilasin normi TUF:in. Olisiko siellä sitten binnattu piirejä tästä +75Mhz ylikellotusta varten, siitä voisi ehkä toinen ero löytyä?

OC Mode - 1740 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1710 MHz , GPU Base Clock : 1440 MHz

vs.

OC Mode - 1815 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1785 MHz , GPU Base Clock : 1440 MHz

Maksimi Power Limit varmaan OC-mallissa korkeampi olettaisin.

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Tuossa Sampsa jo vastasikin, eli OC-versiossa todennäköisesti korkeampi Powerlimit (370W vs 340W), joka mahdollistaa korkeamman/vakaamman kellotaajuuden vakiona ja kellotettuna. Toki ei-OC on heti toiseksi paras valinta jo hintansakin puolesta.Eipä noilla TUF ja TUF OC taida olla eroa mitään muuta kuin biossiin laitettu eri kellot, itse tilasin normi TUF:in. Olisiko siellä sitten binnattu piirejä tästä +75Mhz ylikellotusta varten, siitä voisi ehkä toinen ero löytyä?

OC Mode - 1740 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1710 MHz , GPU Base Clock : 1440 MHz

vs.

OC Mode - 1815 MHz (Boost Clock)

Gaming Mode (Default) - GPU Boost Clock : 1785 MHz , GPU Base Clock : 1440 MHz

Maksimi Power Limit varmaan OC-mallissa korkeampi olettaisin.

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Ainakin aiemmissa sukupolvissa OC-mallissa oli korkeampi powerlimit, samoin esim. Palitin 3080 Gamerock OC (370W) ja pelkkä Gamerock (340W) on eri powerlimitit.En kyllä usko että se Power Limit korkeempi on, vain vakiokellot korkeammalla, mutta mitä minä tiedän mistään

Tuonne kerätty jo jonkin verran dataa: [Official] NVIDIA RTX 3080 Owner's Club

Viimeksi muokattu:

- Liittynyt

- 15.04.2018

- Viestejä

- 2 343

Mielenkiintoista. 2000-sarjassa erot ainakin osittain selittyi sillä, että OC-malleissa käytettiin A chippiä, joka mahdollisti korkeammat kellotukset.Ainakin aiemmissa sukupolvissa OC-mallissa oli korkeampi powerlimit, samoin esim. Palitin 3080 Gamerock OC (370W) ja pelkkä Gamerock (340W) on eri powerlimitit.

Tuonne kerätty jo jonkin verran dataa: [Official] NVIDIA RTX 3080 Owner's Club

- Liittynyt

- 17.10.2016

- Viestejä

- 8 777

Niin oli erillä tavalla speksattu A-piiri OC-malleissa, mutta myös powerlimit oli eri, näistä ei ole vielä raportoitu eroavaisuutta piireissä, mutta powerlimitissä on. Eikä tuossa edellisessä sukupolvessa A/OC piiri tarkoittanut automaattisesti parempaa kellottuvuutta, mutta korkeamman powerlimitin takia kellotaajuuden heittely oli vähäisempää.Mielenkiintoista. 2000-sarjassa erot ainakin osittain selittyi sillä, että OC-malleissa käytettiin A chippiä, joka mahdollisti korkeammat kellotukset.

Tuolta voi katsella 2080 Ti-mallien powerlimit-arvoja, järkiään OC-malleissa korkeampi: [Official] NVIDIA RTX 2080 Ti Owner's Club

Edit: Linkki korjattu

- Liittynyt

- 24.09.2020

- Viestejä

- 68

Mitäköhän reddit insinöörit tuosta sanooGigabyteltä lausunto aiheesta:

Statement Regarding the SP-CAP and MLCC Capacitor on GeForce RTX 3080 Graphics Cards

In response to the recent reports speculating that the use of POSCAP capacitors on the GeForce RTX 3080 graphics cards could lead to stability issues and crashes, we would like to clarify the issue with the following statement:

It is false that POSCAP capacitors independently could cause a hardware crash. Whether a graphics card is stable or not requires a comprehensive evaluation of the overall circuit and power delivery design, not just the difference in capacitor types. POSCAPs and MLCCs have different characteristics and uses, thus it is not true to assert that one capacitor type is better than the other.

The GIGABYTE GeForce RTX 30 graphics cards are designed in accordance with NVIDIA specifications, and have passed all required testing, thus the product quality is guaranteed. GIGABYTE GeForce RTX 3080 GAMING OC and EAGLE OC series graphics cards use high-quality, low-ESR 470uF SP-CAP capacitors, which meet the specifications set by NVIDIA and provide a total capacity of 2820u in terms of GPU core power, higher than the industry’s average. The cost of SP-CAP capacitors is not lower than that of MLCCs. GIGABYTE values product integrity highly and definitely does not reduce costs by using cheap materials.

NVIDIA has released a driver (version 456.55) on September 28, 2020 that improves stability. Users are advised to update to the latest driver for optimized performance. For users who have any concern, please contact our local service centers or representatives.

GIGABYTE has been constantly improving and optimizing product quality, especially in terms of thermal designs, to provide the best gaming experience to the consumers for decades. For the latest AORUS GeForce RTX 30 graphics card series, we have also paid extra attention to the cooling performance and introduced industry-leading solutions such as MAX-Covered Cooling to ensure that the operation of each component is stable.

- Liittynyt

- 17.09.2020

- Viestejä

- 311

Tämän mukaan TUF ja TUF OC on samat power limitit, eli molemmissa 340/375: [Official] NVIDIA RTX 3080 Owner's Club

Uutiset

-

Samsung esitteli Galaxy Unpackedissa uudet Galaxy Buds4 -sarjan nappikuulokkeet

25.2.2026 21:58

-

Lenovo varoittaa tietokoneidensa hintojen pomppaavan maaliskuussa

25.2.2026 20:23

-

Samsung julkisti uudet Galaxy S26 -sarjan puhelimensa vuoden 2026 ensimmäisessä Unpacked-tilaisuudessa

25.2.2026 20:00

-

Endorfy julkaisi mATX-kokoluokan Signum M30 -kotelon ARGB-valaistuksella ja ilman

25.2.2026 11:46

-

Jolla kertoi lisätietoja tulevasta Jolla Phonesta

24.2.2026 23:48