-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA GeForce RTX 3080 / 3080 Ti / 3090 -ketju (GA102)

- Keskustelun aloittaja Kaotik

- Aloitettu

- Liittynyt

- 20.10.2016

- Viestejä

- 7 003

Ongelmana lienee juurikin nuo eri resoluutiot korkeammilla virkistystaajuuksilla. Jos pystyt, niin kokeilee laittaa tuo telkkarikin 1440p ja 120Hz, niin putoaako virrankulutus.Itsellä ei NVidian ohjauspaneelin virransäästöasetuksella näytä olevan asian kanssa mitään tekemistä. Mutta tosiaan heti kun asetan 2. monitorina toimivalle Sampan QLEDille 4k@60Hz->120Hz virkistystaajuuden, niin pomppaa pysyvästi 100 wattiin. Hetken päästä näyttää asettuvan aiempaan, noin 87 wattiin. Pitänee tänään vielä katsoa, josko tuolla telkan resetoinnilla olisi mitään vaikutusta. Ensisijaisen 1440p120Hz-näytön korkea virkistystaajuus ei aiheuta korkeaa virrankulutusta.

Tämä virrankulutus useammalla näytöllä on ollut jo pitkään ongelma...

Nyt on alkanut Asus TUF 3090 OC lämpenemään vähän liikaakin. Vielä muutama kuukausi sitten n. 60 sekunnin Heaven benchmarkin ajamisen jälkeen Hot Spot oli n. 80c.

Tänään saman 60 sekunnin Heavenin jälkeen Hot Spot on n. 100c. Annoin pyöriä ihan rauhassa vähän pidempään ja lämmöt nousi noin 105c asti.

Memory lämmöthän tässä on aina olleet korkeat, mutta nyt vasta alkanut tuo Hot Spot temppuilemaan.

Olen käsittääkseni kortin toinen omistaja ja edellinen omistaja ei omien sanojensa mukaan ollut avannut/räpeltänyt korttia. Telialta ostettu ja takuuta olisi jäljellä. Kannattaako viedä Telialle vai lähettää johonkin Asuksen huoltoon? Kortti on kuitenkin mallia 01/2022 joten hieman oudolta tuntuu nämä lämmöt.

Meni Telian takuuseen, 2329€ takasin päin.

- Liittynyt

- 07.06.2017

- Viestejä

- 6 108

Loistodiili

Meni Telian takuuseen, 2329€ takasin päin.

Nyt samalla rahalla 4090 ja kaljarahaa päälle

- Liittynyt

- 13.11.2017

- Viestejä

- 210

Osaako joku sanoa optista HDMI 2.1 -piuhaa, joka varmasti toimisi 3000-sarjan kanssa? Hommasin 3080:n ja aiemmin olin hankkinut tällaisen piuhan, kun pakko olla vähintään tuo 7.5 m tässä huoneessa, mutta ei tästä tunnu tulevan mitään. Kone pillastuu täysin kun laittaa tuon edes kiinni telkkariin, tai kun piuha on kiinni ja käynnistää telkkarin. Koneen ruutu (näyttö displayportilla) jäätyy ehkä puoleksi minuutiksi, jonka jälkeen menee mustaksi ja kun ottaa HDMI:n irti tai sulkee telkkarin, niin menee vielä muutama minuutti ennen kuin kuva palautuu näyttöön. Laitoin nyt piuhan kiinni telkkarin HDMI 2.0 -porttiin ja toimii ihan normaalisti sen mitä tuosta 2.0:sta irti saa, eli 1440p 120 Hz HDR VRR. Vanhalla 2070:lla tuo sama signaali toimi HDMI 2.1 -portistakin, mutta tämä 3080 tuntuu menevän siitä ihan sekaisin.

Epäilyttää siis, että onko tuo piuha kuitenkin paska, tosin googlella löytyi myös paljon epämääräisiä ongelmia, joita ihmisillä on ollut 3000-sarjan ja HDMI 2.1:n kanssa. Pitäisi kai ensin testata lyhyellä tavallisella piuhalla, mutta pitäisi sekin ensin hommata ja sitten ruveta näitä romuja siirtelemään.

Epäilyttää siis, että onko tuo piuha kuitenkin paska, tosin googlella löytyi myös paljon epämääräisiä ongelmia, joita ihmisillä on ollut 3000-sarjan ja HDMI 2.1:n kanssa. Pitäisi kai ensin testata lyhyellä tavallisella piuhalla, mutta pitäisi sekin ensin hommata ja sitten ruveta näitä romuja siirtelemään.

- Liittynyt

- 02.12.2016

- Viestejä

- 338

Itellä on 20m KabelDirektin kaapeli ja hyvin on toiminu 3080Ti ja LG CX:n kanssa.

Näyttää tosin olevan kaikki pituudet loppu...

EDIT. Näytä olevan joku toinen versio kun sku on 1317b ja tuolla on toinen "samallainen" jota on varastossa jonka sku on 1317. Sitä en tiedä mitä eroa noilla kahdella on.

Näyttää tosin olevan kaikki pituudet loppu...

EDIT. Näytä olevan joku toinen versio kun sku on 1317b ja tuolla on toinen "samallainen" jota on varastossa jonka sku on 1317. Sitä en tiedä mitä eroa noilla kahdella on.

Viimeksi muokattu:

- Liittynyt

- 06.09.2017

- Viestejä

- 891

Osaako joku sanoa optista HDMI 2.1 -piuhaa, joka varmasti toimisi 3000-sarjan kanssa? Hommasin 3080:n ja aiemmin olin hankkinut tällaisen piuhan, kun pakko olla vähintään tuo 7.5 m tässä huoneessa, mutta ei tästä tunnu tulevan mitään. Kone pillastuu täysin kun laittaa tuon edes kiinni telkkariin, tai kun piuha on kiinni ja käynnistää telkkarin. Koneen ruutu (näyttö displayportilla) jäätyy ehkä puoleksi minuutiksi, jonka jälkeen menee mustaksi ja kun ottaa HDMI:n irti tai sulkee telkkarin, niin menee vielä muutama minuutti ennen kuin kuva palautuu näyttöön. Laitoin nyt piuhan kiinni telkkarin HDMI 2.0 -porttiin ja toimii ihan normaalisti sen mitä tuosta 2.0:sta irti saa, eli 1440p 120 Hz HDR VRR. Vanhalla 2070:lla tuo sama signaali toimi HDMI 2.1 -portistakin, mutta tämä 3080 tuntuu menevän siitä ihan sekaisin.

Epäilyttää siis, että onko tuo piuha kuitenkin paska, tosin googlella löytyi myös paljon epämääräisiä ongelmia, joita ihmisillä on ollut 3000-sarjan ja HDMI 2.1:n kanssa. Pitäisi kai ensin testata lyhyellä tavallisella piuhalla, mutta pitäisi sekin ensin hommata ja sitten ruveta näitä romuja siirtelemään.

Ei suoraa vastausta sinun kysymykseen, mutta minulla oli Haman 10m HDMI 2.0 piuha ja tuolla ei tahtonut kuvan saaminen onnistua telkkariin RTX 3080Ti:llä. Ihan jatkuvasti valitti, että ei signaalia ja ihan tuurista oli kiinni lähtikö toimimaan vai ei.

Lyhemmällä kaapelilla ei ollut ongelmia, joten @Lixgou kommentinkin perusteella todennäköisesti syyt on huonossa kaapelissa varsinkin silloin kun mennään yli 5m vaikka ei tuossa "pitäisi" mitään signal lossia olla.

- Liittynyt

- 13.11.2017

- Viestejä

- 210

Kai se on tätä sitten kokeiltava, thanks.Itellä on 20m KabelDirektin kaapeli ja hyvin on toiminu 3080Ti ja LG CX:n kanssa.

Joo, HDMI 2.1 ei taida missään nimessä toimia yli viittä metriä pelkällä kuparilla, mutta kyllä noiden hybridikaapelien pitäisi.Ei suoraa vastausta sinun kysymykseen, mutta minulla oli Haman 10m HDMI 2.0 piuha ja tuolla ei tahtonut kuvan saaminen onnistua telkkariin RTX 3080Ti:llä. Ihan jatkuvasti valitti, että ei signaalia ja ihan tuurista oli kiinni lähtikö toimimaan vai ei.

Lyhemmällä kaapelilla ei ollut ongelmia, joten @Lixgou kommentinkin perusteella todennäköisesti syyt on huonossa kaapelissa varsinkin silloin kun mennään yli 5m vaikka ei tuossa "pitäisi" mitään signal lossia olla.

- Liittynyt

- 06.11.2016

- Viestejä

- 1 697

Nyt meni vähän sormi suuhun. Reilut kolme vuotta sitten hankittu 3080 on aikoinaan alivoltitettu MSI Afterburnerilla. Systeemi on ollut koko tämän ajan stabiili, mutta nyt on esiintynyt epävakautta Avatar-pelissä. Pidemmässä pelisessiossa grafiikkaan saattaa tulla semmoinen häiriö, että grafiikka ikään kuin hajoaa, ja näkymään kääntämällä rikkoutunut kohta leviää ja täyttää koko ruudun. Valikossa käynti korjaa ongelman.

Olen ajatellut, että tämä saattaisi olla coreen liittyvän alivoltituksen aiheuttamaa. Ongelmat alkoivat, kun päivitin prossun ja emon, ja samassa yhteydessä näyttö vaihtui 60Hz ->120Hz. GPU joutunee kovemmille kuin aiemmin, tosin on tässä ennenkin ajettu pelejä, jotka ei pääse 60fps:ään, jolloin kuormitus on ollut jatkuvasti 100%. Tietenkin voi olla, että uusi peli osaa kormuuttaa enemmän tuota GPU:ta.

Ongelma saattaa tietysti liittyä myös muisteihin, niissä on vähän ylikelloa. Ajattelin kuitenkin, että voisin hieman tuunata alivoltitusta, mutta tässäpä tulikin ongelma, johon kaipaisin apua. GPU on alivoltitettu siten, että toimintapiste on asetettu 1905MHz @ 925mV. Olen nyt yrittänyt muuttaa curve-asetusta siten, että 1905MHz piste olisi kaksi askelta myöhemmin, eli jännittellä 937mV. Ongelma on tämä:

Säädän curvea siten, että pudotan

- 925mV pistettä kahdella askelella 1905MHz --> 1875MHz,

- ja seuraavaa pistettä 931mV yhdellä asekeleella 1095MHz --> 1890MHz.

Olen tyytyväinen curveen, mutta kun painan Apply, curven pisteet hyppäävät minne sattuu. Mikä logiikka tuossa ohjelmassa on? Miksi nuo asetukset vaihtuu kun painaa Apply?

Tulokset vaihtelee kovasti sen mukaan miten noita pisteitä veivaa, ja olen onnistunutkin pääsemään lähelle tavoitetta, mutta kai tuossa joku logiikka on, miten nuo hyppii? Lisäksi, jos pistän GPU:lle kuormaa, ne pisteet hyppii eri tavalla. Jos luo profiilin siten, että GPU:lla on kuormaa, painan Apply ja olen tyytyväinen tulokseen ja talletan profiilin, jos sitten lataan saman profiilin GPU:n ollessa idlessä ja painan Apply, curven pisteet hyppii taas ihan mihin sattuu?

Ja vielä, mikä on toi ohut yhtenäinen viiva, sekin hyppii miten sattuu, mitä se tarkoittaa?

Auttakee, mikä tuossa on järki, ja miten tuon ohjelman saa tottelemaan?

Olen ajatellut, että tämä saattaisi olla coreen liittyvän alivoltituksen aiheuttamaa. Ongelmat alkoivat, kun päivitin prossun ja emon, ja samassa yhteydessä näyttö vaihtui 60Hz ->120Hz. GPU joutunee kovemmille kuin aiemmin, tosin on tässä ennenkin ajettu pelejä, jotka ei pääse 60fps:ään, jolloin kuormitus on ollut jatkuvasti 100%. Tietenkin voi olla, että uusi peli osaa kormuuttaa enemmän tuota GPU:ta.

Ongelma saattaa tietysti liittyä myös muisteihin, niissä on vähän ylikelloa. Ajattelin kuitenkin, että voisin hieman tuunata alivoltitusta, mutta tässäpä tulikin ongelma, johon kaipaisin apua. GPU on alivoltitettu siten, että toimintapiste on asetettu 1905MHz @ 925mV. Olen nyt yrittänyt muuttaa curve-asetusta siten, että 1905MHz piste olisi kaksi askelta myöhemmin, eli jännittellä 937mV. Ongelma on tämä:

Säädän curvea siten, että pudotan

- 925mV pistettä kahdella askelella 1905MHz --> 1875MHz,

- ja seuraavaa pistettä 931mV yhdellä asekeleella 1095MHz --> 1890MHz.

Olen tyytyväinen curveen, mutta kun painan Apply, curven pisteet hyppäävät minne sattuu. Mikä logiikka tuossa ohjelmassa on? Miksi nuo asetukset vaihtuu kun painaa Apply?

Tulokset vaihtelee kovasti sen mukaan miten noita pisteitä veivaa, ja olen onnistunutkin pääsemään lähelle tavoitetta, mutta kai tuossa joku logiikka on, miten nuo hyppii? Lisäksi, jos pistän GPU:lle kuormaa, ne pisteet hyppii eri tavalla. Jos luo profiilin siten, että GPU:lla on kuormaa, painan Apply ja olen tyytyväinen tulokseen ja talletan profiilin, jos sitten lataan saman profiilin GPU:n ollessa idlessä ja painan Apply, curven pisteet hyppii taas ihan mihin sattuu?

Ja vielä, mikä on toi ohut yhtenäinen viiva, sekin hyppii miten sattuu, mitä se tarkoittaa?

Auttakee, mikä tuossa on järki, ja miten tuon ohjelman saa tottelemaan?

Liitteet

- Liittynyt

- 17.10.2016

- Viestejä

- 6 599

15MHz askeleissahan nuo menee, mutta eipä siinä aina tosiaan tunnu logiikkaa olevan mihin pykälään ne asettuu, pitää vain veivata riittävästi oletukset <-> säätö väliä tai säädön jälkeen asetella yksittäisiä pisteitä paremmin, jos curvesta haluaa hieman esteettisemmän.

Mutta mitä tuohon "black void" bugiin tulee, niin vastaavaan aikanaan törmäsin Overwatchissa ja tuolloin tulin lopputulokseen, että se ei tykännyt GPU:n muistikellotuksista yhtään. Kannattanee varmaan siis Avatarille kokeilla tehdä vaikka oma profiili Afterburneriin, jossa ei ole muistikelloihin koskettu ja kokeilla.

Tämän kaltainen bugi siis ilmeisesti tuossakin kyseessä, napattu ensimmäinen mikä tuli youtubessa vastaan

Mutta mitä tuohon "black void" bugiin tulee, niin vastaavaan aikanaan törmäsin Overwatchissa ja tuolloin tulin lopputulokseen, että se ei tykännyt GPU:n muistikellotuksista yhtään. Kannattanee varmaan siis Avatarille kokeilla tehdä vaikka oma profiili Afterburneriin, jossa ei ole muistikelloihin koskettu ja kokeilla.

Tämän kaltainen bugi siis ilmeisesti tuossakin kyseessä, napattu ensimmäinen mikä tuli youtubessa vastaan

- Liittynyt

- 06.11.2016

- Viestejä

- 1 697

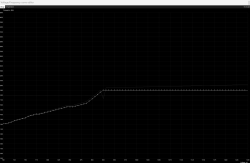

Eli kun teen tällaisen muutoksen:

Ja painan Apply, niin käyrä muuttuu samalla tällaiseksi:

Käyrä siis muuttuu useammasta kohtaa, miksi ihmeessä? Muuttunut curve ei kelpaa, koska siinä maksimikellot on pielessä. Jos jaksa nveivata aikani maalaamalla (Shift) osa käyrästä, saan paremman lopputuloksen, mutta ei tuossa tunnu olevan oikein järkeä. Mutta kai siinä jokin logiikka kuites on.

Grafiikkabugi hieman muistuttaa muodostumisellaan tuota videota, mutta se ei ole pelkkää mustaa, vaan siihen jää jokin satunnainen pala, joka toistaa itseään. Mutta voisin kokeilla tosiaan pudottaa kelloja, sillä jos kyseessä ei olekaan GPU, niin turhaan nostaisin voltteja.

Ja painan Apply, niin käyrä muuttuu samalla tällaiseksi:

Käyrä siis muuttuu useammasta kohtaa, miksi ihmeessä? Muuttunut curve ei kelpaa, koska siinä maksimikellot on pielessä. Jos jaksa nveivata aikani maalaamalla (Shift) osa käyrästä, saan paremman lopputuloksen, mutta ei tuossa tunnu olevan oikein järkeä. Mutta kai siinä jokin logiikka kuites on.

Grafiikkabugi hieman muistuttaa muodostumisellaan tuota videota, mutta se ei ole pelkkää mustaa, vaan siihen jää jokin satunnainen pala, joka toistaa itseään. Mutta voisin kokeilla tosiaan pudottaa kelloja, sillä jos kyseessä ei olekaan GPU, niin turhaan nostaisin voltteja.

Joo toi AB-käyrän hyppiminen on aika omituista välillä. Tätä Escaliburin videota olen mainostellut, koska on suomeksi:

(kohdassa 10:57 alkaa curven säätö)

Itse olen asettanut GPU-kellot hieman yläkanttiin tavoitekelloista käyrää säätäessä (heittelee silti ylöspäin, käyrä sinänsä pysyy yleensä kuitenkin muodossaan) ja sitten .bat tiedostossa / task schedulerissa nvidia-smi -lgc 210,1950 aina bootissa. 1950MHz siis maksimikellot.

Itse olen asettanut GPU-kellot hieman yläkanttiin tavoitekelloista käyrää säätäessä (heittelee silti ylöspäin, käyrä sinänsä pysyy yleensä kuitenkin muodossaan) ja sitten .bat tiedostossa / task schedulerissa nvidia-smi -lgc 210,1950 aina bootissa. 1950MHz siis maksimikellot.

Viimeksi muokattu:

- Liittynyt

- 06.11.2016

- Viestejä

- 1 697

Tuossa escaliburin videossa näkyy todella hienosti miten tuo ohjelma sekoilee noiden asetusten kanssa

Kurvin saa suoraan myös maalaamalla loppuosan ja painamalla Shift+Enter+Enter. Mutta silti ne pisteet saattaa hyppiä kun painaa Applyä. Pitää vaan jaksaa hieroa noita uudestaan ja uudestaan, niin lopulta onnistuu. Oon tässä illan testaillut, ja vaikuttais vähän siltä, että tuo muutos, minkä halusin tehdä, on jostain syystä vielä erittäin ronkeli saada onnistumaan. Sillä olen testailla varsin nostaa hieman kelloja (nälkä kasvaa syödessä), niin yleensä asetus onnistuu parilla/kolmella yrittämällä.

Tuo nvidia-smi olisi varmaan vielä yksi tapa hieroa kelloja kohilleen, nyt ne tosiaan välillä boostaa hieman asetusta ylemmäs, mutta näyttäisi, että ainoastaan yhden tiksun (15MHz). Mitä nyt olen tässä vähän testaillut, niin lappu näyttäisi olevan jokseenkin vakaa vielä 1950@925mV (lopullinen vakaus selviäisi vasta monen päivän pelihommissa), joten luulen, että tuo alkuperäinen 1905@925mV ei ehkä tosiaan ole nuiden Avatarin grafiikkahäiriöiden takana. Pudotan vähän muisteja ja sitten kovaa pelaamista.

Kurvin saa suoraan myös maalaamalla loppuosan ja painamalla Shift+Enter+Enter. Mutta silti ne pisteet saattaa hyppiä kun painaa Applyä. Pitää vaan jaksaa hieroa noita uudestaan ja uudestaan, niin lopulta onnistuu. Oon tässä illan testaillut, ja vaikuttais vähän siltä, että tuo muutos, minkä halusin tehdä, on jostain syystä vielä erittäin ronkeli saada onnistumaan. Sillä olen testailla varsin nostaa hieman kelloja (nälkä kasvaa syödessä), niin yleensä asetus onnistuu parilla/kolmella yrittämällä.

Tuo nvidia-smi olisi varmaan vielä yksi tapa hieroa kelloja kohilleen, nyt ne tosiaan välillä boostaa hieman asetusta ylemmäs, mutta näyttäisi, että ainoastaan yhden tiksun (15MHz). Mitä nyt olen tässä vähän testaillut, niin lappu näyttäisi olevan jokseenkin vakaa vielä 1950@925mV (lopullinen vakaus selviäisi vasta monen päivän pelihommissa), joten luulen, että tuo alkuperäinen 1905@925mV ei ehkä tosiaan ole nuiden Avatarin grafiikkahäiriöiden takana. Pudotan vähän muisteja ja sitten kovaa pelaamista.

Usein huomaa, että ylikellotuksista puhuttaessa annetaan suurempia lukuja, kuten 2150 MHz, vaikka todellinen toimintataajuus saattaa olla vain 2080 MHz.

Jos kiinnostaa se gpun oikea (effective clock) taajuus, eikä vain joku random numero, suosittelen tätä metodia:

Jos kiinnostaa se gpun oikea (effective clock) taajuus, eikä vain joku random numero, suosittelen tätä metodia:

- Liittynyt

- 06.11.2016

- Viestejä

- 1 697

Näytönohjaimen kellottaminen on yllättävän hauskaa hommaa. Oikeastaan vain siksi, että näyttäis, että epästabiilisuus saa pelin vain nurin, ei tähän kyllä olisi intoa jos joka kerta saisi katsoa BSOD:tä, tai joutus tekemään hard bootin, puhumattakaan CMOS-clearauksesta. Mutta nyt pelit vain kippaa, pieni säätö ja uusi yritys, ihan harrastuksesta menee.

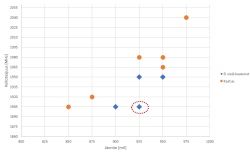

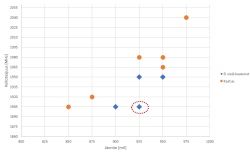

Toistaiseksi havainto on, että kolme vuotta sitten nopeasti haarukoidut asetukset näyttäis olevan melko hyvät. En tosiaan ole vielä kattavasti testannut, mutta piti varsin huvikseni värkätä kuva, jotta itsekin pysyy kärryillä missä mennään:

Asetus on siis ollut sen kolme vuotta tuo punainen ympyrä. Yritin ensin vähän hakea, että saisiko lisää potkua, jos hieman nostaisi jännitettä. Testaus on edelleen kesken, joten muuta ei tässä vaiheessa voi sanoa, kuin että 50mV nostolla saa korkeintaan kolme tiksua, eli 45MHz lisää kelloa, tuskin sitäkään. Mutta testaillessa ja pelaillessa huomasin, että raskaissa peleissä, jotka todella kormuttaa GPU:ta (Avatar), GPU:ssa tahtoo tulla power limit vastaan, ja ylemmille kelloille ei oikein päästä. Joten aloin miettimään, että entäs jo pyrkisikin alivoltittamaan lisää, minkä ansiosta kellotaajuus sitten pysyisi paremmin maksimissa, vaikka se maksimi olisikin hieman matalampi. Erityisesti avatarissa huomasin, että GPU välillä käy 1905:ssä, mutta enemmän aikaa se on tiksun tai kaksi alempana, vaikka GPU:ta on jo alivoltitettu.

Joten tuli semmoinen ajatus, että tuo 1905 saattaisi olla hyvä sweet-spot, ja lähdin lähestymään asiaa "pohjalta", eli saisinko tuon 1905 toimimaan pienemmällä jännitteellä, mikä parantaisi tilannetta silloin, kun sitä eniten tarvitaan, eli niissä raskaissa peleissä, siten että kellotaajuus pysyisi tuossa maksimissa. Tämäkin haarukointi on kesken, ja haastetta aiheuttaa se, että näyttis boostailee itse asetetun arvon päälle, pitää ehkä ottaa tuo nvidia-smi käyttöön jotta tämä haarukointi etenee.

Ja jotta asia ei olisi liian helppoa, niin tällainenkin asia pitää siis huomioida Nappasin tuon efective kellon MSI AB:n overlayhyn, pitää seurailla miten se muuttuu. Siinä mielessä tämä koko puuha on vähän turhaa hommaa, kun nyt jo näkee, että tässä on maksimissaan odotettavissa ehkä 30MHz parannus kelloihin, joka ei hirveästi fps:ään auta*. Mutta tässä konepäivityksen yhteydessä näköjään nousi halu tiristää kaikki irti mitä tuosta lapusta vain on tiristettävissä, kun 40x0-hankita nyt toistaiseksi jäi pöydälle.

Nappasin tuon efective kellon MSI AB:n overlayhyn, pitää seurailla miten se muuttuu. Siinä mielessä tämä koko puuha on vähän turhaa hommaa, kun nyt jo näkee, että tässä on maksimissaan odotettavissa ehkä 30MHz parannus kelloihin, joka ei hirveästi fps:ään auta*. Mutta tässä konepäivityksen yhteydessä näköjään nousi halu tiristää kaikki irti mitä tuosta lapusta vain on tiristettävissä, kun 40x0-hankita nyt toistaiseksi jäi pöydälle.

*) laskemalla 45MHz/ 1905MHz x 45fps = 1fps, eli onnistunut kellotus voisi maksimissaan vaikuttaa peliin siten, että pelin pyöriessä 45fps, se pyörisikin 46fps

Toistaiseksi havainto on, että kolme vuotta sitten nopeasti haarukoidut asetukset näyttäis olevan melko hyvät. En tosiaan ole vielä kattavasti testannut, mutta piti varsin huvikseni värkätä kuva, jotta itsekin pysyy kärryillä missä mennään:

Asetus on siis ollut sen kolme vuotta tuo punainen ympyrä. Yritin ensin vähän hakea, että saisiko lisää potkua, jos hieman nostaisi jännitettä. Testaus on edelleen kesken, joten muuta ei tässä vaiheessa voi sanoa, kuin että 50mV nostolla saa korkeintaan kolme tiksua, eli 45MHz lisää kelloa, tuskin sitäkään. Mutta testaillessa ja pelaillessa huomasin, että raskaissa peleissä, jotka todella kormuttaa GPU:ta (Avatar), GPU:ssa tahtoo tulla power limit vastaan, ja ylemmille kelloille ei oikein päästä. Joten aloin miettimään, että entäs jo pyrkisikin alivoltittamaan lisää, minkä ansiosta kellotaajuus sitten pysyisi paremmin maksimissa, vaikka se maksimi olisikin hieman matalampi. Erityisesti avatarissa huomasin, että GPU välillä käy 1905:ssä, mutta enemmän aikaa se on tiksun tai kaksi alempana, vaikka GPU:ta on jo alivoltitettu.

Joten tuli semmoinen ajatus, että tuo 1905 saattaisi olla hyvä sweet-spot, ja lähdin lähestymään asiaa "pohjalta", eli saisinko tuon 1905 toimimaan pienemmällä jännitteellä, mikä parantaisi tilannetta silloin, kun sitä eniten tarvitaan, eli niissä raskaissa peleissä, siten että kellotaajuus pysyisi tuossa maksimissa. Tämäkin haarukointi on kesken, ja haastetta aiheuttaa se, että näyttis boostailee itse asetetun arvon päälle, pitää ehkä ottaa tuo nvidia-smi käyttöön jotta tämä haarukointi etenee.

Usein huomaa, että ylikellotuksista puhuttaessa annetaan suurempia lukuja, kuten 2150 MHz, vaikka todellinen toimintataajuus saattaa olla vain 2080 MHz.

Jos kiinnostaa se gpun oikea (effective clock) taajuus, eikä vain joku random numero, suosittelen tätä metodia:

Ja jotta asia ei olisi liian helppoa, niin tällainenkin asia pitää siis huomioida

Nappasin tuon efective kellon MSI AB:n overlayhyn, pitää seurailla miten se muuttuu. Siinä mielessä tämä koko puuha on vähän turhaa hommaa, kun nyt jo näkee, että tässä on maksimissaan odotettavissa ehkä 30MHz parannus kelloihin, joka ei hirveästi fps:ään auta*. Mutta tässä konepäivityksen yhteydessä näköjään nousi halu tiristää kaikki irti mitä tuosta lapusta vain on tiristettävissä, kun 40x0-hankita nyt toistaiseksi jäi pöydälle.

Nappasin tuon efective kellon MSI AB:n overlayhyn, pitää seurailla miten se muuttuu. Siinä mielessä tämä koko puuha on vähän turhaa hommaa, kun nyt jo näkee, että tässä on maksimissaan odotettavissa ehkä 30MHz parannus kelloihin, joka ei hirveästi fps:ään auta*. Mutta tässä konepäivityksen yhteydessä näköjään nousi halu tiristää kaikki irti mitä tuosta lapusta vain on tiristettävissä, kun 40x0-hankita nyt toistaiseksi jäi pöydälle.*) laskemalla 45MHz/ 1905MHz x 45fps = 1fps, eli onnistunut kellotus voisi maksimissaan vaikuttaa peliin siten, että pelin pyöriessä 45fps, se pyörisikin 46fps

- Liittynyt

- 18.10.2016

- Viestejä

- 74

Mulla kaatuilee pelit satunnaisesti ja kerkesin jo tekemään RMA hakemuksen myyjäliikkeeseen. Nyt tarkemmin testailessa huomasin, että FurMark taustalla (GPU FAN 100%) niin Afterburner kuin Asuksen GPU Tweak näyttää kelloja paljon vähemmän kuin täällä ketjussa. Näyttääkö nämä arvot OK:lta? Näytönohjaimena TUF 3090 OC Gaming. Jos heitän power limit täysille ja temp limit täysille niin ei tapahdu missään muutosta, ei lämmöissä tai kelloissa. Kokeilin myös pitää yhden ohjelman kerralla päällä.

Qwerty

.

- Liittynyt

- 17.10.2016

- Viestejä

- 1 126

Tuossa sulla kortti throtlaa kelloja ja virrankulutusta alaspäin lämpöjen takia jotta hotspot lämmöt pysyisi alle 105c. Korjaantuu tahnojen vaihdolla tai sitten takuusta uusi kortti tilalle.Mulla kaatuilee pelit satunnaisesti ja kerkesin jo tekemään RMA hakemuksen myyjäliikkeeseen. Nyt tarkemmin testailessa huomasin, että FurMark taustalla (GPU FAN 100%) niin Afterburner kuin Asuksen GPU Tweak näyttää kelloja paljon vähemmän kuin täällä ketjussa. Näyttääkö nämä arvot OK:lta? Näytönohjaimena TUF 3090 OC Gaming. Jos heitän power limit täysille ja temp limit täysille niin ei tapahdu missään muutosta, ei lämmöissä tai kelloissa. Kokeilin myös pitää yhden ohjelman kerralla päällä.

- Liittynyt

- 18.10.2016

- Viestejä

- 74

Throttlaako tuo nyt kellot puolella oikeasta vai miten tuota luetaan? Valmistajan sivuilla luvataan yli 1700MHz "Engine Clock". Mietin vaan, onko tohon joku kaava, kuten ainakin vuosia sitten DDR muistitaajuus piti kertoa kahdella, jotta sai oikean luvun.Tuossa sulla kortti throtlaa kelloja ja virrankulutusta alaspäin lämpöjen takia jotta hotspot lämmöt pysyisi alle 105c. Korjaantuu tahnojen vaihdolla tai sitten takuusta uusi kortti tilalle.

Jos tuo pudotus on tosiaan noin suuri niin saattaa selittää pelien kaatumisen.

- Liittynyt

- 18.10.2016

- Viestejä

- 74

Siltä näyttäisi, hyvä tietää. 3Dmark 1575MHz, Valley 1650MHz, Heaven 1700MHz. Kävin äsken pelaamassa Apex Legends niin pyöri siinä 1650MHz hujakoilla. Hot Spot pyöri siinä 105 asteen korvilla (108 max). Täytynee jatkaa testailuja kun ei tainnut se juurisyy löytyä vielä.Muistaakseni furmarkissa kello droppaa huomattavasti. Kokeile mitä näyttää Valley/Heaven/3Dmarko, niissä pysyy itellä aika paljon tapissa kellot (alivoltitettu)

- Liittynyt

- 18.10.2016

- Viestejä

- 74

Aika pitkälti pelistä ja sovelluksesta riippumatta:Miten corelämmöt (en saa tuota linkkiä/kuvaa auki)?

Vähän matalilta kuulostaa kellot, tosin tuossa 3090:ssä on tieten enemmän rautaa käytössä.

GPU Temperature 81-83C

Memory Junction 93-95C

Hot Spot ~105C

- Liittynyt

- 17.10.2016

- Viestejä

- 6 599

Kyllähän tuo 105C hotspot lämpö kertoisi, että siellä on corella tahnat huonosti / "dry spot", eli takuullisen kortin voinee huollattaa myyjän tai valmistajan kautta tai sitten vain itse vaihtaa tahnat.Siltä näyttäisi, hyvä tietää. 3Dmark 1575MHz, Valley 1650MHz, Heaven 1700MHz. Kävin äsken pelaamassa Apex Legends niin pyöri siinä 1650MHz hujakoilla. Hot Spot pyöri siinä 105 asteen korvilla (108 max). Täytynee jatkaa testailuja kun ei tainnut se juurisyy löytyä vielä.

Vastaavaa löytyy paljonkin googlaamalla "3090 hotspot 105c", kuten:

ok I did a repaste, fixed the problem, hotspot down to 75-80c. There was a bald spot on the GPU from the factory, GPU is like 10c lower too since I used a better paste, Therman Grizzly Kryonut.

Reddit - Netin sydän

- Liittynyt

- 17.10.2016

- Viestejä

- 806

jos on takuuta ja tosiaan huitelee 105c hotspotille niin eiku takuuseen, rahat pois  tai sitten ite vaihtaan, itse olen vaihtotyön tehnyt ja olihan ero kun kunnon tahnat ja tyynyt laittoi.

tai sitten ite vaihtaan, itse olen vaihtotyön tehnyt ja olihan ero kun kunnon tahnat ja tyynyt laittoi.

tää oli hyvä apu kun teki noita tahnan vaihtoja näin aloittelijana.

tää oli hyvä apu kun teki noita tahnan vaihtoja näin aloittelijana.

Viimeksi muokattu:

Eilen RTX 3090 päätti ilmeisesti simahtaa. Korttiin ei syty enää led valot eikä tuulettimet pyöri käynnistyessä, ei tule myöskään kuvaa näytölle. Testattu myös toisella kokoonpanolla ja sama vika.

Takuuta kortissa on, kuitissa 2500€ niin tarjoavatko suoraan RTX 4090 takuusta tilalle?

Takuuta kortissa on, kuitissa 2500€ niin tarjoavatko suoraan RTX 4090 takuusta tilalle?

Eikö se selviä kysymällä myyjältä?Eilen RTX 3090 päätti ilmeisesti simahtaa. Korttiin ei syty enää led valot eikä tuulettimet pyöri käynnistyessä, ei tule myöskään kuvaa näytölle. Testattu myös toisella kokoonpanolla ja sama vika.

Takuuta kortissa on, kuitissa 2500€ niin tarjoavatko suoraan RTX 4090 takuusta tilalle?

Lähinnä mietin mitä muille on tarjottu. Kun missään muussa kortissa ei ole muistia 24gb niin onko heillä perusteita tarjota halvempaa. Näiden kanssa on joskus meinaan joutunut vääntämään ettei tuu kusetetuksi.Eikö se selviä kysymällä myyjältä?

- Liittynyt

- 17.10.2016

- Viestejä

- 6 599

Toisessa ketjussa oli arvioitu korvaajaksi 4070 Ti (ehkä Super voisi olla sitten kunhan tulee myyntiin?), mutta voihan siinä neuvotella rahojen palautuksesta. Lahjakorttia ei käsittääkseni tarvitse hyväksyä kaupan purun yhteydessä.Lähinnä mietin mitä muille on tarjottu. Kun missään muussa kortissa ei ole muistia 24gb niin onko heillä perusteita tarjota halvempaa. Näiden kanssa on joskus meinaan joutunut vääntämään ettei tuu kusetetuksi.

RTX 3090 takuun korvaava tuote

Näytönohjain alkoi oireilla ja olisi lähetettävä takuuseen. Korttia tuskin korjataan, joten sieltä olisi korvaava tuote tulossa. Ongelmana on, että myyjäliikkeessä ei ole edes valikoimissa enää 3090 kortteja. Kyselin alustavasti asiakaspalvelijan arviota minkälaisia kortteja voisi tulla...

bbs.io-tech.fi

- Liittynyt

- 17.10.2016

- Viestejä

- 6 820

Pahimpaan korona+kryptoboomi aikaan ostettu. Itse maksoin 3080 Ti:stä 1800€.Huh, miten tuo nuin kallis on ollut

Varmaankin kannattaa vääntää tiukasti, kun noin paljon kortista maksettu. En oikein voi ymmärtää miten 4070Ti voisi olla korvaava.

Noniin tähän jatkoa. Tosiaan muistin väärin kortin hinnan. Se olikin 2749€. No kuitenkin.

Kortti on nyt käynyt takuu huollossa ja tilalle tarjottiin rtx 4070ti super. Mitäs tästä mieltä? 999€ korttiin vaihto ei oikeen nappaile.

Peleissä about tasoissa 3090 kanssa, virrankulutus ei sinänsä kiinnosta kun hyötylämmöksi se kuitenkin muuttuu. DLSS/DLSS 3 tms en anna arvoa koska on pelejä jotka kärsii kaatumis ongelmista tämän kanssa.

Oma käyttö kortille on 3d piirto ja 4k pelikäyttö ja pelaan aina kaikki herkut täysillä jne. Tästä johtuen tarvitsen vastaavan tilalle vai olenko nyt vaan kiukutteleva asiakas?

Kortti on nyt käynyt takuu huollossa ja tilalle tarjottiin rtx 4070ti super. Mitäs tästä mieltä? 999€ korttiin vaihto ei oikeen nappaile.

Peleissä about tasoissa 3090 kanssa, virrankulutus ei sinänsä kiinnosta kun hyötylämmöksi se kuitenkin muuttuu. DLSS/DLSS 3 tms en anna arvoa koska on pelejä jotka kärsii kaatumis ongelmista tämän kanssa.

Oma käyttö kortille on 3d piirto ja 4k pelikäyttö ja pelaan aina kaikki herkut täysillä jne. Tästä johtuen tarvitsen vastaavan tilalle vai olenko nyt vaan kiukutteleva asiakas?

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 6 797

Väittäisin että 4070Ti Super on huomattavasti jo nopeampi 4k pelaamisessa mitä 3090. Cyberpunk 4k native ultra menee 3080/3090:lla jotakuinkin 8-10 fps kun taas 4070Ti:llä 100% nopeampaa 20fps ilman mitään DLSS kommervenkkejä. Tokihan aina voisi vedota johonkin niche use-caseen jossa 24GB muistista on hyötyä, mutta en tiedä miten taipuvat nuissa. Parashan olisi että maksaisivat 3000e takaisin ja ostaisi kaksi 4090 korttia tilalle hehe.

- Liittynyt

- 17.10.2016

- Viestejä

- 4 895

Lähinnä tuo toteutuu vain Ray tracingin kanssa. Eikä toivottavasti kukaan ole siihen niin fanaattinen, että haluaa lähes päänsärkyä aiheuttavalla alle 25 fps tahdilla pelata.Väittäisin että 4070Ti Super on huomattavasti jo nopeampi 4k pelaamisessa mitä 3090. Cyberpunk 4k native ultra menee 3080/3090:lla jotakuinkin 8-10 fps kun taas 4070Ti:llä 100% nopeampaa 20fps ilman mitään DLSS kommervenkkejä. Tokihan aina voisi vedota johonkin niche use-caseen jossa 24GB muistista on hyötyä, mutta en tiedä miten taipuvat nuissa. Parashan olisi että maksaisivat 3000e takaisin ja ostaisi kaksi 4090 korttia tilalle hehe.

3090 24GB vaihto 4070ti 16GB on aika vitsi kyllä. Ihan eri hintaluokan kortteja. Historiallisesti takuuvaihdoissa on tarvittaessa upgradettu, eli 3090 -> 4090.

Itse katsoisin tuossa tilanteessa että joko toimittavat 4090n tilalle, tai rahakorvauksen joka ottaa huomioon sen mitä kortista on maksettu. Ikävähennystä voi varmasti jonkin verran tulla (olihan kortista iloa) mutta reippaasti yli tonni pitäisi mielestäni korvata.

Itse katsoisin tuossa tilanteessa että joko toimittavat 4090n tilalle, tai rahakorvauksen joka ottaa huomioon sen mitä kortista on maksettu. Ikävähennystä voi varmasti jonkin verran tulla (olihan kortista iloa) mutta reippaasti yli tonni pitäisi mielestäni korvata.

- Liittynyt

- 17.10.2016

- Viestejä

- 6 599

Kun on kerta takuuhuollossa, niin "Jos kauppa puretaan takuuaikana, ei käyttöhyötykorvausta voi vähentää."Ikävähennystä voi varmasti jonkin verran tulla (olihan kortista iloa) mutta reippaasti yli tonni pitäisi mielestäni korvata.

Virheen seuraamukset

Jos tavarassa on virhe, voit valintasi mukaan vaatia tavaran korjaamista tai vaihtamista. Myyjä voi kieltäytyä, jos korjaaminen tai vaihtaminen on mahdotonta.

Myyjälle/valmistajalle pitäisi saada perusteltua, että tuo muistimäärä on ollut se määräävä tekijä edellistä korttia hankittaessa, jotta 3090->4090 vaihto mahdollisesti onnistuisi.

Taitaa olla epätodennäköistä, että lähtisivät tuota korona-ajan hintaa tilittämään ihan rahana.

- Liittynyt

- 06.11.2016

- Viestejä

- 1 697

Täähän on ihan ihmeellinen keissi. Kai nyt pitäis pystyä tarjoamaan 2700eur tuotteen tilalle 1500eur tuote? Kyllä sillä muistin määrällä on merkitystä, jos ei juuri tänään, niin kohta on.

Jos myyjä ei ole valmistautunut siihen että on takuuajalle tarjota sama tuote, niin sit pitää tarjota vähintään kaikilla osa-alueilla yhtä hyvä tai parempi. Aina ne yrittää perhana venkoilla.

Jos myyjä ei ole valmistautunut siihen että on takuuajalle tarjota sama tuote, niin sit pitää tarjota vähintään kaikilla osa-alueilla yhtä hyvä tai parempi. Aina ne yrittää perhana venkoilla.

Charun

Tukijäsen

- Liittynyt

- 03.09.2018

- Viestejä

- 2 448

No en kyllä itsekään ihan kevyesti suostuisi 24GB kortin tilalle ottamaan 16GB mallia, vaikka pelitehot oliskin paremmat. Toisekseen se, että kortti on ostettu korona-aikana, ei liity mitenkään korvauksiin, jos asiakas kuitenkin tuon hinnan on maksanut.

En oikein ymmärrä tuota myyjän/valmistajan näkemystä, luulisi sen olevan heillekin parempi antaa 1500€ kortti 2700€ maksaneen tilalle ja saada vielä päälle todennäköisesti erittäin tyytyväinen asiakas, kuin lähteä riitelemään ja mahdollisesti joutua rahana antamaan edes lähelle ostohintaa takaisin.

En oikein ymmärrä tuota myyjän/valmistajan näkemystä, luulisi sen olevan heillekin parempi antaa 1500€ kortti 2700€ maksaneen tilalle ja saada vielä päälle todennäköisesti erittäin tyytyväinen asiakas, kuin lähteä riitelemään ja mahdollisesti joutua rahana antamaan edes lähelle ostohintaa takaisin.

Noniin tähän jatkoa. Tosiaan muistin väärin kortin hinnan. Se olikin 2749€. No kuitenkin.

Kortti on nyt käynyt takuu huollossa ja tilalle tarjottiin rtx 4070ti super. Mitäs tästä mieltä? 999€ korttiin vaihto ei oikeen nappaile.

Peleissä about tasoissa 3090 kanssa, virrankulutus ei sinänsä kiinnosta kun hyötylämmöksi se kuitenkin muuttuu. DLSS/DLSS 3 tms en anna arvoa koska on pelejä jotka kärsii kaatumis ongelmista tämän kanssa.

Oma käyttö kortille on 3d piirto ja 4k pelikäyttö ja pelaan aina kaikki herkut täysillä jne. Tästä johtuen tarvitsen vastaavan tilalle vai olenko nyt vaan kiukutteleva asiakas?

Itselle tarjottiin 3090 takuusta 1000€ rahaa tai lahjakorttia liikkeeseen. Kieltäydyin kohteliaasti ja muutaman viikon jälkeen maksoivat koko summan.

Noniin tilanne on seuraava. Tarjosivat 999.90€ hyvitystä toiseen tuotteeseen tai mainitsemani rtx 4070ti super. Kyseessä tälläkin foorumilla oleva yritys. Seuraava osoite on sitten kuluttaja asiamies kun näin vaikeaksi piti ryhtyä. Jää omalta osalta viimeiseksi ostokseksi tästä firmasta ja 10 muulta kaverilta/tutulta. Uskomatonta.

Näinköhän käy että 3080 TI mennään 5000 sarjaan asti, 4000 sarja ei vieläkään herättele päivitysvimmaa vaikka tilanne on parantunut julkaisusta jossa FPS per maksettu Euro ei parantunut yhtään verrattaessa edellisen sukupolven mallistoon.

Toisaalta saas nähdä toistaako historia itseään 5000 kanssa.

Toisaalta saas nähdä toistaako historia itseään 5000 kanssa.

Charun

Tukijäsen

- Liittynyt

- 03.09.2018

- Viestejä

- 2 448

Juu, itellä meni myös ihan hyvin 1440p 144Hz näytön kanssa julkkarissa tilatulla 3080:lla, mutta 4K 120Hz joutu omaan makuun karsimaan liikaa silmäkarkkia, niin menin sitten P2W taktiikalla ja tilasin 4090 FE:n.  Eipä oo kyllä pelatessa kaduttanut pätkääkään.

Eipä oo kyllä pelatessa kaduttanut pätkääkään.

Eipä oo kyllä pelatessa kaduttanut pätkääkään.

Eipä oo kyllä pelatessa kaduttanut pätkääkään. 1080p 3080Ti jaksaa varmaan herran vuoteen ~2028Aivan juu. En tuota 4K:ta osannut ajatellaItse pelaan edelleen 1080p:llä.

Mulla viimeinen 1080p näyttö oli 2014-2015 paikkeilla sen aikainen lippulaiva Eizo Foris FG2421 120hz 5000:1 kontrastilla, oli jokaisen euron arvoinen

- Liittynyt

- 17.10.2016

- Viestejä

- 6 820

Nooh harkinnassa on kunhan joskus tänne Suomeenkin saadaan myyntiin niin 3440x1440 QD-OLED1080p 3080Ti jaksaa varmaan herran vuoteen ~2028

Mulla viimeinen 1080p näyttö oli 2014-2015 paikkeilla sen aikainen lippulaiva Eizo Foris FG2421 120hz 5000:1 kontrastilla, oli jokaisen euron arvoinen.

Uutiset

-

Uusi artikkeli: Testissä Samsung Galaxy Buds4 Pro -nappikuulokkeet

27.2.2026 14:37

-

VirtuStride kehittää ”VR-sandaaleja” joukkorahoituksella

27.2.2026 13:22

-

Live: io-techin Tekniikkapodcast (9/2026)

27.2.2026 12:13

-

Omdia: Samsung jatkaa Euroopan älypuhelinten ykkösenä ennen Applea ja Xiaomia

26.2.2026 23:31

-

SK Hynix ja SanDisk aloittivat HBF-muistien standardoinnin

26.2.2026 23:14