bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 4 127

No sehän on AMD:n ehtojen aiheuttama ongelma ihan yhtä lailla, jos tästä johtuu DLSS tuen puute AMD peleissä. Miksi ei voisi sallia myös kilpailijan logon vilahtamista splash screenissä. Sehän on ihan normaali käytäntö, että jos käytetään 3:n osapuolen kehittämää ja omistamaa tekniikkaa, niin mainitaan/annetaan credittiä.

Onkohan joku tutkinut jo, että näkyykö näissä harvassa DLSS:n sisältävässä AMD-sponssipelissä NVIDIA logoa splash screenissä tms.

Jos ei ole splash screenissä nvidiaa mainittu, niin voisi kuvitella, että on saatu NVIDIA:lta siunaus. Jos näkyy NVIDIA logot, niin sitten varmaan AMD:ltä anottu lupa.

Siitä saisi vähän osoittaa, että kumman konttorin myötävaikutuksella se DLSS on saatu kehiin.

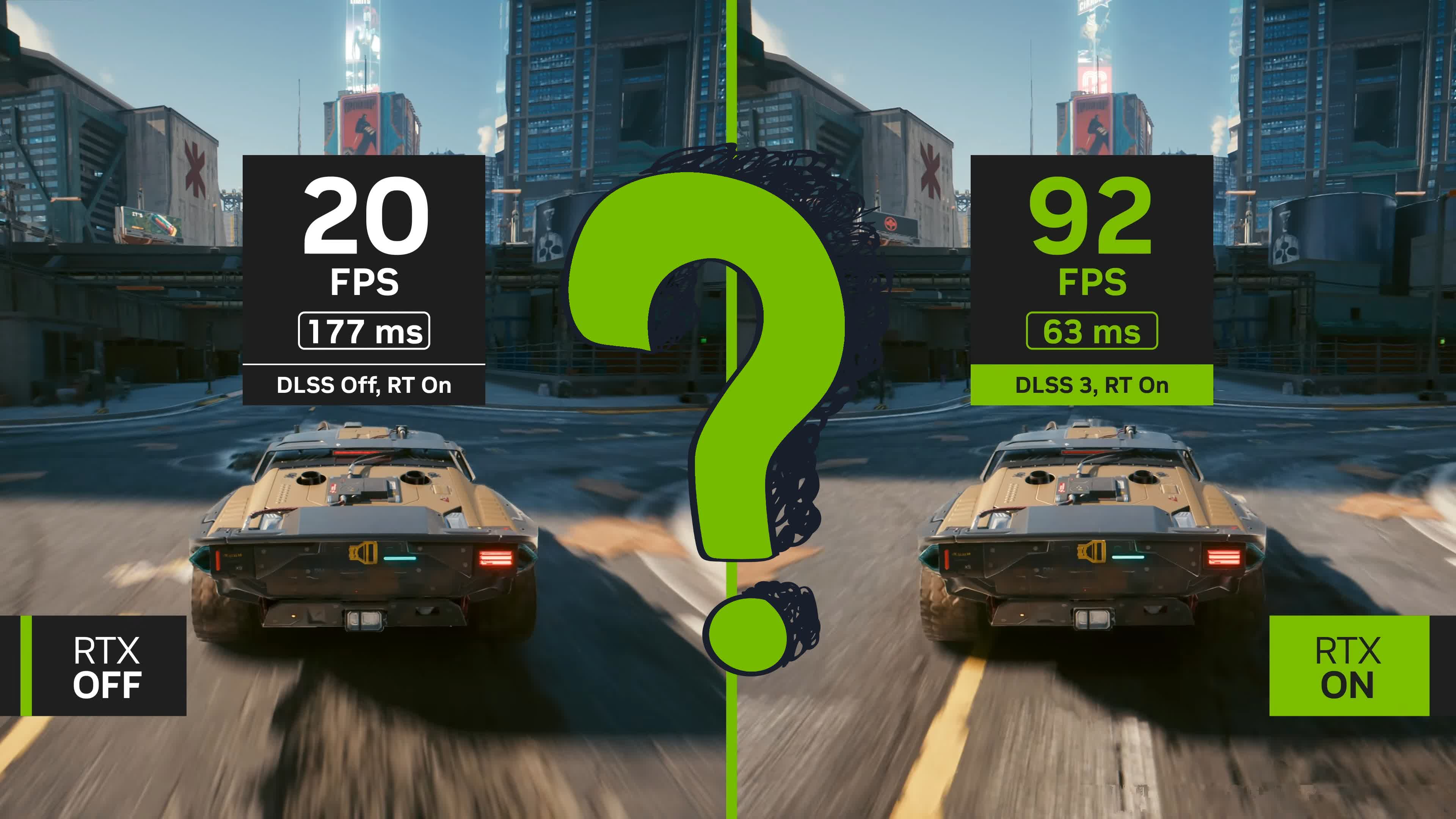

Mitään teknistä haastetta tai ongelmaa DLSS:n puuttumiseen ei kyllä todennäköisesti löydy, vaikka jotkut sitä tuntuu koko ajan vänkäävän. Molemmat tekniikat perustuu samoihin perusjuttuihin ja jos toisen lisää, niin ei se toisen tuominen ihmeitä vaadi. Senhän näkee jo siitä, että näitä community patchejä tulee saman tein saataville.

Miksi ihmeessä AMD sposoroisi Nvidian mainosta?

Ei kai siitä oikeasti kukaan voi suuttua jos sponsorointiehdoissa on että kilpailijaa ei saa mainostaa?