...Ja taas Intel on keinotekoisesti rajoittanut muistikertoimen noston pelkästään Z-sarjan emolevyille. AMD:llä rajoitus on ainoastaan niissä kaikkein halvemmissa A320-emolevyissä, jossa on säästetty kaikesta muustakin. Tämä on sitä perseilyä, jota Intel harrastaa ja jo ihan sen takia on mukava kokeilla AMD:tä välillä.

Onneksi, tällä hetkellä ei ole rajoitettu kerroinlukittujen prosessorien muistien kellotusta. Nyt halvimmat Z370-emolevyt ovat sellaista kuraa, että en ostaisi niihin K-mallia ollenkaan, vaan kerroinlukitun prosessorin ja ottaisin ne lisätehot kellottamalla muisteja.

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Virallinen: AMD vs Intel keskustelu- ja väittelyketju

- Keskustelun aloittaja Sampsa

- Aloitettu

Kyllä se on jännää kun jos vaikka kuin jne. On mulla sateenvarjo jos vaikka sataisi taivaalta.Jos huhuihin on uskomista niin ens vuoden alkupuolella Zen+ myötä pitäisi tulla 10% parannus kelloihin. Siihen päälle jos saadaan vielä IPC parannusta hieman niin ihan hyvältä tulevaisuus näyttää.

Zen2 sitten pitäisi alkaa päästä siihen 5GHz kerhoon kun GF sitä esitteissään ihan mainostaa.

Kun on jotain lihaa luitten päällä niin palataan asiaan.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Kyllä se on jännää kun jos vaikka kuin jne. On mulla sateenvarjo jos vaikka sataisi taivaalta.

Kun on jotain lihaa luitten päällä niin palataan asiaan.

Enkä AMD ei toimi kuten Intel ja ei julkaise vuosi toisensa jälkeen samaa prosessoria 7 vuoden ajan.

Taitaa Intelin fanipojilla alkaa totuus valkenemaan nyt miten teitä on kusetettu viimeiset 7 vuotta, johonkinhan se agressio täytyy purkaa.

TheMeII

Übertaktungspotenzial

- Liittynyt

- 13.11.2016

- Viestejä

- 7 353

- Liittynyt

- 30.10.2016

- Viestejä

- 85

Niin, liekö sitten parempi julkaista uusi prossu 7 vuoden välein vaiko julkaista vuosittain iteratiivisia päivityksiä, riippuu varmaan kuinka hyvin oma päivityssykli menee yhteen näiden julkaisujen kanssa. Nykyinen maisema prossuvalikoiman suhteen on ihan jees, AMD tarjoaa edullisia säikeitä niille jotka tietävät niitä käyttävänsä ja inteli tarjoaa tehoja lopuille, jokaiseen käyttöön löytyy markkinoilta oikea prossu. Ongelmaksi muodostuu se että täysin tarpeettomaan fanitukseen ryhtyvä jengi yrittää väkisin pakottaa väärää työkalua käyttötarkoitukseen "koska kilpailija on katsomatta paskaa".

- Liittynyt

- 16.10.2016

- Viestejä

- 3 209

AMD:n RAID-ajurit asentavan XAMP-stäkin koneelle ja pakan konffaus tapahtuu webbiselaimen kautta. Eli käytännössä saat ajureiden kylkiäisenä koneellasi pyörivän web-serverin, PHP:n sun muuta. Sen enempää en jaksanut katsoa, mutta tietoturvasta oli kaveri huolissaan.

Itseäni ainakin harmittaisi löytää PHP-tulkki koneelta.

Aika lähellä pahinta painajaista olisi itseasiassa kyseinen skenaario.

Aika lähellä pahinta painajaista olisi itseasiassa kyseinen skenaario.Deussu

Premium-jäsen

- Liittynyt

- 18.10.2016

- Viestejä

- 651

Saisiko jonkin yhteenvedon, niin ei tarvitse koko paskaa katsoa?

Päivällä tuon videon vilkaisseena, muistelisin siinä käytetyn 2400 muistikampoja, mutta 1333MHz CL8 asetuksilla. Eli molemmissa kokoonpanoissa ns. natiivikelloilla.Kuinka moni 2600K setti oikeesti kulkee 2400 muistilla. Pitää jo alkaa valikoimaan komponentteja. Kahvijärveä on ajettu "vain" 2666 muisteilla.

Jos molempiin laitettaisiin suurin piirtein nopeimmat tuetut eli vaikka 2133 CL9 ja 4000 CL18, niin pienellä varauksella uskon, että kahvijärven etumatka jonkin verran kasvaisi. Toki riippuen testattavista softista, mutta tuntuu, että uudemmat alustat (valmistajasta riippumatta) hyötyvät enemmän nopeammasta muistista.

On useammalla foorumilla nähty kun Amd marakatit ovat vetäneet herneen nenään kun i5 8400 pesee peleissä itseään yli puolet kalliimman jumal prossun Ryzen 1800X.Enkä AMD ei toimi kuten Intel ja ei julkaise vuosi toisensa jälkeen samaa prosessoria 7 vuoden ajan.

Taitaa Intelin fanipojilla alkaa totuus valkenemaan nyt miten teitä on kusetettu viimeiset 7 vuotta, johonkinhan se agressio täytyy purkaa.

Tässä kieltämättä vähän provon makua. Ei Ryzen huono ole, tarkennuksena.

En fanita Intelin prossuja vaan nopeinta peli prossua. Se on tilanne tällä hetkellä.

Juu, kummassakin natiivi kellot. Olisi pitänyt huomata.Päivällä tuon videon vilkaisseena, muistelisin siinä käytetyn 2400 muistikampoja, mutta 1333MHz CL8 asetuksilla. Eli molemmissa kokoonpanoissa ns. natiivikelloilla.

Jos molempiin laitettaisiin suurin piirtein nopeimmat tuetut eli vaikka 2133 CL9 ja 4000 CL18, niin pienellä varauksella uskon, että kahvijärven etumatka jonkin verran kasvaisi. Toki riippuen testattavista softista, mutta tuntuu, että uudemmat alustat (valmistajasta riippumatta) hyötyvät enemmän nopeammasta muistista.

Eiköhän tuossa ens kuussa jo tule testattu vanhempia pelejä kuinka nopeampi muisti auttaa kahvijärven osalta.

Viimeksi muokattu:

- Liittynyt

- 12.12.2016

- Viestejä

- 3 930

On useammalla foorumilla nähty kun Amd marakatit ovat vetäneet herneen nenään kun i5 8400 pesee peleissä itseään yli puolet kalliimman jumal prossun Ryzen 1800X.

Tässä kieltämättä vähän provon makua. Ei Ryzen huono ole, tarkennuksena.

En fanita Intelin prossuja vaan nopeinta peli prossua. Se on tilanne tällä hetkellä.

Tuo 8400 pesee peleissä myös Intelin 2000 dollarin prosessorin

Parempi verrokki kuin 1800X olisi 1600X.

Parempi verrokki kuin 1800X olisi 1600X.Tähän on kyllä todettava, ettet vain olisi sinä, joka et ole noihin taustoihin tutustunut. On nimittäin aika hemmetin moneen kertaan todistettu myös se, että nuo miniresot oikeasti kuvaa tulevaisuutta tulevilla laitteilla/peleillä kunnolla ja päinvastoin jos historiaa tunnetaan, tulee tuo ero vain vähenemään.

Perustan väitteeni omiin käytännön kokemuksiini ja toisaalta lukemattomiin testituloksiin. 99% testeistä tehdään maksimiasetuksilla, johon vain osalla pelaajista on mahdollisuus. Se antaa väärän kuvan CPU:n tehoista, koska GPU:n vaikutus korostuu maksimidetaileilla merkittävästi.

Käytän 1440p resoluutiota peleissä. FPS-peleissä haluan saada frame raten mahdollisimman korkealle. Otetaan esimerkkinä BF1, joka kuvaa hyvin nykypeliä. Pudotan detaileita, kunnes GPU (1070) ei enää ole pullonkaula (eli FPS ei enää nouse). Tämän jälkeen detaileiden pudottaminen ei enää vaikuta oikeastaan mitenkään, koska CPU ei pysy mukana. Frame rate droppien takia päivitin i5 4670K => i7 4790K, jolloin keskimääräinen FPS nousi noin 30 ja nykiminen väheni merkittävästi. Minimi-FPS nousi myös 70=>100. Tuo on huikea ero pelkästään lisäthreadeillä. Vastaava vaikutus näkyy kellotaajuutta nostamalla eikä frame raten kasvulle näytä tulevan loppua.

On turha katsoa 1440p ultra-testejä, joiden mukaan CPU:t omat saman vertaisia. Eivät ne olisi, jos GPU ei olisi jatkuvasti 100% kuormalla! Viisi vuotta sitten oli GTX 680, nyt GTX 1080 Ti. Tässä ajassa on tapahtunut huima kehitys. Viiden vuoden päästä GPU ei ole enää selkeä pullonkaula 1440p/4K resoilla, vaan se on 8700K, 1800X tai mikä ikinä nyt sattuukaan olemaan valittu kokoonpanoon. 720p-testit kertovat, minkälainen potentiaali CPU:lla on. Valitsemalla 720p-testien perusteella paras CPU on todennäköistä, että se pysyy jatkossa paremmin uusien näytönohjainten mukana.

Jos on vähäänkään seurannut tekniikan kehitystä, on huomannut miten GPU-rintamalla asiat etenevät huomattavasti ripeämpään tahtiin. Kukaan ei lesoile viisi vuotta vanhalla GPU:lla, mutta 2600K:lla moni pärjää vielä hyvin. Peli alkavat vähitellen tukea lisäytimiä, mutta GPUiden laskentateho tulee omien arvioideni mukaan kasvamaan nopeammin.

Kakista nyt vaan selvästi ulos et i5 8400 on hyvä peli prossuksi.Tuo 8400 pesee peleissä myös Intelin 2000 dollarin prosessorinParempi verrokki kuin 1800X olisi 1600X.

Väitteet 720p pelitestien hyödyllisyydestä perustuvat kahteen oletukseen:

1. Tulevaisuuden pelit käyttävät yhtä huonosti ytimiä kuin nykyiset

2. Tulevaisuudessa näytönohjaimien tehot kasvavat huimasti

Vaihtoehto 1 jää nähtäväksi, vaihtoehto 2 ei tule toteutumaan.

Pelit tulevat skaalautumaan paremmin kellotaajuuden kuin ytimien mukaan. Tietyn rajan jälkeen lisäytimet eivät enää vaikuta (laskenta ei rinnakkaistu), mutta kellotaajuuden kasvattaminen parantaa aina suorituskykyä.

Jälkimmäisen väitteen kanssa olen eri mieltä historian perusteella (esim. viimeinen 10 vuotta). Mihin perustat oman väitteesi?

- Liittynyt

- 10.01.2017

- Viestejä

- 365

Jos nyt hankin 8700K:n olettaen, että siitä riittää seuraavaksi 3-5 vuodeksi prosessori pääosin pelikäyttöön, tulenko pettymään? Hakkaako suoritinkäyttö mahdollisesti lähelle 100% kuten edellisen generaation yksilöillä? Viimeisimmässä setupissa 6600K oli pullonkaulana, mutta onko tilanne muuttunut lisäytimien myötä?

- Liittynyt

- 21.07.2017

- Viestejä

- 676

rinnakkaisajo windowsissa on edelleenkin purkkaa ja teippiä

eikä tule siitä miksikään muuttumaan ellei ms aloita ytimen kanssa täysin alusta

joten tulevien pelienkin useamman ytimen käyttö tulee olemaan purkkaa ja teippiä, tyyliin ajanpa nyt lehmän ai.tä tuolla toisella ytimellä, joka ei sitä oikeata moniajoa ole eikä siis tule windowssissa olemaankaan

eikä tule siitä miksikään muuttumaan ellei ms aloita ytimen kanssa täysin alusta

joten tulevien pelienkin useamman ytimen käyttö tulee olemaan purkkaa ja teippiä, tyyliin ajanpa nyt lehmän ai.tä tuolla toisella ytimellä, joka ei sitä oikeata moniajoa ole eikä siis tule windowssissa olemaankaan

- Liittynyt

- 12.12.2016

- Viestejä

- 3 930

On turha katsoa 1440p ultra-testejä, joiden mukaan CPU:t omat saman vertaisia. Eivät ne olisi, jos GPU ei olisi jatkuvasti 100% kuormalla! Viisi vuotta sitten oli GTX 680, nyt GTX 1080 Ti. Tässä ajassa on tapahtunut huima kehitys. Viiden vuoden päästä GPU ei ole enää selkeä pullonkaula 1440p/4K resoilla, vaan se on 8700K, 1800X tai mikä ikinä nyt sattuukaan olemaan valittu kokoonpanoon. 720p-testit kertovat, minkälainen potentiaali CPU:lla on. Valitsemalla 720p-testien perusteella paras CPU on todennäköistä, että se pysyy jatkossa paremmin uusien näytönohjainten mukana.

Jos on vähäänkään seurannut tekniikan kehitystä, on huomannut miten GPU-rintamalla asiat etenevät huomattavasti ripeämpään tahtiin. Kukaan ei lesoile viisi vuotta vanhalla GPU:lla, mutta 2600K:lla moni pärjää vielä hyvin. Peli alkavat vähitellen tukea lisäytimiä, mutta GPUiden laskentateho tulee omien arvioideni mukaan kasvamaan nopeammin.

Vai viiden vuoden päästä GPU ei ole selkeä pullonkaula 4K resolla

Jos olet vähänkään seurannut tekniikan kehitystä, huomaisit kuinka näytönohjaimien kehityksessä on pitkälti otettu löysät pois eikä kehitystä ole juurikaan tapahtunut. Nvidia julkaisi Maxwellin 4 vuotta sitten. Sen jälkeen ei ole tapahtunut juuri muuta kuin päivitys 28nm valmistustekniikasta 16nm valmistustekniikkaan. Maxwellia voisi melkein (ei kuitenkaan ihan) kuvata Nvidian 2500K:ksi, sillä päästiin melko korkealle perustasolle ja sen jälkeen ei ole enää tarjolla taikatemppuja jolla ottaa sormia napsauttamalla kymmenien prosenttien lisäyksiä valmistustekniikan parannusten ulkopuolelta.

Kakista nyt vaan selvästi ulos et i5 8400 on hyvä peli prossuksi.

Minun mielestäni Ryzen on kokonaisuutena parempi peli.

Pelit tulevat skaalautumaan paremmin kellotaajuuden kuin ytimien mukaan. Tietyn rajan jälkeen lisäytimet eivät enää vaikuta (laskenta ei rinnakkaistu), mutta kellotaajuuden kasvattaminen parantaa aina suorituskykyä.

Jälkimmäisen väitteen kanssa olen eri mieltä historian perusteella (esim. viimeinen 10 vuotta). Mihin perustat oman väitteesi?

Riittää kuin pelit alkavat käyttämään paremmin ytimiä ja silloin 720p testien hyödyllisyys lähentelee nollaa. Mantle (johon DirectX 12 ja Vulkan perustuvat) on tässä asiassa todella suuressa roolissa.

Väitteeni perustuu pääasiassa kahteen asiaan:

1. Valmistustekniikassa ei tulla tekemään yhtä suurta harppausta kuin 28nm->14/16nm oli, joka automaattisesti hidastaa kehitystä. Lisäksi valmistustekniset parannukset ovat yhä vaikeampia toteuttaa eikä niillä saada yhtä paljoa hyötyä kuin aikaisemmin.

2. Kuten ylempänä sanoin, näytönohjaimien puolella ollaan päästy tilanteeseen jossa suurta kehitystä ei helposti saa. Riittää kun katselet mitä Nvidia on saanut arkkitehtuurin puolella aikaan 4 vuodessa (Maxwell->Pascal). Ei oikeastaan mitään merkittävää.

Siksi historian perusteella näytönohjaimet eivät tule huikeasti kehittymään lähivuosina.

- Liittynyt

- 21.07.2017

- Viestejä

- 676

Vai viiden vuoden päästä GPU ei ole selkeä pullonkaula 4K resollaKyllä nyt tulee niin tuuheaa settiä ettei mitään tolkkua.

Jos olet vähänkään seurannut tekniikan kehitystä, huomaisit kuinka näytönohjaimien kehityksessä on pitkälti otettu löysät pois eikä kehitystä ole juurikaan tapahtunut. Nvidia julkaisi Maxwellin 4 vuotta sitten. Sen jälkeen ei ole tapahtunut juuri muuta kuin päivitys 28nm valmistustekniikasta 16nm valmistustekniikkaan. Maxwellia voisi melkein (ei kuitenkaan ihan) kuvata Nvidian 2500K:ksi, sillä päästiin melko korkealle perustasolle ja sen jälkeen ei ole enää tarjolla taikatemppuja jolla ottaa sormia napsauttamalla kymmenien prosenttien lisäyksiä valmistustekniikan parannusten ulkopuolelta.

Minun mielestäni Ryzen on kokonaisuutena parempi peli.

Riittää kuin pelit alkavat käyttämään paremmin ytimiä ja silloin 720p testien hyödyllisyys lähentelee nollaa. Mantle (johon DirectX 12 ja Vulkan perustuvat) on tässä asiassa todella suuressa roolissa.

Väitteeni perustuu pääasiassa kahteen asiaan:

1. Valmistustekniikassa ei tulla tekemään yhtä suurta harppausta kuin 28nm->14/16nm oli, joka automaattisesti hidastaa kehitystä. Lisäksi valmistustekniset parannukset ovat yhä vaikeampia toteuttaa eikä niillä saada yhtä paljoa hyötyä kuin aikaisemmin.

2. Kuten ylempänä sanoin, näytönohjaimien puolella ollaan päästy tilanteeseen jossa suurta kehitystä ei helposti saa. Riittää kun katselet mitä Nvidia on saanut arkkitehtuurin puolella aikaan 4 vuodessa (Maxwell->Pascal). Ei oikeastaan mitään merkittävää.

Siksi historian perusteella näytönohjaimet eivät tule huikeasti kehittymään lähivuosina.

mikään ei hidasta kehitystä yhtä paljon kuin ahneus, jo nyt voitaisiin tehdä 4nm viivalla jos tahtoa löytyisi, mutta eipä löydy

käsittääkseni ja muistaakseni eri tekniikoillla päästäisiin jo koko viivanleveyden rajoittavasta tekijästä eroon, mutta tahtoa tähän ei jostain syystä ole

valoa käyttävä kytkinhän keksittiin jo vuosia sitten

- Liittynyt

- 17.10.2016

- Viestejä

- 10 719

Pelit tulevat skaalautumaan paremmin kellotaajuuden kuin ytimien mukaan. Tietyn rajan jälkeen lisäytimet eivät enää vaikuta (laskenta ei rinnakkaistu), mutta kellotaajuuden kasvattaminen parantaa aina suorituskykyä.

Jälkimmäisen väitteen kanssa olen eri mieltä historian perusteella (esim. viimeinen 10 vuotta). Mihin perustat oman väitteesi?

Tämä on pitänyt ennen paikkansa, mutta sekä Intel että AMD huomasivat tuon tien käytännössä käytetyn loppuun ja alkoivat panostaa useampaan ytimeen. Nykyisin (esim. viimeiset 17 vuotta) huomaa että suurin osa peleistä tukee useampaa ydintä ja yllättävän moni peli ei enää toimi kunnolla vain yhden ytimen prosessorilla.

Esim. 6v vanha 2600K prosessori kellottui itselläni 5GHz. Nyt siis JOS sinun hypoteesisi pitäisi paikkansa meillä pitäisi olla jo lähelle tai yli vähintään 7 ehkä 10GHz kellottuvaa 1, maksimissaan 2-ytimen prosessoria pelaamiseen. Eikö totta?

Myös keskusmuistin sekä kovalevytilan tarve ovat kasvaneet, katsoen viimeistä 17 tai edes 10 vuotta varmaankin huomaat että harvempi peli enää tyytyy esim. noin yhden CD:n asennustilaan, eli noin 650-700mb ja useampi peli vaatii myös enemmän kuin 1Gb keskusmuistia.

Samaten kun katsoo direct X vaatimuksia harvempi uusista peleistä enää listaa esim. DX6, 7, 8 tai edes 9 vaan yleensä DX11 tai 12 mitkä tukevat jo paremmin useampaa ydintä.

Mihin perustat oman väitteesi että esim. nestetypellä jäähdytetty 1-ytimen prosessori olisi se graalin malja pelaamista ajatellen?

Mihin perustat oman väitteesi että esim. nestetypellä jäähdytetty 1-ytimen prosessori olisi se graalin malja pelaamista ajatellen?

Sitä en ole väittänyt, etteikö ytimien lisäämisellä olisi mitään vaikutusta. Ytimien lisääminen voi vaikuttaa pelin suorituskykyyn tiettyyn rajaan asti, mutta kellotaajuuden kasvattaminen aina.

Oletetaan, että GPU:n suorituskyky on ääretön, CPU:ssa on ääretön määrä ytimiä ja kellotaajuus 5 GHz. Testipelinä voi toimia mikä vaan. Aloitetaan sillä, että CPU:ssa on vain yksi core käytössä ja sitten uusia coreja otetaan käyttöön yksi kerrallaan. Seurataan, miten keskimääräinen ja 99% persentiili FPS muuttuvat. Ennen pitkää coreja aktivoitaessa tulee eteen tilanne, jossa FPS ei enää kasva (voi käydä jopa päin vastoin). Mitä enemmän coreja saatiin aktivoitua sitä paremmin voidaan ajatella pelin osaavan rinnakkaistaa laskentaa.

Kun tuo corejen maksimi on saavutettu, voidaan silti todeta ylikellottamisen nostavan FPS:ää.

Miksi näin? En ole pelikehittäjä, mutta sovelluskoodin optimointi on tuttua. Jotta pelissä tai missä tahansa reaaliaikasovelluksessa halutaan täysi hyöty moniydinprosessorista, täytyy laskentaa rinnakkaistaa. Jos coreja on käytössä ääretön määrä olisi ideaalista, jos kaikki mahdollinen suoritus rinnakkaistuisi rajatta. Pohjimmiltaan pelissä on kuitenkin "pääluuppi", joka ei rinnakkaistu. Pelin osaongelmia voidaan laskea yksittäin rinnakkain usealla ytimellä, mutta lopulta osatulokset täytyy suorittaa peräkkäin lopputulosta kootessa. Tuon pääluupin suoritusta voidaan silti parantaa CPU:n kellotaajuutta nostamalla ja samalla sillä on suotuisa vaikutus osaongelmien laskentaa.

Yksinkertaisuudessaan tarkoitin sitä, että kellotaajuuden nostolla on reaaliaikasovellukseen aina positiivinen vaikutus. Tämä olettaen, ettei jokin muu komponentti muutu pullonkaulaksi.

- Liittynyt

- 16.12.2016

- Viestejä

- 903

Windows ajaa peliä/ softaa juuri niin kuin sen ovat softan/ pelin kehittäjät luoneet. Ei yhtään sen paremmin tai huonommin.rinnakkaisajo windowsissa on edelleenkin purkkaa ja teippiä

eikä tule siitä miksikään muuttumaan ellei ms aloita ytimen kanssa täysin alusta

joten tulevien pelienkin useamman ytimen käyttö tulee olemaan purkkaa ja teippiä, tyyliin ajanpa nyt lehmän ai.tä tuolla toisella ytimellä, joka ei sitä oikeata moniajoa ole eikä siis tule windowssissa olemaankaan

Pelkkä viivan leveyden muutos sellaisenaan ei tuo yhtään lisätehoja tai kelloja.mikään ei hidasta kehitystä yhtä paljon kuin ahneus, jo nyt voitaisiin tehdä 4nm viivalla jos tahtoa löytyisi, mutta eipä löydy

käsittääkseni ja muistaakseni eri tekniikoillla päästäisiin jo koko viivanleveyden rajoittavasta tekijästä eroon, mutta tahtoa tähän ei jostain syystä ole

Noissa todella pienissä nm on todellakin omat ongelmansa eikä kyse ole tahdosta (esim. vuotovirrat kasvavat rajusti, eli myös esim. "transistorin" tyyppiä pitää myös muuttaa).

- Liittynyt

- 17.10.2016

- Viestejä

- 25 463

Windows ajaa peliä/ softaa juuri niin kuin sen ovat softan/ pelin kehittäjät luoneet. Ei yhtään sen paremmin tai huonommin.

OT: Windowsissa on käyttöjärjestelmän tarjoamat threadit, jotka eivät ole sama asia kuin esim. *nix-maailmassa käytetyt POSIX-threadit. Joku Intelin kaveri kyllä tykkää ylistää niitä:

Why Windows Threads Are Better Than POSIX Threads | Intel® Software

Windowsin scheduleri myös vastaa siitä, miten noi threadit menee ajoon, niin pieni pelinkehittäjä voi vaan toivoa, että ne menee oikein. Jopa minä olisin osannut ottaa Bulldozerista enemmän irti, jos olisin pystynyt kontrolloimaan, miten ne threadit jakautuu. Käytännössä pitäisi saada threadit menemään eri moduuleille, jos niitä on vähäinen määrä.

- Liittynyt

- 21.07.2017

- Viestejä

- 676

Windows ajaa peliä/ softaa juuri niin kuin sen ovat softan/ pelin kehittäjät luoneet. Ei yhtään sen paremmin tai huonommin.

Pelkkä viivan leveyden muutos sellaisenaan ei tuo yhtään lisätehoja tai kelloja.

Noissa todella pienissä nm on todellakin omat ongelmansa eikä kyse ole tahdosta (esim. vuotovirrat kasvavat rajusti, eli myös esim. "transistorin" tyyppiä pitää myös muuttaa).

windows ei pysty todelliseen moniajoon jossa siis yksi tehtävä ajetaan kahdella tai useammalla ytimellä jolloin suorituskyky tai nopeus on kerrannollinen ytimien määrän kanssa

mainitsinkin tuossa valolla toimivan kytkimen

Jos olet vähänkään seurannut tekniikan kehitystä, huomaisit kuinka näytönohjaimien kehityksessä on pitkälti otettu löysät pois eikä kehitystä ole juurikaan tapahtunut. Nvidia julkaisi Maxwellin 4 vuotta sitten. Sen jälkeen ei ole tapahtunut juuri muuta kuin päivitys 28nm valmistustekniikasta 16nm valmistustekniikkaan. Maxwellia voisi melkein (ei kuitenkaan ihan) kuvata Nvidian 2500K:ksi, sillä päästiin melko korkealle perustasolle ja sen jälkeen ei ole enää tarjolla taikatemppuja jolla ottaa sormia napsauttamalla kymmenien prosenttien lisäyksiä valmistustekniikan parannusten ulkopuolelta.

Arkkitehtuurisella tasolla ei varmaan mitään merkittävää, mutta suorituskyky kuitenkin +50% tai 980Ti ja 1080Ti tapauksessa enemmänkin 70-80%. Mun mielestä suht merkittävä parannus (puhumattakaan hyötysuhteesta), kuten oli myös Kepler -> Maxwell, vaikka valmistustekniikka sama 28nm. Tästä eteenpäin saattaa tosin tulla haastavammaksi, kun valmistustekniikka kyntää ja kellot on jo melko huipussa näyttisarkkitehtuureille. Mutta kummsti sitä vaan jostain aina kaivetaan...2. Kuten ylempänä sanoin, näytönohjaimien puolella ollaan päästy tilanteeseen jossa suurta kehitystä ei helposti saa. Riittää kun katselet mitä Nvidia on saanut arkkitehtuurin puolella aikaan 4 vuodessa (Maxwell->Pascal). Ei oikeastaan mitään merkittävää.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Pelit tulevat skaalautumaan paremmin kellotaajuuden kuin ytimien mukaan. Tietyn rajan jälkeen lisäytimet eivät enää vaikuta (laskenta ei rinnakkaistu), mutta kellotaajuuden kasvattaminen parantaa aina suorituskykyä.

Entäs kun kellotaajuus katto on jo saavutettu Intelin kohdalla? Niin kyllä se 5GHz on ollut jo monta vuotta se maaginen luku. 2011Q1 julkaistiin 2600K joka tuohon maagiseen lukuun jo ylti. Se huomattiin jo yli vuosikymmen sitten kun oli käynnissä clockwars että se raja tulee vastaan. Taidettiin tuon clockwarsin aikana myös sitä 5GHz hätyytellä jos en väärin muista. Nyt Intelillä ei ole mitään muuta tietä kuin corejen lisääminen. AMD:llä on vielä vähän varaa noissa kelloissa mutta eiköhän se 2019 viimeistään ole AMD:n osalta myös toi kellojen nosto katsottu loppuun.

Clock for clock IPC nosto on toinen millä sitä tehoa saadaan lisää mutta siinäkään ei ole oikein enää mitään kehitystä tapahtunut.

- Liittynyt

- 16.12.2016

- Viestejä

- 903

Windows ei pysty itse säikeisiin vaikuttamaan (esim. siihen miten merkittäviä ne on). Se vain jaa ne mielensä mukaan samanlaisille ytimille.Windowsin scheduleri myös vastaa siitä, miten noi threadit menee ajoon, niin pieni pelinkehittäjä voi vaan toivoa, että ne menee oikein.

Jopa minä olisin osannut ottaa Bulldozerista enemmän irti, jos olisin pystynyt kontrolloimaan, miten ne threadit jakautuu. Käytännössä pitäisi saada threadit menemään eri moduuleille, jos niitä on vähäinen määrä.

Ei täysin suoraan, vain tiettyyn rajaan asti (kaikkea ei edes voi rinnakkaistaa). Joka tuo olennaisesti koodaajalle lisää työtä. Ja etu on usein mitätön esim. yli 4- pääsäikeen jälkeen.windows ei pysty todelliseen moniajoon jossa siis yksi tehtävä ajetaan kahdella tai useammalla ytimellä jolloin suorituskyky tai nopeus on kerrannollinen ytimien määrän kanssa

Esim. DX12: sta eri säikeet määrittelee softan koodaaja.

- Liittynyt

- 10.03.2017

- Viestejä

- 654

Voi luoja, te ja teidän käytännön kokemukset. Mä näytän sulle käytännön kokemuksen, otetaa vaikka Phenom II 945 ja Core duo E8400. Näistä jälkimmäinen voitti vaivattomasti kaikki pienen resoluution testit aikoinaan, mutta vain toisella kykenee pelaamaan nykyisin Rise of Tombraideria uudemman näyttiksen kanssa, aika kummallista jos kerran "ero vain kasvaa". Voit tarkistaa asian, mutta älä mene siiihen Youtubevideoon, jossa se vetää jälkimmäisellä vain siperian wildsiä, se kun hyytyy 10 fps alle kun päästää soviet installatioon.Perustan väitteeni omiin käytännön kokemuksiini ja toisaalta lukemattomiin testituloksiin. 99% testeistä tehdään maksimiasetuksilla, johon vain osalla pelaajista on mahdollisuus. Se antaa väärän kuvan CPU:n tehoista, koska GPU:n vaikutus korostuu maksimidetaileilla merkittävästi.

Otanko toisen esimerkin, jossa 955 ja 1100t olivat samoissa lukemissa pelitesteissä ja 1100t otti itseasiassa turpaan pikkuresoilla. Vaan tarvitseeko edes sanoa, kumpi näistä kyntää 35fps RoTR:ssa ja kummalla pääsee 50 fps lukemiin? Mitenkä nykyvehkeet sitten kehtaatko edes väittää että 7700K, joka vetelee +95% käyttöasteella 5 fps (<<5%) enemmän, kun esim. 1700 75% käyttöasteella tai 1800x 65% käyttöasteella, olisi se tulevaisuudessa parempi?

Kannattaa tosiaan katsoa vähän jotain muutakin, kuin sitä vääristynyttä tilastoa. Olisikohan se miten vaikeaa saada IO-techinkin prossussuje pelitesteihin huomiota tuosta käyttöasteesta?

Eli jos esim. W3 tekee kuin se tekee, eli käytännössä käyttää raskaasti paria kolmea threadia ja osa pyörii 10-20% nurkilla, niin olisihan tuo aika merkittävä asia ottaa huomioon. Etenkin kun tuosta optimointiongelmasta tulee kerrannaisvaikutuksia tämän "turboamisen" myötä testissä.

Eli jos esim. W3 tekee kuin se tekee, eli käytännössä käyttää raskaasti paria kolmea threadia ja osa pyörii 10-20% nurkilla, niin olisihan tuo aika merkittävä asia ottaa huomioon. Etenkin kun tuosta optimointiongelmasta tulee kerrannaisvaikutuksia tämän "turboamisen" myötä testissä.- Liittynyt

- 16.04.2017

- Viestejä

- 1 439

Vähän hölmöä teoreettista spekulointia tällainen. Toki nopeammat kellot auttavat, mutta kun mitään merkittävää hyppäystä ei enää tule, ei vaikka viivanleveyttä pienennettäisiin. Ongelmana ei ole enää pelkästään lämmön poisjohtaminen vaan kutistamisen myötä yhä merkittävämmäksi tulevat fysikaaliset epävarmuudet ja signaalivuodot. Nämä ennustavat pikkuhiljaa nykyisen valmistustekniikan lakipistettä.Sitä en ole väittänyt, etteikö ytimien lisäämisellä olisi mitään vaikutusta. Ytimien lisääminen voi vaikuttaa pelin suorituskykyyn tiettyyn rajaan asti, mutta kellotaajuuden kasvattaminen aina.

Oletetaan, että GPU:n suorituskyky on ääretön, CPU:ssa on ääretön määrä ytimiä ja kellotaajuus 5 GHz. Testipelinä voi toimia mikä vaan. Aloitetaan sillä, että CPU:ssa on vain yksi core käytössä ja sitten uusia coreja otetaan käyttöön yksi kerrallaan. Seurataan, miten keskimääräinen ja 99% persentiili FPS muuttuvat. Ennen pitkää coreja aktivoitaessa tulee eteen tilanne, jossa FPS ei enää kasva (voi käydä jopa päin vastoin). Mitä enemmän coreja saatiin aktivoitua sitä paremmin voidaan ajatella pelin osaavan rinnakkaistaa laskentaa.

Kun tuo corejen maksimi on saavutettu, voidaan silti todeta ylikellottamisen nostavan FPS:ää.

Miksi näin? En ole pelikehittäjä, mutta sovelluskoodin optimointi on tuttua. Jotta pelissä tai missä tahansa reaaliaikasovelluksessa halutaan täysi hyöty moniydinprosessorista, täytyy laskentaa rinnakkaistaa. Jos coreja on käytössä ääretön määrä olisi ideaalista, jos kaikki mahdollinen suoritus rinnakkaistuisi rajatta. Pohjimmiltaan pelissä on kuitenkin "pääluuppi", joka ei rinnakkaistu. Pelin osaongelmia voidaan laskea yksittäin rinnakkain usealla ytimellä, mutta lopulta osatulokset täytyy suorittaa peräkkäin lopputulosta kootessa. Tuon pääluupin suoritusta voidaan silti parantaa CPU:n kellotaajuutta nostamalla ja samalla sillä on suotuisa vaikutus osaongelmien laskentaa.

Yksinkertaisuudessaan tarkoitin sitä, että kellotaajuuden nostolla on reaaliaikasovellukseen aina positiivinen vaikutus. Tämä olettaen, ettei jokin muu komponentti muutu pullonkaulaksi.

Toisekseen ei sen sovelluskoodaajan aina tarvitse stressaa kuinka se sovellus rinnakkaistuu. Jo nykyään prosessoreihin tungetaan vaikka minkälaisia data-analytiikasta tuttuja ennustusalgoritmeja, likuhihnojen optimointia, superskaalarius ollut arkipäivää pitkän aikaa yhdistettynä ooo:ihin ja rekisterikikkailuihin. Näillä kaikilla pyritään syöttämään prosessoria mahdollisimman tehokkaasti, jotta sen nopeuspotentiaali saadaan hyötykäyttöön. Tämän ansiosta se toisen prossun 3,5GHz voikin olla nopeampi kuin toisen 4,5GHz, eikä koodaajan tarvitse ymmärtää tästä välttämättä höpöäkään. Riitää kun on uusimmat kääntäjät käytössä.

Mutta lähtemättä paasaamaan enempää, niin kellotaajuuksien katto on aika lailla pian saavutettu ja niin myös isoimmat prosessoreiden sisäiset perusoptimoinnit, minkä takia ainoa tapa jatkossa tuottaa lisää laskentatehoa on kasvattaa rinnakkaisuutta...ja on sitten peleissä päälooppeja tai ei, niin niitä on pakko alkaa myös pilkkoa pienempiin osiin joko itse tai Vulkan/Dx12/tms. avulla tai sitä lisänopeutta ei ole tiedossa.

Voi luoja, te ja teidän käytännön kokemukset. Mä näytän sulle käytännön kokemuksen, otetaa vaikka Phenom II 945 ja Core duo E8400. Näistä jälkimmäinen voitti vaivattomasti kaikki pienen resoluution testit aikoinaan, mutta vain toisella kykenee pelaamaan nykyisin Rise of Tombraideria uudemman näyttiksen kanssa, aika kummallista jos kerran "ero vain kasvaa"

Tarkoitatko, että Rise of the Tomb Raider toimisi 720p:llä paremmin C2D E8400 kuin PII 945? Sitä en kyllä usko. Nuo 10 vuotta vanhat testit on tehty peleillä, jotka eivät osanneet hyödyntää neljää ydintä. Itse en uskaltaisi interpoloida testituloksia kuin muutaman vuoden eteenpäin. Pelit tukevat vähitellen useampia ytimiä, mutta tuota kehitystä voi vain arvailla. Nykyisillä peleillä testit kuitenkin osoittavat, että tykeimmissä CPUissa on hyvin reserviä jäljellä tulevaisuuteen, kun uudet GPU-sukupolvet tulevat markkinoille.

Vähän hölmöä teoreettista spekulointia tällainen. Toki nopeammat kellot auttavat, mutta kun mitään merkittävää hyppäystä ei enää tule, ei vaikka viivanleveyttä pienennettäisiin.

36 vuodessa PC:n kellotaajuus on tuhatkertaistettu. Kehitys kellotaajuuden suhteen ei todellakaan pysähdy maagisesti 5 GHziin vuonna 2017. Toki kellotaajuuden kasvu on hidastunut merkittävästi viime vuosina, mutta toisaalta yhteen kellojaksoon saadaan lisättyä enemmän laskentaa. Olisikin korrektimpaa puhua IPC:stä kun pelkästä kellotaajuudesta.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

36 vuodessa PC:n kellotaajuus on tuhatkertaistettu. Kehitys kellotaajuuden suhteen ei todellakaan pysähdy maagisesti 5 GHziin vuonna 2017. Toki kellotaajuuden kasvu on hidastunut merkittävästi viime vuosina, mutta toisaalta yhteen kellojaksoon saadaan lisättyä enemmän laskentaa. Olisikin korrektimpaa puhua IPC:stä kun pelkästä kellotaajuudesta.

Why Haven't CPU Clock Speeds Increased in the Last Few Years?

- Liittynyt

- 12.12.2016

- Viestejä

- 3 930

mikään ei hidasta kehitystä yhtä paljon kuin ahneus, jo nyt voitaisiin tehdä 4nm viivalla jos tahtoa löytyisi, mutta eipä löydy

käsittääkseni ja muistaakseni eri tekniikoillla päästäisiin jo koko viivanleveyden rajoittavasta tekijästä eroon, mutta tahtoa tähän ei jostain syystä ole

valoa käyttävä kytkinhän keksittiin jo vuosia sitten

Mikään ongelma ei olisi valmistaa selvästi nykyistä nopeampaa prosessoria. Ongelmat alkavat siinä vaiheessa kun sitä prosessoria pitäisi valmistaa kohtuullisella hinnalla muutama miljoona kappaletta.

Taloudellisesti ei mitään järkeä tehdä muutaman kappaleen supertuotetta koska silloin markkinat alkaisivat odottamaan millon se saapuu massamarkkinoille.

Arkkitehtuurisella tasolla ei varmaan mitään merkittävää, mutta suorituskyky kuitenkin +50% tai 980Ti ja 1080Ti tapauksessa enemmänkin 70-80%. Mun mielestä suht merkittävä parannus (puhumattakaan hyötysuhteesta), kuten oli myös Kepler -> Maxwell, vaikka valmistustekniikka sama 28nm. Tästä eteenpäin saattaa tosin tulla haastavammaksi, kun valmistustekniikka kyntää ja kellot on jo melko huipussa näyttisarkkitehtuureille. Mutta kummsti sitä vaan jostain aina kaivetaan...

980Ti vuoden 2011 valmistustekniikka ja 1080Ti vuoden 2016 valmistustekniikka. Siihen nähden hypyssä ei ollut mitään ihmeellistä.

36 vuodessa PC:n kellotaajuus on tuhatkertaistettu. Kehitys kellotaajuuden suhteen ei todellakaan pysähdy maagisesti 5 GHziin vuonna 2017. Toki kellotaajuuden kasvu on hidastunut merkittävästi viime vuosina, mutta toisaalta yhteen kellojaksoon saadaan lisättyä enemmän laskentaa. Olisikin korrektimpaa puhua IPC:stä kun pelkästä kellotaajuudesta.

Kellotaajuus ei maagisesti pysähdy 5 GHz:n, silti sitä on aina vaan vaikeampaa ja vaikeampaa nostaa. Tuhatkertaistunut, joo. Valitettavasti prosessorin kellotaajuuden tuhatkertaistaminen megahertsista gigahertsiin on noin tuhat kertaa helpompaa kuin sen nosto gigahertsista edes 10 gigahertsiin...

Kellotaajuus ei merkittävästi kasva eikä myöskään IPC yhden ytimen osalta. Jälkimmäinen siksi että käytännössä kaikki vähänkään helpommat keinot on jo käytetty. Ainoa tapa lisätä CPU-tehoa merkittävästi on rinnakkaisuus.

Viimeksi muokattu:

windows ei pysty todelliseen moniajoon jossa siis yksi tehtävä ajetaan kahdella tai useammalla ytimellä jolloin suorituskyky tai nopeus on kerrannollinen ytimien määrän kanssa

mainitsinkin tuossa valolla toimivan kytkimen

Mikään käyttis ei kykene toimimaan kristallipallona ja ajamaan koodia, jos se ei tee toisistaan riippumattomia asioita. Peleissä se itse ydin, joka lopulta on se rajoittava tekijä on esimerkiksi asia, jota on mahdotonta täysin säikeistää, koska sen toiminta on lähinnä rajoitetun satunnaisia polkuja, joissa tapahtuu toisistaan riippuvia peräkkäisiä asioita.

Asioilla, joista ei ole edullisia massatuotettavia käytännön sovellutuksia olemassa ei juurikaan ole iloa.

- Liittynyt

- 21.07.2017

- Viestejä

- 676

Mikään käyttis ei kykene toimimaan kristallipallona ja ajamaan koodia, jos se ei tee toisistaan riippumattomia asioita. Peleissä se itse ydin, joka lopulta on se rajoittava tekijä on esimerkiksi asia, jota on mahdotonta täysin säikeistää, koska sen toiminta on lähinnä rajoitetun satunnaisia polkuja, joissa tapahtuu toisistaan riippuvia peräkkäisiä asioita.

Asioilla, joista ei ole edullisia massatuotettavia käytännön sovellutuksia olemassa ei juurikaan ole iloa.

eli koska windows ei pysty siihen niin sitä ei voi olla olemassa

Kellotaajuus ei merkittävästi kasva eikä myöskään IPC yhden ytimen osalta. Jälkimmäinen siksi että käytännössä kaikki vähänkään helpommat keinot on jo käytetty. Ainoa tapa lisätä CPU-tehoa merkittävästi on rinnakkaisuus.

Uskomatonta, että jollain voi olla näin lyhytnäköinen näkemys. IPC on kasvanut generaatiosta toiseen ja loppua ei näy. Rinnakkaisuus ei todellakaan ole ainoa tie. Tuon kommenttisi voisi melkein kehystää seinälle ja naureskella sille vielä vanhainkodissa.

Mielestäni niin IPC kuin kellotaajuuskaan eivät yksin kerro suorituskyvystä, vaan kyse on niiden yhdistelmästä. Kellotaajuutta on helppo nostaa IPC:n kustannuksella ja toisaalta IPC:tä voi nostaa, jos tingitään kellotaajuudesta. Oletan, että puhut IPC:n kohdalla yhden säikeen suorituskyvystä, koska siinä käytössä IPC-termiä käytetään. Viime vuosina on kyllä vaikuttanut siltä, että kellotaajuuden nosto on helpompaa kuin IPC:n (paitsi AMD:n tapauksessa, koska AMD:n vanhat prosessorit olivat IPC:n osalta niin kehnoja).36 vuodessa PC:n kellotaajuus on tuhatkertaistettu. Kehitys kellotaajuuden suhteen ei todellakaan pysähdy maagisesti 5 GHziin vuonna 2017. Toki kellotaajuuden kasvu on hidastunut merkittävästi viime vuosina, mutta toisaalta yhteen kellojaksoon saadaan lisättyä enemmän laskentaa. Olisikin korrektimpaa puhua IPC:stä kun pelkästä kellotaajuudesta.

- Liittynyt

- 17.10.2016

- Viestejä

- 10 719

Uskomatonta, että jollain voi olla näin lyhytnäköinen näkemys. IPC on kasvanut generaatiosta toiseen ja loppua ei näy. Rinnakkaisuus ei todellakaan ole ainoa tie. Tuon kommenttisi voisi melkein kehystää seinälle ja naureskella sille vielä vanhainkodissa.

Eihän se nyt ainoa tie tietysti ole mutta jos nyt mietitään prosessoreita joiden mukana tulee cooleri niin kutakuinkin yleinen kellotaajuus näillä (olemme varmaan samaa mieltä että puhumme ns. suurille massoille tehdyistä prosessoreista ja tietokoneista nyt) on tuollaista 4GHz tai alle luokkaa.

Ne mistä sinä vänkäsit, pelit, tehdään luonnollisesti toimiviksi näille kuluttajaluokan prosessoreille.

Nyt, ei tarvitse olla järin suuri näkemys että ymmärtää että:

1) ilmalla tehtävä jäähdytys alkaa olla niillä rajoilla ettei se näissä prosessoreiden mukana tulevissa coolereissa pysty tehokkaampaa (ja enemmän lämpöä tuottavaa) kellotaajuutta jäähdyttämään.

2) pienemmät prosessit, niistä puhutaan mutta kehitys väkisinkin hidastuu. En väitä etteikö esim. 1nm prosessilla tulevaisuudessa saada pienempään tilaan paljon tavaraa.. ..mutta tällä hetkellä PC:t millä pelataan alkavat olla aika pieni osa myyntiä. Sekä Intel että AMD keskittyvät myös kannettaviin, toimisto(valmis)koneisiin, varmasti myös kehitystä kännyköiden prosessoreilla jne. tehdään.

3) On fakta että nestetyppi/kuivajää/custom vesijäähy & kompressori jne. menetelmillä saadaan lisää kellotaajuutta nostettua. On myöskin fakta että tälläisiä ei käsittääkseni järkevään ns. suuremmille massoille tehtäviin prosessoreihin AMD:n tai Intelin puolelta ole oikeastaan tehty sekä takuun kanssa myyty.

Voisitko nyt kertoa faktoja miten yhä korkeampi prosessorin kellotaajuus voidaan saavuttaa miettien näitä faktoja? Prosessorien hinnat eivät voi tietenkään nousta liikaa tai ne eivät enää ole ns. suurille massoille mahdollista hankkia. Siksi paketti missä tulee mukana kompressoria ja Intelin/AMD:n avulla luvattua 5v takuuta sekä esim. 7GHz kelloilla käyvää prosessoria kohtuulliseen muutaman sadan euron (tai edes suurehkoon 500 euron/dollarin) hintaan tulla aivan heti näkemään. En näkisi myöskään ns. "gigantti konepaketteja" noin 1000€ hintaan missä olisi tälläisiä jäähdytys mentelmiä, prosessoria valmiiksi suurilla kelloilla ja tehokasta näytönohjainta. Olen kuitenkin nähnyt reippaasti alle 500€ pelikonsoleita, jopa ns. uusimpia Playstation/X-Box versioita.

Jos jotain tuotetta myytäisiin sen elinaikana esim. vain 10 000kpl ei se olisi enää soveltuva massatuotantoon, sitä varten ei kannattaisi rakentaa tehtaita jne. koska sen hinta nousisi järjettömiin miettien useiden vuosien kehityksen jne.

Miten siis sinusta päästään tulevaisuudessa tuollaiseen tulokseen että ilman ytimien lisäämistä kellotaajuudet kasvavat ja tavallinen koululainen jolle vanhemmat ostavat sen noin 1000€ pelikoneen tulee saamaan iloisena jouluyllätyksenään 7GHz+ kelloilla käyvän Geforce 2780TI näytönohjaimella ja 512GB muistilla sekä 16k näytöllä varustetun koneensa?

eli koska windows ei pysty siihen niin sitä ei voi olla olemassa

Jos ei ole olemassa, niin ei ole olemassa.

Koska ei ole olemassa, niin Windowskaan ei pysty siihen, niinpäin se menee.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Uskomatonta, että jollain voi olla näin lyhytnäköinen näkemys. IPC on kasvanut generaatiosta toiseen ja loppua ei näy. Rinnakkaisuus ei todellakaan ole ainoa tie. Tuon kommenttisi voisi melkein kehystää seinälle ja naureskella sille vielä vanhainkodissa.

Tuon kuvan pitäisi selittää myös sinulle ja muillekin miksi se kellojen nosto ei yksinkertaisesti ole järkevää.

Sweetspot on edelleen jossain 3GHz jopa alle tienoilla, tämän takia palvelin prosessoreissa ei nähdä mitään 4GHz 24/7 full load kelloja. Kotikäytössä homma on tiettyyn pisteeseen asti toki eri, siksi tuollaisia 5GHz kelloja nyt alkaa olla mutta 6GHz alkaa olemaan sellainen että voi viedä todella pitkään että sellaista tullaan näkemään ellei transistori puolella keksitä jotain mullistavaa.

- Liittynyt

- 16.12.2016

- Viestejä

- 903

Tuo dia koskee vain vanhoja SB: ja.Tuon kuvan pitäisi selittää myös sinulle ja muillekin miksi se kellojen nosto ei yksinkertaisesti ole järkevää.

Kotikäytössä homma on tiettyyn pisteeseen asti toki eri, siksi tuollaisia 5GHz kelloja nyt alkaa olla mutta 6GHz alkaa olemaan sellainen että voi viedä todella pitkään että sellaista tullaan näkemään ellei transistori puolella keksitä jotain mullistavaa.

Intel’s enhanced 10nm tech to bring up to 40 percent performance boost over 14nm

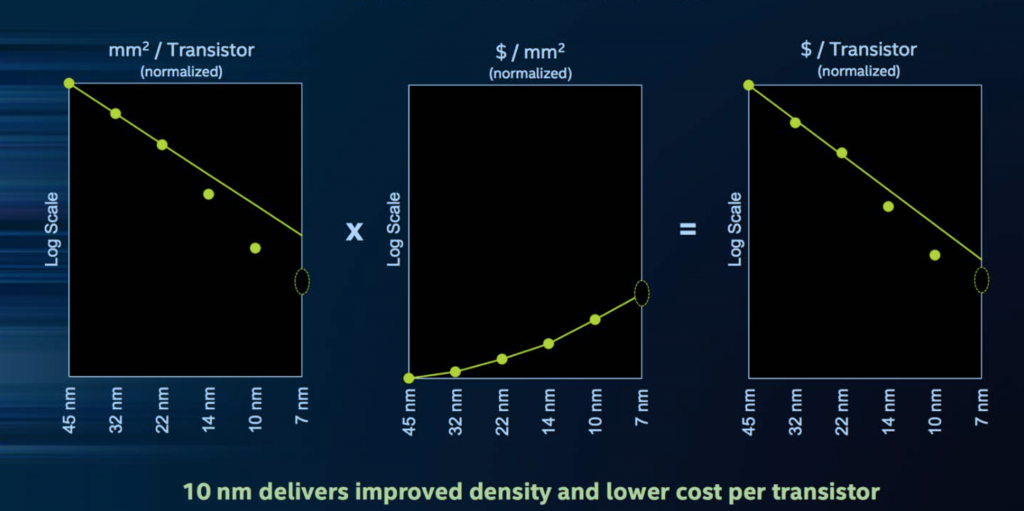

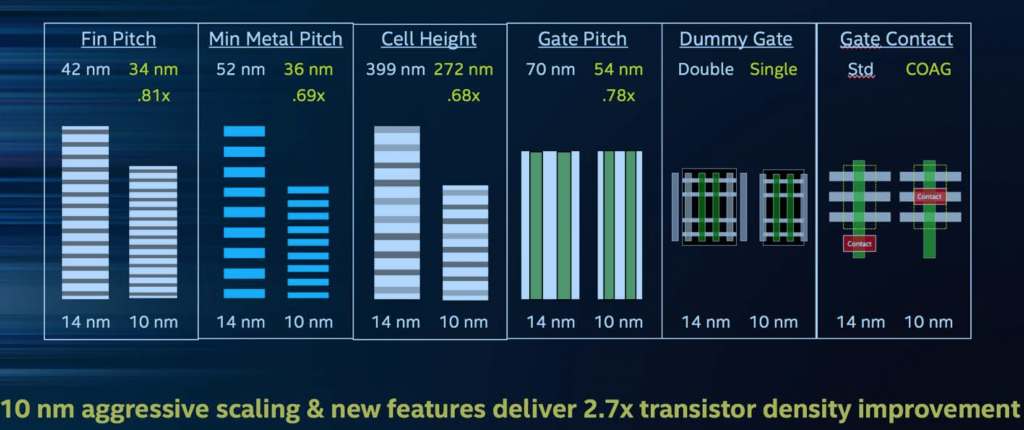

One of the major points of the presentation was the upcoming 10nm process node, which Intel claims is a ‘full generation ahead’ of the 10nm technology competing chip makers are using, including Samsung, TSMC, Qualcomm and others.

So what is so different about Intel’s 10nm tech compared to its rivals? Well for starters, it uses third-generation FinFET technology, but there is a bit more to it than that. One of the key focusses for Intel when it comes to 10nm is Hyper Scaling, which allows Intel to “continue the benefits of Moore’s Law economics by delivering transistors that are smaller and have lower cost-per-transistor”. We can see Intel’s example of this in the graph below, which was published as part of the press materials for this event.

With Intel’s 10nm node, the company claims it can deliver a 2.7x improvement in transistor density compared with its 14nm products. This is achieved due to the ‘minimum gate pitch’ shrinking from 70nm down to 54nm and the minimum metal pitch coming down from 52nm to 36nm. This enables a logic transistor density of 100.8 mega transistors per mm squared, which is estimated to be double that of competing 10nm chips.

Aside from that, Intel’s jump from 14nm to 10nm will bring further improvements. The latest process node is said to deliver up to 25 percent better performance at a 45 percent lower power draw. An upcoming enhanced version of the 10nm process known as ’10++’ will boost this performance benefit by an additional 15 percent, while reducing power draw by a further 30 percent.

KitGuru Says: While other companies might already be out of the gate with 10nm products, it sounds like Intel’s own node is much more refined. If Intel’s 10nm CPUs can really deliver those performance advantages, coupled with reduced power draw, then this could end up being a big generational leap.

Lähde: Intel's enhanced 10nm tech to bring up to 40 percent performance boost over 14nm | KitGuru

- Liittynyt

- 17.10.2016

- Viestejä

- 10 719

Tuo dia koskee vain vanhoja SB: ja.

Intel’s enhanced 10nm tech to bring up to 40 percent performance boost over 14nm

Tosin Canonlake lupasi tuoda olikos se 25%-30% lisää tehoa 7700K prosessoriin mikä ei suoraan tarkoittanut 5 GHz kellotetusta => 7½ GHz kellotettua vaan 4 => 6 ydintä. Voitaisiinko päätellä että uusi teknologia tuo muutaman ytimen lisää?

El-Reino69

Cunning Stuntman

- Liittynyt

- 14.12.2016

- Viestejä

- 981

Päivitetty versio sumppi lammesta se todennäköisesti on ja veikkaan että melkoisen kuumia kiviä tulevat oleen

Tässä hieman faktaa perustelujen pohjaksi. Keräsin tiedot 10v ajalta kovimmista harrastelija-CPUista ja niillä saaduista Passmark-tuloksista. Idea tässä on se, että IPC:n kasvu pitäisi olla selkeästi nähtävissä. Rajasin aika-akselin neliytimisten tuloon markkinoille ja vertailin prosessorit Q6600:ta vasten. Valitsin Passmarkin siksi, että sieltä oli saatavilla pidempää historiadataa.

Passmark-tulokset: PassMark CPU Benchmarks - Single Thread Performance

Lähtötiedot (Wikipedia/ARK):

Tulokset graafisesti:

Sinisestä kuvaajasta nähdään, että single thread suorituskyky on kasvanut noin kolminkertaiseksi 10 vuodessa.

Koska kellotaajuus kasvanut vuosien saatossa voidaan sen vaikutus poistaa (epätieteellisesti) skaalaamalla tulokset turbo-kellotaajuuden mukaan. Oranssi kuvaaja siten muuttaa kaikki tulokset vastaamaan Q6600-kellotaajuutta.

Single thread suorituskyvyn kasvu on selkeästi nähtävissä sekä kellotaajuuden että IPC:n parantumisen myötä. Interpoloimalla sinistä kuvaajaa, voidaan arvioida, että 10 vuoden päästä Intel CPUn single thread suorituskyky olisi noin kolminkertainen (tai ainakin merkittävästi parempi).

Passmark-tulokset: PassMark CPU Benchmarks - Single Thread Performance

Lähtötiedot (Wikipedia/ARK):

Tulokset graafisesti:

Sinisestä kuvaajasta nähdään, että single thread suorituskyky on kasvanut noin kolminkertaiseksi 10 vuodessa.

Koska kellotaajuus kasvanut vuosien saatossa voidaan sen vaikutus poistaa (epätieteellisesti) skaalaamalla tulokset turbo-kellotaajuuden mukaan. Oranssi kuvaaja siten muuttaa kaikki tulokset vastaamaan Q6600-kellotaajuutta.

Single thread suorituskyvyn kasvu on selkeästi nähtävissä sekä kellotaajuuden että IPC:n parantumisen myötä. Interpoloimalla sinistä kuvaajaa, voidaan arvioida, että 10 vuoden päästä Intel CPUn single thread suorituskyky olisi noin kolminkertainen (tai ainakin merkittävästi parempi).

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Tuo dia koskee vain vanhoja SB: ja.

Mitä väliä sillä on että mistä se kuva on? Ihan samanlaisia komponentteja niissä nykyisissäkin prosessoreissa on ja ihan samoiten niillä nykyisillä prosessoreilla se villan kulutus kasvaa exponentiaalisesti.

Kokonais kulutus samoilla kelloilla tok ion nyt pienempi mutta ihan samanlailla se muuten se virta kasvaa kun mennää tietyn sweetspotin ylitte.

Single thread suorituskyvyn kasvu on selkeästi nähtävissä sekä kellotaajuuden että IPC:n parantumisen myötä. Interpoloimalla sinistä kuvaajaa, voidaan arvioida, että 10 vuoden päästä Intel CPUn single thread suorituskyky olisi noin kolminkertainen (tai ainakin merkittävästi parempi).

No nythän on varsin tieteellisen tutkimuksen väsännyt. Tuossa nyt vaan on lähes kaikki pielessä. Jos oikesti sitä IPC:n kasvua alettaisiin tutkimaan niin silloin se mittaus pitäisi tehdä samoilla kelloilla kaikilla prosessoreilla.

TheMeII

Übertaktungspotenzial

- Liittynyt

- 13.11.2016

- Viestejä

- 7 353

+vertailukohta on 4c ja suurin osa 4c8t prossuja.No nythän on varsin tieteellisen tutkimuksen väsännyt. Tuossa nyt vaan on lähes kaikki pielessä. Jos oikesti sitä IPC:n kasvua alettaisiin tutkimaan niin silloin se mittaus pitäisi tehdä samoilla kelloilla kaikilla prosessoreilla

No nythän on varsin tieteellisen tutkimuksen väsännyt. Tuossa nyt vaan on lähes kaikki pielessä. Jos oikesti sitä IPC:n kasvua alettaisiin tutkimaan niin silloin se mittaus pitäisi tehdä samoilla kelloilla kaikilla prosessoreilla.

Pääpointti tuossa oli esittää single thread suorituskyvyn kasvu ajan funktiona. Se lienee kiistatonta, että trendi on nouseva? Vai onko siinä suhteessa jokin virhe? Mitkä asiat ovat pielessä ja mitkä eivät? Raportti on kasattu alle tunnissa, joten mistään tieteellisempää spektaakkelia ei edes ollut tarkoitus tehdä.

Jos testattaisiin samoilla kellotaajuuksilla tulisi seuraavaksi vaatimus, että muistitkin pitää toimia samalla taajudella. Ja sitten nostettaisiin esiin DDR2 vs. DDR3. vs DDR4 vertailukelpoisuus, Passmarkin tulosten kyseenalaistaminen jne. Itselläni ei ole resursseja tai kiinnostusta tehdä oikeita hardware-testejä enkä löytänyt sellaisia netistäkään näin pitkältä aikaväliltä.

- Liittynyt

- 12.12.2016

- Viestejä

- 3 930

Uskomatonta, että jollain voi olla näin lyhytnäköinen näkemys. IPC on kasvanut generaatiosta toiseen ja loppua ei näy. Rinnakkaisuus ei todellakaan ole ainoa tie. Tuon kommenttisi voisi melkein kehystää seinälle ja naureskella sille vielä vanhainkodissa.

Intelillä IPC nousee noin 5% vuodessa. Onko se merkittävää? Ei ole.

Sekä Intelin, että AMD:n kannattaisi nyt panostaa erittäin voimallisesti muistiohjaimiin ja välimuisteihin. Siellä on todella paljon suorituskykyä jarruttavaa löysää, eritoten 6 ydin ja yli prosuissa ja varsinkin CPU + GPU integraatioihmeissä.

Suurempaan parannukseen välimuistien osalta pitäisi saada tehtyä huomattavasti nykyistä pienempään menevä välimuisti joka olisi myös selvästi nopeampaa. Sellainen saadaan varmasti jossakin vaiheessa ulos. Koska ilman sellaista ei saada merkittävää parannusta, ei välimuisteissa ole löysää ollenkaan tällä hetkellä.

Itse asiassa sekä Intel että AMD ovat hidastaneet L1 välimuistia jotta saavat virrankulutusta alaspäin.

Tässä hieman faktaa perustelujen pohjaksi. Keräsin tiedot 10v ajalta kovimmista harrastelija-CPUista ja niillä saaduista Passmark-tuloksista. Idea tässä on se, että IPC:n kasvu pitäisi olla selkeästi nähtävissä. Rajasin aika-akselin neliytimisten tuloon markkinoille ja vertailin prosessorit Q6600:ta vasten. Valitsin Passmarkin siksi, että sieltä oli saatavilla pidempää historiadataa.

Passmark-tulokset: PassMark CPU Benchmarks - Single Thread Performance

Lähtötiedot (Wikipedia/ARK):

Tulokset graafisesti:

Sinisestä kuvaajasta nähdään, että single thread suorituskyky on kasvanut noin kolminkertaiseksi 10 vuodessa.

Koska kellotaajuus kasvanut vuosien saatossa voidaan sen vaikutus poistaa (epätieteellisesti) skaalaamalla tulokset turbo-kellotaajuuden mukaan. Oranssi kuvaaja siten muuttaa kaikki tulokset vastaamaan Q6600-kellotaajuutta.

Single thread suorituskyvyn kasvu on selkeästi nähtävissä sekä kellotaajuuden että IPC:n parantumisen myötä. Interpoloimalla sinistä kuvaajaa, voidaan arvioida, että 10 vuoden päästä Intel CPUn single thread suorituskyky olisi noin kolminkertainen (tai ainakin merkittävästi parempi).

Nuo tulokset osoittavat ettei IPC:n parantamisella ole saavutettavissa mitään merkittävää parannusta.

i7-8700K: 585 pistettä / GHz

i7-2600K: 511 pistettä / GHz

Ero IPC:ssa 13% ja aikaa kulunut 6 vuotta. Tekee vähän yli 2% IPC parannusta/vuosi

Ymmärrätkö nyt mitä tarkoitan kehityksen hidastumisella?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 209

Suoraan Anandtechin IPC artikkelista:

Broadwelliä uudemmilta sukupolvilta ei ole dataa, koska vanha artikkeli. Eli yllättäen totuus löytyi taas sieltä paskanvänkääjien välimaastosta. Kehitys ei ole junnannut paikoillaan, muttei myöskään mitään villejä +50% gaineja ole tullut jos ottaa keskiarvon sijaan mediaanin.

Kehitys ei ole junnannut paikoillaan, muttei myöskään mitään villejä +50% gaineja ole tullut jos ottaa keskiarvon sijaan mediaanin.

Eli jos nyt ostaa kahvijärveä kaupasta, niin kyllä sen IPC on aika tuuhea verrattuna vanhaan Sandy Bridgeen (koska nuo IPC gainit kumuloituvat ja tuosta puuttuu pari sukupolvea vielä omine lisineen).

https://www.anandtech.com/show/9482/intel-broadwell-pt2-overclocking-ipc/3 sanoi:Sandy Bridge to Ivy Bridge: Average ~5.0% Up

Ivy Bridge to Haswell: Average ~11.2% Up

Haswell to Broadwell: Average ~3.3% Up

Broadwelliä uudemmilta sukupolvilta ei ole dataa, koska vanha artikkeli. Eli yllättäen totuus löytyi taas sieltä paskanvänkääjien välimaastosta.

Kehitys ei ole junnannut paikoillaan, muttei myöskään mitään villejä +50% gaineja ole tullut jos ottaa keskiarvon sijaan mediaanin.

Kehitys ei ole junnannut paikoillaan, muttei myöskään mitään villejä +50% gaineja ole tullut jos ottaa keskiarvon sijaan mediaanin.Eli jos nyt ostaa kahvijärveä kaupasta, niin kyllä sen IPC on aika tuuhea verrattuna vanhaan Sandy Bridgeen (koska nuo IPC gainit kumuloituvat ja tuosta puuttuu pari sukupolvea vielä omine lisineen).

Uutiset

-

Uusi artikkeli: Testissä Samsung Galaxy Buds4 Pro -nappikuulokkeet

27.2.2026 14:37

-

VirtuStride kehittää ”VR-sandaaleja” joukkorahoituksella

27.2.2026 13:22

-

Live: io-techin Tekniikkapodcast (9/2026)

27.2.2026 12:13

-

Omdia: Samsung jatkaa Euroopan älypuhelinten ykkösenä ennen Applea ja Xiaomia

26.2.2026 23:31

-

SK Hynix ja SanDisk aloittivat HBF-muistien standardoinnin

26.2.2026 23:14