finWeazel

Chief Karpfen

- Liittynyt

- 15.12.2019

- Viestejä

- 8 005

Vertaat nvidian ja amd:n liikevoittoa niin löytyy juurisyy. Nvidia optimoi voittoa niin paljon kuin pystyy. Amd kompensoi heikkoa säteenseurantakykyä muistimäärillä, että on kulma missä parempi. Näillä ei mitään tekemistä ai markkinan kanssa.Vuonna 2020

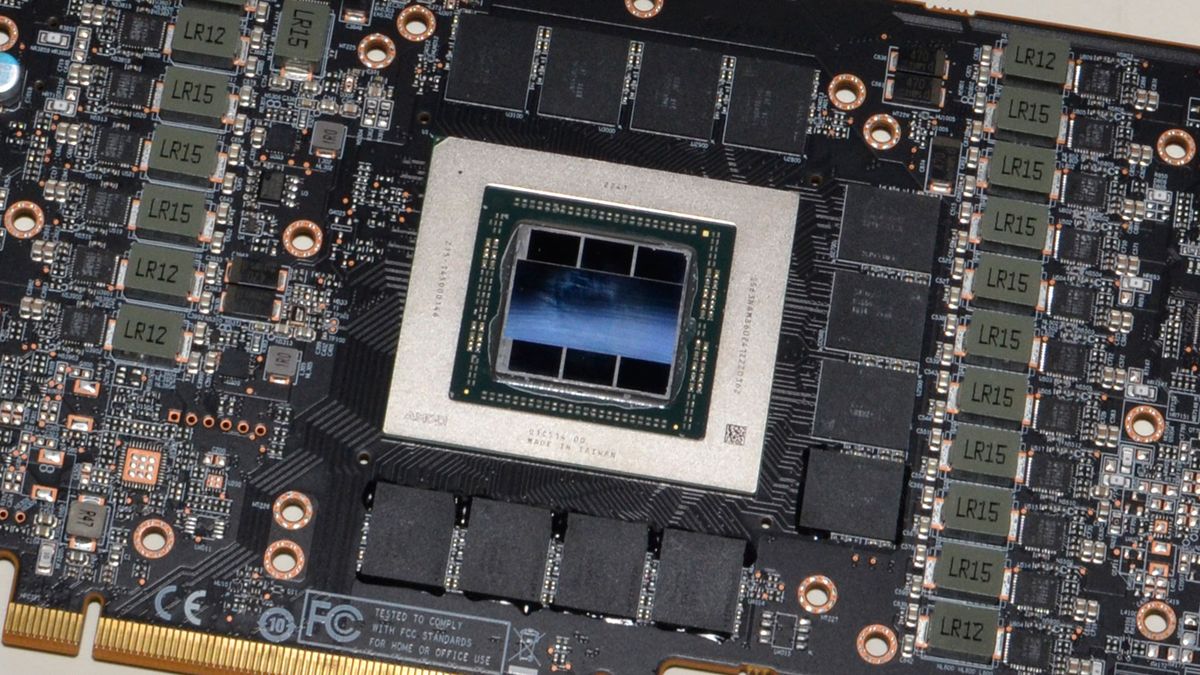

Radeon RX 6800 $579

-13056 Gflops single

-16 GB VRAM

-512 GB/s (128Mb cache 1432.6Gb/s)

-250 W

Ja tuo pyöritää edelleen pelejä

Samaan aikaan nVidia:

GeForce RTX 3070 $499

-17660 Gflops single

-8Gb VRAM

-448Gb/s

-220 W

GeForce RTX 3080 $699

-25060 Gflops single

-12Gb VRAM

-760Gb/s

-350 W

GeForce RTX 3090 $1499

-29280 Gflops single

-24Gb VRAM

-935.8GB/s

-350 W

Ja vastaava linja jatkui nVidialla 4xxx sarjassa. AMD tuntuu balansoivan korttia paremmin pelisuorituskykyyn.

Ja siis itsehän olin nVidia fani sieltä Geforce 2 MX:stä saakka mutta sitten kun RTX:t tuli niin pelikäyttöä silmällä pitäen ei oikein ole vakuuttanut speksit. Minulla siis vielä nVidia mutta tarkoitus olisi uusia tietokone kohta.