Niin eikös se naniten idea ole siinä, että devaajan ei tartte alkaa luomaan assetista lukuisia eri lod malleja, vaan se automaattisesti osaa etäisyyden mukaan lisätä/vähentää tarkkuutta. Näin olen sen käsittänyt. Miksi tätä ominaisuutta ei sitten saisikaan käyttää.

Periaatteessa miksei käyttäisi mutta se tarkkuus minkä tunkee peliin mukaan ei tarvitse olla parin pikselin objektia varten gigan assetti. Kyllä tuolla voi haaskata paljon tallentamalla assetit korkeammalla tarkuudella mitä naniitti voi hyödyntää.

Käytännön tasolla Nanite ei sitten vielä ole ollut mielekäs kun se on vain staattisiin mesheihin, että on pitänyt olla niin hahmot kuin mikä tahansa liikkeessä oleva, tyyliin puiden oksat jotenkin muuten.

Mielekkyyttä vie sitten tämä pois että voi tulla kontrastia Nanite objektien ja muiden välillä, kun se grafiikka näyttää paremmalta kun on texel/vertex density jokseenkin samanlaista niin se paistaa silmään jos jokin on erilainen. Se näyttää nimittäin ihan kauhealta jos on photogrammetry Nanite objekteina rakennettu tarkkaan kivet, kannot ja staattinen pusikko ja niiden päällä sitten hyppii joku 3rd person näkymästä hahmo missä erilainen tarkkuus, eikä pusikkokaan yhtään heilu tuulessa.

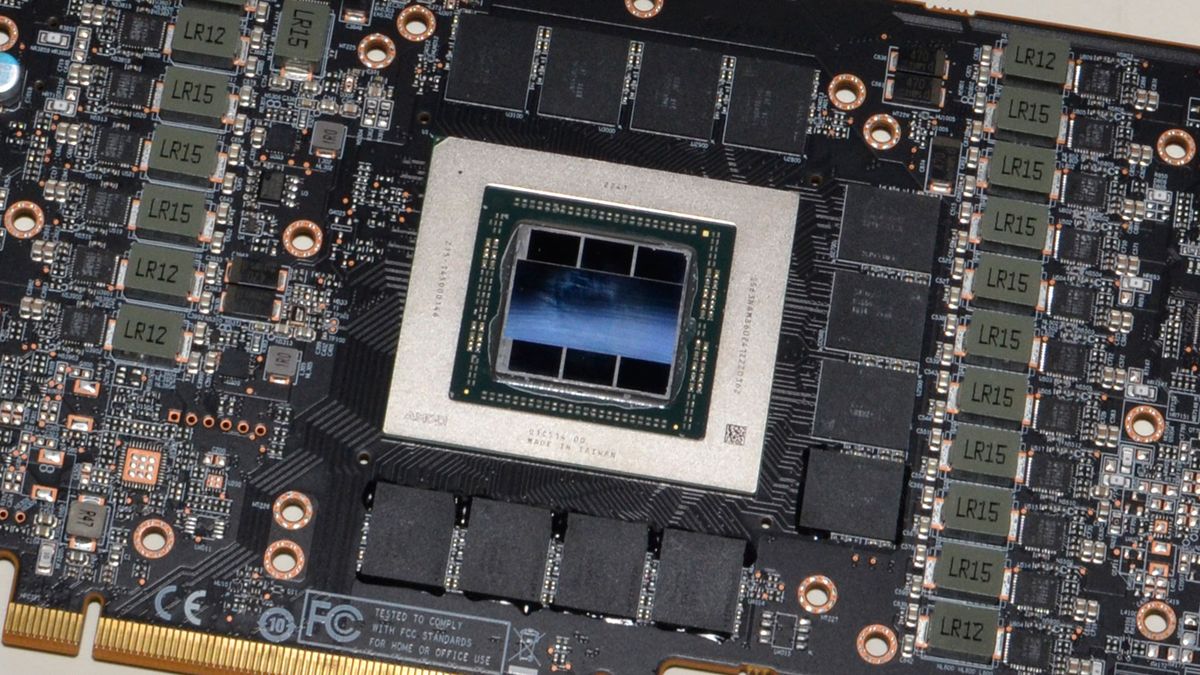

Muita harmeja sitten on se, että Nanite toimii toistaiseksi vain deferred renderöinnissä jossa sitten antialiasoinnit ovat huonoja. On sitten sitä TAA blurria kuvassa ja tosiaankin aika möhköjä ne assetit jos optimoimattomina laittavat sinne. Nanite + deferred renderöinti sitten yhdessä tehnyt sen, että on kovinkin kaistariippuvaista että Steam Deck on kyykyssä näiden kanssa.

Toistaiseksi ilman Nanitea saanut paremman lopputuloksen peleissä. Leffoissa ym. tuo Nanite sitten on oikein kätevä jos tekee virtuaalisia taustoja mutta Epic olisi ilmeisesti seuraavassa Unreal Engine versiossa tuomassa sitä Nanitea hahmomalleihin yms. tilanteisiin, että poistaa melkoisesti tuon rajoitteita.

Eli PS6 yms. tason vehkeillä kun PC:ssä 32 gigaa VRAM:ia, toimii myös mm. hahmoissa, opeteltu optimoimaan ne Nanitet myös ettei tarpeettomasti tallenneta detaljia mikä ei näy, opeteltu tekemään pelireleaset niin että ei tarvitse tehdä samoja pelejä uudestaan tai segmentoitu sellaiset 4k elämykset ja Steam Deck yhteensopivat eri kategorioihin design vaiheessa, että ei edes yritetä tuoda Steam Deckkiin niitä möhköjä vaan samoja mitkä vaikka Xboxin 1080p versiolla.

Minusta on muuten ihan jännä tämä kun Microsoft teki uusimmasta konsolisukupolvesta kaksi versiota, että jos tuollainen vaikka tekisi standardisointia pelien tarkkuudelle. Sillä tavalla että vaikka olisi mikä tahansa Nanite niin peli silti toimisi 1080p laitteella täysipainoisesti missä vähemmän VRAM:ia, kaistaa ja flopseja ja 4k laitteella sitten ero olisi ruudun pikseliresoluutiossa eikä vaikka assettien laadussa. Nykyinen konsolisukupolvi ei ihan tätä tee kun PS5:lla pelejä ajetaan 1600x900 kun ei jaksa pyörittää.