- Liittynyt

- 16.10.2016

- Viestejä

- 1 803

Eiköhän sieltä ole se 3080 Ti tulossa tuohon 3080 ja 3090 väliin, siinä missä on tulossa varmastikin myös 3060 jne. Veikkaisin että se täyden piirin korttikin nähdään, mahdollisesti nimellä 3090 Ti, eli nVidia varmaan tekee ns. "titan xp":t. Eli siis sama setti mitä pascal generaatiossa jossa mallisarjan huipulle julkaistiin ensin "titan x (pascal)" ja myöhemmin siitä vielä täyden piirin versio "titan xp", kortteja joita kumpaakaan ei muuten markkinoitu 'pelaajille' vaan ns. 'prosumer', aivan kuten 3090 nyt. Jos niinkö muistellaan niin nVidia julkaisi Titanin, sitten tuli Titan Z, GTX Titan X, sitten tuli uudestaan Titan X (pascal, ilman GTX etuliitettä, pascal arkkitehtuurilla ja kutsumanimi Titan Xp), ja siitä tuli biiffattu versio Titan Xp (nVidia trollaus, otettiin communityn edellisestä käyttämä nimi uudelle kortille).Moni seikka kuitenkin puhuu sen puolesta, että 3090 korvaisi molemmat, sekä 2080 Ti:n että Titan RTX:n

- hinta on näiden kahden välimaastossa

- Jensen kuvaili korttia Titan class -kortiksi

- AIB eivät ole saaneet valmistaa koskaan Titania, 3090 saavat

- 3090 ei ole täysi piiri (82SM 84:stä), kuten ei ole myöskään 2080 Ti, Titan on tähän asti ollut täydellä piirillä

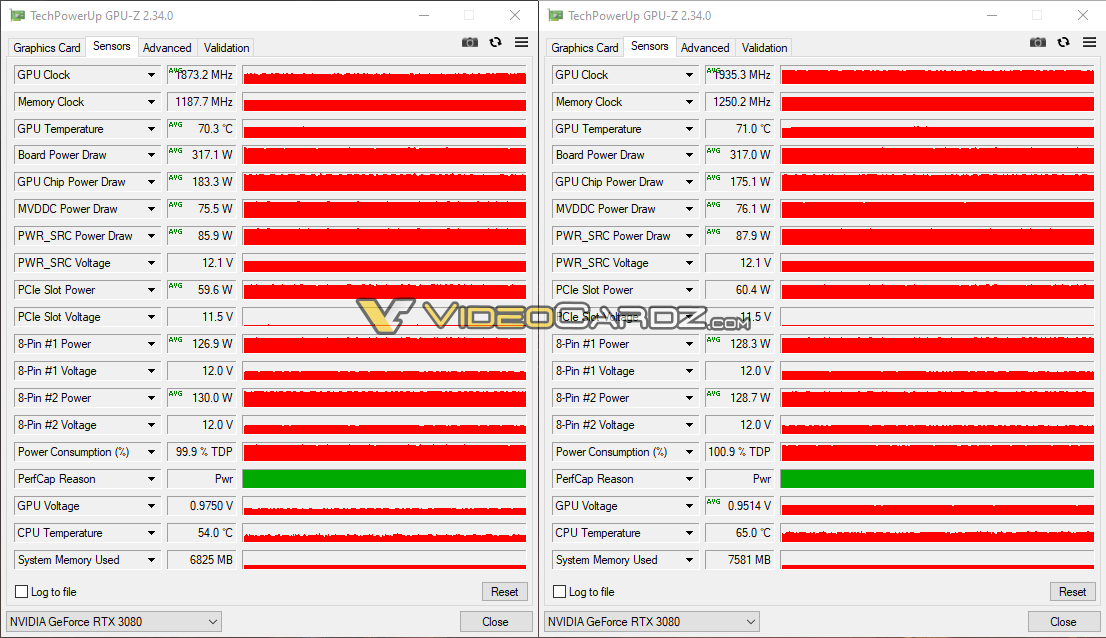

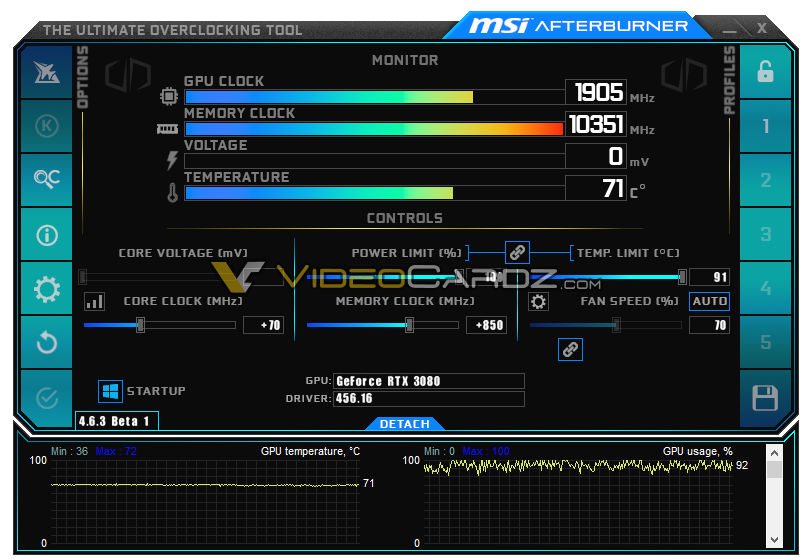

Speksien puolesta puhutaan noin +20% teholisästä 3080 nähden. Muistia toki on se +140%.

Skaalautuvuus ei kuitenkaan liene täysin lineaarista, eli todellinen ero lienee jossain 10-15% tuntumassa, ellei ajeta muistiriippuvaisia sovelluksia.

Veikkaan että nVIdia luopui varmaan kokonaan tosta Titan nimestä kun siitä tuli jo hyvin, hyvin sekava. RTX Titan oli vaihteeksi ihan selkeä, kun 2000-sarja oli eka RTX-sarja. Nyt niiden ois pitäny taas keksiä uusi nimi Titanille, joka ei sekottuis jo noihin aiempiin jotka oli jo todella sekaisin.

xx90 nimeä taas ei ole käytetty 600-sarjan jälkeen, joten sieltäpä löytyi sitten hyvä. Toivottavasti toi Titan-sekoilu on nyt loppu