-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA GeForce RTX 2070 Super / 2080 / 2080 Super / 2080 Ti -ketju (TU102, TU104)

- Keskustelun aloittaja Kaotik

- Aloitettu

Rane

Coordinator @ Diablo 4 clan "iotech"

- Liittynyt

- 01.11.2016

- Viestejä

- 3 421

Hetkinen puhutaanko me nyt TI:stä vai normi 2080? Itse puhuin TI

Tarkoitin tuossa aiemmassa kumpaakin. 20mhz ero kellottuvuudessa on aika mitätön puolin ja toisin.

Tarkoitin tuossa aiemmassa kumpaakin. 20mhz ero kellottuvuudessa on aika mitätön puolin ja toisin.

Ok, toki pieni on ero mutta jäi vain epäselväksi että ei se Msi:n TI ainakaan paremmi Kellotu tai että lämmöt nousisi huomattavasti kellottaessa strixissä

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Jaa itse missasin että tuossa graafissa myös OC lämmöt. Melkoinen ero korttien välillä tosiaan. Siis OC load 66c vs 75c Strixin voitoksi ja sillä vielä korkeammat nuo OC kellot.https://tpucdn.com/reviews/ASUS/GeForce_RTX_2080_Ti_Strix_OC/images/temp.png

en nyt noita sanoisi huonoiksi lämmöiksi vs Gaming Trio

MSI duke Ti puolestaan 72C OC load lämmöt ja karvan verran korkeammat kellot kuin isoveljellään. Epäilyttäviä tuloksia, kiinnostaisi nähdä toistuuko toisen tahon testeissä samat.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 004

Niin siis pienempi reso vs skidisti vähemmän karkkia. Spekulointia toki vielä, mutta aika näyttää kuinka hyvin dlss toimii. Toivottavasti hyvin sillä olisihan se helpoin tapa saada lisätehoja lappuihin.Miten se on paremman näköinen jos asetuksia tipauttaa

- Liittynyt

- 23.10.2016

- Viestejä

- 568

Yhtäläin DLSS päällä voi kytkeä grafiikka-asetuksia pienemmälle ja näin saada ison boostin fps-lukemaan. Vai tarkoitatko, että DLSS pitää kytkeä pois päältä ja sen sijaan laittaa grafiikka-asetuksia pienemmälle? Mitä järkeä siinä on? Kuvanlaadun heikkeneminen on nykytiedon valossa käytännöllisesti katsoen täysin mitätön. Jokainen täysijärkinen ottaa DLSS-boostin käyttöön, jos peli sitä suinkin tukee. Ja kun kerran boostia tulee kymmeniä-fps:ä, on selvää että jatkossa DLSS:ää tukevia pelejä tulee markkinoille solkenaan.Lähes ilmaisia, koska kuvanlaatu heikkenee vaikkei ero ehkä suuri olekaan. Kun saadaan kunnolla vertailumateriaalia voi tehdä lopulliseen tuomion mutta väittäisin että esim detailien laskulla pykälää alemmas maksimeista saa niin ikään aika tavalla lisää frameja ilman että kuvanlaatu laskee senkään vertaa (tyypillisesti ero korkeimman ja toiseksi korkeimman asetustason välillä on merkittävä suorituskyvyn osalta mutta näkyvät muutokset ovat väliltä "olematon" ja "pieni")

Usealla valmistajalla on todella hiljaisia custom kortteja ja pelien FPS ei juuri liiku suuntaan tai toiseen, vaikka kortin valmistaja vaihtuisi.

Ylikellotustulokset on pitkälti arpapeliä, joten kannattaa miettiä, että onko järkeä maksaa n. 100€ extraa kalleimmasta mallista.

Olisi kuitenkin kiva nähdä custom kortit testattuna samoilla kelloilla ja äänitasoilla. Tuossa selviäisi, että missä on oikeasti se tehokkain cooleri.

Tällä hetkellä kaikilla on eri kellotaajuudet ja fan curvet käytössä, niin on hankala löytää selviä eroja.

Ylikellotustulokset on pitkälti arpapeliä, joten kannattaa miettiä, että onko järkeä maksaa n. 100€ extraa kalleimmasta mallista.

Olisi kuitenkin kiva nähdä custom kortit testattuna samoilla kelloilla ja äänitasoilla. Tuossa selviäisi, että missä on oikeasti se tehokkain cooleri.

Tällä hetkellä kaikilla on eri kellotaajuudet ja fan curvet käytössä, niin on hankala löytää selviä eroja.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Automaagisesti tekee mitä tekeeJos käyttää DLSS reunojenpehmennykseen, niin muuttaako se resot samalla alaspäin josta skaalailee menemään mitä sitten tekeekin, vai pitääkö myös resoa laskea asetuksista? Eikai sentääs.

Kyllähän tuo 2080 Ti on 3440x1440-resolla pelaavan unelmakortti! Kohta pyörii taas kaikki pelit nupit kaakossa ja lähempänä sataa fps:ää kuin 60:ä

P.S. Ei näy vielä Gigabyten 2080 Ti Gaming OC:n :n arvostelua missään

P.P.S. Ei muuten häviä tuo FE-malli paljoa kustomeille, muutaman fps:n ero - mitäs hittoa?

P.S. Ei näy vielä Gigabyten 2080 Ti Gaming OC:n :n arvostelua missään

P.P.S. Ei muuten häviä tuo FE-malli paljoa kustomeille, muutaman fps:n ero - mitäs hittoa?

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

NVIDIAn promomateriaalista https://www.io-tech.fi/wp-content/uploads/2018/09/nvidia-turing-dlss-comparison-full-20180915.jpgOnko jollain linkata joku DLSS vs natiivireso vertailu?

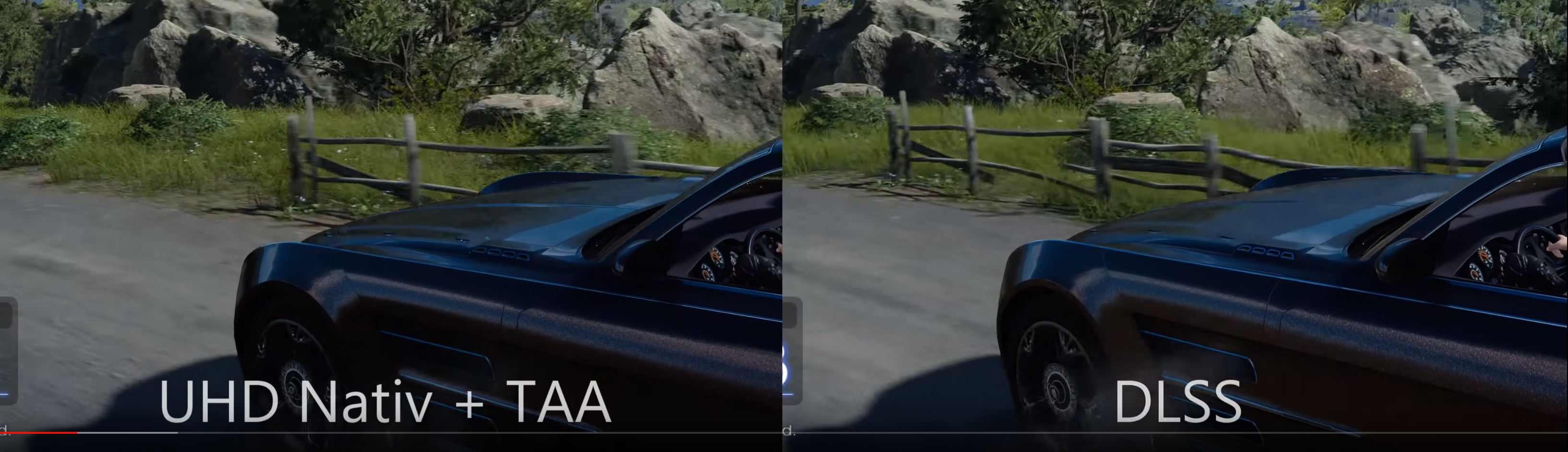

ComputerBasen videovertailua FF:stä (tarvitset toki 4K-näytön vertailun tekemiseksi ja valitettavasti youtuben pakkaus voi vaikuttaa kuvanlaatuun, mutta ihan alussa etenkin autossa olevissa teksteissä ero on todella selvä)

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

FE:ssä on referenssiä korkeammat kellot, eli sekin on "OC-malli" (niillä on myös referenssiä korkeampi TDP)P.P.S. Ei muuten häviä tuo FE-malli paljoa kustomeille, muutaman fps:n ero - mitäs hittoa?

Jaha khronos julkassu uuden Vulkanin version, mukana uusia nvidian laajennoksia Turingin raudalle. (Mm. vk_nvx_raytracing, vk_nv_mesh_shader yms.)

https://pclab.pl/art78828-20.html

Star Wars Reflection demo bench

Star Wars Reflection demo bench

FE:ssä on referenssiä korkeammat kellot, eli sekin on "OC-malli" (niillä on myös referenssiä korkeampi TDP)

Ja näköjään Guru3D:n mukaan kellottuu paremmin kuin kumpikaan heidän testaamistaan kustomeista. Eikä myöskään järkyttävän äänekäs tai kuumana käyvä.

latee77

RTX ON

- Liittynyt

- 18.02.2017

- Viestejä

- 5 892

Automaagisesti tekee mitä tekee

Ok, hyvä niin, automagia on aina paikallaan laiskemmalle säätäjällä.

Toiv tätä tullaan käyttämään useimmissa peleissä niin saa vähän balsamia haavoille kun ei ihan perus fps noussut niin paljoa kuin edellisellä kierroksella.

- Liittynyt

- 04.02.2018

- Viestejä

- 274

NVIDIAn promomateriaalista https://www.io-tech.fi/wp-content/uploads/2018/09/nvidia-turing-dlss-comparison-full-20180915.jpg

ComputerBasen videovertailua FF:stä (tarvitset toki 4K-näytön vertailun tekemiseksi ja valitettavasti youtuben pakkaus voi vaikuttaa kuvanlaatuun, mutta ihan alussa etenkin autossa olevissa teksteissä ero on todella selvä)

Ainakin kun itse katsoo tuota 1440p ultra wide resolla, niin kyllä tuo DLSS on paljon tarkempi alussa puiden ja kallion tekstuureissa. TAA päällä ois sama kuin ois elmukelmu päällä. Toki nuita kukaan oikeasti kerkeä seurata missään FPS pelissä..

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Tykkäisin, jos DLSS toimisi liukuvasti millä tahansa (tai ainakin joidenkin rajojen sisässä) resolution scalella.Ok, hyvä niin, automagia on aina paikallaan laiskemmalle säätäjällä.

Uutta ajuria btw:

http://uk.download.nvidia.com/Windows/411.63/411.63-desktop-win10-64bit-international-whql.exe

- Liittynyt

- 17.10.2016

- Viestejä

- 939

Ainakin kun itse katsoo tuota 1440p ultra wide resolla, niin kyllä tuo DLSS on paljon tarkempi alussa puiden ja kallion tekstuureissa. TAA päällä ois sama kuin ois elmukelmu päällä. Toki nuita kukaan oikeasti kerkeä seurata missään FPS pelissä..

Tuossa testissä nyt on aika paljon vikoja ainakin jos gamers nexusta on uskominen. Time stampatty kohta videosta jossa puhuu asiasta

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Onko jollain ko. testiä ladattuna ja mahdollisuus ottaa samasta kohtaa kuvaa ilman AA:ta 4K-resolla? Näkisi onko tuo TAA:n aiheuttamaa suttua vai tarkoituksellinen DoF-suttu jolla asetetaan focus autoonAinakin kun itse katsoo tuota 1440p ultra wide resolla, niin kyllä tuo DLSS on paljon tarkempi alussa puiden ja kallion tekstuureissa. TAA päällä ois sama kuin ois elmukelmu päällä. Toki nuita kukaan oikeasti kerkeä seurata missään FPS pelissä..

edit: lataan ja testaan varmaan itse jossain välissä tänään

- Liittynyt

- 17.10.2016

- Viestejä

- 115

Onko jollain linkata joku DLSS vs natiivireso vertailu?

Techpowerupin revikasta lainattua: "Under the hood, DLSS renders the scene at lower resolution (typically 50%, so for 4K that's 2880x1620), and the feeds the frame to the tensor cores, which use a predefined deep neural network to enhance that image"

Ei mikään kuvavertailu, mutta itselle ainakin selkeytti, että kuinka paljon alemman reson kuvaa oikein skaalataan ylös.

- Liittynyt

- 17.10.2016

- Viestejä

- 310

Computerbasen haukutumpi DLSS demo:

Transulate:

On the other hand, DLSS can not convince with the infiltrator demo There is a major leap in performance at the infiltrator tech demo. This is up to 45 percent. Interestingly, the performance gain in the demo is very scene-dependent. Sometimes the DLSS version does not run faster, but this can also be due to a lack of optimization. Evidently, Epic also exaggerated the resolution a bit. For Infiltrator flicker relatively many objects that are displayed absolutely quiet at native resolution. In addition, the picture looks less sharp than with the native resolution. Accordingly, the visual impression of the demo with DLSS is worse than with the native Ultra HD resolution. The developer can freely choose the native resolution at DLSS. Accordingly, there will probably be big differences in DLSS integration in games as well. As the two tests show, DLSS can look very good in one game and rather bad in another. The implementation of AI technology in the first games is accordingly exciting.

Transulate:

On the other hand, DLSS can not convince with the infiltrator demo There is a major leap in performance at the infiltrator tech demo. This is up to 45 percent. Interestingly, the performance gain in the demo is very scene-dependent. Sometimes the DLSS version does not run faster, but this can also be due to a lack of optimization. Evidently, Epic also exaggerated the resolution a bit. For Infiltrator flicker relatively many objects that are displayed absolutely quiet at native resolution. In addition, the picture looks less sharp than with the native resolution. Accordingly, the visual impression of the demo with DLSS is worse than with the native Ultra HD resolution. The developer can freely choose the native resolution at DLSS. Accordingly, there will probably be big differences in DLSS integration in games as well. As the two tests show, DLSS can look very good in one game and rather bad in another. The implementation of AI technology in the first games is accordingly exciting.

- Liittynyt

- 26.07.2017

- Viestejä

- 233

Yksinpeleissä varmasti ihan kova ratkaisu. Pubgissa tuskin haluaisin käyttää.Techpowerupin revikasta lainattua: "Under the hood, DLSS renders the scene at lower resolution (typically 50%, so for 4K that's 2880x1620), and the feeds the frame to the tensor cores, which use a predefined deep neural network to enhance that image"

Ei mikään kuvavertailu, mutta itselle ainakin selkeytti, että kuinka paljon alemman reson kuvaa oikein skaalataan ylös.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Ainakin kun itse katsoo tuota 1440p ultra wide resolla, niin kyllä tuo DLSS on paljon tarkempi alussa puiden ja kallion tekstuureissa. TAA päällä ois sama kuin ois elmukelmu päällä. Toki nuita kukaan oikeasti kerkeä seurata missään FPS pelissä..

Onko jollain ko. testiä ladattuna ja mahdollisuus ottaa samasta kohtaa kuvaa ilman AA:ta 4K-resolla? Näkisi onko tuo TAA:n aiheuttamaa suttua vai tarkoituksellinen DoF-suttu jolla asetetaan focus autoon

edit: lataan ja testaan varmaan itse jossain välissä tänään

Noniin, tulipahan haettua testi ja katsottua ihan itse miltä se näyttää. Näyttäisi meinaan siltä että DLSS hukkaa täysin ihan tarkoituksenmukaisen syvyysblurrin, ne on meinaan pehmeitä myös ilman mitään AA:ta.

- Liittynyt

- 04.02.2018

- Viestejä

- 274

Noniin, tulipahan haettua testi ja katsottua ihan itse miltä se näyttää. Näyttäisi meinaan siltä että DLSS hukkaa täysin ihan tarkoituksenmukaisen syvyysblurrin, ne on meinaan pehmeitä myös ilman mitään AA:ta.

Liikkuvan kuvan osalta, en ainakaan tuossa infiltrator pätkässä näe yhtään eroa nuiden välillä. Jos sitä ei liikkeestä erota, niin mitä väliä

- Liittynyt

- 21.08.2018

- Viestejä

- 5 521

Ne asetukset ei ole samat kun se DLSS renderöi matalammalla resoluutiolla

Sillä ei ole mitään merkitystä mistä ne freimit tulee jos se ei heikennä kuvanlaatua.

Ja DLSS näillänäkymin ei sitä heikennä,mutta selvästi nostaa freimejä eli oikein hyvältä vaikuttaa.

- Liittynyt

- 21.08.2018

- Viestejä

- 5 521

NVIDIAn promomateriaalista https://www.io-tech.fi/wp-content/uploads/2018/09/nvidia-turing-dlss-comparison-full-20180915.jpg

ComputerBasen videovertailua FF:stä (tarvitset toki 4K-näytön vertailun tekemiseksi ja valitettavasti youtuben pakkaus voi vaikuttaa kuvanlaatuun, mutta ihan alussa etenkin autossa olevissa teksteissä ero on todella selvä)

DLSS on paljon tarkempi esim heti alussa taustalla olevissa puissa jne.

Toihan on parempi kuin osasin edes kuvitella.

Lisää Fps + parempilaatuinen kuva tuon videon perusteella.

Noniin, tulipahan haettua testi ja katsottua ihan itse miltä se näyttää. Näyttäisi meinaan siltä että DLSS hukkaa täysin ihan tarkoituksenmukaisen syvyysblurrin, ne on meinaan pehmeitä myös ilman mitään AA:ta.

Voi mennä taas benchmarkin piikkiin, kun tossa on monta muutakin asiaa rikki, jotka taas toimii itse pelissä. Päivitystä odotellessa, niin pääsee joskus kokeilemaan..

Kieltämättä erikoinen julkaisu, kun kortit puskettiin ulos ilman pelitukea uusille ominaisuuksille.

Onkohan siellä jo 7nm kortit tulossa lähitulevaisuudessa vai miksi oli näin kova kiire?

- Liittynyt

- 21.08.2018

- Viestejä

- 5 521

Kysymys kuuluukin, jos haetaan samanlainen kuvanlaatu TAA:lla nouseeko framet samalla tahdilla vai onko DLSS täysin turhake?

Jos sitä resoluutioo menet laskemaan niin kyllä Fps nousee,mutta verrattuna DLSS näyttää paljon pahemmalta koska silloin kuva ei mene ns "tensor ytimien läpi upskaalattuna"

- Liittynyt

- 17.10.2016

- Viestejä

- 310

7nm korteista pitäisi päästä nauttimaan ensi vuonna (TMSC:llä tunkua, kun AMD myös asiakkaana). Nvidia pahemmin niistä hiiskunut, mutta AMD:n pitäisi ilmoitella näistä loppuvuodesta.Kieltämättä erikoinen julkaisu, kun kortit puskettiin ulos ilman pelitukea uusille ominaisuuksille.

Onkohan siellä jo 7nm kortit tulossa lähitulevaisuudessa vai miksi oli näin kova kiire?

- Liittynyt

- 21.02.2017

- Viestejä

- 6 070

Erittäin vähän DLSS kuvamateriaalia nähty tähän mennessä ja kaikki Nvidian valikoimaa.Toihan on parempi kuin osasin edes kuvitella.

Lisää Fps + parempilaatuinen kuva tuon videon perusteella.

Nvidiahan antoi monta viikkoa sitten sen suorituskykykuvaajan, jossa kuvattiin usemman DLSS-tuetun pelin suorituskykyä. Jostain syystä nyt julkaisussa nähdään kuvanlaatua vain tästä FFXV:stä. Ei kuvaa esim. PUBG:stä, ARKista ja Tomb Raiderista, vaikka DLSS kehitys jo sen verran pitkällä, että suorituskyvystä kertovat.

Ehkä kannattaa arvioidensa kanssa vielä odotella ihan rauhassa.

- Liittynyt

- 13.09.2018

- Viestejä

- 808

7nm korteista pitäisi päästä nauttimaan ensi vuonna (TMSC:llä tunkua, kun AMD myös asiakkaana). Nvidia pahemmin niistä hiiskunut, mutta AMD:n pitäisi ilmoitella näistä loppuvuodesta.

Minua ainakin huolettaa, että jos nyt ostaa ökyhintaisen 2080 Ti kortin, voi se olla jo ensi vuonna vanhentunut, mikäli 7nm korteista saadaan revittyä paljonkin enemmän tehoa irti. Vastaavasti 2080 tuntuu huonolta sijoitukselta ennen kuin raytracingia käyttäviä pelejä on enemmän markkinoilla. Taidan odotella vuoden loppuun ainakin ennen kuin menen hankkimaan uutta korttia.

Tuo kertoo enemmänkin siitä kuinka huono FFXV:n TAA toteutus on jos alhaisemmalla resoluutiolla rendatussa kuvassa on jäljellä enemmän yksityiskohtia.DLSS on paljon tarkempi esim heti alussa taustalla olevissa puissa jne.

Toihan on parempi kuin osasin edes kuvitella.

Lisää Fps + parempilaatuinen kuva tuon videon perusteella.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Jos nyt olisit edes ne edelliset viestit lukenut. Sen taustan kuuluu olla pehmeä, se on pehmeä myös ilman mitään AA:ta koska kyse on DoF-efektistä.DLSS on paljon tarkempi esim heti alussa taustalla olevissa puissa jne.

Toihan on parempi kuin osasin edes kuvitella.

Lisää Fps + parempilaatuinen kuva tuon videon perusteella.

Eli DLSS joko rikkoo koko efektin täysin tai arpoo matalamman resoluution takia tarkkuuden päin sitä itseään. Kannattaa myös kiinnittää huomiota niihin teksteihin (esim rekisterikilpi) joiden laatu on todella surkeaa vrt TAA natiiviresolla.

kts ylläTuo kertoo enemmänkin siitä kuinka huono FFXV:n TAA toteutus on jos alhaisemmalla resoluutiolla rendatussa kuvassa on jäljellä enemmän yksityiskohtia.

edit:

Toisaalta lainattu kuvankaappaus videosta, leveyden takia spoilereissa. DLSS tekee ruohikosta ohiajettaessa pelkkää mössöä

Tuon Tompan revikan perusteella vaikuttaisi siltä, että 4K harrastajille oikein hyvä ostos, hinnasta huolimatta. Nostaa jo nykyisten pelin FPS:ää monasti juuri tarpeeksi, ilman mitään virityksiäkään. Jos taas käyttää FHD tai siitä seuraavaa resoa, niin ei vielä tarpeellinen, mutta jos säteenseuranta ja muut uudet ominaisuudet tulevat käyttöön jossain vaiheessa, niin soveltuu toki sitten siihenkin sekmenttiin.IO-techin sivuilla on 2080 revikat, Tom's Hardwarelle on puolestaan 2080 ti ulkona:

Aika hurjaa että 2080 ti on ainoa kortti joka jaksaa pyörittää yli 60 fps 4k:lla 1,5 vuotta vanhaa peliä

Results: Tom Clancy’s Ghost Recon, The Witcher 3, and WoW - Nvidia GeForce RTX 2080 Ti Founders Edition Review: A Titan V Killer

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 6 790

Onko jossain testattu DLSS2x eli renderöidään 4k resolla ja DLSS käyttää taikaa ja saa kuvan näyttämään 8k renderiltä. Tuo minun mielestä se oikea käyttötarkoitus eikä mikään palikkareson suttaaminen muka-4k:ksi.

- Liittynyt

- 16.11.2016

- Viestejä

- 4 254

Kyllähän tuo 2080 Ti on 3440x1440-resolla pelaavan unelmakortti! Kohta pyörii taas kaikki pelit nupit kaakossa ja lähempänä sataa fps:ää kuin 60:ä

P.S. Ei näy vielä Gigabyten 2080 Ti Gaming OC:n :n arvostelua missään

P.P.S. Ei muuten häviä tuo FE-malli paljoa kustomeille, muutaman fps:n ero - mitäs hittoa?

Joo ei oo löytyny vielä mistään.. :/

Ite vähä ihmettelen kans et kui tasanen esim fe 2080ti on msi trion kanssa. Trio kuluttaa jonkun 50w enemmän, on vähän hiljaisempi mut lämmöt suurinpiirtein samat. Toki kierrokset vaikuttaa. Hyvin se fe silti potkii kun joku 2fps ero customiin, näin ollen ei harmita yhtää et tuli se melkein halvin, gb wf 2080ti oc hommattua

Joo kyllä sitä jytky tuli ja pidetään preorder sisässä, onneks ei oo Gigantti muuttanut 4.10 tilausta enää pidemmälle. Blokkikin tulee kun tulee mutta kiire ei oo, vähän on auki miten hyvin nämä vedestä tykkäävät. Onko joku tätä pohtinut sen syvällisemmin??

Ja hyvä että saatiin PISTE sille p****n jauhamiselle

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Ei vielä mutta näyttäisi "kaikki" tuskastelleen aikataulujen kanssa ja noita päivitellään varmasti joka revikkaan ellei tehdä kokonaan omia artikkeleita noilleOnko jossain testattu DLSS2x eli renderöidään 4k resolla ja DLSS käyttää taikaa ja saa kuvan näyttämään 8k renderiltä. Tuo minun mielestä se oikea käyttötarkoitus eikä mikään palikkareson suttaaminen muka-4k:ksi.

Jokohan joku on laskemassa ruohonkorsien kulmaa aa-analyysin tueksi

Itsehän tulen käyttämään DLSS 2X:ää, mutta en silti vetäisi kovin suuria johtopäätöksiä pelkästään yhden mittakaavaltaan pienen DLSS-testin perusteella. Ja voisin kuvitella, että tuo DLSS päivittyy ajan myötä - ja koska se hoidetaan tensor coreilla, niin tulevaisuudessa sen avulla 2080 tulee kiskomaan kunnon kaulaa 1080 Ti:hin verrattuna.

Itsehän tulen käyttämään DLSS 2X:ää, mutta en silti vetäisi kovin suuria johtopäätöksiä pelkästään yhden mittakaavaltaan pienen DLSS-testin perusteella. Ja voisin kuvitella, että tuo DLSS päivittyy ajan myötä - ja koska se hoidetaan tensor coreilla, niin tulevaisuudessa sen avulla 2080 tulee kiskomaan kunnon kaulaa 1080 Ti:hin verrattuna.

Voi mennä taas benchmarkin piikkiin, kun tossa on monta muutakin asiaa rikki, jotka taas toimii itse pelissä. Päivitystä odotellessa, niin pääsee joskus kokeilemaan..

Kieltämättä erikoinen julkaisu, kun kortit puskettiin ulos ilman pelitukea uusille ominaisuuksille.

Onkohan siellä jo 7nm kortit tulossa lähitulevaisuudessa vai miksi oli näin kova kiire?

Nuo sisältävät uusia ominaisuuksia, joita varten kortteja pitää olla liikkeellä, että niitä voidaan tukea.

Toisaalta kun kilpailijoilla ei ole mitään tarjottavaa uusilla aluella, niin Nvidia pystyy rauhassa vahvistamaan jalansijaa noiden uusien tekniikoiden kanssa. En tiedä, pysyykö kukaan muu esim hyödyntämään Nvidian laskemaa DLSS dataa joskus muulla raudalla, vai onko se estetty kaikilla tasoilla, myös patentein ja omistusoikeuksin.

- Liittynyt

- 17.10.2016

- Viestejä

- 1 882

Joo, tasan samat ajatukset täällä. QHD-näytön kanssa ei ole mitään kiirusta, 1080Ti piisaa paremmin kuin hyvin. Laadukkaan 4K-näytön kaveriksi taas 2080Ti olisi hyvin potentiaalinen hankinta.Tuon Tompan revikan perusteella vaikuttaisi siltä, että 4K harrastajille oikein hyvä ostos, hinnasta huolimatta. Nostaa jo nykyisten pelin FPS:ää monasti juuri tarpeeksi, ilman mitään virityksiäkään. Jos taas käyttää FHD tai siitä seuraavaa resoa, niin ei vielä tarpeellinen, mutta jos säteenseuranta ja muut uudet ominaisuudet tulevat käyttöön jossain vaiheessa, niin soveltuu toki sitten siihenkin sekmenttiin.

Täysin linjassa omien odotusten kanssa oli revikoiden tulokset, ei muuta asetelmaa mitenkään. Eipä tuo väliraha nyt montaa satasta olisi toki, ehkä sieltä joku myyntiargumentti ennen pitkää paljastuu, joka saa ostohousut jalkaan.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Ei se siitä nopeutumaan pääse ja toki kuvanparannusmetodit skaalauksessa ja arvauslogiikat voi parantua mutta siinäpä seJokohan joku on laskemassa ruohonkorsien kulmaa aa-analyysin tueksi

Itsehän tulen käyttämään DLSS 2X:ää, mutta en silti vetäisi kovin suuria johtopäätöksiä pelkästään yhden mittakaavaltaan pienen DLSS-testin perusteella. Ja voisin kuvitella, että tuo DLSS päivittyy ajan myötä - ja koska se hoidetaan tensor coreilla, niin tulevaisuudessa sen avulla 2080 tulee kiskomaan kunnon kaulaa 1080 Ti:hin verrattuna.

Uusien teknologioiden ongelma ei ole pelkästään huono teho. Miksi edes kehittää raytracingia hyödyntäviä pelejä jos ne teknologiat ei sisälly tuleviin konsoleihin? Tämä saattaa kuolla välittömästi, sillä eihän 2080-sarjan omistajille kannata pelejä tehdä. DLSS voi yleistyä enemmän kun se on vain pienitöinen lisä.

Uusien teknologioiden ongelma ei ole pelkästään huono teho. Miksi edes kehittää raytracingia hyödyntäviä pelejä jos ne teknologiat ei sisälly tuleviin konsoleihin? Tämä saattaa kuolla välittömästi, sillä eihän 2080-sarjan omistajille kannata pelejä tehdä. DLSS voi yleistyä enemmän kun se on vain pienitöinen lisä.

Saattaahan ne tullakin konsolehinkin sitten joskus, siellä sitten siirrytään 720p upskaalattuun tilaan, kun GPU ei saa maksaa tarpeeksi.

Tuo olisi ollut myyntivaltti konsolipuolella (kuten aikoinaan PS1:n 3d), mutta PC puolella tulee nyt käyttöön ensiksi.

Aikoinaan konsoleihin oli vara pistää innovaatioita, mutta Sony poltti näppinsä melko pahasti PS3:n kanssa, jonka jälkeen konsolit ovatkin sitten olleet halpoja, lukittuja pikkuisen modattuja PC koneita, omilla lukituilla käyttiksillään.

Lisäksi valmistustekniikan kehitys on hidastunut ratkaisevasti. Nyt julkaistujen näyttisten suorituskykyhyppäys on tämä huomioonottaen suorastaan ihme.

Viimeksi muokattu:

8k-näyttöjä ei vielä paljoa ole näkynyt. Sen sijaan skaalaus DSLL:llä hakkaa varmasti 100-0 nykyiset telkkareissä käytettävät skaalaukset kuvanlaadun puolesta, joten tuo on erittäin hyvä laite 4k-telkkarin/näytön kaveriksi.Onko jossain testattu DLSS2x eli renderöidään 4k resolla ja DLSS käyttää taikaa ja saa kuvan näyttämään 8k renderiltä. Tuo minun mielestä se oikea käyttötarkoitus eikä mikään palikkareson suttaaminen muka-4k:ksi.

Uusia konsoleita on tulossa 2020, ja siihen mennessä hitaampikin GPU-suunnittelija saattaa jotain saada aikaiseksi. AMD:lla on omien sanojensa mukaan kehitteillä "secret saucet" sekä Sonyn että MS:n kanssa, joten suattaapi olla, että sieltä myös löytyy vastineet RT- ja Tensor-virityksille.Miksi edes kehittää raytracingia hyödyntäviä pelejä jos ne teknologiat ei sisälly tuleviin konsoleihin? Tämä saattaa kuolla välittömästi, sillä eihän 2080-sarjan omistajille kannata pelejä tehdä. DLSS voi yleistyä enemmän kun se on vain pienitöinen lisä.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Ei ole, piirit ovat paitsi pirusti isompia kuin edeltäjänsä, myös valmistettu pienemmällä prosessilla (vaikka se 12nm toki perustuu 16nm:ään se on ihan oikeastikin pienempi kuulemma)Lisäksi valmistustekniikan kehitys on hidastunut ratkaisevasti. Nyt julkaistujen näyttisten suorituskykyhyppäys on tämä huomioonottaen suorastaan ihme.

Ennemmin piirien koko ei kasvanut, vaikka suhteellinen trankkumäärä kasvoi huomattavasti. Lisäksi saatiin korkeammat kellot ym kivaa. Ei enää, ei ainankaan läheskään yhtä usein ja homma hyytyy kokoajan lisää. Eli kyllä se on todella hyvä saavutus, kun ottaa huomioon, mitä kaikkea GPU:hun on myös ympätty lisää.Ei ole, piirit ovat paitsi pirusti isompia kuin edeltäjänsä, myös valmistettu pienemmällä prosessilla (vaikka se 12nm toki perustuu 16nm:ään se on ihan oikeastikin pienempi kuulemma)

Uutiset

-

Huawei julkisti kattauksen uusia tuotteita Madridissa – juoksijoille uusi Watch GT Runner 2 -älykello

26.2.2026 16:30

-

NVIDIAn päättynyt neljännes rikkoi jälleen yhtiön ennätyksiä

26.2.2026 12:00

-

Samsung esitteli Galaxy Unpackedissa uudet Galaxy Buds4 -sarjan nappikuulokkeet

25.2.2026 21:58

-

Lenovo varoittaa tietokoneidensa hintojen pomppaavan maaliskuussa

25.2.2026 20:23

-

Samsung julkisti uudet Galaxy S26 -sarjan puhelimensa vuoden 2026 ensimmäisessä Unpacked-tilaisuudessa

25.2.2026 20:00

Uusimmat viestit

-

-

-

-

Poliittiset ja yhteiskunnalliset asiat videopeleissä

- Viimeisin: P c L A Y E R