Palaten aikaisempaan keskusteluun 7nm yieldeistä, tässä taas yksi esimerkki, eli selkeästi hinnoittelun kautta on nähtävissä että AMD haluaa myydä pääasiassa 6-ytimen versioita Zen3:sta. Jos piirien yieldit olisivat tosiaan 93% tässä ei olisi mitään järkeä vaan piirit kannattaisi hinnoitella niin että myynti koostuisi pääosin 8-ytimen piireistä ja noita rampautettuja versioita myytäisiin sen verran mitä niitä luonnostaan syntyy. -> todelliset toteutuvat saannot 8-ytimen chipleteille on paljon huonommat ja AMD hinnoittelullaan koittaa pitää huolen siitä että pääosa myytävistä piireistä voidaan valmistaa pelastetuista 6-ytimisistä versioista.

Aivan, Zen 2:ssa AMD sai hitosti hyötyä siitä että ne voi ottaa yhdestä CCXs kolme toimivaa ydintä unohtaen sen yhden, ja "liimailla" näistä eri konfiguraation prossuja.

Nyt kun AMD myös tekee isoja 8 ytimen CCX:siä niin tilanne on hyvin eri. Mielestäni mä mainitsin aiemmin että se chiplet systeemi(käytin kai väärää termiä tai en selittänyt täsmällisesti mihin vittasin) oli halpa mutta tulevat eivät tule olemaan, ja joku väitti että nää tulevat eivät tule olemaan sen kalliimpia kuin Zen 2.

Tässä on paljon ollut juttua noista saannoista joista en ymmärrä tuon taivaallista. Mutta, kannattaa muistaa että hintat on kuitenkin vähemmän riippuvainen tuotantokustannuksista.

Zen 3:n hintoihin vaikuttavista tekijöistä:

Ymmärtääkseni Zen 2:sta ei juurikaan käytetty OEM pöytäkoneissa. OEM valmistajat myyvät lähes kaikki tietokoneet. Pienet nyrkkipaja OEM:t ja komponetteina koneensa hankkivat ovat pieni vähemmistö. JOS Zen 3 pääsee nyt kunnolla OEM valmistajien koneisiin, sinne menee valtavasti hieman huonompia piirejä. Se muuttaisi sitä asetelmaa minkä verran ja millaisia Zen 3 piirejä voidaan myydä Ryzeneinä, mitkä Epyc:nä ja TR vielä lopuksi, luulen kyllä ettei TR ole kovin merkittävä näistä kolmesta/neljästä segmentistä.

Teho: Zen 3 nyt selvästi vastaa 10 gen Inteliä. 11th gen tulee olemaan Intelille merkittävä edistysaskel, muttei, uskoisin, niin suuri happaus suorituskyvyssä. Kilpailutilanteen kautta tulee se hinta. R5 5600x ei kilpaile jotain kerroinlukittua i5:sta vastaan, vaan nyt suoraan 10600K:ta. Jne. Joten nää on kaikki sitä myöten kalliimpia. Ei se pelkkä R5 määrittele hintaa tai segmenttia, vaan sen R5:n suorituskyky.

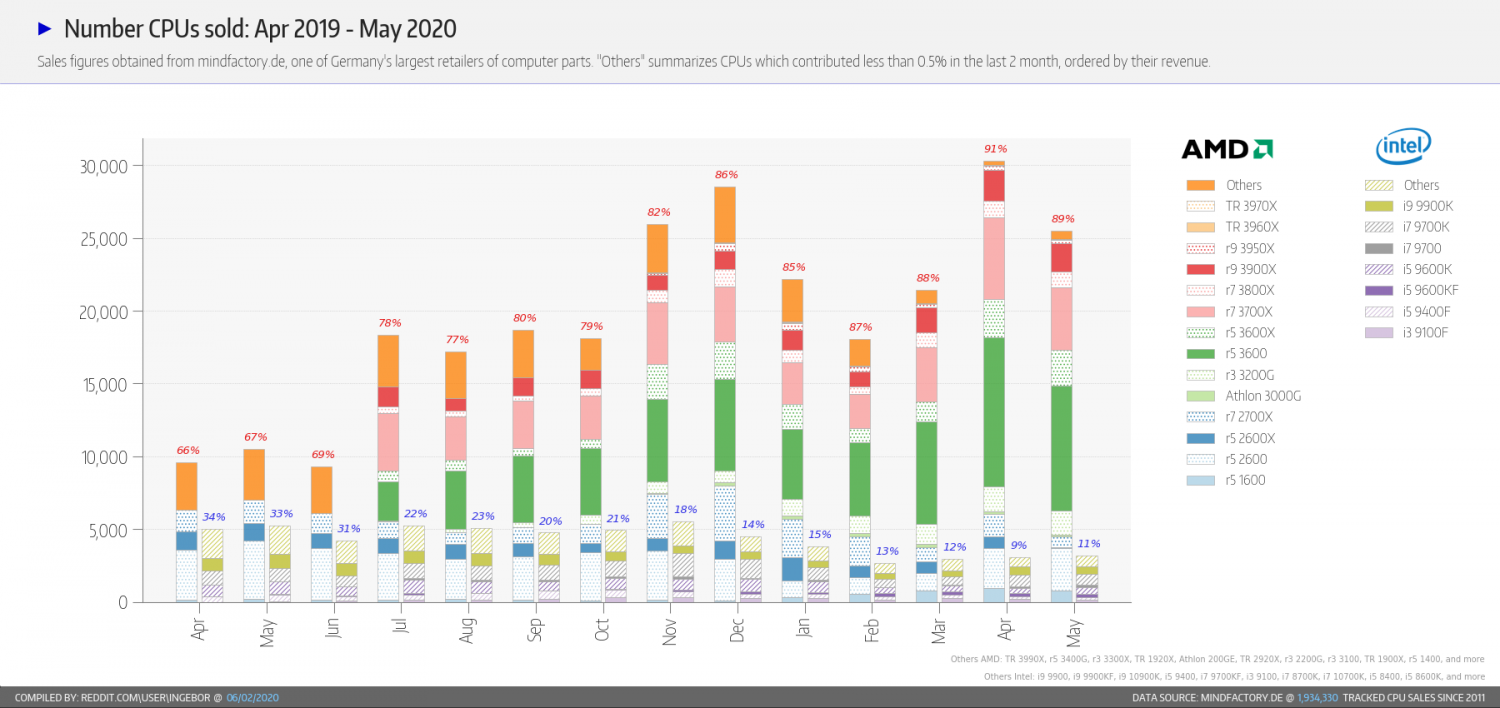

Kolmatta unohtamatta:

Jätän tarkoituksella nämä sen tarkemmin selittämättä. Sanotaan vain että Mindfactory on tarpeeksi iso myyntimääriltään että heidän tilastonsa kertovat tilanteesta yleisesti. Mutta tuossa näkyy aika selkeästi jotain joka hyvin voi nostaa Zen 3:n hintaa ellei jokin muu sitä estäisi. (siis nostaa suhteessa Zen 2:een) Siis käytännössä tuo olisi ilmoitetuissa hinnoissa jo mukana.

Pitäisikö yhtälöön ottaa myös se, että kuinka kauan prosessori olisi käytössä? Eikö nyt ole jo pelejä joissa esim. 6C6T prosessorit alkavat pahimmillaan tukehtua? Kysyn ihan sen vuoksi etten tiedä vastausta

Tällä hetkellä on muutamia pelejä joissa 6/12 toimii selvästi nopeammin kuin 6/6. Itse ostin just tuossa pari kuukautta sitten 9600k:n. Paras mahdollinen valinta olisi mulle ollut 3300X.

Maksimaalisen vähän rahaa kiinni sekä prossuun että emoon. Joku tuossa edelliselläkin sivulla sanoi saman. Sillä olisi helposti pärjännyt 4k peleissä monta vuotta, ja sitten päivittää pelkkä prossu vaihtamalla johonkin 6 tai mahdollisesti 8 ytimiseen Zen 2 tai Zen 3, riippuen hinnoista. Mä en silloin keväällä/kesällä enkä vieläkään edes haaveile mistään 8 ytimisestä, en usko että suhteellisen vaatimattoman budjetin luokassa sille saa mitään hyötyä peleissä, verrattuna jos pitää ne rahat ja laittaa ne näyttiksen päivitykseen 3 vuoden päästä.

Mutta AMD ei halunnut mun rahojani kun ei valmista tai kertonut mitään tuon prosessorin tulevaisuudesta. Luultavasti se on pysyvästi lopetettu, mutta AMD ei ilmoittele tuollaisista. Joten 9600k:n sain parempaa vastinetta rahalle kuin ainosta järkevästä verrokista eli se R5 3600. Jos en olisi hieman enakkoon tuota hankkinut kun tässä vielä odotellaan 3070:as, niin en ihan äkkiseltään tiedä mikä tässä hetkessä ja nyt olisi valintani. Zen 3 on silti aika kallis, en haluaisi laittaa 300 euroa pelkkään prosessoriin.

6/6 suorituskyky ei ole kovin relevanttia enää, kun mahdollisia malleja joita voi ostaa on niin vähän. Jos joku miettii jonkun 8 ytimisen Zen 2:n ja 6 ytimisen Zen 3:n välillä, olen aika varma että seuraavat 4 vuotta jälkimmäinen antaa paremman vastineen rahoille peleissä. Toki noiden vanhojen 8 ytimisten ja isompienkin hinnat tippuvat nyt Zen 3:n alla, ja se porukka joka aina tykkää uusimmasta suht high end kamasta päivittää Zen 3:een, niin voi saada käytettynä edullisemmin parempia 8 ja 8+ malleja, siis erityisesti näitä X ja XT malleja. Toki laskennallisesti joku R5 2600 tai myös 3600 antaa enemmän suorituskykyä per euro, mutta ei niitä enää kenekään kannata hetkeäkään harkita, ellei budjetti ole todella vaatimaton.

Eli syy miksi esim. 2600K oli niin hyvä prosessori ja käytännössä osa vasta nyt noin 10 vuoden käytön jälkeen (otaksuen että hankkivat uuden prosessorin 2021 alkuvuodesta) siirtyy AMD:n uusiin prosessoreihin/emoihin tai kuten itse tein vasta 2017 hankin seuraavan prosessorini johtui ihan siitä että Intel nysväsi ja jopa tahallaan esti useamman ytimen käyttöönoton peruskuluttajamalleissa.

Todella valtava ajatusvirhe.

AMD:stä se nimenomaan johtui. Jokainen yritys tietää että sisäinen kilpailu on todella huono. Jokunen firma on mennut konkurssiin sitä yrittäessä. Ei ole mitään järkeä alkaa kilpailemaan omien tuotteiden kanssa. Suurille yrityksille se ei olisi edes helpolla laillista.

AMD oli kyvytön kilpailemaan Intelin kanssa. Verrattain hidas kehitys johtui tästä ja vain tästä.

jolloin ostamalla 5950X prosessorin ja kellottamalla sen (jos se onnistuu) esim. ~5GHz se riittäisi oikein hyvin seuraavat ~10 vuotta käyttöä vaikka uudemmat prosessorit ehtisivät saada noin 20% tehonlisäystä (2600K vs 7700K).

Kuten yllä mainittu, ne olosuhteet eivät ole enää olemassa mitä jollain Sandy Bridgellä oli. Ne olosuhteet ovat hyvin dramaattisesti muuttuneet.

Kymmenen vuoden päästä 5950X tulee olemaan välttävä suorituskyvyltään, monet uudet läppärit ovat siinä aikana menneet jo sen ohi.

Ehkä 10 vuoden jälkeen myös kokonaismyynnissä näkyy muutos joka lisää kilpailua ja siten kehityksen nopeutta(Kiina ja Intia). Mutta sitä ei vielä tule näkymään 5 vuoden jälkeen.

6- ja 8-ydin mallien hintatasossa näkyy selvästi tarve pitää zen2:set pois polkumyynnistä. Zen2:sia ei kannata puoli-ilmaiseksi myydä kun niiden kysyntä ei ole vähentynyt tämän vuoden aikana.

Jep, Zen 2 voi edelleen olla tuotannossa. Zen 2 palvelee paikkaansa alemmassa hintaluokassa. Mutta Zen 3:lla täytyy olla jotain millä se voi olla kalliimpi kuin Zen 2. Suorituskyky, ja sitä sillä on.