-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Virallinen: NVIDIA vs AMD (vs Intel) keskustelu- ja väittelyketju

- Keskustelun aloittaja Sampsa

- Aloitettu

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Powering Next-Generation Gaming Visuals with AMD RDNA 2 and DirectX 12 Ultimate

AMD has long been a strong supporter of next-generation, low-overhead graphics API technologies like Microsoft® DirectX® 12 that help take games to a whole new level. Therefore, we’re pleased to announce that in partnership with Microsoft we will provide full support for DirectX® 12 Ultimate in...

Puoliso tosiaan hätähousuna osti uuden tietokoneen mutta prosessorin kanssa striimamisessa oli alussa ongelmia niin vaihdoin koneeni rtx 2060 superin(koska nvenc) siihen ja hänen rx 5700 xt omaan koneeseeni.

Pakko sanoa että todella tyytyväinen tähän näytönohjaimeen, mitään bugeja ei ole tullut vastaan, pelit toimii hienosti tosin eipä taida merkittävää eroa olla tehoissa verrattuna vanhaan.

Nvidian ohjaimissa on ollut taloudella gtx 1060 läppärissä ja rtx 2060 superin kanssa ongelmana ohjelmat joista ei saa laitteistokiihdytystä pois josta tulee välillä sellaista kuvaviirua.

Pakko sanoa että todella tyytyväinen tähän näytönohjaimeen, mitään bugeja ei ole tullut vastaan, pelit toimii hienosti tosin eipä taida merkittävää eroa olla tehoissa verrattuna vanhaan.

Nvidian ohjaimissa on ollut taloudella gtx 1060 läppärissä ja rtx 2060 superin kanssa ongelmana ohjelmat joista ei saa laitteistokiihdytystä pois josta tulee välillä sellaista kuvaviirua.

- Liittynyt

- 13.12.2016

- Viestejä

- 5 534

Kerranki NVIDIA julkaisee jotain avointa, kun julkaisi laiteriippumattoman SDK:n pelien kehittäjille. Tuon avulla pelien Global Illuminationin laskentaan voidaan helposti käyttää raytracingiä DXR rajapinnan kautta kaikkilla DXR rajapintaa tukevilla näyttiksillä. Eli ei vaadi mitään erillistä RayTracing rautaa kortilta.

www.guru3d.com

www.guru3d.com

NVIDIA Releases SDK allowing Global Illumination through Ray-Tracing for any GPU supporting DXR

Nvidia released a new developer toolkit called Nvidia's RTX Global Illumination SDK v1.0 (RTXGI), which aims to provide all the tools necessary to provide scalable lighting solutions across all Direc...

knz0

300 yard drive

- Liittynyt

- 02.11.2016

- Viestejä

- 1 354

AMD:n grafiikka-IP:tä varastettu ja heitetty githubiin (josta sittemmin poistettu)

torrentfreak.com

torrentfreak.com

AMD Uses DMCA to Mitigate Massive GPU Source Code Leak (Updated) * TorrentFreak

AMD has filed at least two DMCA notices against Github repos that carried "stolen" source code relating to AMD's Navi and Arden GPUs, the latter being the processor for the upcoming Xbox Series X. The person claiming responsibility for the leak informs TorrentFreak that if they doesn't get a...

Vermon

Ph.D. in Wisdom Sciences

- Liittynyt

- 17.10.2016

- Viestejä

- 484

On jo uutisissa.AMD:n grafiikka-IP:tä varastettu ja heitetty githubiin (josta sittemmin poistettu)

AMD Uses DMCA to Mitigate Massive GPU Source Code Leak (Updated) * TorrentFreak

AMD has filed at least two DMCA notices against Github repos that carried "stolen" source code relating to AMD's Navi and Arden GPUs, the latter being the processor for the upcoming Xbox Series X. The person claiming responsibility for the leak informs TorrentFreak that if they doesn't get a...torrentfreak.com

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Mitäs tuhnuraati on mieltä tästä?

www.reddit.com

www.reddit.com

Vaikuttaisi siis että ratukoissa parempi väritoisto.

Reddit - The heart of the internet

Vaikuttaisi siis että ratukoissa parempi väritoisto.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 760

Ei parempi vaan erilainen (vakiona). Aina ollut eri valmistajilla vähän erilaiset näkemykset siitä millaisena asiat siihen näytölle piirretään. Se että PS4:ssä ja Radeoneilla on samanlainen kuva on ihan luonnollista kun Radeon siellä PS4:ssäkin on.Mitäs tuhnuraati on mieltä tästä?

Reddit - The heart of the internet

www.reddit.com

Vaikuttaisi siis että ratukoissa parempi väritoisto.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 957

Oikea kysymys on: kumpi näyttää oikein?

En tässä vaiheessa usko tällaista eroa olevan.

EDIT: Pikaisen testauksen jälkeen Resident Evilissä on aivan ilmeistä, että Ratukan kuvassa on syötetty näytölle 0-255 signaalia näytön odottaessa 16-235-signaalia. NVidialla taas on syötetty 0-255 signaalia näytön odottaessa 0-255 signaalia. Saan nuo tasan samat tulokset säätämällä telkkarista black level low-high välillä ihan vaihtamatta korttia. Eli kuvista NVidia näyttää Resident Evilin oikein. Uskon AMD:kin näyttävän oikein, jos vain signaali täsmättäisiin näyttölaitteen kanssa.

En tässä vaiheessa usko tällaista eroa olevan.

EDIT: Pikaisen testauksen jälkeen Resident Evilissä on aivan ilmeistä, että Ratukan kuvassa on syötetty näytölle 0-255 signaalia näytön odottaessa 16-235-signaalia. NVidialla taas on syötetty 0-255 signaalia näytön odottaessa 0-255 signaalia. Saan nuo tasan samat tulokset säätämällä telkkarista black level low-high välillä ihan vaihtamatta korttia. Eli kuvista NVidia näyttää Resident Evilin oikein. Uskon AMD:kin näyttävän oikein, jos vain signaali täsmättäisiin näyttölaitteen kanssa.

Viimeksi muokattu:

Eli radeoni vaihtaa telkkarin väriasetuksia? Vai meinaatko että syöttölaitteen vaihtamisen yhteydessä on tarkoitushakuisesti vaihdettu telkkarin asetuksia välissä?Oikea kysymys on: kumpi näyttää oikein?

En tässä vaiheessa usko tällaista eroa olevan.

EDIT: Pikaisen testauksen jälkeen Resident Evilissä on aivan ilmeistä, että Ratukan kuvassa on syötetty näytölle 0-255 signaalia näytön odottaessa 16-235-signaalia. NVidialla taas on syötetty 0-255 signaalia näytön odottaessa 0-255 signaalia. Saan nuo tasan samat tulokset säätämällä telkkarista black level low-high välillä ihan vaihtamatta korttia. Eli kuvista NVidia näyttää Resident Evilin oikein. Uskon AMD:kin näyttävän oikein, jos vain signaali täsmättäisiin näyttölaitteen kanssa.

knz0

300 yard drive

- Liittynyt

- 02.11.2016

- Viestejä

- 1 354

Postauksen kommenttiosio on loistava esimerkki vahvistusvinoutumasta joka on toki yleistä kun fanituksen kohteena oleva firma on vähän liian lähellä sydäntä vaikuttaen loogiseen ajattelukykyyn.Mitäs tuhnuraati on mieltä tästä?

Reddit - The heart of the internet

www.reddit.com

Vaikuttaisi siis että ratukoissa parempi väritoisto.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 957

Eli radeoni vaihtaa telkkarin väriasetuksia? Vai meinaatko että syöttölaitteen vaihtamisen yhteydessä on tarkoitushakuisesti vaihdettu telkkarin asetuksia välissä?

Radeoni tuskin vaihtaa telkkarin asetuksia. Radeonilla saattaa esim. telkkarin automaattinen signaalintunnistus pettää. Mutta jotain hämminkiä tuossa nyt on. Voihan tuo olla valhetta koko postaus ja tarkoituksella säädetty niin, että oman lempifirman tuote näyttää paremmalta. Vaikkakin näyttää tuossa tapauksessa kuvan väärin, jota alkuperäinen kirjoittaja ei selvästikään ymmärtänyt. Usein enemmän saturaatiota ja keinotekoisesti venytetty kontrasti = paremmat värit, kun perusjampalta kysytään.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Radeoni tuskin vaihtaa telkkarin asetuksia. Radeonilla saattaa esim. telkkarin automaattinen signaalintunnistus pettää. Mutta jotain hämminkiä tuossa nyt on. Voihan tuo olla valhetta koko postaus ja tarkoituksella säädetty niin, että oman lempifirman tuote näyttää paremmalta. Vaikkakin näyttää tuossa tapauksessa kuvan väärin, jota alkuperäinen kirjoittaja ei selvästikään ymmärtänyt. Usein enemmän saturaatiota ja keinotekoisesti venytetty kontrasti = paremmat värit, kun perusjampalta kysytään.

Reddit - The heart of the internet

Saattaapi siis johtua AUO:n paneeleista.

EDIT: Ja siitä että nvidialla ei ole dithering käytössä kuin quatroilla.

Joo jotakin tossa on pielessä. Jos se telkkari amd:n näyttiksellä päättää säätää asetuksiaan kuten väitit, niin eikö se johtaisi siihen että tummat ja vaaleat menevät enemmän tukkoon kontrastin kasvaessa? (0-255 -> 16-235 muunnoksessa 15 tumminta harmaansävyä tulkittaisiin mustana) Noi linkatut pelikuvat viittaavat aivan toiseen, eli siihen että nvidialla menee tummat tukkoon. (eka kuva)Radeoni tuskin vaihtaa telkkarin asetuksia. Radeonilla saattaa esim. telkkarin automaattinen signaalintunnistus pettää. Mutta jotain hämminkiä tuossa nyt on. Voihan tuo olla valhetta koko postaus ja tarkoituksella säädetty niin, että oman lempifirman tuote näyttää paremmalta. Vaikkakin näyttää tuossa tapauksessa kuvan väärin, jota alkuperäinen kirjoittaja ei selvästikään ymmärtänyt. Usein enemmän saturaatiota ja keinotekoisesti venytetty kontrasti = paremmat värit, kun perusjampalta kysytään.

Väitänkin siis että noiden testikuvien perusteella nvidian näyttis saa aikaan tilanteen jossa näyttö tulkitsee 0-255 signaalin videotasoisena. Edit: ei kyllä noinkaan voi toimia koska silloin myös vaaleiden sävyjen tulisi mennä tukkoon, joka ei testikuvissa pidä paikkaansa. Ero vaikuttaisi olevan vain kirkkaudessa.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 957

Noissa kuvissa Resident Evil ja DOA käyttäytyvät täysin päinvastoin kullakin väitetyllä kortilla, mikä vain lisää minun fiilistä, että tuo kirjoittaja manipuloi tuloksia. Näitä näkee aina.

Ditheröintikään ei tummenna tai vaalenna kuvaa.

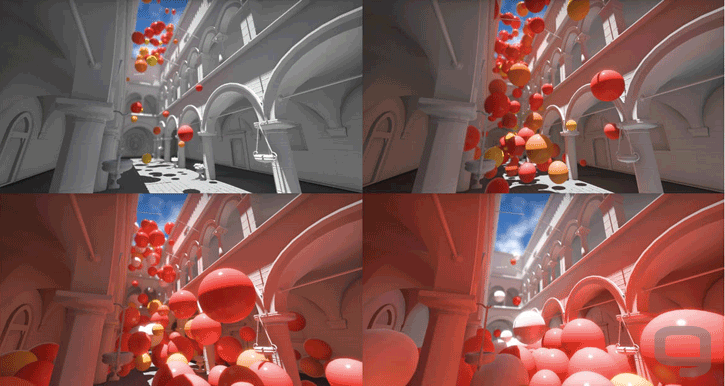

Tässäpä ottamani esimerkki. Hienosti näkyy juuri ne asiat joita redditin jamppa otti esille. Tummemmat ikkunat, saturoidumpi vihreä seinä ja niin pois päin. Alemmassa "paremmassa" kuvassa menee 0-255 signaalia 16-235 näyttölaitteelle, eli alempi kuva näyttää värit väärin. Täytyykö siis tulkita, että Ratukka on huonompi?

Ditheröintikään ei tummenna tai vaalenna kuvaa.

Tässäpä ottamani esimerkki. Hienosti näkyy juuri ne asiat joita redditin jamppa otti esille. Tummemmat ikkunat, saturoidumpi vihreä seinä ja niin pois päin. Alemmassa "paremmassa" kuvassa menee 0-255 signaalia 16-235 näyttölaitteelle, eli alempi kuva näyttää värit väärin. Täytyykö siis tulkita, että Ratukka on huonompi?

Viimeksi muokattu:

Ja ekassa kuvaparissa nvidia piirtää väärin, joten tasapeli?Noissa kuvissa Resident Evil ja DOA käyttäytyvät täysin päinvastoin kullakin väitetyllä kortilla, mikä vain lisää minun fiilistä, että tuo kirjoittaja manipuloi tuloksia. Näitä näkee aina.

Ditheröintikään ei tummenna tai vaalenna kuvaa.

Tässäpä ottamani esimerkki. Hienosti näkyy juuri ne asiat joita redditin jamppa otti esille. Tummemmat ikkunat, saturoidumpi vihreä seinä ja niin pois päin. Alemmassa "paremmassa" kuvassa menee 0-255 signaalia 16-235 näyttölaitteelle, eli alempi kuva näyttää värit väärin. Täytyykö siis tulkita, että Ratukka on huonompi?

Tossa sun kuvassa voi muuten kyseessä yhtälailla olla se että nvidia tuuttaa 16-235 signaalia pc tasoiselle näytölle. Tällä saadaan myös sama ero noiden kuvien välille. Pitäisi saada pakkaamattomat kuvat signaalikaapattuna jotta voidaan olla varmoja siitä että mistä on kyse.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 957

Ja ekassa kuvaparissa nvidia piirtää väärin, joten tasapeli?

En usko mitään, mitä redditin jamppa kirjoittelee. Olen vakuuttunut, AMD ja NVidia toistaisivat värit niin samankaltaisesti, ettei niitä erottaisi toisistaan, jos värisignaalit olisi vain kohdillaan. En yllättyisi, jos mr. redditillä olisi vain AMD:n kortti ja ramplannut värisäätöjä saadakseen eroa ja valehtelee silmät päästään. Joillakin fanitus on sairaalla tasolla.

Tossa sun kuvassa voi muuten kyseessä yhtälailla olla se että nvidia tuuttaa 16-235 signaalia pc tasoiselle näytölle. Tällä saadaan myös sama ero noiden kuvien välille. Pitäisi saada pakkaamattomat kuvat signaalikaapattuna jotta voidaan olla varmoja siitä että mistä on kyse.

Nuo on ihan testikuvilla tarkistettu. Ylemmässä näyttis tuuttaa RGB 0-255 ja telkkari odottaa 0-255:ttä. Alemmassa näyttis tuuttaa myös RGB 0-255 mutta telkkari odottaa 16-235:ttä. Huomaa, kuinka esim. istuimen alla oleva ritilä katoaa kokonaan alemmassa kuvassa, kun tummimmat 16 sävyä leikataan surutta pois. Jos lähetettäisiin 16-235 signaalia 0-255 näytölle, niin kuva haalenisi tuosta ylemmästä kuvasta entisestään.

Millä testikuvilla?Nuo on ihan testikuvilla tarkistettu.

- Liittynyt

- 17.10.2016

- Viestejä

- 2 957

Millä testikuvilla?

Eikä noihin testikuvia edes tarvita. Jos telkkari odottaa jotain muuta kuin näyttis antaa niin se on ihan ilmeistä muutenkin.

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

Nämä RX 5700 ajuriongelmat ovat Nvidialaisten täydenkuun aikaa. Jokainen vuorollaan suorittaa rituaalin, jossa käydään aukomassa päätä keskustelussa, jossa jaellaan hyvähenkisesti neuvoja ongelmista kärsiville. Ikävä tosiasia, että kaikki ajuriongelmiksi koetut eivät ole olleet ajuriongelmia. Ratkaisuja on löytynyt hyvin erinäisillä tavoilla, ja emolevyjen PCI-E -porttien toiminnasta myös paljastunut ongelmia.

Vielä kerran, yhteensopivuus kulkee kahteen suuntaan. Monella pelkästään PCI-E autoasetuksen vaihto on auttanut ongelmiin. Onko vika tällöin kuitenkin ollut AMD:n? Eikö emolevyjen valmistajilla ole mitään vastuuta PCIE-porttien toiminnasta? Kaiken järjen mukaan on.

Kumma et Nvidialla ei tarvii vaihella PCI-E asetuksia.

- Liittynyt

- 18.09.2019

- Viestejä

- 215

AMD Radeon RX 5700 XT Väylä: PCI Express 4.0, GeForce RTX 2080 Super Väylä: PCI-Express 3.0 x16Kumma et Nvidialla ei tarvii vaihella PCI-E asetuksia.

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

AMD Radeon RX 5700 XT Väylä: PCI Express 4.0, GeForce RTX 2080 Super Väylä: PCI-Express 3.0 x16

- GPU. Radeon VII, 7nm FinFET. VEGA Architecture.

- Engine Clock. Up to 1750 MHz Boost.

- Stream Processors. 3840.

- Memory Size/Bus. 16GB/4096-bit.

- Memory Clock. 1000 MHz, Effective 2000.

- Displays. Maximum 4 Displays.

- Resolution. DisplayPort: 5120×2880@60Hz. HDMI: 4096×2160@60Hz.

- Interface. PCI-Express 3.0.

Tämän tason nollapostaukset kuuluu ennemmin väittelyketjuun kuin tänne. Muutenkin vituttaa lukea tätä samaa saikkausta joka toisesta ketjusta. Jos ei oo mitään sanottavaa Navista, niin miksi edes vaivautua kommentoimaan jotain "Nvidia on paras"?

Miksi kommentoisin Nvidian olevan paras, kun AMD on paras. Harmillista vaan, että ajurit on mitä on.

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

Millonka AMD:llä on viimeksi ollut ongelmaton launchi uuden näykyttimen kanssa? Joudutaan menemään aika kauas taakse päin. Navi on nyt ollut aikamoinen fiasko, halusi psykooseissaan mitä tahansa muuta väittääkkään. VII kellotus ei toiminut lainkaan, vai muistanko väärin? Vegan launchissa oli ajureissa vaikka ja mitä ongelmaa ja Polariksenkaan launchi ei mennyt ihan putkeen. Ei kovinkaan mairittelevalta näytä.

Niin ja lisäksi VII toiminut jo pitkään, mutta päättivät samat bugit siirtää siihenkin.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Asiaton käytös

- GPU. Radeon VII, 7nm FinFET. VEGA Architecture.

- Engine Clock. Up to 1750 MHz Boost.

- Stream Processors. 3840.

- Memory Size/Bus. 16GB/4096-bit.

- Memory Clock. 1000 MHz, Effective 2000.

- Displays. Maximum 4 Displays.

- Resolution. DisplayPort: 5120×2880@60Hz. HDMI: 4096×2160@60Hz.

- Interface. PCI-Express 3.0.

Miksi kommentoisin Nvidian olevan paras, kun AMD on paras. Harmillista vaan, että ajurit on mitä on.

No mitä nyt vittua? Todistelet että seiskatta on PCIE 3.0 on puhutaan RX5000 sarjasta? Korkki kii nyt.

Qwerty

.

- Liittynyt

- 17.10.2016

- Viestejä

- 1 125

Lähinnä kai se, että myös Radeon VII kärsii nykyään osalla käyttäjistä samoista ongelmista kuin RX5000 sarjan kortit. Niin tuskin se PCIE 4 aiheuttaa noita ongelmia.No mitä nyt vittua? Todistelet että seiskatta on PCIE 3.0 on puhutaan RX5000 sarjasta? Korkki kii nyt.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 760

Ei varmasti kaikkia maailman mustia ruutuja, mutta osan selvästikin kyllä, kun kerran sillä on monella ongelmat tai osa ongelmista korjaantunut. Myöhemmät BIOSit ovat toki parantaneet tilannetta myös sillä PCIe4:llä niiden kohdalla joilla sen suhteen ongelmia on ollutLähinnä kai se, että myös Radeon VII kärsii nykyään osalla käyttäjistä samoista ongelmista kuin RX5000 sarjan kortit. Niin tuskin se PCIE 4 aiheuttaa noita ongelmia.

(itselläkin on PCIe4 käytössä Asuksen Prime X570 Pro -lankulla 5700XT:n kanssa, ei käryä onko se aiheuttanut yhtään niistä sormin laskettavista kerroista kun on yli puolen vuoden aikana tullut noita mustia ruutuja)

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

No mitä nyt vittua? Todistelet että seiskatta on PCIE 3.0 on puhutaan RX5000 sarjasta? Korkki kii nyt.

Puhuttiin kyllä ajureista.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 760

Siellä taisi yhdet puhua yhdestä, toiset toisesta ja kolmannet kolmansista. Ja ne kaikki liittyvät kuitenkin lopulta toisiinsa, osa mustista ruuduista on ihan ajurikamaa, luultavasti valtaosa ja ainakin ne mitä VII:llä tulee, mutta kaikki eivät ole olleet etenkään RX 5700 -sarjalla.Puhuttiin kyllä ajureista.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Puhuttiin kyllä ajureista.

Katohan nyt uudestaan sitä mitä lainasit. Siellä puhuttiin väylistä.

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

Katohan nyt uudestaan sitä mitä lainasit. Siellä puhuttiin väylistä.

ok

- Liittynyt

- 28.10.2016

- Viestejä

- 224

Onnistuuko?

Jahve3

Staff

- Liittynyt

- 16.10.2016

- Viestejä

- 1 255

Onnistuuko?

Joo, siellä luki ajureista, sekä väylistä.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Kumma et Nvidialla ei tarvii vaihella PCI-E asetuksia.

Tosi kumma joo, Nvidian ja AMD:n kortithan on kuin sisaruksia keskenään. Kumma että Nvidia on erillis-GPU:n kukkulankuningas ja käyttää reilusti enemmän resursseja kehitystyöhön ja ajureihin. Kumma että AMD:n korteissa on usein tehoissa mitattuna parempi hintalaatusuhde. Kumma että netin keskusteluista voi vetää aivan vääriä johtopäätöksiä ajureiden toimivuuden suhteen. Maailma on kumma paikka.

Lähinnä kai se, että myös Radeon VII kärsii nykyään osalla käyttäjistä samoista ongelmista kuin RX5000 sarjan kortit. Niin tuskin se PCIE 4 aiheuttaa noita ongelmia.

Tarkoitatko black screeneja? Noissa ongelman aiheuttajia on ollut useampia. Joillain RX5700 käyttäjillä joissain peleissä enchanced sync aiheutti noita black screeneja, joillain monitorointi softat ovat aiheuttaneet niitä, joillain on auttanut BIOS:in PCIE-tilan vaihtaminen. Vai liittyiköhän viimeksi mainittu niihin BSOD:eihin. No joka tapauksessa, en lähtisi laittamaan noita VII:n ongelmia ihan yksi-yhteen 5000-sarjan kanssa. Jos ongelman ratkaisujen kirjo on laaja, niin olisi omituista jos se ongelman aiheuttaja olisi kaikissa sama. Voihan siellä olla taustalla jotain samasta syystäkin johtuvia ongelmia, who knows.

- Liittynyt

- 09.12.2016

- Viestejä

- 2 237

Tosi kumma joo, Nvidian ja AMD:n kortithan on kuin sisaruksia keskenään. Kumma että Nvidia on erillis-GPU:n kukkulankuningas ja käyttää reilusti enemmän resursseja kehitystyöhön ja ajureihin. Kumma että AMD:n korteissa on usein tehoissa mitattuna parempi hintalaatusuhde. Kumma että netin keskusteluista voi vetää aivan vääriä johtopäätöksiä ajureiden toimivuuden suhteen. Maailma on kumma paikka.

Tarkoitatko black screeneja? Noissa ongelman aiheuttajia on ollut useampia. Joillain RX5700 käyttäjillä joissain peleissä enchanced sync aiheutti noita black screeneja, joillain monitorointi softat ovat aiheuttaneet niitä, joillain on auttanut BIOS:in PCIE-tilan vaihtaminen. Vai liittyiköhän viimeksi mainittu niihin BSOD:eihin. No joka tapauksessa, en lähtisi laittamaan noita VII:n ongelmia ihan yksi-yhteen 5000-sarjan kanssa. Jos ongelman ratkaisujen kirjo on laaja, niin olisi omituista jos se ongelman aiheuttaja olisi kaikissa sama. Voihan siellä olla taustalla jotain samasta syystäkin johtuvia ongelmia, who knows.

Et kai tosissaan sano, että monitorointisoftat aiheuttaa enhanced syncin kanssa ongelmia. Se on toisin päin.

AMD:llä on ollut kaikki aika testata niitä kortteja muutaman eniten käytetyimmän softan kanssa. Vaikka edes MSI afterburner. Mutta ei ilmeisesti ollut kiinnostusta tai taitoa saada niitä toimimaan.

- Liittynyt

- 17.10.2016

- Viestejä

- 447

Kumma että AMD:n korteissa on usein tehoissa mitattuna parempi hintalaatusuhde.

SI-järjestelmän mukaan mitattuna tämä kyllä pitää paikkansa

knz0

300 yard drive

- Liittynyt

- 02.11.2016

- Viestejä

- 1 354

Toi on vähän sitä että Ford syyttäisi Kehä I:n päällysteitä siitä että renkaat lentävät irti samalla kun Mersut ja Volkkarit toimivat ongelmitta.Et kai tosissaan sano, että monitorointisoftat aiheuttaa enhanced syncin kanssa ongelmia. Se on toisin päin.

AMD:llä on ollut kaikki aika testata niitä kortteja muutaman eniten käytetyimmän softan kanssa. Vaikka edes MSI afterburner. Mutta ei ilmeisesti ollut kiinnostusta tai taitoa saada niitä toimimaan.

- Liittynyt

- 12.12.2016

- Viestejä

- 4 950

SI-järjestelmän mukaan mitattuna tämä kyllä pitää paikkansa

Pitää se kyllä fps per € mitattunakin usein.

Esimerkiksi 5700XT on noin 5% halvempi (hinta.fi, halvimmat mallit) kuin 2060 super vaikka 5% suorituskykyisempi (techpowerup)

5600XT on vähän yli 5% hitaampi kuin RTX 2060, mutta hinnassa 15% ero. Tosin alaspäin ero tasoittuu, ja jopa kääntyy 1660 super tarjoaa 88% suorituskyvystä 85% hinnalla!

- Liittynyt

- 09.12.2016

- Viestejä

- 2 237

Eiköhän noissa hinnoissa näy se, että AMD:n näyttikset on epäluotettavia. Vaikka tehoa on äfpeeässissä enemmän, mieluummin otetaan 5% vähemmän tehoa, kuin musta ruutu. Itse tein tämmösen valinnan, ja maksoin 2070:sta enemmän ja myin oman 5700XT:n pois. Ei oo enää tullut mustia ruutuja.

- Liittynyt

- 18.10.2016

- Viestejä

- 3 264

Mulla ei ollut ongelmia HD5870, RX290, RX480 kanssa. Tämän 5700XT:n kanssa ollut jollain ajureilla ongelmia, mutta ei mitään pahoja. Nyt en muista milloin olis viimeks ollut mitään.Ei kyllä ihan vaan pelkästään uusimman sukupolven kanssa ole nuo amd:n ajurit olleet ongelmana, helpompi laskea sukupolvet joiden kanssa ei ole ollut ajurihäikkää

En tiedä että missä maailmassa elät mutta olihan ne ajurit paskaa ainakin RX 4xx ja RX 5xx aikanakin

Kai mä vaan osaan käyttää ATK:ta ja muut säätää.

AMD puolella vaan tuo piirisarjan ajureiden päivityskään ei ole mikään 100% selvä homma...

Tuli vaan huomattua, kun veljelle kasasin AMD koneen:

- Ryzen 5 3600

- MSI B450 Tomahawk MAX

- Gigabyte RX 5700XT Gaming OC

Täysin puhdas Windows asennus (juuri pakasta vedetty uusi kone) alla, ilman mitään edellisiä ajureita sotkemassa, AMD piirisarjan ajureiden asennus tervehtii 0% asennuspalkilla, eikä etene mihinkään, mutta kysyy jo boottimaan koneen välissä... (loput onkin tuurista kiinni, meneekö asennus läpi vai ei...)

AMD foorumeilla ongelmasta ketjua

Eikä kyllä millään tavalla vahvista luottoa AMD puoleen, kun näyttispuolen ajurit on olleet mitä on ja nytten ongelma jo laajenee piirisarjan asennuksenkin puolelle, toki olihan Ryzeneissä alunperin (lähinnä 1000-sarjan Ryzenit kaatuilut isoin ongelma) kaikkea pientä harmia, kunnes vähitellen bios päivitykset korjaili niitä.

Tuli vaan huomattua, kun veljelle kasasin AMD koneen:

- Ryzen 5 3600

- MSI B450 Tomahawk MAX

- Gigabyte RX 5700XT Gaming OC

Täysin puhdas Windows asennus (juuri pakasta vedetty uusi kone) alla, ilman mitään edellisiä ajureita sotkemassa, AMD piirisarjan ajureiden asennus tervehtii 0% asennuspalkilla, eikä etene mihinkään, mutta kysyy jo boottimaan koneen välissä... (loput onkin tuurista kiinni, meneekö asennus läpi vai ei...)

AMD foorumeilla ongelmasta ketjua

Eikä kyllä millään tavalla vahvista luottoa AMD puoleen, kun näyttispuolen ajurit on olleet mitä on ja nytten ongelma jo laajenee piirisarjan asennuksenkin puolelle, toki olihan Ryzeneissä alunperin (lähinnä 1000-sarjan Ryzenit kaatuilut isoin ongelma) kaikkea pientä harmia, kunnes vähitellen bios päivitykset korjaili niitä.

RX 5xxx sarjan PCI-E gen 4 näemmä rikkoo tuen vanhempien PCI-E gen 1 ja joidenkin gen 2 emojen kanssa.

Kun tuossa vasta irrottelin RX 5700:seni omasta koneestani ja laittelin vanhan testikorttini Vega 64:n sen tilalle, eli nyt tuleva prossujen testaus näytönohjaimeni on tuo RX 5700:n

Niin testailin sitä eri emoilla niin:

LGA775 (Asus P5K3 Deluxe) ja AM3 (Asus Crosshair III Formula) emoillani ei päästy edes POSTaus ruutuun = musta ruutu.

Sitten LGA1156 (Asus P7P55D Deluxe) ja LGA1366 (Asus Rampage III Extreme) emoillani ExpressGate pitää olla aktivoituna BIOSista taikka kun käyttistä pitäisi alkaa lataamaan niin musta ruutu. Mutta jostain syystä tuo ExressGate korjaa tämän ongelman

Uudemmilla emoilla sitten ei ole mitään ongelmia, eli nuo AM3 prossut pystyn testaamaan AM3+ emollani (Asus Crosshair V Formula-Z).

Ja mainittakoon että vastaavia yhteensopivuus ongelmiin olen aikaisemminkin törmännyt, tosin Nvidian leirissä. Eli AM2+ Asus Crosshair 2 Formula emon Nvidian piirisarja ei tykännyt yhtään Geforce GTX 780 (ti) korteista vaan jämähti aina POSTaus ruutuun. Kun laittoi Radeon R9 290X:n tilalle niin ei ongelmia kuten tästä vanhasta Tweetistäni voitte nähdä:

Ja nyt kun tuo RX 5700 kävi testipenkissäni niin se on jopa 1950MHz:n kellotettuna todella hiljainen blower jäähystä huolimatta, kun tuo Vega 64:n piti alivoltittaa että päästiin kunnon Turbo kelloille ja silloinkin tuo oli/on aika suikumoottori luokkaa metelin osalta.

Muuten tämmöinen "helmi" tuli napattua tupla gpu kortti kokoelmiini, kun halvalla sain:

En tiedä miksi mutta tykkään noita harvinaisuuksia kerätä hyllyyni vaikka eihän noilla nykyään mitään tee. Ja tällä hetkellä noita siis löytyy jo:

ATI Radeon HD 3870 X2

ATI Radeon HD 4870 X2

AMD Radeon HD 5970

AMD Radeon HD 6990

AMD Radeon HD 7990

Nvidia Geforce GTX 590

Nvidia Geforce GTX 690

Kun tuossa vasta irrottelin RX 5700:seni omasta koneestani ja laittelin vanhan testikorttini Vega 64:n sen tilalle, eli nyt tuleva prossujen testaus näytönohjaimeni on tuo RX 5700:n

Niin testailin sitä eri emoilla niin:

LGA775 (Asus P5K3 Deluxe) ja AM3 (Asus Crosshair III Formula) emoillani ei päästy edes POSTaus ruutuun = musta ruutu.

Sitten LGA1156 (Asus P7P55D Deluxe) ja LGA1366 (Asus Rampage III Extreme) emoillani ExpressGate pitää olla aktivoituna BIOSista taikka kun käyttistä pitäisi alkaa lataamaan niin musta ruutu. Mutta jostain syystä tuo ExressGate korjaa tämän ongelman

Uudemmilla emoilla sitten ei ole mitään ongelmia, eli nuo AM3 prossut pystyn testaamaan AM3+ emollani (Asus Crosshair V Formula-Z).

Ja mainittakoon että vastaavia yhteensopivuus ongelmiin olen aikaisemminkin törmännyt, tosin Nvidian leirissä. Eli AM2+ Asus Crosshair 2 Formula emon Nvidian piirisarja ei tykännyt yhtään Geforce GTX 780 (ti) korteista vaan jämähti aina POSTaus ruutuun. Kun laittoi Radeon R9 290X:n tilalle niin ei ongelmia kuten tästä vanhasta Tweetistäni voitte nähdä:

Ja nyt kun tuo RX 5700 kävi testipenkissäni niin se on jopa 1950MHz:n kellotettuna todella hiljainen blower jäähystä huolimatta, kun tuo Vega 64:n piti alivoltittaa että päästiin kunnon Turbo kelloille ja silloinkin tuo oli/on aika suikumoottori luokkaa metelin osalta.

Muuten tämmöinen "helmi" tuli napattua tupla gpu kortti kokoelmiini, kun halvalla sain:

En tiedä miksi mutta tykkään noita harvinaisuuksia kerätä hyllyyni vaikka eihän noilla nykyään mitään tee. Ja tällä hetkellä noita siis löytyy jo:

ATI Radeon HD 3870 X2

ATI Radeon HD 4870 X2

AMD Radeon HD 5970

AMD Radeon HD 6990

AMD Radeon HD 7990

Nvidia Geforce GTX 590

Nvidia Geforce GTX 690

Oikea kysymys on: kumpi näyttää oikein?

En tässä vaiheessa usko tällaista eroa olevan.

EDIT: Pikaisen testauksen jälkeen Resident Evilissä on aivan ilmeistä, että Ratukan kuvassa on syötetty näytölle 0-255 signaalia näytön odottaessa 16-235-signaalia. NVidialla taas on syötetty 0-255 signaalia näytön odottaessa 0-255 signaalia. Saan nuo tasan samat tulokset säätämällä telkkarista black level low-high välillä ihan vaihtamatta korttia. Eli kuvista NVidia näyttää Resident Evilin oikein. Uskon AMD:kin näyttävän oikein, jos vain signaali täsmättäisiin näyttölaitteen kanssa.

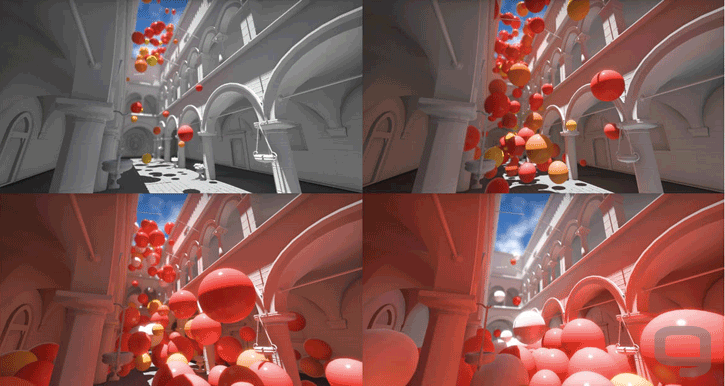

En tiedä tosta väristoistosta että muka niissä olisi jotain eroa leirien välillä, mutta Nvidia:lla on ollut banding ongelma iät ja ajat jos käytössä softacalibrointi (ICC) ja korttina ei ole ollut Quadro. Asia parani pari (kolme?) vuotta sitten kun Nvidia vihdoin ja viimein toi yli 8bit värituen myös kuluttajakortteihin jolloin calibroinnin LUT myös parani. Sitä ennen 10bit paneelin käyttö softacalibroinnila aiheutti lähinnä oksennusreaktion. AMD on käyttänyt +10bit LUT:ia(nykyään taitaa olla 16bit) jostain HD5000 sarjasta lähtien kun on ollut käytössä ICC profiili josta sitten on temporal ditheröity näytön haluamaan bittisyyteen. Siksi AMD:lla on ollut mahdollista säätää softalla värit ja gammat aivan poskelleen ilman jäätävää pykällystä.

Joskus muron aikoihin tästä tuli tehtyä ihan kunnon testiä kun oli käytössä direct drive 10bit paneeli.

Ja ennen kuin Nvidian valkoiset ritarit tulevat puolustamaan vihreää ylivoimaisuutta niin tämä ongelma ei ole koskettanut ketään jolla ei ole calibroitua ICC profiilia käytössä.

EDIT: siitä Nvidia vs AMD kun käytössä softacalibrointi. Katsokaa taivasta: AMD:n pykällys huomattavasti pienempi.

![unknown[1].png unknown[1].png](https://bbs.io-tech.fi/data/attachments/364/364391-4bc4ce2c553a8d3f3cf5de4499201bc7.jpg?hash=S8TOLFU6jT)

Viimeksi muokattu:

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Et kai tosissaan sano, että monitorointisoftat aiheuttaa enhanced syncin kanssa ongelmia. Se on toisin päin.

Kirjoitin:

Tarkoitatko black screeneja? Noissa ongelman aiheuttajia on ollut useampia. Joillain RX5700 käyttäjillä joissain peleissä enchanced sync aiheutti noita black screeneja, joillain monitorointi softat ovat aiheuttaneet niitä,

Eli joillain siis monitorointi softien sulkeminen auttanut peleissä blackscreeneihin. Enchanced syncin pois ottaminen auttanut joillain. Sitä en tiedä miten nuo monitorointi softat ja Enchanced sync liittyy tässä kontekstissa suoraan toisiinsa? Molemmat ovat siis aiheuttaneet joillain käyttäjillä joissain peleissä black screeneja. Vai pitääkö se muotoilla että: AMD on aiheuttanut ne, mutta monitorointi softan sulkeminen korjaa ne? Menee jo pilkunviilaamiseksi, kun jokainen varmaan ymmärsi pointtini jo aiemmin, mutta sama se.

Siitä olen samaa mieltä, että AMD voisi laittaa nämä toimimaan myös MSI Afterburnerin jne. kanssa. Osalla ilmeisesti toimiikin, ja toki AMD tarjoaa oman monitorointi softan, ja osa monitorointi softista ilmeisesti toimii, joten eiköhän jokainen saa haluamansa datan jotain kautta.

Missä se Nvidian oma monitorointi softa + kellotussofta muuten on? Onko Nvidialla mitään mahdollisuutta tehdä esim. pelikohtaisia asetuksia ja säätöjä? Tämä ihan vilpittömänä kysymyksenä. Ei se AMD:nkaan softa täydellinen ole, mutta itse tykkään noista pelikohtaisista säädöistä, ja itsellä ne säädöt pysyneet boottienkin jälkeen. Wattman oli aika kulmikas, mutta tuo Radeon Software on selvästi parempi. AMD tarjoaa mm. tekstuurioptimoinneilla lisää FPS:iä tuota softaa ja oikeita asetuksia käyttäville, ja itse olen peleissä noita eroja myös huomannut. Joutuuko Nvidialaiset edelleen ronklata Afterburneria, vai löytyykö sieltä experiencestä jotain hyödyllistä nykyään?

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Toi on vähän sitä että Ford syyttäisi Kehä I:n päällysteitä siitä että renkaat lentävät irti samalla kun Mersut ja Volkkarit toimivat ongelmitta.

Tämä on vähän sitä, kun Pasi lukee aapista väärin, ja Kalle komppaa.

Eiköhän noissa hinnoissa näy se, että AMD:n näyttikset on epäluotettavia.

Tai se että jotku Nvidialaiset ostaa vaikka vessapaperia, jos siinä on Nvidian logo. Esim. AMD:n Polarikset tarjosi erinomaista hintalaatusuhdetta, eikä noissa ole merkittäviä ajuriongelmia ollut. RX570 ja 580 ostajat saivat erinomaista vastinetta rahalleen, varsinkin kun hinnat lähti tippumaan, niin perf/€ arvo Nvidiaan nähden ylivoimainen, ja näiden ajurit olleet myös luotettavia.

Sitten tuli Navit, joissa ajuriongelmia (joista varmaan valtaosa jo korjattu?), jolloin vedetään johtopäätöksiä, että AMD:n näytönohjaimet ovat epäluotettavia. Joopa joo. Koittakaas nyt miettiä vähän isoa kuvaa taas. Mites ne Nvidian GTA5 ongelmat, Whea Errorit, 2080 black screenit yms. jakselee?

Requiem

For You

- Liittynyt

- 17.10.2016

- Viestejä

- 2 860

Joillakin on ongelmia ja toisilla ei vaikka täysin sama rauta. C'est la vie.AMD puolella vaan tuo piirisarjan ajureiden päivityskään ei ole mikään 100% selvä homma...

Tuli vaan huomattua, kun veljelle kasasin AMD koneen:

- Ryzen 5 3600

- MSI B450 Tomahawk MAX

- Gigabyte RX 5700XT Gaming OC

Täysin puhdas Windows asennus (juuri pakasta vedetty uusi kone) alla, ilman mitään edellisiä ajureita sotkemassa, AMD piirisarjan ajureiden asennus tervehtii 0% asennuspalkilla, eikä etene mihinkään, mutta kysyy jo boottimaan koneen välissä... (loput onkin tuurista kiinni, meneekö asennus läpi vai ei...)

AMD foorumeilla ongelmasta ketjua

Eikä kyllä millään tavalla vahvista luottoa AMD puoleen, kun näyttispuolen ajurit on olleet mitä on ja nytten ongelma jo laajenee piirisarjan asennuksenkin puolelle, toki olihan Ryzeneissä alunperin (lähinnä 1000-sarjan Ryzenit kaatuilut isoin ongelma) kaikkea pientä harmia, kunnes vähitellen bios päivitykset korjaili niitä.

Mutta sen hauskuus tulee siitä, että kyseessä oli suoraan "pakasta vedetty" uusi kone, täysin puhtaalla Windows asennuksella, että mielenkiintoista tosiaan jne... (pitääkö siinä asennuksessa tehdä jotain sadetanssia jne, että onnistuu 100% varmasti?)Joillakin on ongelmia ja toisilla ei vaikka täysin sama rauta. C'est la vie.

Ja asensitko siis nuo uusimmat piirisarjan ajurit, vai onko käytössä vanhempi ajuriversio?

Jos asensit, niin sehän on mielenkiintoista, että mikä sen laukaisee, kun kyseessä oli täysin puhdas Windows asennus, vasta pakasta vedetyllä raudalla tässä veljen koneessa...

Ja tosiaan on tuota ongelmaa ollut muillakin, kun tuota AMD foorumin ketjua lukee ja sielläkin ollut puhdasta Windows asennusta ja silti asennus jäätyy 0%...

Toki saa jäädä tähän tämä piirisarjan ajurit homma, kun ei ihan suoraan liity AMD vs Nvidia ketjuun, mutta ohimennen vain totesin, ettei se paljon puhuttu piirisarjan ajureidenkaan päivitys ole mikään varma juttu AMD raudalla.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Et kai tosissaan sano, että monitorointisoftat aiheuttaa enhanced syncin kanssa ongelmia. Se on toisin päin.

AMD:llä on ollut kaikki aika testata niitä kortteja muutaman eniten käytetyimmän softan kanssa. Vaikka edes MSI afterburner. Mutta ei ilmeisesti ollut kiinnostusta tai taitoa saada niitä toimimaan.

Eiköhän se afterburnerin tukeminen AMD:n taholta lopahtanut siihen kun alkoivat tarjota omassa softassaan overlay lukemia nörttien kyylättäväksi.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 639

Eikä kyllä millään tavalla vahvista luottoa AMD puoleen, kun näyttispuolen ajurit on olleet mitä on ja nytten ongelma jo laajenee piirisarjan asennuksenkin puolelle, toki olihan Ryzeneissä alunperin (lähinnä 1000-sarjan Ryzenit kaatuilut isoin ongelma) kaikkea pientä harmia, kunnes vähitellen bios päivitykset korjaili niitä.

Jos näillä jokaisella yksittäisellä ongelmalla lähdetään mittaamaan valmistajien luotettavuutta, niin ei tässä maailmassa ole yhtään luotettavaa firmaa. Miten esim. Nvidian whea errorit vaikuttavat sinun kuvaasi Nvidiasta? Entä joidenkin Nvidia käyttäjien ongelmat x570 piirisarjan kanssa. Tai GTA5 ongelmat. Tai 2080 black screenit?

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Jos näillä jokaisella yksittäisellä ongelmalla lähdetään mittaamaan valmistajien luotettavuutta, niin ei tässä maailmassa ole yhtään luotettavaa firmaa. Miten esim. Nvidian whea errorit vaikuttavat sinun kuvaasi Nvidiasta? Entä joidenkin Nvidia käyttäjien ongelmat x570 piirisarjan kanssa. Tai GTA5 ongelmat. Tai 2080 black screenit?

Vihreitten keskuudessa noita kutsutaan tervetulleiksi ominaisuuksiksi ja kumarretaan jensenin suuntaan.

Uutiset

-

Uusi artikkeli: Testissä Philips Evnia 27M2N6501L -pelinäyttö (QD-OLED)

23.2.2026 18:36

-

Oura siirtyy virallisesti Yhdysvaltoihin

20.2.2026 14:55

-

Donut Lab tiedotti julkaisevansa VTT:n tekemiä mittausraportteja ensi viikosta alkaen

20.2.2026 12:57

-

Microsoft esitteli Windows 11:n uutta Ask Copilot -ominaisuutta ja muita tekoälyuudistuksia

20.2.2026 08:45

-

Razer julkisti Huntsman Signature Edition -lippulaivanäppäimistön

20.2.2026 08:36