Tuossa lähdin testaamaan Hardware Unboxedin väitettä Nvidia ajuri overhead ongelmasta. Eli niiden mukaan jos prosessori jarruttaa menoa niin Ratukalla saa 20-30% enemmän fps kuin Geforcella.

Testikorteiksi otin tehokkaimmat kortit mitä hyllystäni löytyy eli AMD edustaa RX 5700 XT ja Nvidiaa Titan V.

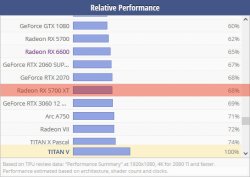

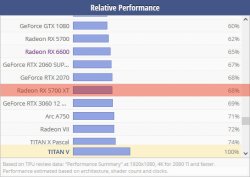

Ja kuten näemmä techpowerupin taulukoista että RX 5700 XT on about RX 2070 tehoinen ja tämä pitää paikkaansa kun olen molemmat testannut.

Titan V:n sitten pitäisi olla saamaa tasoa kuin RTX 2080 Ti eli huomattavasti RX 5700 XT nopeampi.

Sitten kummatkin testasin AC Valhallassa, Far Cry 6 ja Foza Horizon 5:ssa (siksi nämä koska näissä pelin sisäinen benchmarkkaus toiminto) kolmella eri setupilla.

Nopeinta edusti Ryzen 7 5700X, keskimmäistä Ryzen 7 2700X ja hitainta AMD FX-8320.

Kaikki oli säädetty sitten että prossuista ja muisteista revitään kaikki irti mitä niillä on annettavaa.

Joten pitääkö Hardware Unboxedin väite paikkaansa ?

Eipä oikeastaan.

Kyllä Ratukalla sai enemmän FPSiä, mutta erot johtuivat enemmänkin siitä että tuon Titan V arkkitehtuuri on vanhentunut todella heikosti.

Nimittäin RX 5700 XT hakkas sen kaikissa peleissä kaikilla eri prossuilla lukuun ottamatta yhtä.

Nimittäin AMD FX:llä Forza Horizon 5:ssa Titan V sai enemmän fps kuin Ratukka.

Se tästä testistä jäikin parhaiten mieleen kuinka hyvin haukuttu AMD FX pelejä vielä pyörittää ja kuinka heikko Titan V oli.

Nuo testit ajoin siis 1080p Ultra asetuksilla ja niillä AMD FX:llä oli pientä frametime eloa AC Valhallassa ja Far Cry 6:ssa.

Joten Extra kanavalle tein toisen testin jossa huvikseen kokeilin nuo pelit 1080p low asetuksilla Titan V ja RX 5700 XT:llä.

Ja low:lla RX 5700 XT voitti Forzassa ylivoimaisesti. Ja Ratukka tarjosi kautta linjan paremmat frametimet kuin Titani.

---------------------------------------------------------------------

Ensi perjantaina tulee oma testi video Titan V:stä ja tässä juuri sain testattua Titan X:n.

Ja voi pojat se on vanhentunut heikosti.

Tuossa vertailin edellisiin testeihini niin tuohan nykyään vastaa RX 580:stä.... kun aikoinaan GTX 980 oli jo nopeampi kuin RX 580:n

Ja siis kortti sai power limitti modin ja nestemetallitkin, eli kaikki yritin siitä repiä irti.

Tulikin huomattua siinä samalla että Nvidia ollut taas tyypillinen Nvidia.

Eli Nvidia ei tykkää että korttien vbioseja muokkaillaan ja näin saadaan niistä enemmän irti. Joten ennen riitti kun muokatulla NVflashillä (josta oli poistettu tuo aitouden tarkastus) ajo muokatun vbiosin sisään ja se oli siinä.

Nykyään ajurit tunnistaa onko vbiosia ronkittu vai ei.

Jos on, niin kone kaatuu windowsin latauksen siinä vaiheessa kun ajurit pitäisi ladata.

Sitten jos asennat ajureita ja vbios on muokattu niin taas kaatuu kone ja takaisin windowsiin ei ole mitään asiaa ennen kuin olet flashännyt orginaalin takaisin.

Tuossa testailin vielä kuinka FSR ja XeSS tuolla Titan X toimii, kun tuolla on semmoinen ongelma että grafiikka asetuksista viis kortti haluu jatkuvasti pyöri peleissä 50 - 70fps:ssä.

Ja kuten näette XeSS ei oikein toiminut silleen kuin piti:

Ilman kuvanpaskomis juttuja:

![2023-09-21 17-00-18.mp4_snapshot_00.10_[2023.09.22_09.31.22].jpg 2023-09-21 17-00-18.mp4_snapshot_00.10_[2023.09.22_09.31.22].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175199-b610370fd0415ca711e148a439055a32.jpg?hash=thA3D9BBXK)

FSR:

![2023-09-22 09-22-05.mp4_snapshot_00.14_[2023.09.22_09.30.29].jpg 2023-09-22 09-22-05.mp4_snapshot_00.14_[2023.09.22_09.30.29].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175200-4beea506bd9b73130524838ffb4fc216.jpg?hash=S-6lBr2bcx)

XeSS:

![2023-09-22 09-24-03.mp4_snapshot_00.16_[2023.09.22_09.30.51].jpg 2023-09-22 09-24-03.mp4_snapshot_00.16_[2023.09.22_09.30.51].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175201-8f5f9fa72587885469f7aa9d1a0d3a50.jpg?hash=j1-fpyWHiF)

![2023-09-21 17-00-18.mp4_snapshot_00.10_[2023.09.22_09.31.22].jpg 2023-09-21 17-00-18.mp4_snapshot_00.10_[2023.09.22_09.31.22].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175199-b610370fd0415ca711e148a439055a32.jpg?hash=thA3D9BBXK)

![2023-09-22 09-22-05.mp4_snapshot_00.14_[2023.09.22_09.30.29].jpg 2023-09-22 09-22-05.mp4_snapshot_00.14_[2023.09.22_09.30.29].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175200-4beea506bd9b73130524838ffb4fc216.jpg?hash=S-6lBr2bcx)

![2023-09-22 09-24-03.mp4_snapshot_00.16_[2023.09.22_09.30.51].jpg 2023-09-22 09-24-03.mp4_snapshot_00.16_[2023.09.22_09.30.51].jpg](https://bbs.io-tech.fi/data/attachments/1175/1175201-8f5f9fa72587885469f7aa9d1a0d3a50.jpg?hash=j1-fpyWHiF)