Tyypillinen/yleinen aliasoitumiefekti on moire-efekti.

Pikagoogletuksella löytyi:

Auts! Miten ne noin pahasti on kämmänneet tuonkin?

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Tyypillinen/yleinen aliasoitumiefekti on moire-efekti.

Pikagoogletuksella löytyi:

Tällä hetkellä eroa on säteenseurannan kiihdytyksen suhteen yms, mutta tämä korjaantuu tässä kuussa esiteltävän RDNA2:n ja RX 6000 -sarjan näyttisten osalta.Nyt kun ei noita RTX-kortteja oikein saa, niin miten nykypäivänä NVidia ja AMD -kortit eroaa toisistaan (peli)käyttäjän näkökulmasta?

Edellisen kerran AMD:n näyttiksen omistin joskus n.20 vuotta sitten. Siihen aikaan Radeoneissa oli hieman parempi kuvanlaatu. Sen jälkeen menty NVidialla, koska tehoa alkoi löytymään enemmän ja kuvanlaadulliset erotkin tasoittuivat.

Onko jotain oleellisia featureita mitä toiselta puuttuu mitä toisella on jne.? Toki tuo 144Hz G-sync näyttö hieman jarruttaa AMD:hen siirtymistä, mutta toisaalta 4K-näyttöön siirtyminen uusien korttien myötä vois olla ihan realistista (etenkin kun myös HDR puuttuu joten siihen tarvii käyttää telkkaria).

Edit: Joo, tein samanlaisen kyselyn joku aika sitten tuolla prossu-alueella

Tyypillinen/yleinen aliasoitumiefekti on moire-efekti.

Pikagoogletuksella löytyi:

Ei tuon jälkeen ole ainakaan missään patch noteissa ollut mainintaa muutoksista. Toi mip bias on säädetty pelimoottorissa.Video on heinäkuulta ja tässä tullu isoja päivityksiä niin eikö vieläkään ole korjattu ?

Jos haluat pelata ja striimata niin Nvidia ainut vaihtoehto tähän kiitos NVENCin.Nyt kun ei noita RTX-kortteja oikein saa, niin miten nykypäivänä NVidia ja AMD -kortit eroaa toisistaan (peli)käyttäjän näkökulmasta?

Edellisen kerran AMD:n näyttiksen omistin joskus n.20 vuotta sitten. Siihen aikaan Radeoneissa oli hieman parempi kuvanlaatu. Sen jälkeen menty NVidialla, koska tehoa alkoi löytymään enemmän ja kuvanlaadulliset erotkin tasoittuivat.

Onko jotain oleellisia featureita mitä toiselta puuttuu mitä toisella on jne.? Toki tuo 144Hz G-sync näyttö hieman jarruttaa AMD:hen siirtymistä, mutta toisaalta 4K-näyttöön siirtyminen uusien korttien myötä vois olla ihan realistista (etenkin kun myös HDR puuttuu joten siihen tarvii käyttää telkkaria).

Edit: Joo, tein samanlaisen kyselyn joku aika sitten tuolla prossu-alueella

Ei se mikään ainut vaihtoehto ole millään mittarilla, vaikka hyvä vaihtoehto onkin.Jos haluat pelata ja striimata niin Nvidia ainut vaihtoehto tähän kiitos NVENCin.

Jep, helposti näyttiksessä säästetyn hinnan voi laittaa tehokkaampaan prosessoriin, ja niin saa myös näyttiksen ehkä vaihtuessa pidettyä sen suorituskyvyn. NVENC ja RTX voicet ja muut on kyllä aika gimmickejä edelleen, kun saman pystyy juuri tekemään esim prosessorilla.Ei se mikään ainut vaihtoehto ole millään mittarilla, vaikka hyvä vaihtoehto onkin.

Myös AMD tarjoaa rautaenkooderin vaikka se laadussa onkin tällä haavaa heikompi, eikä se prosessorilla enkoodaaminenkaan mitenkään poissuljettu vaihtoehto ole.

Kyllä AMD:n korteillakin voi pakata kuvaa. Kuvanlaatu on hieman matalempi etenkin korkeilla bitrateilla, mutta silti n. veryfast presettiin verrattavissa. "ainut vaihtoehto" on aika kärjistävä heitto.Jos haluat pelata ja striimata niin Nvidia ainut vaihtoehto tähän kiitos NVENCin.

oletko kokemusasiantuntijaKyllä AMD:n korteillakin voi pakata kuvaa. Kuvanlaatu on hieman matalempi etenkin korkeilla bitrateilla, mutta silti n. veryfast presettiin verrattavissa. "ainut vaihtoehto" on aika kärjistävä heitto.

Jep. Vielä kun ajurit vähän kypsyy, niin voi hyvin olla, että mennään jopa ohi nvidiasta. Ja kuten mainittua, näyttiksessä säästetyllä rahalla voi ostaa sen tehokkaammaan (ja future proofin) prosessorin, jolla saa laitettua pihalle parempaa kuvaa kuin millään NVENC-gimmikeillä.Kyllä AMD:n korteillakin voi pakata kuvaa. Kuvanlaatu on hieman matalempi etenkin korkeilla bitrateilla, mutta silti n. veryfast presettiin verrattavissa. "ainut vaihtoehto" on aika kärjistävä heitto.

Nyt kun ei noita RTX-kortteja oikein saa, niin miten nykypäivänä NVidia ja AMD -kortit eroaa toisistaan (peli)käyttäjän näkökulmasta?

Edellisen kerran AMD:n näyttiksen omistin joskus n.20 vuotta sitten. Siihen aikaan Radeoneissa oli hieman parempi kuvanlaatu. Sen jälkeen menty NVidialla, koska tehoa alkoi löytymään enemmän ja kuvanlaadulliset erotkin tasoittuivat.

Onko jotain oleellisia featureita mitä toiselta puuttuu mitä toisella on jne.? Toki tuo 144Hz G-sync näyttö hieman jarruttaa AMD:hen siirtymistä, mutta toisaalta 4K-näyttöön siirtyminen uusien korttien myötä vois olla ihan realistista (etenkin kun myös HDR puuttuu joten siihen tarvii käyttää telkkaria).

Tietysti myös RT-tuki puuttuu täysin. Myös striimereille käyttökelpoiset rautakoodaukset ja muut mukavat lisät joita rtx-kortit tuo tullessaan.

Tietysti myös RT-tuki puuttuu täysin. Myös striimereille käyttökelpoiset rautakoodaukset ja muut mukavat lisät joita rtx-kortit tuo tullessaan.En tässä asiassa. Ihan netflix VMAF tuloksia katsottaessa tilanne on tämä.oletko kokemusasiantuntija

Se on ainut vaihtoehto jos puhutaan näytönohjaimista. Oikei, Intel tuonut myös uutta heidän quicksynciin. Se voi jossain vaiheessa olla varteenotettava. AMD:llä kehitystyötä ei ole näkynyt ja se on harmi.Ei se mikään ainut vaihtoehto ole millään mittarilla, vaikka hyvä vaihtoehto onkin.

Myös AMD tarjoaa rautaenkooderin vaikka se laadussa onkin tällä haavaa heikompi, eikä se prosessorilla enkoodaaminenkaan mitenkään poissuljettu vaihtoehto ole.

lähtökohtaisesti saat niin paljon parempaa perf/€ AMD:ltä, että pystyt ylijäävän rahan panostamaan halutessasi esim juuri prosessoriin, jolla enkoodaus hoituu paremmin kuin näyttiksellä. Onhan se ihan validi pointti näyttiksistä puhuttaessa.Prosessorilla enkoodaaminen ei ole poissuljettu asia, mutta nyt puhutaan näytönohjaimista joten turha tuoda tuota näkökulmaa tähän.

Edelleen, ei ole ainut. Se ettei ole paras ei tarkoita että olisi käyttökelvoton. Striimaamaan pääsee vaikka ilman mitään kolmansien osapuolten softia suoraan Radeon Softwaresta.Se on ainut vaihtoehto jos puhutaan näytönohjaimista. Oikei, Intel tuonut myös uutta heidän quicksynciin. Se voi jossain vaiheessa olla varteenotettava. AMD:llä kehitystyötä ei ole näkynyt ja se on harmi.

Prosessorilla enkoodaaminen ei ole poissuljettu asia, mutta nyt puhutaan näytönohjaimista joten turha tuoda tuota näkökulmaa tähän.

NVENC on ainut oikeasti hyvä vaihtoehto.Ei se mikään ainut vaihtoehto ole millään mittarilla, vaikka hyvä vaihtoehto onkin.

Myös AMD tarjoaa rautaenkooderin vaikka se laadussa onkin tällä haavaa heikompi, eikä se prosessorilla enkoodaaminenkaan mitenkään poissuljettu vaihtoehto ole.

Enpä osannut näitä asioita yhdistää enkä siten tuolla hakusanalla googlettaakaan.Tyypillinen/yleinen aliasoitumiefekti on moire-efekti.

Aliasoitumista voi tulla muistakin asioista kuin väärin konfiguroidusta mip biaksesta. Moire tasaisessa teksturoidussa pinnassa kuten death stranding esimerkissä taas on hyvin suurella varmuudella juuri mip biasista kiinni.Tämä mip homma itselleni vähän tuntematon, mutta käytännön testi herättää kyllä kysymyksen, että miksi aliasoituminen/Moire on erityisesti DLSS:ään/mip biakseen liittyvä ongelma?

Se on ainut vaihtoehto jos puhutaan näytönohjaimista. Oikei, Intel tuonut myös uutta heidän quicksynciin. Se voi jossain vaiheessa olla varteenotettava. AMD:llä kehitystyötä ei ole näkynyt ja se on harmi.

Prosessorilla enkoodaaminen ei ole poissuljettu asia, mutta nyt puhutaan näytönohjaimista joten turha tuoda tuota näkökulmaa tähän.

Juu voi olla itseasiassa ihan paljonkin tekemistä asian kanssa sillä että tuossa tuijotellaan heijastusta. Samassa materiaalissa ei juuri Moireja näy kun katsotaan ihan sitä itseään.Aliasoitumista voi tulla muistakin asioista kuin väärin konfiguroidusta mip biaksesta. Moire tasaisessa teksturoidussa pinnassa kuten death stranding esimerkissä taas on hyvin suurella varmuudella juuri mip biasista kiinni.

Enpä osannut näitä asioita yhdistää enkä siten tuolla hakusanalla googlettaakaan.

Kokeilinpa huvikseni Unreal Engine -pelissä kun muistin Moireen törmänneeni. Efekti ei rajoitu efekti kehittyneempiin DLSS ja TAAU ratkaisuihin vaan sitä esiintyy myös ihan TAA:lla tuossa haastavassa avaruuspuvun materiaalissa (tässä kuvassa pahiten tuossa rinnan ulokkeessa). 960p -> 1440p eli ~67% skaalauksella nämä kaikki:

DLSS

TAA

TAAU

Tämä mip homma itselleni vähän tuntematon, mutta käytännön testi herättää kyllä kysymyksen, että miksi aliasoituminen/Moire on erityisesti DLSS:ään/mip biakseen liittyvä ongelma?

Nanitessa on oma softarasteroija joka käyttää näytönohjaimen compute shadereitä muun muassa. Eli kaikki FP32 on kyllä takuulla käytössä. Käyttävät myös muita primitiivishadereita mitä alusta vain tukee.edit: Ja entäs Unreal Engine 5 Nanite teknologia? Toihan käyttää softarasterisointia, joten tuleeko siinä hyötyä noista FP32 ytimistä? Mietin vaan, että onhan se mahdollista, että NVIDIA on kysellyt pelimoottorien kehittäjiltä, mitä he haluaisivat nähdä seuraavan sukupolven näytönohjaimissa ja rakentanut arkkitehtuuria hieman sitäkin silmällä pitäen.

Jaa? Täällä tuntuu kuitenkin olevan porukkaa joka väittää, että laatua haluava ei koske yhteenkään rautaenkooderiin vaan tekee sen kokonaan softalla.Vuosi 2016 soitteli ja halusi prosessorilla encoodaamisen takaisin. mitään tolkkua tykittää kahdeksaa ydintä tapissa prosessorilla jos parempaa laatua saa näytönohjaimella.

Jep, helposti näyttiksessä säästetyn hinnan voi laittaa tehokkaampaan prosessoriin, ja niin saa myös näyttiksen ehkä vaihtuessa pidettyä sen suorituskyvyn. NVENC ja RTX voicet ja muut on kyllä aika gimmickejä edelleen, kun saman pystyy juuri tekemään esim prosessorilla.

Tähän asti saman tehoinen AMD kortti on ollu reilusti halvempi kuin vastaava Nvidia kortti.Niin siis minkä säästetyn hinnan? Tuo nvenc ei juurikaan hidasta näytönohjainta joten sitä varten ei tarvitse hommata nopeampaa korttia.

Aikalailla mennyttä aikaa, jos katsot minkä tahansa vertailu videon tai artikkelin kuluneen vuoden ajalta niin kaikissa päädytään suosittelemaan turingin nvenciä. Itsekin striimailin softalla, kunnes sitten toi turing-nvenc saapui OBS:ään ja sen jälkeen vaihtui mullakin. Ei ollu mitään eroa x264-slowiin, muuta kun se että kaikki randomi ripuloinnit lakkasi.Jaa? Täällä tuntuu kuitenkin olevan porukkaa joka väittää, että laatua haluava ei koske yhteenkään rautaenkooderiin vaan tekee sen kokonaan softalla.

Niinhän se on, mutta toki AMD:n seuraava kohta julkistettava sukupolvi tässä olikin mielessä. 3080 tilaamiseen en niin paljoa panostanut, että jonoa varmaan on edellä reilusti...Tällä hetkellä suurin ero on se, että amd:n kortit ovat suorituskyvyltään hitaampia kuin nvidian toissa sukupolviTietysti myös RT-tuki puuttuu täysin. Myös striimereille käyttökelpoiset rautakoodaukset ja muut mukavat lisät joita rtx-kortit tuo tullessaan.

Ei ole mitään kiirettä. Jos se teho ei riitä natiiviresolle, niin olet ostanut liian tehottoman kortin. Enkä muutenkaan ainakaan itse ota vapaaehtoisesti käyttöön yhtään kuvanlaatua huonontavaa tekniikkaa

Pitkälti täysin samannäköistä? Siinä on kyllä niin ympäripyöreästi ilmaistu, että joko toimii tai sitten ei. Jos 8K vaatii sen DLSS:n, niin siinä voi sanoa, että itsepetos haisee taivaaseen saakka ja nVidian markkinointipowerpointit on nielaistu koukkua, siimaa ja puolta vapaakin myöten.Nvidian RTX korttien kanssa tehon ei tarvi riittääkkään jollekkin resolle kun DLSS 2.0:lla saat hyvin pitkälti täysin samanäköistä jälkeä kuin natiivi.

AMD on tässä valovuosia takana, Nvidialla onnistuu DLSS 2.0:lla jo 8K pelaaminenkin, AMD:llä tämä on fantasiaa jos haluaa että peli näyttäisi vielä hyvällekkin

Huutonaurua. 8k ruudusta jos aikoo ottaa mitään iloa irti pitää FOV olla n. 110 astetta.Nvidialla onnistuu DLSS 2.0:lla jo 8K pelaaminenkin

Huutonaurua. 8k ruudusta jos aikoo ottaa mitään iloa irti pitää FOV olla n. 110 astetta.

Minkä suhteen? Sivulla näyttää olevan puhetta enkoodereista, joissa Nvidia vie 100-0 ja AMD ei ole vielä julkaissut uusia näyttiksiään tai edes speksejä. Millä logiikalla AMD johtaa juuri nyt? Sori jos minulta on nyt mennyt jotakin ohi.Loppuipa NVIDIA-fanaatikoilta argumentit lyhyeen. Kyllä se niin on, että AMD:llä on nyt jo parhaat tuotteet low- ja mid rangeen, ja todennäköisesti kohta myös high endiin. Siinä on Jenssenin pojalla tiedossa kuumat paikat.

Oon aina luullu naiseksiLoppuipa NVIDIA-fanaatikoilta argumentit lyhyeen. Kyllä se niin on, että AMD:llä on nyt jo parhaat tuotteet low- ja mid rangeen, ja todennäköisesti kohta myös high endiin. Siinä on Jenssenin pojalla tiedossa kuumat paikat.

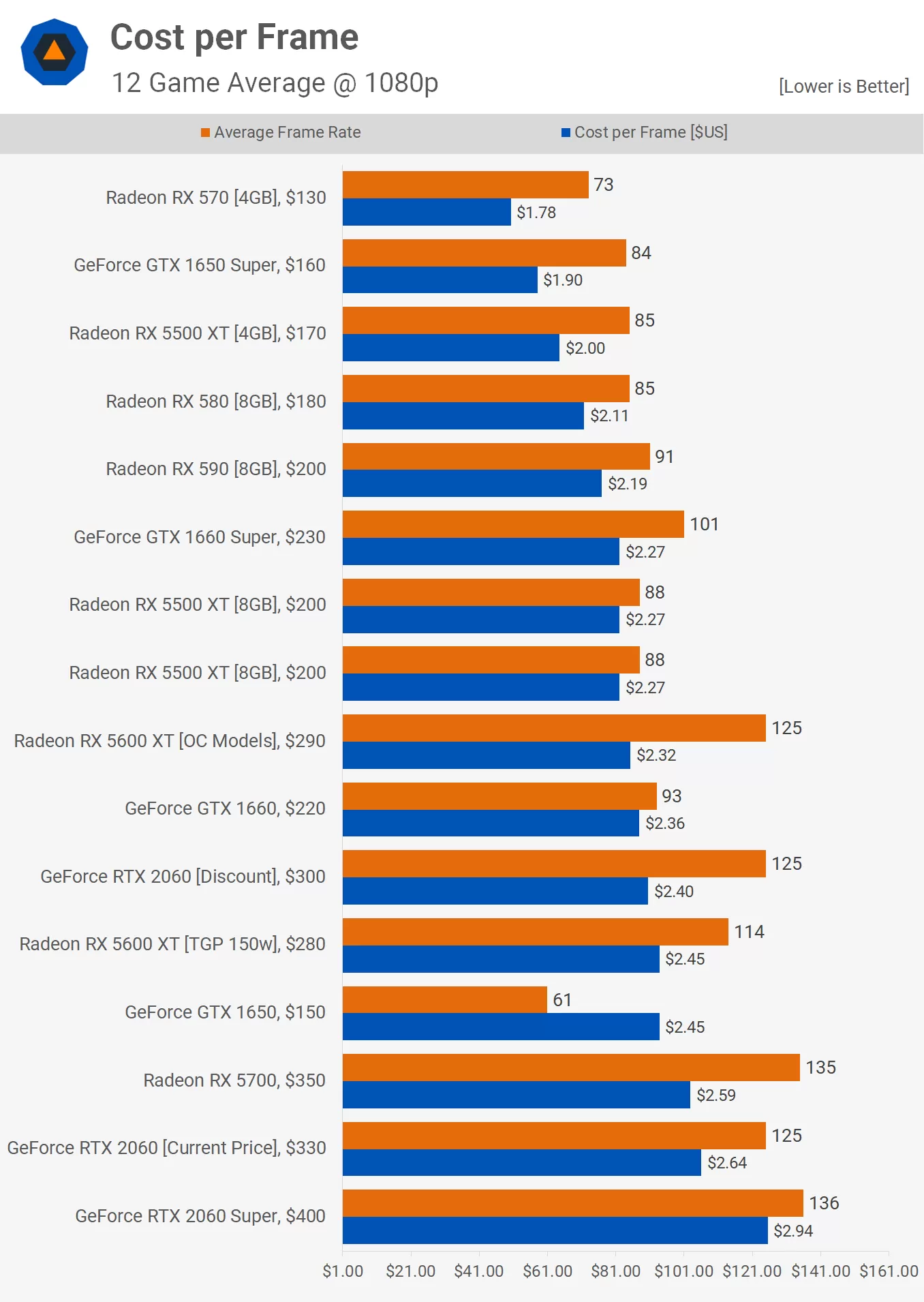

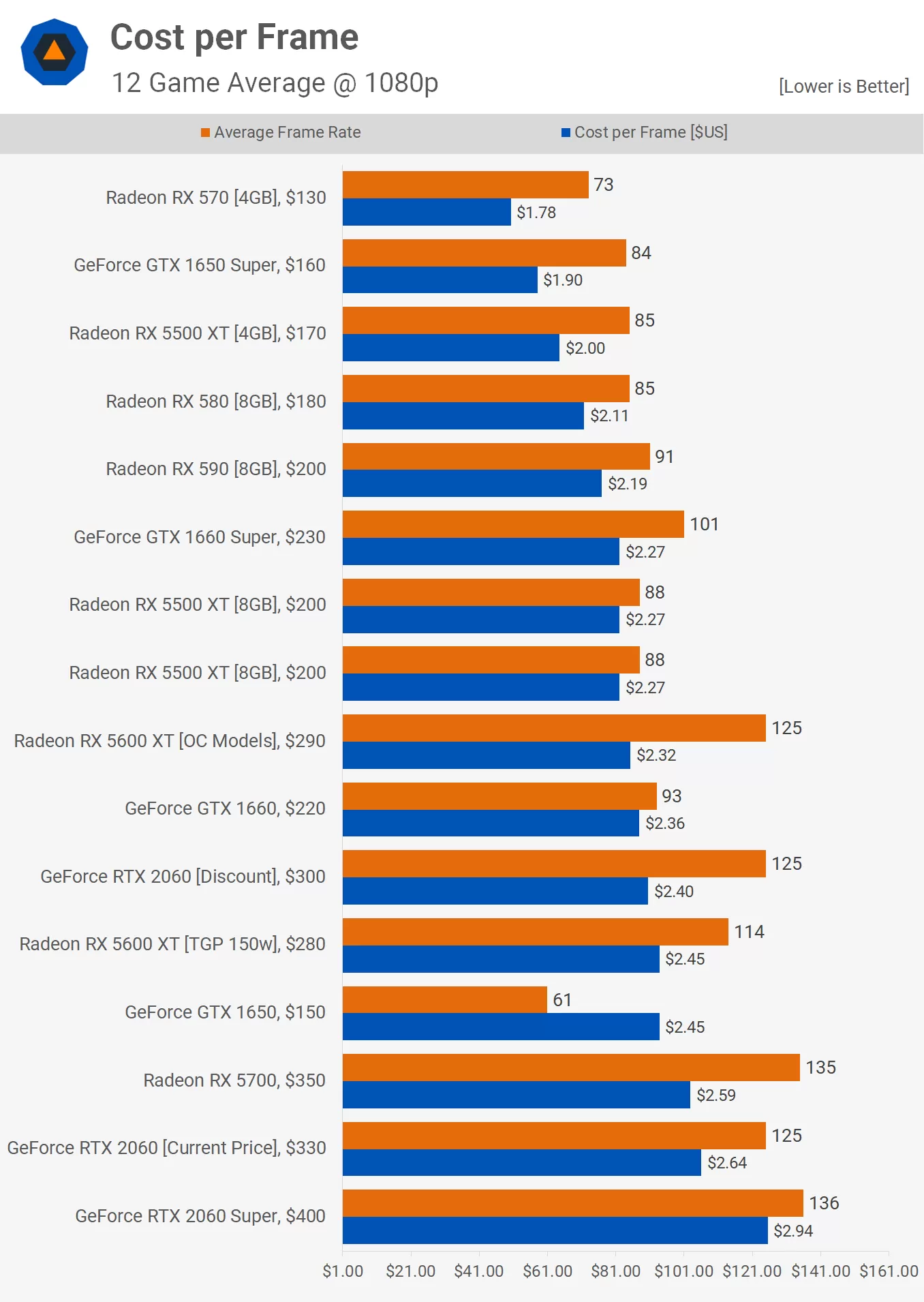

Kattelenkohan jotenkin vinoon kun 1650S näyttää minun silmääni paremmalta valuelta AMD:n samantehoisia verrokkeja vastaan? Hinta.fi:ssä halvin 1650S ~160eur toimitettuna, 5500XT 4gb puolestaan ~176eur (ja 580 vielä vähän kalliimpi), joten tämänhetkinen suhteellinen ero on Suomessa vielä suurempi Nvidian eduksi kuin tuossa kuvaajassa.Tähän asti saman tehoinen AMD kortti on ollu reilusti halvempi kuin vastaava Nvidia kortti.

Niin, sehän on AMD:n ansiota, että noita hintoja on saatu poljettua alemmas. Ja edelleen AMD tarjoaa parasta perf/wattKattelenkohan jotenkin vinoon kun 1650S näyttää minun silmääni paremmalta valuelta AMD:n samantehoisia verrokkeja vastaan? Hinta.fi:ssä halvin 1650S ~160eur toimitettuna, 5500XT 4gb puolestaan ~176eur (ja 580 vielä vähän kalliimpi), joten tämänhetkinen suhteellinen ero on Suomessa vielä suurempi Nvidian eduksi kuin tuossa kuvaajassa.

Halvin 2060 puolestaan ~3% kalliimpi hinta.fi:ssä kuin halvin 5600XT = AMD reilusti halvempi?

AMD Radeon RX 5600 XT Review

The Radeon RX 5600 XT is a respectable product that has pushed for lower prices and better performance at $300. For that alone, we commend it. The...www.techspot.com

Yhtälöstä uupui nyt energiatehokkuus.Aiemmin kaikki oli sitä mieltä että yli 300W näyttistä ei osta kukaan. Nyt kun logo sattui olemaan vihreä ne menee kuin kuumille kiville...

Sinällään ihan fiksu ratkaisu kellottaa kortit reilusti parhaan hyötysuhteen yli niin saatiin vakiona nopeita kortteja...

Paitsi että senkään perusteella ei yksistään voi ostaa näytönohjainta.Niin, sehän on AMD:n ansiota, että noita hintoja on saatu poljettua alemmas. Ja edelleen AMD tarjoaa parasta perf/watt

Halvin 2060 puolestaan ~3% kalliimpi hinta.fi:ssä kuin halvin 5600XT = AMD reilusti halvempi?

Eli näissäkin tämä 5600 XT malli selvästi paremmalla jäähyllä?5600XT korteista ei taida olla niitä 2 markan jäähyillä olevia halppismalleja ollenkaan. Jos verrataan vastaavia niin onhan se 5600XT halvempi.

Tällä hetkellä kyllä paras ei ole 3080, kun katselee saatavuutta. Jos haluat päästä peleille jouluna tai vähän myöhemmin, niin tokihan 3080 on varmaan aika hyvä valinta. Katsotaan ihan rauhassa mikä yllätys AMD:llä on hihassaan, turha verrata viime sukupolven kortteihin tuota 30xx-sarjaa.Paitsi että senkään perusteella ei yksistään voi ostaa näytönohjainta.

Vai mitenköhän Rx570 pyörittelis 4K.lla Max asetuksilla pelejä

Eli hankinta menee myös tarvittavan suorituskyvyn mukaan,eli mitä se käyttäjä tarvitsee/vaatii.

Paras 4K näytönohjain on nyt Rtx3080

Yhtälöstä uupui nyt energiatehokkuus.

Yli 300w paskalla energiatehokkuudella oleva nöytönohjain on kyllä iso miinus vihkoon, mutta 3080/3090 on parempi energiatehokkuus kuin esim 2080Ti joten eipä se kulutus silloin haittaa kun potkuakin löytyy suhteessa paremmin.

Mun puolesta saa kuluttaa vaikka 500w kunhan se energiatehokkuus on edelleen hyvä, eikä tuohon liity merkki mitenkään, vaan itse energiatehokkuus eli suorituskyky per käytetty watt.

Joo, toinen on normihintainen ja toinen alennustuote. Onpa yllättävää, että hetkellisesti alennuksesta saattaa saada halvalla tuotteita.Eli näissäkin tämä 5600 XT malli selvästi paremmalla jäähyllä?

Gigabyte GeForce RTX 2060 D6 -näytönohjain, 6GB GDDR6 (Tarjous! Norm. 389€!) - 309,00€

Tarjous koskee vain Turun varastossa olevaa erää! Tekniset tiedot : GPU GPU: NVIDIA GeForce RTX 2060 Kellotaajuus: 1680 MHz RTX-OPS: 36 Coret: 1920 Muisti Määrä: 6GB GDDR6 Muiwww.jimms.fi

Gigabyte Radeon RX 5600 XT WINDFORCE OC -näytönohjain, 6GB GDDR6 - 349,00€

Tekniset tiedot : GPU GPU: AMD Radeon RX 5600 XT GPU:n kellotaajuus: - Boost Clock: Jopa MHz - Game Clock: MHz Stream-prosessorit: 2304 Muisti Muistin määrä: 6GB GDDR6 Muistinwww.jimms.fi

Eli näissäkin tämä 5600 XT malli selvästi paremmalla jäähyllä?

Gigabyte GeForce RTX 2060 D6 -näytönohjain, 6GB GDDR6 (Tarjous! Norm. 389€!) - 309,00€

Tarjous koskee vain Turun varastossa olevaa erää! Tekniset tiedot : GPU GPU: NVIDIA GeForce RTX 2060 Kellotaajuus: 1680 MHz RTX-OPS: 36 Coret: 1920 Muisti Määrä: 6GB GDDR6 Muiwww.jimms.fi

Gigabyte Radeon RX 5600 XT WINDFORCE OC -näytönohjain, 6GB GDDR6 - 349,00€

Tekniset tiedot : GPU GPU: AMD Radeon RX 5600 XT GPU:n kellotaajuus: - Boost Clock: Jopa MHz - Game Clock: MHz Stream-prosessorit: 2304 Muisti Muistin määrä: 6GB GDDR6 Muistinwww.jimms.fi

Noissa molemmissa yhtä surkeat jäähyt..Eli näissäkin tämä 5600 XT malli selvästi paremmalla jäähyllä?

Gigabyte GeForce RTX 2060 D6 -näytönohjain, 6GB GDDR6 (Tarjous! Norm. 389€!) - 309,00€

Tarjous koskee vain Turun varastossa olevaa erää! Tekniset tiedot : GPU GPU: NVIDIA GeForce RTX 2060 Kellotaajuus: 1680 MHz RTX-OPS: 36 Coret: 1920 Muisti Määrä: 6GB GDDR6 Muiwww.jimms.fi

Gigabyte Radeon RX 5600 XT WINDFORCE OC -näytönohjain, 6GB GDDR6 - 349,00€

Tekniset tiedot : GPU GPU: AMD Radeon RX 5600 XT GPU:n kellotaajuus: - Boost Clock: Jopa MHz - Game Clock: MHz Stream-prosessorit: 2304 Muisti Muistin määrä: 6GB GDDR6 Muistinwww.jimms.fi

Toivottavasti tulevissa 3000 sarjoissa ei enään samoja säästöjä nähdä, vaikka vähän epäilen että siellä taas osa pulttaa kiinni noita pilipali jäähyjä.

Täytyy toivoa, ongelma on vaan siinä kun valmistajat haistaa matalahkon kulutuksen niin pultataan niitä 2markan jäähyjä jotka nippanappa sitten riittävät.Ainakin 3080 ja 3090 jotka on testeissä nyt näkyny on ollu yllättävän hyviä. Jospa sama trendi jatkuisi noiden 3070 ja 3060 korttien kanssa.

Nvidia taitaa tuolla alle 300e luokassa hallita hieman ja Amd.lla sitten hyvin hinnoiteltuna nämä 5600XT/5700/5700XTJos olisin näyttistä ostamassa niin kiinnoistaisi paljonko se köyhdyttää, ei se onko se tarjoushinta vai ei. Tällä hetkellä edelleenkin halvimmat 2060:t ja 5600 XT:t hyvin lähellä toisiaan hinnoissa.

Ja se 1650S tarjoaa parempaa valueta kuin AMD.

Mutta sovitaan että AMD tosiaan reilusti halvempi.

Tähän asti saman tehoinen AMD kortti on ollu reilusti halvempi kuin vastaava Nvidia kortti.

No jos reilu 5% on mielestäsi ”selvästi nopeampi”, niin selvä. Mielestäni tuo on aika pieni ero.No, 5700XT on vajaan satkun halvempi kuin 2070 Super, ja Super on kuitenkin selvästi nopeampi kortti keskimäärin. Eli tuolla erotuksella pitäisi saada selvästi parempi prossu jotta softaenkoodaus onnistuu vastaavalla laadulla mikä ei ihan taida onnistua, lisäksi sinulla on sitten hitaampi näytönohjain

Käytämme välttämättömiä evästeitä, jotta tämä sivusto toimisi, ja valinnaisia evästeitä käyttökokemuksesi parantamiseksi.