- Liittynyt

- 21.02.2017

- Viestejä

- 5 354

Oisko se DLSS:n idea jotain tämän tyyppistä:

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Onko tuo varmistunut että se on upscale kuten heti alkujaan epäilin että olisi vai onko edelleen mutuilua? Olen tätä tekniikkaa suht mielenkiinnolla seurannut ja jossain vaiheessa jo herättelin toiveita että se ei olisi upscale vaan jotain oikeasti kivaa.

Oisko se DLSS:n idea jotain tämän tyyppistä:

Miten niin ennakkoon? Kysehän on siitä, että parannetaan olemassaolevaa kuvaa.Putkijuoksuissa toimii varmasti, koska peliä voidaan opettaa oletettaviin katselusuuntiin. Mutta peleissä joissa on muista pelaajista riippuvaa toimintaa ja hajoavaa kenttää, niin miten voidaan luotettavasti ennustaa tapahtumat ennakkoon?

DLSS:n toimintaperiaate ei ole vielä selvillä, mutta tuskin se kaikesta ruudulla näkyvästä on vastuussaToinen pelaaja rikkoo tarkoituksella rakennusta, että vihollinen ei näe häntä; mutta viholliselle ei piirretäkkään juuri sillä hetkellä sitä rakennuksesta nousevaa savua, koska DLSS ei osannut ennakoida tätä tilannetta?

Kyllä.

Ja pahana ongelmana tosiaan on se, että kuvasta puuttuu yksityiskohtia joita siellä pitäisi olla, ja toisaalta kuvaan ilmestyy yksityiskohtia, joita siellä ei pitäisi olla.

Ihan olemassa olevista faktoista. Yksinkertaista matematiikkaa katsos...Mistäs tietotoimistosta nämä luvut on revitty vai tuliko ne ihan omasta alumiinipiposta?

DLSS:hän on aliresoluutiolla rendausta niin tokihan se antaa puhtia. jos 4k näytölle ajat 1080p + tekoälytarkennus vs puhdas 4k niin pöljäkin tajuaa että sillä saa lisää kuvia näytölle.

Onko tuo varmistunut että se on upscale kuten heti alkujaan epäilin että olisi vai onko edelleen mutuilua? Olen tätä tekniikkaa suht mielenkiinnolla seurannut ja jossain vaiheessa jo herättelin toiveita että se ei olisi upscale vaan jotain oikeasti kivaa.

Ihan olemassa olevista faktoista. Yksinkertaista matematiikkaa katsos...

Nuo "laskelmat" ei perustu tasan mihinkään faktoihin, vaan koko viesti on täynnä pelkkiä olettamia ja spekulointia. En ymmärrä miksi pitää tänne hatusta keksittyjä "bechmarkkeja" postailla faktatietona

Noiden korttien todellista suorituskykyä ei edelleenkään tiedä kukaan.

Yksi tyyppi pelasi BF5@DLSS @4K (detaileista ei tietoa) niin FPS oli 110-195. Keskimäärin 130-140fps. 4K:na.

Tuo pessimistikin on hieman optimistinen joissain kohdin.Tälläi menee suorituskyky pelien keskiarvoista.

taulukko optimisteille

Rtx2080Ti = 150%

Rtx2080 = 120%

Gtx1080Ti = 100%

Rtx2070 = 95%

Tässä vielä toinen taulukko kaikille pessimisteille

Rtx2080Ti = 140%

Rtx2080 = 105%

Gtx1080Ti = 100%

Rtx2070 = 80%

Sinun faktoille suosittelen tarkistusta:Ihan olemassa olevista faktoista. Yksinkertaista matematiikkaa katsos...

Eihän sen nyt mikään "joko ennakkoon tai ei sitten ollenkaan"-asetelma tarvitse olla. Voihan ne ostohousut myöhemminkin vetää jalkaan, jos siltä tuntuu (ja näyttää).Ennakkotilaus peruttu, päätin sittenkin skipata tän sukupolven - lähinnä sen vuoksi, että oma gtx 1080 on vielä aika tuore ja pelaan 1440p - en usko ray tracingin tuovan tarpeeksi lisäarvoa omaan pelikokemukseen vielä tässä korttisukupolvessa.

Tottakai jos vertaa SuperSamplingiin niin ko. spekulatiot voi unohtaa koska em. on paljon raskaampaa eikä sitä voittanutta ole.Jaa, Epicin demosta on taas kommentoitu ettei DLSS yltänyt TAA:n tasolle kuvanlaadussa.

Teet myös villin oletuksen verrokeissa olevasta MSAA:sta vaikka se voi olla yhtä hyvin vaikka SSAA mikä selittäisi hyvin nopeasti suuren eron suorituskyvyssä.

Tässä vielä toinen taulukko kaikille pessimisteille

Rtx2080Ti = 140%

Rtx2080 = 105%

Gtx1080Ti = 100%

Rtx2070 = 80%

Tuo pessimistikin on hieman optimistinen joissain kohdin.

Sinun faktoille suosittelen tarkistusta:

Eli GTX1080 on jos jossain historiassa, joka oli esimerkeissäni vrt.1080 vs 2080... Siihen DLSS niin erot olisivat kuten sanoin. "2X". Pitänyt sotkea vielä enemmän spekuloitu peruna, 2070.

Ennakkotilaus peruttu, päätin sittenkin skipata tän sukupolven - lähinnä sen vuoksi, että oma gtx 1080 on vielä aika tuore ja pelaan 1440p - en usko ray tracingin tuovan tarpeeksi lisäarvoa omaan pelikokemukseen vielä tässä korttisukupolvessa.

Mene kouluun noob tarkistamaan omia faktoja. Tossahan juuri näkyy että 2080 vs 1080 erot @4K on Tensor-ytimimien (DSLL) takia juuri sanomani +80-120% Turingille!!!

Tulos on saavutettu vertaamalla 1080 ja 2080 ohjaimia toisiinsa samoissa Nvidian valitsemissa tilanteissa. Tuloksen pitäisi kaiketi olla olennaisin asia. Tuon tarkempia tuloksia ei ole olemassa, joten niihin on tyytyminen. Jotain positiivista noikin prosenttiluvut kertonevat, toinen tuote tukehtuu ja toinen ilmeisesti ei.Niin ja ohitat kokonaan sen faktan kuinka tuo on saavutettu. Siihen on syynsä miksi nvidia on tuohon valinnut juurikin 1080 vs 2080 eikä 1080Ti vs 2080Ti ja se syy on että 1080 tukehtuu muistikaistaan 4K resolla ja tukehtuu vielä lisää HDR matskulla.

Tulos on saavutettu vertaamalla 1080 ja 2080 ohjaimia toisiinsa samoissa Nvidian valitsemissa tilanteissa. Tuloksen pitäisi kaiketi olla olennaisin asia. Tuon tarkempia tuloksia ei ole olemassa, joten niihin on tyytyminen. Jotain positiivista noikin prosenttiluvut kertonevat, toinen tuote tukehtuu ja toinen ilmeisesti ei.

Tietysti jotkut voivat nähdä asian niin, että vertailussa on esimerkiksi ikään kuin huijattu tai testattu väärillä asetuksilla, koska 1080 ei tue DLSS:ää ja 4K resoluution tilalle olisi voinut valita vaikka hd:n tai full hd:n. Prosessoriksi joku alkukantainen Pentium niin saataisiin tasaväkiset palkit. Totta kai Nvidia markkinoi uutta tuotetta parhaalla mahdollisella tavalla, mutta en näe että esitetyt palkit olisivat miltään osin vääriä.

Tuo on varmana jossain tilanteessa oikein kuvaava ero 1080 vs 2080. Toisaalta jos spekuloidaan, niin hintojen puolesta voisi olla 1080Ti vs 2080 kun edustavat edes jotenkin samaa hintaluokkaa, joskin 1080Ti taitaa olla edullisempi. Toki tämä oli nVidian vertailu ja siellä ei tietenkään haluta korostaa tuota hintojen nousua.Tulos on saavutettu vertaamalla 1080 ja 2080 ohjaimia toisiinsa samoissa Nvidian valitsemissa tilanteissa. Tuloksen pitäisi kaiketi olla olennaisin asia. Tuon tarkempia tuloksia ei ole olemassa, joten niihin on tyytyminen. Jotain positiivista noikin prosenttiluvut kertonevat, toinen tuote tukehtuu ja toinen ilmeisesti ei.

Tietysti jotkut voivat nähdä asian niin, että vertailussa on esimerkiksi ikään kuin huijattu tai testattu väärillä asetuksilla, koska 1080 ei tue DLSS:ää ja 4K resoluution tilalle olisi voinut valita vaikka hd:n tai full hd:n. Prosessoriksi joku alkukantainen Pentium niin saataisiin tasaväkiset palkit. Totta kai Nvidia markkinoi uutta tuotetta parhaalla mahdollisella tavalla, mutta en näe että esitetyt palkit olisivat miltään osin vääriä.

Jotain positiivista noikin prosenttiluvut kertonevat, toinen tuote tukehtuu ja toinen ilmeisesti ei.

Harminlista että verrataan Ti korttia Ti korttiin, ja ei-Ti korttia ei-Ti korttiin. Perinjuurin harminlista

Yksi tyyppi pelasi BF5@DLSS @4K (detaileista ei tietoa) niin FPS oli 110-195. Keskimäärin 130-140fps. 4K:na.

Tai harmi kun ei ole vielä mitään kunnollisia vertailuja mistään 2000-sarjan kortistaHarminlista että verrataan Ti korttia Ti korttiin, ja ei-Ti korttia ei-Ti korttiin. Perinjuurin harminlista

Ei tullut itselle edes mieleen tarkistaa tukeeko ko. peli sitä, tiesin vain ettei Epicin Infiltrator-demossa vastaa TAA-laatua useamman lähteen mukaanMiten voi pelata BFV DLSS päällä kun koko peli ei tue sitä sitä NVIDIA RTX Platform Brings Real-Time Ray Tracing and AI to Barrage of Blockbuster Games (lista peleistä missä tuki Ray Trace / DLSS)

Itse otan DLSS mieluumin kun hidas Ray Trace mihin tahansa pelaamaani peliin. Onneks tulee ees PUBG. Jos kuvan laatu paranee todella hyväksi niin itselle on ihan sama luoko sen AI jollain uuber algoritmilla vai upsamplataanko se jostain alaresoisista näytteistä. No tämä nähdään pian mikä on tekniikka tässä takana.

No jos 2080 on muistikaistaltaan hyvin lähellä 1080Ti:tä ja 1080Ti ei tukehu muistikaistaan niin voidaan tehdä melko huoletta johtopäätös että 2080 myös se muistikaista riittää eikä samanlaista tukehtumista tapahdu kuten 1080 tapahtuu.

Lisäksi toi Wolfenstein ero tuossa selittyy sillä että se tukee FP16 jota 1080 ei tue ja 2080 tukee.

Eli mikäli nvidia olisi saman dian tehnyt 1080Ti vs 2080Ti niin tuollaisia lukemia ei olisi saatu koska 1080Ti:ssä on riittävästi muistikaistaa pyörittämään 4K resoa tukehtumatta vaikka sekin toki hiukan kärsii HDR matskulla penaltyä niin se ei ole lähellekkään niin suuri kuin 1080.

2080 Ti Strixiä ei ole edes esitelty vielä.Kauppa käyny kun Jimmsillä ei kuulemma riitä kaikille tilaajille ensimmäisestä erästä. Pitäisköhän sittenkin pistää ennakkotilaten, varmaan jostain Gigantista pääsis vielä apajille. Tosin tuosta 2080ti ei ole edes Strixiä vielä tilattavissa. Harmittais vaihtaa mallia kun useamman generaation mennyt Strixillä (ja sitä ennen DirectCU:lla...)

2080 Ti Strixiä ei ole edes esitelty vielä.

Kauppa käyny kun Jimmsillä ei kuulemma riitä kaikille tilaajille ensimmäisestä erästä. Pitäisköhän sittenkin pistää ennakkotilaten, varmaan jostain Gigantista pääsis vielä apajille. Tosin tuosta 2080ti ei ole edes Strixiä vielä tilattavissa. Harmittais vaihtaa mallia kun useamman generaation mennyt Strixillä (ja sitä ennen DirectCU:lla...)

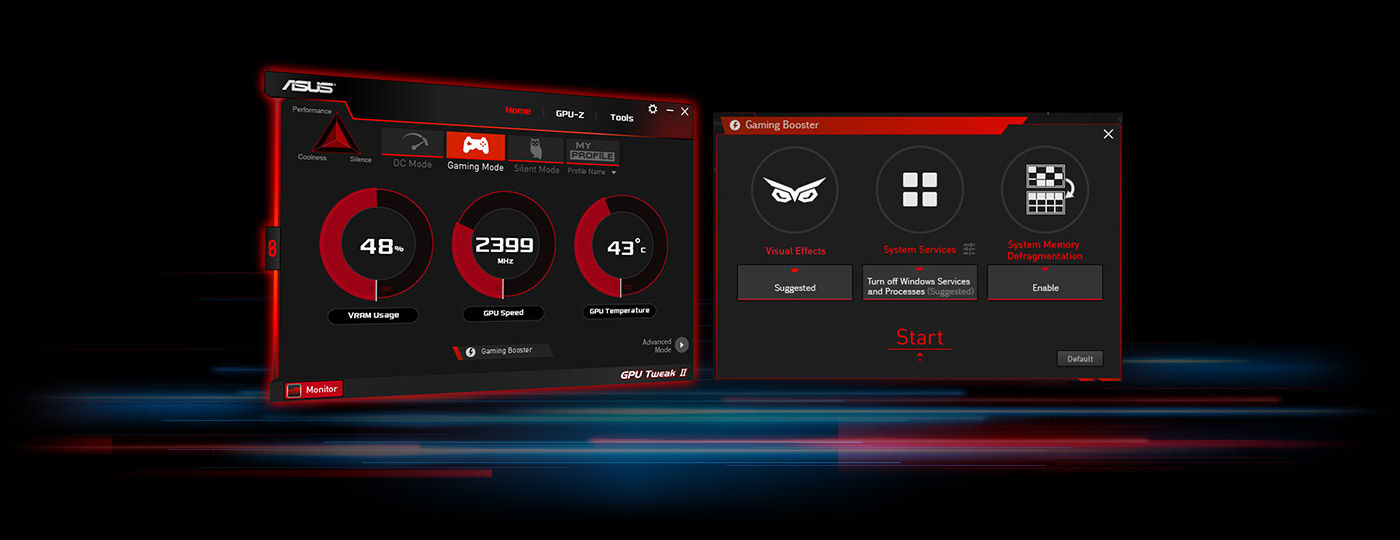

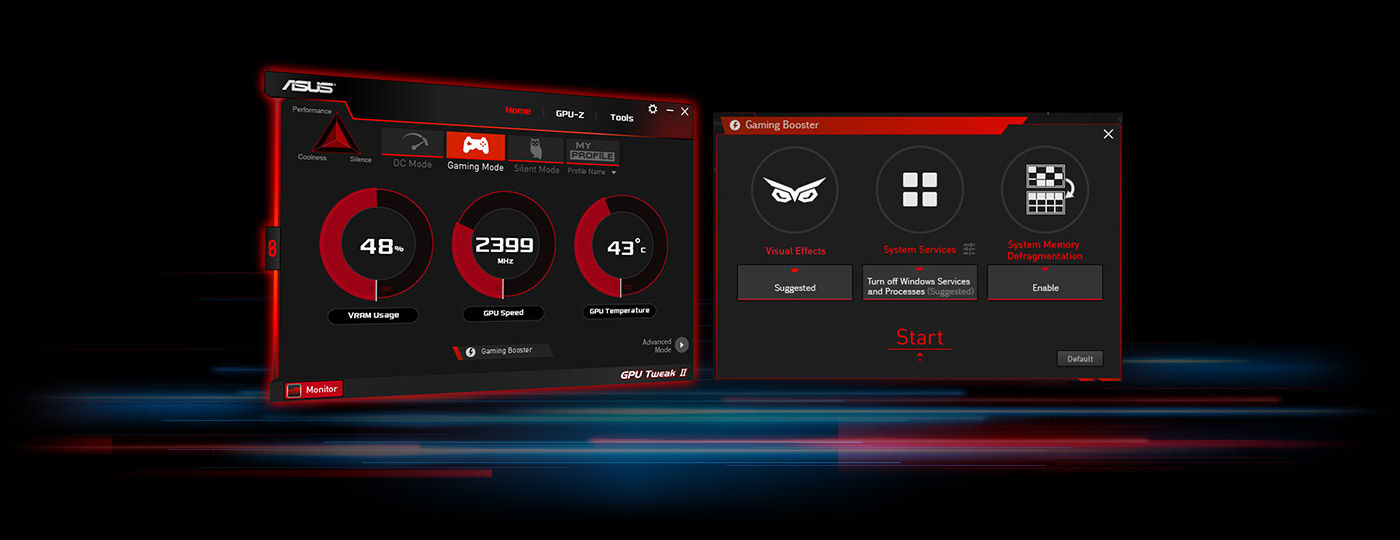

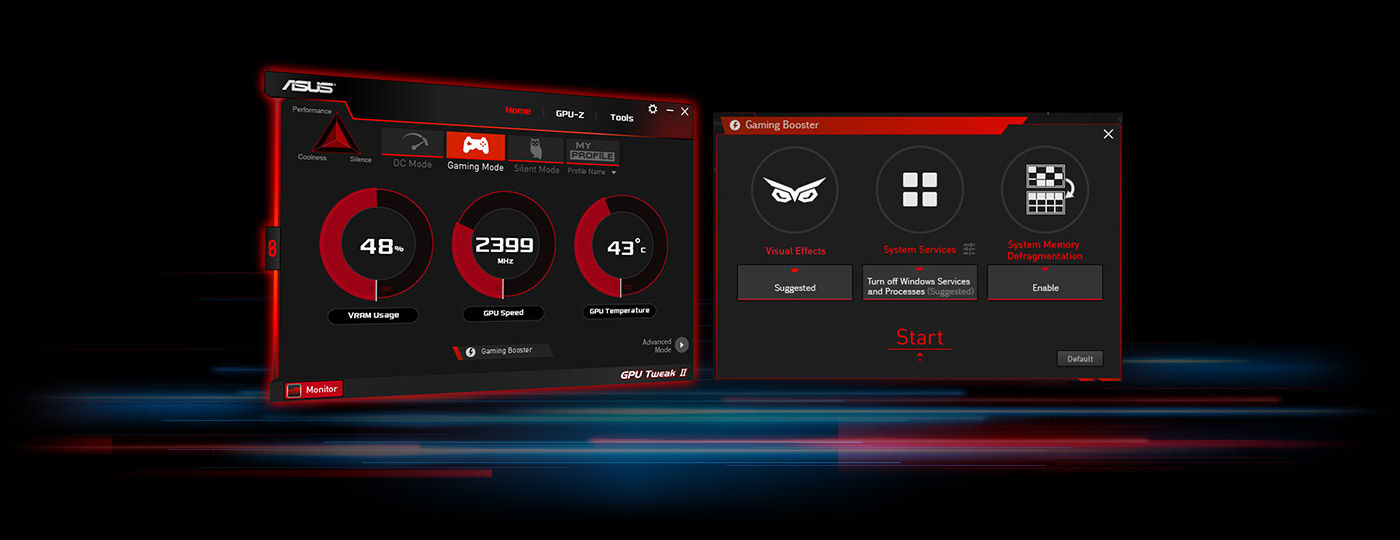

Aika hyviä kelloja ja lämpöjä lupailee tuolla sivulla. Jytky tulossa.

Jahas, seison korjattuna. Esiteltiin kuitenkin myöhemmin kuin muut Asuksen mallit

DLSS itsessään on kuvanlaatuhuijaus.

Se että verrataan tilannetta jossa toisessa on DLSS päällä ja toisessa ei, ei ole mikään "samassa tilanteessa vertailu", eikä se kerro juuri mitään piirien nopeuserosta oikeasti samassa tilanteessa.

Että jospa odoteltaisiin niitä reviewejä, joissa myös

1) Tehdään kunnollinen vertailu piirien välillä siten että DLSS ei ole sotkemassa

2) Analysoidaan kunnolla DLSSn vaikutus kuvanlaatuun.

Sen sijaan että postaillaan noita nykyisiä kuvanlaatuhuijaukseen perustuvia propagandalukuja ympäriinsä.

Aika hyviä kelloja ja lämpöjä lupailee tuolla sivulla. Jytky tulossa.

Kauppa käyny kun Jimmsillä ei kuulemma riitä kaikille tilaajille ensimmäisestä erästä. Pitäisköhän sittenkin pistää ennakkotilaten, varmaan jostain Gigantista pääsis vielä apajille. Tosin tuosta 2080ti ei ole edes Strixiä vielä tilattavissa. Harmittais vaihtaa mallia kun useamman generaation mennyt Strixillä (ja sitä ennen DirectCU:lla...)

On kyllä kovat kellot... Luulis tommosilla kelloilla tulevan jo mukavaa eroa 1080Ti malliin...

Lähdettä? Vai meinaatko ihan stock kelloja?Kuulemma muistit kulkee todella hyvin näissä.

Laittasko toisen 1080 Ti vai 2080 Ti

Rtx2080Ti on selkeästi enempi cuda ytimiä kuin Gtx1080Ti

Joka tarkoittaa että eroa tulee aivan varmasti 4K lla ihan yhtälailla.

Ei se pelkkä muistiväylä määritä 4K nopeutta vaikka sekin on 2080Ti isompi. 616 vs 484

Ytimissä kuitenki selvä ero.

Gtx1080Ti

Cuda 3584

Rtx2080Ti

Cuda 4352