- Liittynyt

- 23.10.2016

- Viestejä

- 1 079

2:lla alkaa 5090 ja alle nelinumeroinen summa on 5080Mitä arvaat paljon hinnat tulee olemaan? Itse lyön vetoa, että 5090 on n. 2100€ ja 5080 n. 1400€. (Suomen hinnoissa)

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Hyvää joulua!

Osallistu io-techin piparikakkutalokilpailuun 2024 Linkki osallistumisketjuun >>>

SER-huutokaupat hyväntekeväisyyteen käynnissä! Linkki huutokauppaan >>>

2:lla alkaa 5090 ja alle nelinumeroinen summa on 5080Mitä arvaat paljon hinnat tulee olemaan? Itse lyön vetoa, että 5090 on n. 2100€ ja 5080 n. 1400€. (Suomen hinnoissa)

Piti kirjoittaa Ti -versio on sen 1400€, eli hieman huonompi 50902:lla alkaa 5090 ja alle nelinumeroinen summa on 5080

Kyllä se 5080 voi olla sen 1400€ launchissa, en ihmettelisi tätä yhtään.Piti kirjoittaa Ti -versio on sen 1400€, eli hieman huonompi 5090

Pitäisin yllättävänä jos 5090 hinta olisi alempi mitä 4090 launchissa. Eli dollareissa 1699$ OVH joka on sitten sen 2000 - 2500 suomessa riippuen AIB mallista.

$1699 -> konversio suoraan euroon 1699€ johon 25,5% ALV = 2133€ karvalakki ja sitten Optimus Prime AIB mallit helposti sen 2500e.

E2: jotta hypoteettinen 5080 maksaisi vain tonnin suomessa niin dollari hinta pitäisi olla alle $799.

Kuulostaa kyllä fantasialta tuollainen. Yksi asia mitä NVIDIA haluaa (omasta mielestä) on se, että AI-kykyiset kortit ovat ne lippulaivan kortit ja niillehän laitetaan ne valtavat katteet.Tällä taulukollahan jossain 5070:ssa olisi muistia jopa 28Gb

Huoh, mistä te kaivatte näitä nevöhööd -sivustoja, luulin klikatessani että että joku tunnettu iso puhuva pää tai tukkajumala paasaa tunnin mutta silmille hyppäs joku uus babyface...

Tommonen 440 tilaajan kanava, varmasti ennennäkemättömiä tietoja ja ei mitään clickbaittia uusien tilaajien toivossa!Huoh, mistä te kaivatte näitä nevöhööd -sivustoja, luulin klikatessani että että joku tunnettu iso puhuva pää tai tukkajumala paasaa tunnin mutta silmille hyppäs joku uus babyface...Tulee olemaan pitkät 4 kuukautta vältellä kiihtyvällä vauhdilla joka tuutista pursuavaa spekulaatiota.

Youtube ekana näitä ehdotteli haulla. Kahta videoo katsonut ihan eri kanavilta ja molemmilla oli tuo sama taulukko...Tommonen 440 tilaajan kanava, varmasti ennennäkemättömiä tietoja ja ei mitään clickbaittia uusien tilaajien toivossa!

Ei noihin kannata uskoa ellei wccftech, videocardz.com uutisoi ja huhun takana aikaisemmin oikeassa olleet "Luottovuotajat". Suurin osa tubettajista ja saiteista on klikkien perässä, totuusarvo nolla.Youtube ekana näitä ehdotteli haulla. Kahta videoo katsonut ihan eri kanavilta ja molemmilla oli tuo sama taulukko...

Ennen julkaisua kortit pitää pakata, valmistaa ja ajella erinäisiä testejä. Lisäksi kun tilataan valmistajalta niitä muistipiirejä, niin tilaukset tehdään kyllä varmasti pitkä-aikaa etukäteen, joten kyllä sitä muistimäärää joutuu vakavasti miettimään varmasti jo yli ennen 6kk julkaisuun, eikä sitä voi päättääå viimehetkellä.. Puoli vuotta ei ole pitkä aika..Ei varmaan nvidia ole vielä päättänyt mitkä muistimäärät eri 50x0 sarjan kortteihin menee. Piirien leikkaukset ja mallimerkinnät päätetään ihan viime hetkellä eikä tyyliin 4kk-6kk ennen julkaisua.

Arvailen että 5090 leikattu 448bit väylälle ja 28GB muistia. 5080 täysi 256bit piiri ja 16GB muistia. Jos/Kun muistimäärät tulevat ongelmaksi niin super malleissa voidaan käyttää 3GB gddr7 piirejä tai vähemmän leikattua piiriä. Tyyliin 4080 super 3GB piireillä=24GB muistia ja 5090 super täydellä piirillä 32GB muistia. Huhu on, että alussa ei ole 3GB gddr7 piirejä tarjolla. Toki 5080 super voi olla myös vielä enemmän leikattu versio 512bit piiristä ja jäisi 3GB muistipiirit käyttämättä 5080 mallissa kokonaan.

Ei noihin kannata uskoa ellei wccftech, videocardz.com uutisoi ja huhun takana aikaisemmin oikeassa olleet "Luottovuotajat". Suurin osa tubettajista ja saiteista on klikkien perässä, totuusarvo nolla.

Tällä taulukollahan jossain 5070:ssa olisi muistia jopa 28Gb ja hinta tuossa taulukossa vain jotain 500€ - voikohan nämä tiedot mitenkään perin pitää paikkansa? Vai mikä tuo Suomilisä olisi, alvillinen 620€ kuulostaa liian hyvältä? Sehän vertaantuisi 3090:een noiden tietojen valossa, mutta varmaan sähköä veisi vähemmän? Kun nytkin olis ihan passeli kortti tuo pelkkä 4070 Blenderiin, mutta se muisti! 24Gb käytännössä minimi, jos ei hermoja tahdo jatkuvasti laittaa kuminarulle.

Youtube

Kuulostaa kyllä fantasialta tuollainen. Yksi asia mitä NVIDIA haluaa (omasta mielestä) on se, että AI-kykyiset kortit ovat ne lippulaivan kortit ja niillehän laitetaan ne valtavat katteet.

Jos kukaan nyt edes katsoi tuota videota niin siinähan sanotaan taulukossa että 5070:ssa olisi 12GB muistia. 28Gbit/pinni muistipalikoilla.Tommonen 440 tilaajan kanava, varmasti ennennäkemättömiä tietoja ja ei mitään clickbaittia uusien tilaajien toivossa!

Nvidia on kuuluisa siitä, että päätökset piirien konfiguraatioista/nimistä tehdään viime hetkellä toisin kuin ehkä joissain muissa yrityksissä. Siihenkin on syynsä miksi julkaisussa on hyvin vähän kortteja tarjolla. Ei ne muutokset ole mitään isoja kun viime tingassa viilataan siitä miten piirit leikataan tehtaalla eri tuotteisiin tai mikä konfiguraatio saa minkä nimen. Tyyliin se mikä oli ajateltu x070ti:ksi voikin olla lopulta x080 tai x070. Nimet vaihtuu ja ehkä joku yksittäinen tuote saa vähemmän/enemmän leikatun piirin käyttöön.Ennen julkaisua kortit pitää pakata, valmistaa ja ajella erinäisiä testejä. Lisäksi kun tilataan valmistajalta niitä muistipiirejä, niin tilaukset tehdään kyllä varmasti pitkä-aikaa etukäteen, joten kyllä sitä muistimäärää joutuu vakavasti miettimään varmasti jo yli ennen 6kk julkaisuun, eikä sitä voi päättääå viimehetkellä.. Puoli vuotta ei ole pitkä aika..

Eiköhän julkaisussa ole ihan tarkoituksellisesti nuo yläpään kortit esnsin, kun.Nvidia on kuuluisa siitä, että päätökset piirien konfiguraatioista/nimistä tehdään viime hetkellä toisin kuin ehkä joissain muissa yrityksissä. Siihenkin on syynsä miksi julkaisussa on hyvin vähän kortteja tarjolla. Ei ne muutokset ole mitään isoja kun viime tingassa viilataan siitä miten piirit leikataan tehtaalla eri tuotteisiin tai mikä konfiguraatio saa minkä nimen. Tyyliin se mikä oli ajateltu x070ti:ksi voikin olla lopulta x080 tai x070. Nimet vaihtuu ja ehkä joku yksittäinen tuote saa vähemmän/enemmän leikatun piirin käyttöön.

Eiköhän julkaisussa ole ihan tarkoituksellisesti nuo yläpään kortit esnsin, kun.

Voi kun 5090 jaksaisi unreal engine 5 peleissä pitää edes 120 fps niin olisin erittäin tyytyväinen.4k 240Hz... tuossa ois yks use-case jossa voisi olla järkeä. Eli moar fps.

No juust! Eipähän noita tällasen tahvopään kannata sit tuijotella! Ihe ymmärsin että on eri versioita, kuten matkalla ollut; toisessa 8Gb, toisessa 12GB - kuten 3060:sta.Jos kukaan nyt edes katsoi tuota videota niin siinähan sanotaan taulukossa että 5070:ssa olisi 12GB muistia. 28Gbit/pinni muistipalikoilla.

Eli 4070 -> 5070 siirtymä ei toisi ollenkaan lisää muistia.

Taitaa mennä alkuperäisen nvidian vuotaneen aikataulun mukaan. Eiköhän ne CES:ssa julkaista. Huhuthan yrittivät pakottaa julkaisua aikaisemmaksi koska kilpailu amd:n kanssa. Ei taida amd pakottaa nvidian kättä julkaisun aikaistamiseen.Mikäs nyt 5090 viimeisin spekuleeraus julkaisu / myyntitulo ajankohdasta? 2025 tammi-helmi kaupoissa?

Ja mikähän tämä muutos tarkalleen ottaen oli? Onko lähde luotettava?Tämä on ihan eri keskustelu kuin mistä aloitit. Mun vihjaus oli siihen suuntaan, että kun julkaisussa on vähän kortteja tarjolla niin helpompi esim x070ti uudelleennimetä x080 tai x070 kun mahdollista reworkkia vähemmän ja/tai piirit ovat edelleen tehtaalla ja paketit printtaamatta.

En jaksa kaivaa tähän hätään, mutta pcworldin podcastissa juttelivat miten jensen vaihtoi kerran julkaisussa kortit toiseen konfiggiin hetki ennen lavalle kävelemistä ja korttien esittelyä.

No juust! Eipähän noita tällasen tahvopään kannata sit tuijotella! Ihe ymmärsin että on eri versioita, kuten matkalla ollut; toisessa 8Gb, toisessa 12GB - kuten 3060:sta.

Kiitos tästä!

Jep, hankala kyllä perustella itselle että päivittäisin 4080 -> 5080 jos muistimäärä on sama. Nyt jo kelpaisi modattuun cyberpunkkiin 20 Gb tai enemmän. Melkein sitten pitäisi katsoa ennemmin käytetty 4090 tms.Toivon että 5080 tulisi 4080S hinnalla ulos ja siinä olisi 320-bittisen muistiväylän jatkeena 20 Gt muistia. Olisi aika surullista tänä päivänä maksaa yli tonni kortista, jos siinä olisi 4080S tavoin vain 16 Gt muistia, olkoonkin GDDR7:aa.

Aina löytyy joku engine jollakin asetuksella joka pistää fps:n single digits oli kortti mikä hyvänsä nyt tai tulevaisuudessa. Mielestäni Wukon näyttää aika paskalle siihen nähden miten pyörii. IMO tuon pitäisi mennä native 4k480fps tuon näköisenä.Voi kun 5090 jaksaisi unreal engine 5 peleissä pitää edes 120 fps niin olisin erittäin tyytyväinen.

edit.

Nimim. Wukong 4k, resolution scale 60%, frame generation on = 90 fps 4090:lla

Joo mutta kyllä iso osa uusista näyttävistä peleistä on alle 100 fps 4090:lla 4k:lla. Ja osa myös vanhemmista.Aina löytyy joku engine jollakin asetuksella joka pistää fps:n single digits oli kortti mikä hyvänsä nyt tai tulevaisuudessa. Mielestäni Wukon näyttää aika paskalle siihen nähden miten pyörii. IMO tuon pitäisi mennä native 4k480fps tuon näköisenä.

Warren kommentti: https://videocardz.com/newz/nvidia-...0w-with-10-performance-increase-over-rtx-4090Kovat on kulutukset jos tämä pitää paikkaansa:

4090:n maksimi powerlimit on 600 W.Todellinen puppu generaattori...

Kun joka viikko arvailee niin väkisinkin osuu jossain vaiheessa oikeaan. Kannattaa jättää nuo vähemälle ja odotella vuotoja...4090:n maksimi powerlimit on 600 W.

Kopitelta on tullut sen verran tarkkoja speksejä sen verran monta kertaa, että vaihtoehto että hän keksii ne päästään vaikuttaa äärimmäisen epätodennäköiseltä. On myös tiedossa tapauksia joissa hänen ilmoittamansa speksit SKU:lle osoittautuvat "vääriksi", mutta myöhemmin paljastuu että kyseinen konfiguraatio on ihan oikeasti ollut olemassa, mutta sitä on muutettu myöhemmin.

PS. kuka on Warre ja miksi hänen analyysinsä on varteenotettava?

Jos kyse olisi pelkistä arvauksista, tällöin piirien speksit luultavasti muuttuisivat jatkuvasti. Mutta tyypillisesti Kopiten huhut menevät niin, että alkuvaiheessa ilmoittaa piirien speksit ja myöhemmin tarkentaa SKU:iden konfiguraatioita. Haulikko ei siis ammu sokkona vaan tiettyyn kohteeseen, vaikkei aina konfiguraation kohdalla lopputuote ole juuri se, mitä kuukausia ennen julkaisua on kertonut.Kun joka viikko arvailee niin väkisinkin osuu jossain vaiheessa oikeaan.

Siis ehdottomasti kannattaa jättää huhujen/vuotojen seurailu vähälle, jos vaihtoehdot on uskoa ne joko varmaksi lopputuotteen speksiksi tai sitten täysin keksityksi.Kannattaa jättää nuo vähemälle ja odotella vuotoja...

Jep juuri näin. Sama kauhistelu oli käynnissä kun oli vuotoja Nvidian 600W jäähdtytyksestä ennen 4090 julkaisua. Kyse oli vaan todennäköisesti varautumisesta jos tarvittaisiin 4090Ti jotain AMD:n yllättävää jytkyä vastaan.Virrankulutushuhut ihan yhdentekeviä. Vaikka huhut olisivat totuusperäisiäkin niin todennäköisesti kyse on nvidian sisäisistä testeistä eri jäähyillä tai teoreettisia "piirin"/jäähyn maksimeita. Vaikka highend blackwell piiri ja jopa fe-jäähy olisi speksattu 600W niin FE malli voi silti olla 450W tai 500W. Loppuvara jää ylikellottajille ja AIB-valmistajille käytettäväksi.

Huhuissa ollut, että nykyiset blackwellit tai niiden super versiot tulisivat kilpailemaan rdna5:en kanssa. Nvidia speksannee ja testannee asiat niin, että tarpeen vaatiessa saadaan viimeisetkin tiristettyä irti piireistä.

Warren kommentti: https://videocardz.com/newz/nvidia-...0w-with-10-performance-increase-over-rtx-4090

Kopite7kimi said that the RTX 4090 would be 600W. (March 12 2022)

Kopite7kimi said that the RTX 4090 Ti would be 600W. (January 29 2023)

Now they're saying the RTX 5090 will be 600W.

At what point do we stop believing this doofus?

Todellinen puppu generaattori...

Näinhän se toimii. Ja kun sitten yleensä muistetaan vain osumat niin pääsee nostradamukseksi.Kun joka viikko arvailee niin väkisinkin osuu jossain vaiheessa oikeaan. Kannattaa jättää nuo vähemälle ja odotella vuotoja...

Kortti ei kyllä yhtään sen energiatehokkaammaksi muutu jos power limittiä rajoitetaan. Tuo oli kyllä muutenkin aivan älytön trendi mitä osa täälläkin harrasti.kuullostaa samalta kuin 4090 kanssa joka kummiskin julkaistiin vähän järkevämmillä lukemilla ja kortista sai oikeasti energiatehokkaan tiputtamalla powerlimit 60% tai alle.

Mutta en nyt ihmettelisi jos 5080 saatu tarjoamaan 4090 tehoja samaan hintaluokkaan ja jotain pitänyt keksiä uudeksi halo tuotteeksi uudessa hintaluokassa nostamalla 5090 virrankulutus maksimiin.

xx70 luokan kortin tehonkulutuksen lisäys kummiskin aika mieto ja xx60 kortin vähän ihmetyttää.

Videocardz -sivusto kuvailee Kopitea termein "most reliable leaker associated with NVIDIA" ja Tom's Hardware puolestaan sanoo että "Kopite7kimi tends to have accurate information about Nvidia's plans".Näinhän se toimii. Ja kun sitten yleensä muistetaan vain osumat niin pääsee nostradamukseksi.

Olihan RTX 4090 600W kortti?Warren kommentti: https://videocardz.com/newz/nvidia-...0w-with-10-performance-increase-over-rtx-4090

Kopite7kimi said that the RTX 4090 would be 600W. (March 12 2022)

Kopite7kimi said that the RTX 4090 Ti would be 600W. (January 29 2023)

Now they're saying the RTX 5090 will be 600W.

At what point do we stop believing this doofus?

Todellinen puppu generaattori...

Yhtä selvää on, että konteksti katoaa. Uutisoidaan nvidia tekee 800w hirviögpu:n(ada huhut) ja konteksti on että r&d porukka on testannut jäähyä ja jäähyä käyttävää tuotetta tuskin tulee.Ei, kyllä se nyt vaan on asioita pidempään seuranneille ilmeistä, että tuo heppu saa hyvää informaatiota jaettavakseen.

Vai haluavatko he vain tehdä huomiota hehättäväviä juttuja kun kiinnostus julkaisun lähestyessä kasvaa.Ollaanko Tompalla ja Videocardzilla jossain linssiin viilauksessa mukana rahan takia? Tai ehkä ovat hyväuskoisia hölmöjä eivätkä seuraa tilannetta yhtä tarkkaan kuin te?

wattia per fps on siis kyseessä kun puhun energiatehokkuudesta. Ehkä hyötysuhde olisi ollut parempi sana.Kortti ei kyllä yhtään sen energiatehokkaammaksi muutu jos power limittiä rajoitetaan. Tuo oli kyllä muutenkin aivan älytön trendi mitä osa täälläkin harrasti.

Jos haluaa kulutusta pienentää niin alivoltitus on se ratkaisu, ja silloin se kortti myös on energiatehokkaampi.

Konteksti katoaa varmaan joo ja asioita vähemmän seuraavan on varmasti vaikeampi arvioida kuinka varma tai epävarma tuollainen virrankulutusspeksi on joku puoli vuotta ennen julkaisua (erittäin epävarma). Mutta tää on ohi mun pointtini, joka oli se, että nuo Kopiten kertomat labralukemat on kuitenkin melko todennäköisesti aitoja ja tuskin päästä keksittyjä. Tästä tuskin olet eri mieltä, siinä missä sniperfin ja fiarska (ja joku Warre) kertoivat että kyse vain arvauksista kuten Nostradamuksella.Yhtä selvää on, että konteksti katoaa. Uutisoidaan nvidia tekee 800w hirviögpu:n(ada huhut) ja konteksti on että r&d porukka on testannut jäähyä ja jäähyä käyttävää tuotetta tuskin tulee.

Varmaan, mutta eikö tätä voisi tehdä valehtelematta, että Kopite on poikkeuksellisen luotettava vuotaja, jos asia ei niin ole?Vai haluavatko he vain tehdä huomiota hehättäväviä juttuja kun kiinnostus julkaisun lähestyessä kasvaa.

Juu tuskin on Videocardz tai Tomppa tuollaista data-analyysiä tehnyt, enkä minäkään. Eli rehellisesti sanoen ihan mutuun perustuu omakin käsitykseni, että Kopiten vuodot ovat harvoin pahasti pielessä.Pitäisi olla selkeää dataa vuotojen määrästä ja siitä kuinka hyvin ne ovat osuneet.

Tästä eri mieltä, esim. Moore's Law is Deadillä on heikko maine nimenomaan pahasti pieleen menneiden huhujen vuoksi.Kuten sanoin osumat muistetaan, huteja ei.

Mutta se wattia per fps ei laske yhtään tuolla power limitin laskemisella. Alivoltituksella laskee.wattia per fps on siis kyseessä kun puhun energiatehokkuudesta. Ehkä hyötysuhde olisi ollut parempi sana.

että nuo Kopiten kertomat labralukemat on kuitenkin melko todennäköisesti aitoja ja tuskin päästä keksittyjä. Tästä tuskin olet eri mieltä, siinä missä sniperfin ja fiarska (ja joku Warre) kertoivat että kyse vain arvauksista kuten Nostradamuksella.

Kyllähän se wattia per fps paranee pelkällä power limitilläkin? Vai meinaatko, että toimii myös toiseen suuntaan eli vaikka 4090 nostan powerlimitin 450w->600w niin fps nousee jonkun 30%? Ei taida kuitenkaan nousta..Mutta se wattia per fps ei laske yhtään tuolla power limitin laskemisella. Alivoltituksella laskee.

Jep, eli tämän yksittäisen vuotajan kohdalla, josta oli kyse, tiedot perustuisi tyypillisesti jonkinlaisiin testituloksiin eikä random arvauksiin.Helposti uskon, että nvidia sisäisesti testaa ja valmistelee 5090 tuotteen mikä olisi maksimissaan 600W. Se mistä en ole yhtä mieltä on, että 5090fe varmuudella on 600W ja 600W 5090fe tiedon kanssa voi mennä pankkiin. Voi olla 600W voi olla 450W, voi olla 500W ja voi olla että FE ja aib oc:t on eri wateilla.

Samaahan nähtiin kopitelta adan kanssa. Watit vaihtuu viikoittain kun ei ymmäretä sitä tietoa mitä vuotaja on antanut.Toki voi olla että myös ymmärretään tieto mutta tahallaan vuodetaan eri tavalla klikkien maksimoimiseksi.

Pelkkä powerlimitin lasku 450W -> 350W ei lineaarisesti laske kelloja/suorituskykyä samassa suhteessa. Useinhan on niin, että ne korkeimmat kellot saavutetaan tuhlaavaisesti.Mutta se wattia per fps ei laske yhtään tuolla power limitin laskemisella.

Ei tietenkään, mutta 4090 on defaulttina jo markkinoiden energiatehokkain kortti. Aika usein ilman mitään rajoituksia tehonkulutus on 200-300W luokkaa 7800X3D prossulla, jos nyt ei puhuta raskaimmista RT-peleistä. Se että laskee power limittiä ei isossa osassa pelejä vaikuta yhtään tuohon tehonkulutukseen, kun se on tuolla kortilla muutenkin niin matala.Jep, eli tämän yksittäisen vuotajan kohdalla, josta oli kyse, tiedot perustuisi tyypillisesti jonkinlaisiin testituloksiin eikä random arvauksiin.

On juu mahdollista että kopite ja tekkisivustot ilmaisevat asiat epäselvästi ja harhaanjohtavasti rahanahneuden, epäpätevyyden, egoistisen maineen tavoittelun tai muun heikkoiden takia, mutta informaation lähde ei välttämättä aina ole oma hattu, kuten yllä haluttiin pelkistää.

Pelkkä powerlimitin lasku 450W -> 350W ei lineaarisesti laske kelloja/suorituskykyä samassa suhteessa. Useinhan on niin, että ne korkeimmat kellot saavutetaan tuhlaavaisesti.

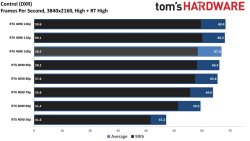

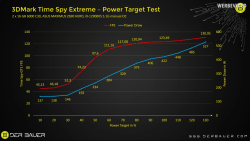

Usempi saitti testasi tätä 4090:n julkaisussa:

Mutta siitä olen toki samaa mieltä, että alivoltittaminen järkevämpää.

Varmaan oli harhaanjohtava esimerkki epärealistisuudessaan joo. Otetaan sitten peli joka kuluttaa 350W, lasketaan limitti niin että kuluttaa 10% vähemmän ja suorituskyky ei laske kuitenkaan 10%:a. Energiatehokkuus paranee, se oli pointti.Edit. Tuohon 450W -> 350W ei laske melkein missään tilanteessa kelloja myöskään koska todella harva peli käyttää sen yli 350W. Eli käytännössä tehonkulutus ei tipu yhtään tuolla rajoituksella.