Nyt ei kuitenkaan @kajakkivajakki lähteny vertaamaan yhtään sitä yhtä sukupolvea pidemmälle niitä korttien teho/euroja niin ei ollut mitään tarvetta inflaation vaikutuksia ihmetellä.Ei se samaan generaatioon vaikutakaan, mutta jos lähdetään vertaamaan yleisesti vähänkään pidemmälle niin onhan sillä massiivinen vaikutus.

Mitä budjetti pelaamiseen tulee, niin ei siitä montaa vuotta ole kun rx580 sai kaupasta sillä 150 eurolla ja itsekin ostin 2600x:n alle 120e jimssistä. Noiden edullisempien korttien hinta on sinänsä pysynyt hyvin omistuksessa, kun uudet kortit eivät noille hintatasoille ole laskeneet missään vaiheessa.

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2024 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

-

Hyvää joulua!

Osallistu io-techin piparikakkutalokilpailuun 2024 Linkki osallistumisketjuun >>>

SER-huutokaupat hyväntekeväisyyteen käynnissä! Linkki huutokauppaan >>>

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA-spekulaatioketju (Lovelace ja tulevat sukupolvet)

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 258

Noita katenumeroita voi heitellä pepusta. Miten olet päätynyt 70% katteeseen? EVGA:n kate ei ollut niin iso, igor's lab:in artikkeli laittoi katteet 5-10%:lle aib:lle amperen suhteen. 5nm pohjaiset piirit ovat kalliimpia valmiista, kalliimpia suunnitella ja fe tuuletinta, virransyöttöä yms. on tuunattu paremmaksi ei välttämättä halvemmaksi versus ampere. Tuo 4n ad102 saattaa olla tuplahintainen pelkän piirin valmistamisen osalta versus ga102 ennen kuin aletaan latomaan muita kohonneita kustannuksia ja r&d kuluja päälle,...Lienee kuitenkin ihan kivat n. 70% kate valmistuskustannusten jälkeen noissa top level korteissa (ainakin chipin osalta).

Mä väittäsin, että noi isot piirit on pelimaailman ferrareita. Jos ne jää ostamatta niin ne helposti voi myös jäädä tekemättä tai päätyvät samaan kategoriaan hopper konesaligpu:n kanssa missä myydään vain entistä kalliimpaa tuotetta pro-käyttäjille ja jää kuluttajat välistä. En usko, että kysyntää laskemalla tuollainen piiri tulisi halvemmaksi muuta kuin loppuunmyynnissä ja seuraavassa generaatiossa jäisi piiri välistä.

Nyt ei kuitenkaan @kajakkivajakki lähteny vertaamaan yhtään sitä yhtä sukupolvea pidemmälle niitä korttien teho/euroja niin ei ollut mitään tarvetta inflaation vaikutuksia ihmetellä.

Ok, luin ne tekstit ja generaatiolta generaatiolle antoi vaan väärän käsityksen.

Mitä katteisiin tulee, niin jos tuosta siirtyy nykyään 70%+ suoraan nvidialla ja se 5-10% OEM tahoille niin kyllähän siellä katteet on kunnossa, vaikka eivät välttämättä itse korttien valmistajilla (ja siis OEM katteet ovat laskeneet koko ajan).

- Liittynyt

- 24.06.2020

- Viestejä

- 1 229

Noita katenumeroita voi heitellä pepusta. Miten olet päätynyt 70% katteeseen? EVGA:n kate ei ollut niin iso, igor's lab:in artikkeli laittoi katteet 5-10%:lle aib:lle amperen suhteen. 5nm pohjaiset piirit ovat kalliimpia valmiista, kalliimpia suunnitella ja fe tuuletinta, virransyöttöä yms. on tuunattu paremmaksi ei välttämättä halvemmaksi versus ampere. Tuo 4n ad102 saattaa olla tuplahintainen pelkän piirin valmistamisen osalta versus ga102 ennen kuin aletaan latomaan muita kohonneita kustannuksia ja r&d kuluja päälle,...

Mä väittäsin, että noi isot piirit on pelimaailman ferrareita. Jos ne jää ostamatta niin ne helposti voi myös jäädä tekemättä tai päätyvät samaan kategoriaan hopper konesaligpu:n kanssa missä myydään vain entistä kalliimpaa tuotetta pro-käyttäjille ja jää kuluttajat välistä. En usko, että kysyntää laskemalla tuollainen piiri tulisi halvemmaksi muuta kuin loppuunmyynnissä ja seuraavassa generaatiossa jäisi piiri välistä.

Muah, Nvidian kate on aivan eri luokkaa kuin AIB:n. Sanoin, että "kate chip:lle". Nvidia myy ne AIB:lle. Nvidian net sales - COGS on jo pitkään ollut 60+ ja viimeksi n. 65%. Sä voit itse heitellä pepusta noita lukuja, mutta tuo 70% on aika lähellä nykytilannetta ja nimenomaan noilla isoilla piireillä se voi olla vielä paljon korkeampikin.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 258

Nvidia antoi kuukausi sitten tulosvaroituksen ja kvartaaliraportin missä firman bruttovoitto 40% pinnassa entisen reilun 60% sijaan. Tämä siitä huolimatta että konesalibisnes ei yski ja konesalibisneksen koko tuplat pelipuoleen verrattuna.Muah, Nvidian kate on aivan eri luokkaa kuin AIB:n. Sanoin, että "kate chip:lle". Nvidia myy ne AIB:lle. Nvidian net sales - COGS on jo pitkään ollut 60+ ja viimeksi n. 65%. Sä voit itse heitellä pepusta noita lukuja, mutta tuo 70% on aika lähellä nykytilannetta ja nimenomaan noilla isoilla piireillä se voi olla vielä paljon korkeampikin.

Mutta joo, arvailla voi, mutta ei kannata arvailua väittää tiedoksi. Kate pitää kuitenkin laskea lopputuotteesta. Olis niin helppoa, jos ainoa kustannus olisi piikiekko.

Täysin hyödytön kuva, kun verrataan kahta täysin eri asiaa. Pitäis verrata dlss3 101 fps ja natiivi 101 fps.

Tuossa Cyberpunk 2077 vertailussahan näkyy, että viive on sama DLSS2 vs. DLSS3, mutta DLSS3:lla fps on ~30 enemmän. Eli ei lisää viivettä. Tuo on tosin varmaan saavutettu Nvidia Reflexillä

Tätä en ollut nähnyt vielä mainittavan. Että kun peliä pystytään ajamaan korkeammalla FPS:llä niin silloin myös paneelia pystytään ajamaan korkeammalla virkistystaajuudella, joka vähentää viivettä, eikö vain? Tämä siis kun oletetaan että on G-sync tai vastaava VRR-teknologia käytössä.

Viimeksi muokattu:

- Liittynyt

- 21.06.2017

- Viestejä

- 7 278

Tuossa Cyberpunk 2077 vertailussahan näkyy, että viive on sama DLSS2 vs. DLSS3, mutta DLSS3:lla fps on ~30 enemmän. Eli ei lisää viivettä. Tuo on tosin varmaan saavutettu Nvidia Reflexillä jonka tukea ei kovin monesta näytöstä löydy.

Eikö se nimenomaan osoita sen että viivettä tulee lisää? Suuremman FPS:n pitäisi laskea viivettä, jos se on nyt kuitenkin sama kuin alemmalla FPS:llä niin silloinhan viive on jossain muualla pipelinessä korkeampi.

- Liittynyt

- 17.09.2020

- Viestejä

- 280

Riippuu miten tuota katsoo. Jos vaihtoehtona on 60fps vs. DLSS3 120fps niin niissä on sama viive, eli mitään ei tullut lisää joten miksi et käyttäisi DLSS3:sta jolla saat smoothimman kuvan (olettaen että se oikeasti toimii)? Jos vertaa 120fps vs. DLSS3 120fps niin viivettä on toki yhden framen verran, kun ne on puhtaasti näytönohjaimen ennustamia joihin ei käyttäjän komentoja lasketa mukaan.

Toisin sanoaen, viive on korkeampi kuin samalla natiivi FPS:llä, mutta DLSS3:n päälle laittaminen ei viivettä lainkaan lisää kun et peliä alkujaankaan 120fps pyörittänyt.

Toisin sanoaen, viive on korkeampi kuin samalla natiivi FPS:llä, mutta DLSS3:n päälle laittaminen ei viivettä lainkaan lisää kun et peliä alkujaankaan 120fps pyörittänyt.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 394

Reflexin vaikutus viiveeseen ei ole riippuvainen yhteensopivasta näytöstä. Eli kunhan on riittävän uusi Nvidian näyttis ja peli joka tukee Reflexiä niin sitä voi hyödyntää millä tahansa näyttölaitteella.Tuo on tosin varmaan saavutettu Nvidia Reflexillä jonka tukea ei kovin monesta näytöstä löydy.

Reflex Analyzer on ominaisuus joissain näytöissä, jolla voi monitoroida hiiren viivettä tms. kunhan hiirikin yhteensopiva.

Koska se näyttää, ainakin sen ainoan näkemäni vertailun perusteella, merkittävän huonolta.Riippuu miten tuota katsoo. Jos vaihtoehtona on 60fps vs. DLSS3 120fps niin niissä on sama viive, eli mitään ei tullut lisää joten miksi et käyttäisi DLSS3:sta jolla saat smoothimman kuvan (olettaen että se oikeasti toimii)? Jos vertaa 120fps vs. DLSS3 120fps niin viivettä on toki yhden framen verran, kun ne on puhtaasti näytönohjaimen ennustamia joihin ei käyttäjän komentoja lasketa mukaan.

Toisin sanoaen, viive on korkeampi kuin samalla natiivi FPS:llä, mutta DLSS3:n päälle laittaminen ei viivettä lainkaan lisää kun et peliä alkujaankaan 120fps pyörittänyt.

- Liittynyt

- 02.12.2019

- Viestejä

- 652

Jos vaihtoehtona on 60fps vs. DLSS3 120fps niin niissä on sama viive

Koska jos se toimii noin, niin se peli tulee silti tuntumaan 60fps peliltä. Jos sillä pystyy pelaamaan, onnittelut niille tyypeille. Ja vaikka lähtökohtana olisi se 90fps (joka itselle on se absoluuttinen minimi) ja dlss3 nostaisi sen vaikkapa 180fps, niin siinäkin on vaarana se, että se tuntuisi liian väärältä.

Varmasti jossain tosi hidastempoisissa peleissä dlss3 tulee olemaan ok, mutta se suurin epäily kohdistuu siihen, miten nää nopeatempoiset pelit (esim räiskinnät) sillä sitten toimii.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 278

Riippuu miten tuota katsoo. Jos vaihtoehtona on 60fps vs. DLSS3 120fps niin niissä on sama viive, eli mitään ei tullut lisää joten miksi et käyttäisi DLSS3:sta jolla saat smoothimman kuvan (olettaen että se oikeasti toimii)? Jos vertaa 120fps vs. DLSS3 120fps niin viivettä on toki yhden framen verran, kun ne on puhtaasti näytönohjaimen ennustamia joihin ei käyttäjän komentoja lasketa mukaan.

Toisin sanoaen, viive on korkeampi kuin samalla natiivi FPS:llä, mutta DLSS3:n päälle laittaminen ei viivettä lainkaan lisää kun et peliä alkujaankaan 120fps pyörittänyt.

Näytöthän on jo pitkään tehny tuplausta jos ollaan adaptive sync alueella, eli 60FPS tuplataan jolloin näyttö pyörittää peliä 120Hz. Eli tuodaanko tässä nyt markkinoille kaikkien aikojen huijaus?

Näytöthän on jo pitkään tehny tuplausta jos ollaan adaptive sync alueella, eli 60FPS tuplataan jolloin näyttö pyörittää peliä 120Hz. Eli tuodaanko tässä nyt markkinoille kaikkien aikojen huijaus?Toi näytön tuplaushan ei näy FPS mittareissa mutta tää nvidian gimmikki näkyy FPS mittareissa vaikka latessin puoleen on ihan sama pyöriikö se 60FPS vaiko 120FPS.

Se että näyttö piirtää saman kuvan kahdesti perättäin ei lisää fps.

Näytöthän on jo pitkään tehny tuplausta jos ollaan adaptive sync alueella, eli 60FPS tuplataan jolloin näyttö pyörittää peliä 120Hz. Eli tuodaanko tässä nyt markkinoille kaikkien aikojen huijaus?Toi näytön tuplaushan ei näy FPS mittareissa mutta tää nvidian gimmikki näkyy FPS mittareissa vaikka latessin puoleen on ihan sama pyöriikö se 60FPS vaiko 120FPS.

Ketä tässä nyt kusetetaan ja miten?

Viimeksi muokattu:

Tällä videolla puhutaan siitä, kuinka surkea PCIe 3.0 -virtaliitin on. Ilmeisesti sitä saa kiinnittää ja irroittaa vaan 30 kertaa ennen kuin liitin alkaa hajota, tuleekohan tuo aiheuttamaan ongelmia myös PCIe 3.0 -virtalähteiden kanssa? Sama liitinhän niissä on kuin tuossa adapterissa...

Jos se OIKEASTI kestää vähintään sen 30 kertaa 100%:n todennäköisyydellä, niin en näe miten asia tulisi vielä kovin monelle ongelmaksi. Lähinnä tulee mieleen, tesitivustot.

Mutta tuhan on helppoa testata!

Ottaa ja tekee pikku irrooita / kiinnitä session testilaitteilla. Sen liittimen lämpötilan voi esim mitata, kun ajaa tietyn testisoftan ekalla kiinnityksella ja siitten rämppää sitä vaikka 100 kertaa ja mittaa lämpötilan ja 100 kertaa uudestaan ja...

Käytännössähän tuo kestävyys riippuu 90% sesti materiaaleista. Jos on tehty paskasta materiaalista liuskat, jotka löystyvät ja saavat huonosti kosketusta, niin on täysin selvää, että liitin sulaa helposti. Jos taas on kunnollisista, niin tuskin on ongelmia.

Mutta tuhan on helppoa testata!

Ottaa ja tekee pikku irrooita / kiinnitä session testilaitteilla. Sen liittimen lämpötilan voi esim mitata, kun ajaa tietyn testisoftan ekalla kiinnityksella ja siitten rämppää sitä vaikka 100 kertaa ja mittaa lämpötilan ja 100 kertaa uudestaan ja...

Käytännössähän tuo kestävyys riippuu 90% sesti materiaaleista. Jos on tehty paskasta materiaalista liuskat, jotka löystyvät ja saavat huonosti kosketusta, niin on täysin selvää, että liitin sulaa helposti. Jos taas on kunnollisista, niin tuskin on ongelmia.

Viimeksi muokattu:

Clarenz

Tukijäsen

- Liittynyt

- 17.10.2016

- Viestejä

- 1 800

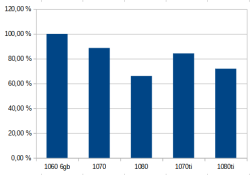

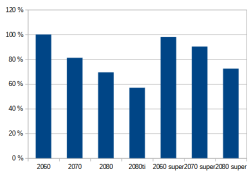

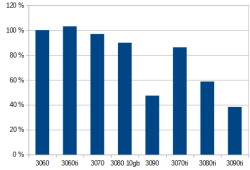

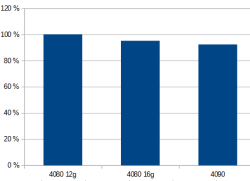

Itseasiassa tähän on olemassa aivan yksinkertainen syy: kilpailu.Generaatio generaatiolta itseni kaltaiselle ns tarkan markan budjettipelaajalle tilanne on huonontunut.

Ennemminkin jo kirjoittanut, että 3000 sarjassa oli kehno suuntaus eli hinta putosi suurinpiirtein samassa suhteessa kuin tehot -> Aiemmin budjettipelaaja sai paremmin tehoa pienemmällä rahalla.

Mittarina käytetty Techpowerupin relative perfonmance listausta ja julkaisuhintaa dollareina.

Nyt eilen piirtelin excelillä käppyrät:

Nyt julkaistusta 4000 sarjastahan ei ole oikeata dataa saatavilla, vain Nvidian itsensä julkaisemat muutamat pelit.

Niiden kertoma on vieläkin tasapäisempää teho/hinta leikkausta kuin 3000 sarjassa.

Viimeisimmissä generaatioissa kilpailu on yltänyt vahvemmin ihan yläpäähän asti ja Nvidia ei ole voinut rahastaa niillä niin paljoa, kuin silloin kun kortilla ei ollut käytännössä mitään kilpailua omassa teholuokassaan. Väitän jopa, että sinä et ole hävinnyt tarkan markan pelaajana mitään, mutta high- ja midhigh-luokan pelaajat on voittanut (joko säästänyt rahaa tai saanut enemmän tehoa kalliilla summalla). 4000-sarjaa ei vielä oikein voi verrata kun ei ole 60-sarjaa ulkona eikä tiedetä kilpailuasetelmaa.

Tällä videolla puhutaan siitä, kuinka surkea PCIe 3.0 -virtaliitin on. Ilmeisesti sitä saa kiinnittää ja irroittaa vaan 30 kertaa ennen kuin liitin alkaa hajota, tuleekohan tuo aiheuttamaan ongelmia myös PCIe 3.0 -virtalähteiden kanssa? Sama liitinhän niissä on kuin tuossa adapterissa...

Suosittelen kaivamaan vanhempien liittimien datalehtiä esim. Molexin sivuilta ja katsomaan mitään lupaillaan kiinnityssykleiksi (vinkki: se on samat 30 kiinnityssykliä 8-pin PCI-E lisävirtaliittimelle)...

Tässä on taas vauhdissa idiootit Youtubettajat, joilla ei ole yhtään mitään käryä siitä, mistä he puhuvat. Ollaan kaikkitietävää elektroniikasta, mutta edes datalehtiä ei osata selata. Mutta saapahan paljon klikkejä, kun tekee sensaatiohakuisia juttuja tyhjästä ja laiskat ihmiset levittelee ne sitten ympäri nettiä, kun eivät viitsi edes tarkistaa, että puhuukohan tuo puhuva pää X totta vai ei...

Suosittelen kaivamaan vanhempien liittimien datalehtiä esim. Molexin sivuilta ja katsomaan mitään lupaillaan kiinnityssykleiksi (vinkki: se on samat 30 kiinnityssykliä 8-pin PCI-E lisävirtaliittimelle)...

Tässä on taas vauhdissa idiootit Youtubettajat, joilla ei ole yhtään mitään käryä siitä, mistä he puhuvat. Ollaan kaikkitietävää elektroniikasta, mutta edes datalehtiä ei osata selata. Mutta saapahan paljon klikkejä, kun tekee sensaatiohakuisia juttuja tyhjästä ja laiskat ihmiset levittelee ne sitten ympäri nettiä, kun eivät viitsi edes tarkistaa, että puhuukohan tuo puhuva pää X totta vai ei...

Mistäs sää tuon löysit sieltä?

Ja toisekseen, on eri asia jos lupaillaan että liitin VARMASTI toimii 30 sykliä, kuin se että se oikeasti alkaa hajota 30 syklin jälkeen merkittävällä todennäköisyydellä.

Ja tuolta lisää:Mistäs sää tuon löysit sieltä?

Ja toisekseen, on eri asia jos lupaillaan että liitin VARMASTI toimii 30 sykliä, kuin se että se oikeasti alkaa hajota 30 syklin jälkeen merkittävällä todennäköisyydellä.

Update: We have confirmed with NVIDIA that the 30-cycle spec for the 16-pin connector is the same as it has been for the past 20+ years. The same 30-cycle spec exists for the standard PCIe/ATX 8-pin connector (aka mini-fit Molex). The same connector is used by AMD and all other GPU vendors too so all of those cards also share a 30-cycle life. So in short, nothing has changed for the RTX 40 GPU series.

NVIDIA GeForce RTX 40 Series PCIe Gen 5 Power Adapters Have a Limited Connect & Disconnect Life of 30 Cycles

The PCIe Gen 5 12VHPWR connector may have a limited connect & disconnect life cycle on NVIDIA's GeForce RTX 40 series graphics cards.

cman

Make ATK Great Again

- Liittynyt

- 17.10.2016

- Viestejä

- 3 068

Juu se Molexin liitin on testattu EIA-364-1000 -standardin mukaisesti, jossa sen täytyy kestää vähintään 30 irroitusta ja kiinnitystä ja resistanssi ei saa muuttua yli 20 milliohmia after dat. Mutta tosiaan sen kestävyydestä pitkässä juoksussa ei ole tietoa.Suosittelen kaivamaan vanhempien liittimien datalehtiä esim. Molexin sivuilta ja katsomaan mitään lupaillaan kiinnityssykleiksi (vinkki: se on samat 30 kiinnityssykliä 8-pin PCI-E lisävirtaliittimelle)...

Tässä on taas vauhdissa idiootit Youtubettajat, joilla ei ole yhtään mitään käryä siitä, mistä he puhuvat. Ollaan kaikkitietävää elektroniikasta, mutta edes datalehtiä ei osata selata. Mutta saapahan paljon klikkejä, kun tekee sensaatiohakuisia juttuja tyhjästä ja laiskat ihmiset levittelee ne sitten ympäri nettiä, kun eivät viitsi edes tarkistaa, että puhuukohan tuo puhuva pää X totta vai ei...

Ite oon 10 vuotta duunissa noita erilaisissa olosuhteissa testanneen voin sanoa, että ihan kevyesti kestää yli 30 irroitusta ja kiinnitystä. Vielä sen jälkeenkin kun niitä on kuritettu lämmössä (>+120°C) ja pakkasessa (jopa -100°C).

Mutta, edellinen pätee vain Molexin Mini Fit JR:eihin . Noi mitä PC:n powereissa ja kaapeleissa yms. käytetään harvemmin varmaan on sitä ns. "aitoa" Molexia. Ainakin ne tuntuu kädessä täysin eilaiselta kuin ne Molexit mitä päivittäin töissä käpistelen. Muovi jota rungoissa käytetään on erilaista, ja veikkaan että sama pätee myös itse liittimeen ja sen pinnoitukseen. Alunperin liitintyyppi on toki Molexin speksaama, mutta tuota liitintyyppiä kun voi valmistaa kuka tahansa, joten laatukin ihan varmasti heittelee laidasta laitaan. Muuthan valmistaja myyvät usein noita 1586041-6, 8 ja 12 -liittiminä koska eivät voi tienkään myydä sitä Mini Fit JR:änä, joka on Molexin oma tuotemerkki.

- Liittynyt

- 17.10.2016

- Viestejä

- 4 751

Jaskapaskakaks-senttiä on tunnettu siitä et se on oikeesti vähän tyhmä äijä. Tai no ei nyt välttämättä niin tyhmä mut tapana on tehä videoita klikkiotsikoilla ilman et asiaa oikeasti tutkitaan, kunhan saadaan video ekana pihalle ja keskustelua herätettyä. Teki 3080 julkasun nurkilla videon niistä POSCapeista jotka on ytimen takana, muistaakseni väitti faktana sitä et kaatuilut johtuu siitä. Ajeli kanssa 3090 Kingpinillä aika rajuja kellotuksia samalla ku VRM:t oli paljaana, lopuks kanssa rikko sen kortin vielä. Tais olla jotain jonkun emolevyn kanssakin vielä missä burgeroitiin homma ihan pystyyn.Tässä on taas vauhdissa idiootit Youtubettajat, joilla ei ole yhtään mitään käryä siitä, mistä he puhuvat. Ollaan kaikkitietävää elektroniikasta, mutta edes datalehtiä ei osata selata. Mutta saapahan paljon klikkejä, kun tekee sensaatiohakuisia juttuja tyhjästä ja laiskat ihmiset levittelee ne sitten ympäri nettiä, kun eivät viitsi edes tarkistaa, että puhuukohan tuo puhuva pää X totta vai ei...

Eikä siinä mitään jos on väärässä, mut en kyl voi sanoa et toi palvelee ketään jos tehdään videoita missä esitetään omia mutuiluja faktoina ja sit ei edes myöhemmin sanota et joo, olin muuten väärässä, sori.

Jaskapaskakaks-senttiä on tunnettu siitä et se on oikeesti vähän tyhmä äijä. Tai no ei nyt välttämättä niin tyhmä mut tapana on tehä videoita klikkiotsikoilla ilman et asiaa oikeasti tutkitaan, kunhan saadaan video ekana pihalle ja keskustelua herätettyä. Teki 3080 julkasun nurkilla videon niistä POSCapeista jotka on ytimen takana, muistaakseni väitti faktana sitä et kaatuilut johtuu siitä. Ajeli kanssa 3090 Kingpinillä aika rajuja kellotuksia samalla ku VRM:t oli paljaana, lopuks kanssa rikko sen kortin vielä. Tais olla jotain jonkun emolevyn kanssakin vielä missä burgeroitiin homma ihan pystyyn.

Eikä siinä mitään jos on väärässä, mut en kyl voi sanoa et toi palvelee ketään jos tehdään videoita missä esitetään omia mutuiluja faktoina ja sit ei edes myöhemmin sanota et joo, olin muuten väärässä, sori.

Jep ja eikö tästä uusien PCIe liittimien ”30 irroituskerrasta” ollut kohu jo silloin kun RTX30-sarja julkaistiin

- Liittynyt

- 17.10.2016

- Viestejä

- 4 751

Oli. 3080 ja 3090 Founders Editioneissa ainakin oli suht samanlainen liitin josta oli samaa juttua et ei voi irrotella liian monta kertaa. Oiskohan ollu about sama määrä. Ei oo kuitenkaa vielä kuulunu keneltäkään sitä et ois liitin menny paskaks.Jep ja eikö tästä uusien PCIe liittimien ”30 irroituskerrasta” ollut kohu jo silloin kun RTX30-sarja julkaistiin

- Liittynyt

- 14.10.2016

- Viestejä

- 22 657

Ne eivät olleet PCIe-liittimiä vaan NVIDIAn oma kikkare (toki lähes sama fyysisesti mutta ei ihan vaikkei sideband-pinnejä laskettaisi)Jep ja eikö tästä uusien PCIe liittimien ”30 irroituskerrasta” ollut kohu jo silloin kun RTX30-sarja julkaistiin

- Liittynyt

- 14.05.2021

- Viestejä

- 588

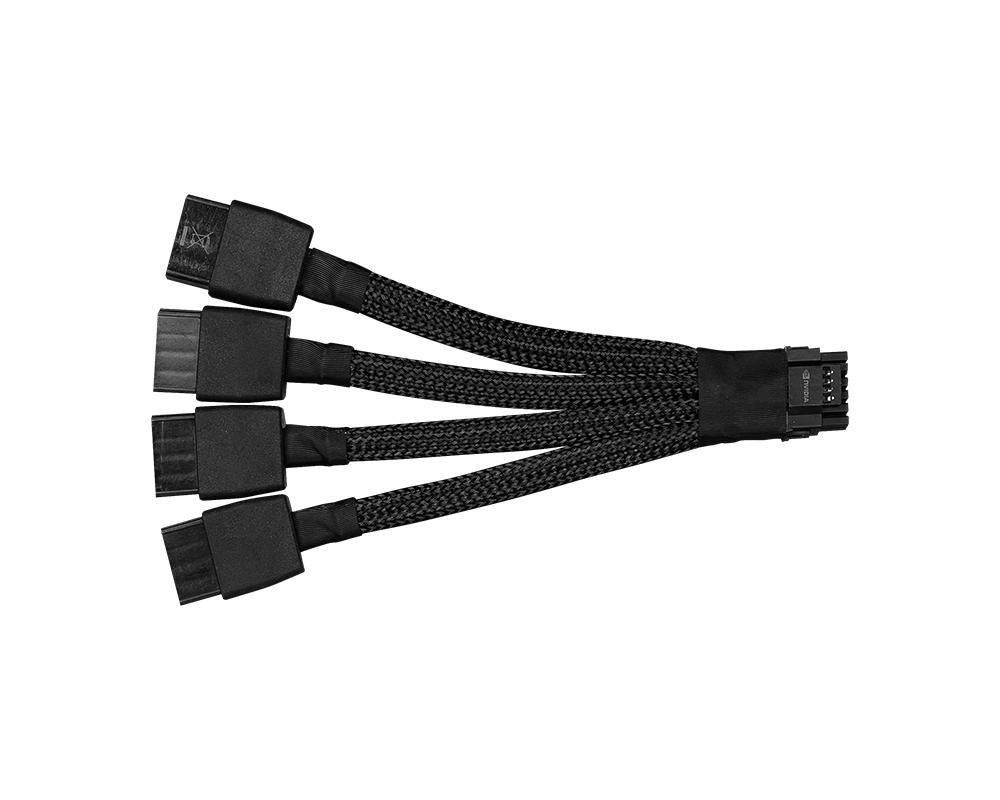

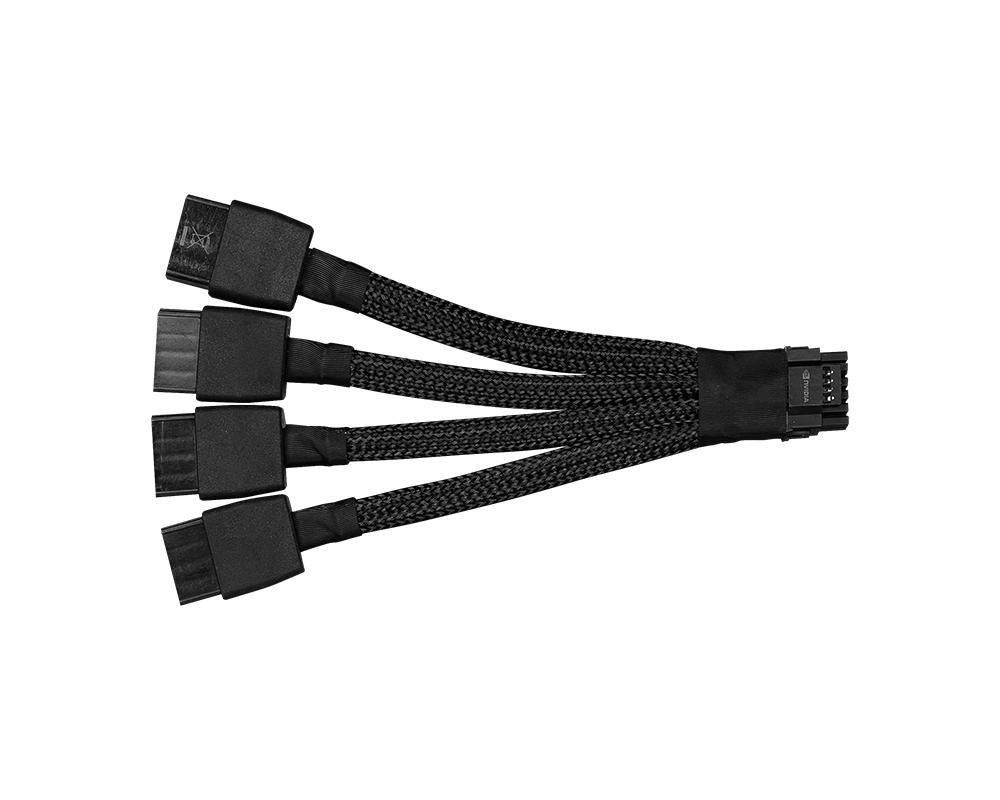

ottamatta kantaa tuohon 30 kerran liitäntäkulumiseen niin itseäni kiinnostaa enemmän tuo virran jakautuminen splitteriä käytettäessä kun ei ole tarkotus uutta virtalähdettä ostella (jos nyt uutta korttiakaan ostaa, saa nähdä).

esim 3x8 pin oli testissä aika epätasainen jakauma jos 150w per 8pin on maksimi.

onko nykyisillä splittereillä ollut mitään vastaavaa kun en itse ainakaan muista mitään nähneeni aiheesta?

12VHPWR Connector To 3 x 8-Pin Adapter In 450W Test Load:

wccftech.com

wccftech.com

esim 3x8 pin oli testissä aika epätasainen jakauma jos 150w per 8pin on maksimi.

onko nykyisillä splittereillä ollut mitään vastaavaa kun en itse ainakaan muista mitään nähneeni aiheesta?

12VHPWR Connector To 3 x 8-Pin Adapter In 450W Test Load:

- 1 x 8-Pin Connector = 25.34A or 282.4W (88% Increase Over 150W Rating)

- 1 x 8-Pin Connector = 7.9A or 94.8W (Within 150W Power Rating)

- 1 x 8-Pin Connector = 6.41 or 76.92W (Within 150W Power Rating)

PCI-SIG Warns of Potential Overcurrent/Overpower Risk With 12VHPWR Connectors Using Non-ATX 3.0 PSU & Gen 5 Adapter Plugs

With ATX 3.0 PSU's coming soon, there has been talk about a major safety concern affecting the 12VHPWR Gen 5 connector as per PCI-SIG.

bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 3 705

ottamatta kantaa tuohon 30 kerran liitäntäkulumiseen niin itseäni kiinnostaa enemmän tuo virran jakautuminen splitteriä käytettäessä kun ei ole tarkotus uutta virtalähdettä ostella (jos nyt uutta korttiakaan ostaa, saa nähdä).

esim 3x8 pin oli testissä aika epätasainen jakauma jos 150w per 8pin on maksimi.

onko nykyisillä splittereillä ollut mitään vastaavaa kun en itse ainakaan muista mitään nähneeni aiheesta?

12VHPWR Connector To 3 x 8-Pin Adapter In 450W Test Load:

linkki itse artikkeliin

- 1 x 8-Pin Connector = 25.34A or 282.4W (88% Increase Over 150W Rating)

- 1 x 8-Pin Connector = 7.9A or 94.8W (Within 150W Power Rating)

- 1 x 8-Pin Connector = 6.41 or 76.92W (Within 150W Power Rating)

PCI-SIG Warns of Potential Overcurrent/Overpower Risk With 12VHPWR Connectors Using Non-ATX 3.0 PSU & Gen 5 Adapter Plugs

With ATX 3.0 PSU's coming soon, there has been talk about a major safety concern affecting the 12VHPWR Gen 5 connector as per PCI-SIG.wccftech.com

Jos on virtalähteessä modulaariset kaapelit niin paras vaihtoehto on ostaa uusi kaapeli tuolle uudelle liittimelle joka tulee suoraan 2 tai 3x pci-e liittimiin powerin kyljessä niin jää yksi väliliitos pois.

Ainakin Corsairilta saa suoraan ja Cablemod sitten tekee ainakin Corsair, EVGA ja Seasonic / Asus virtalähteille.

Jos 8 pin on mitotettu 150w niin tuo 2 liittimen käyttäminen vaikuttaa hieman epäilyttävältä... se että tuleeko 4090 mallia varten update mallit kun nuissa adaptereissa lukee spekseissä että 3090:stä varten suunniteltu.Jos on virtalähteessä modulaariset kaapelit niin paras vaihtoehto on ostaa uusi kaapeli tuolle uudelle liittimelle joka tulee suoraan 2 tai 3x pci-e liittimiin powerin kyljessä niin jää yksi väliliitos pois.

Ainakin Corsairilta saa suoraan ja Cablemod sitten tekee ainakin Corsair, EVGA ja Seasonic / Asus virtalähteille.

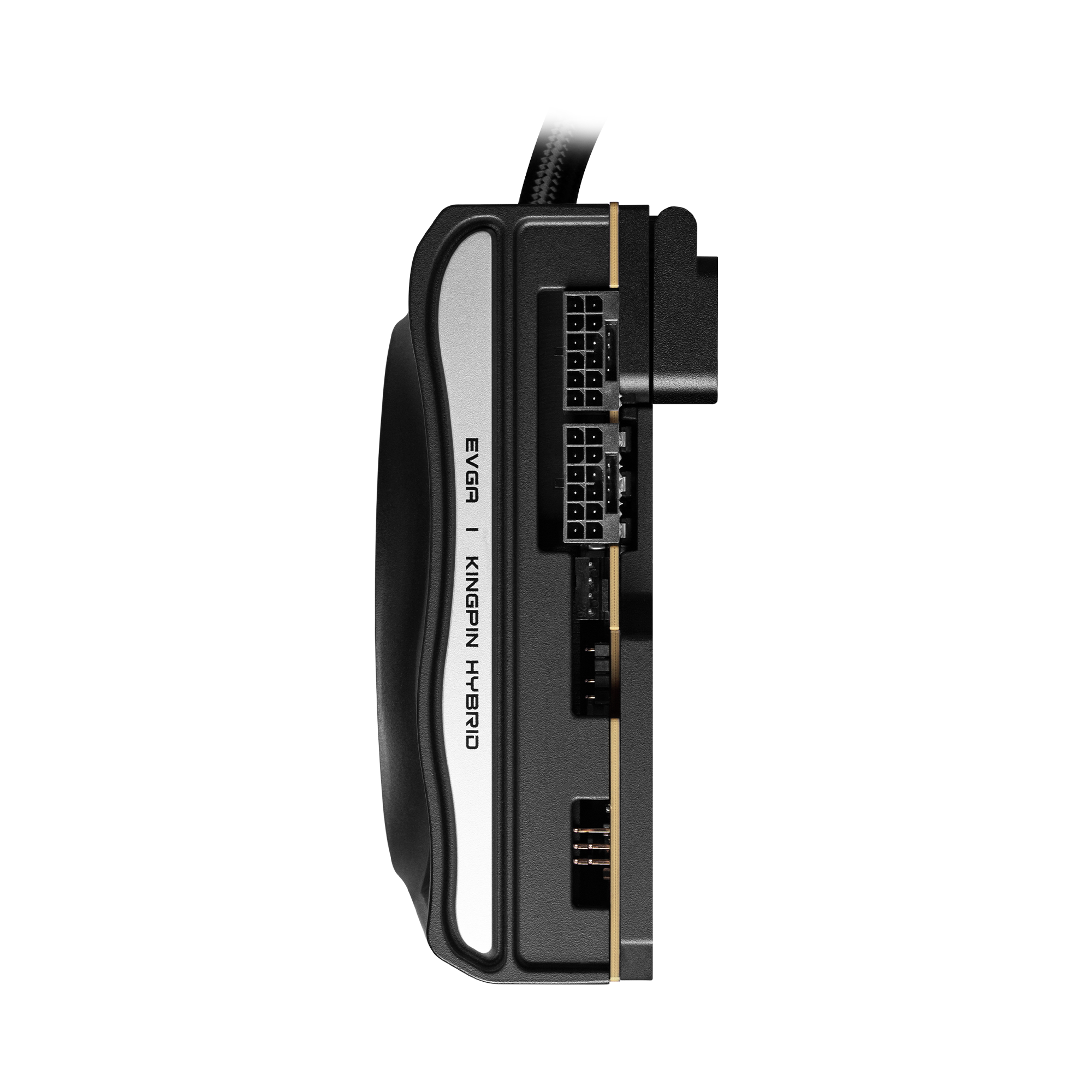

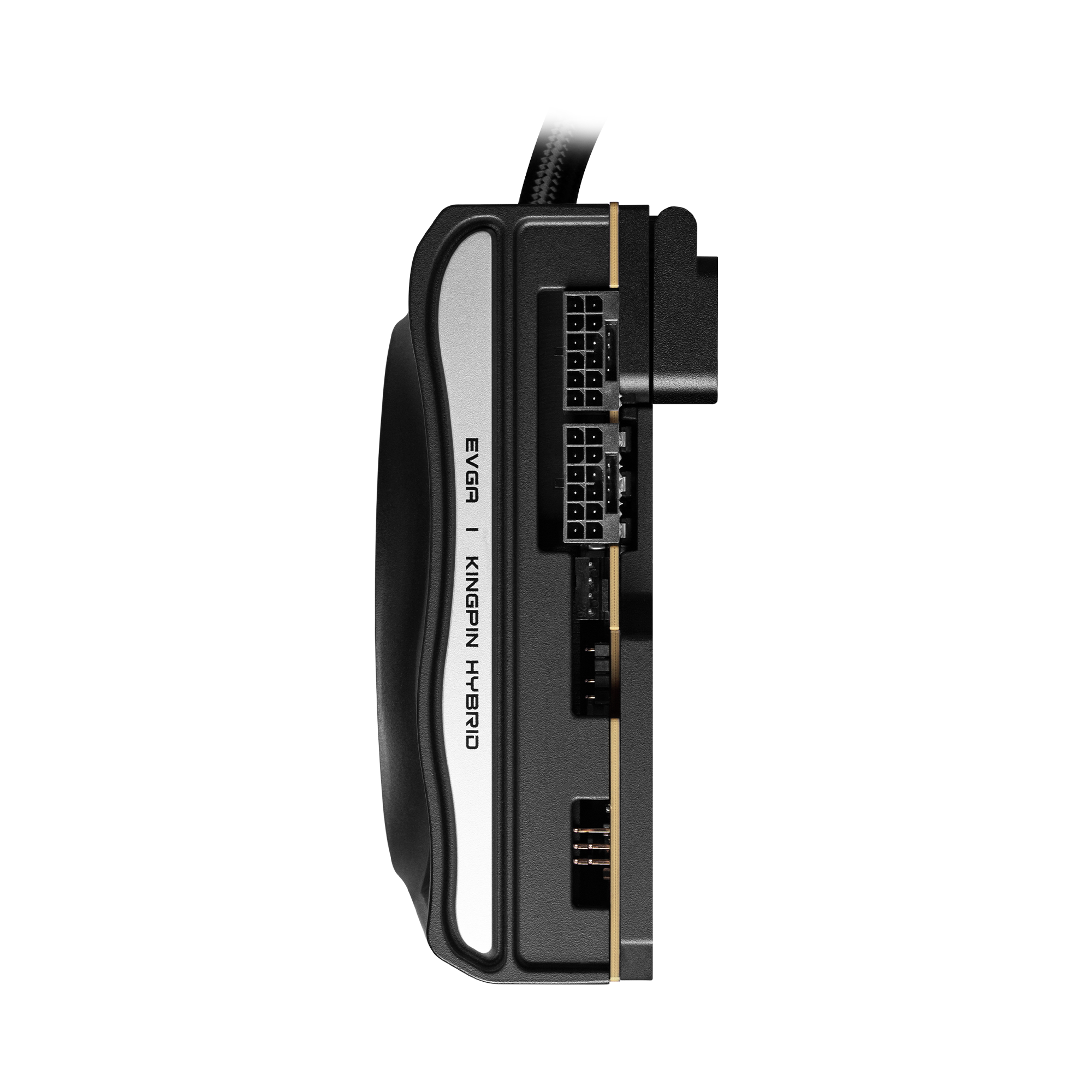

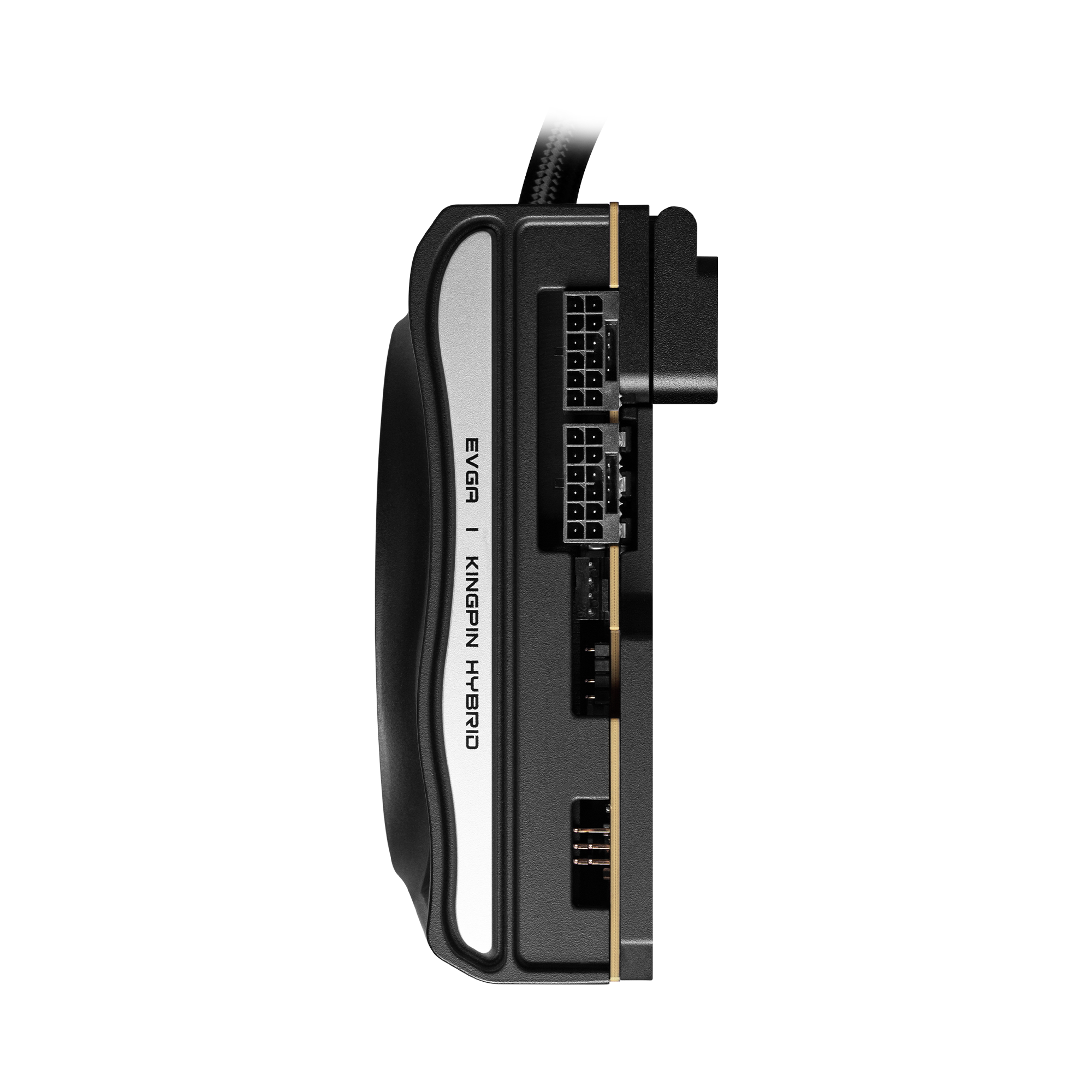

Ainakin EVGA:lla oli näin.

Se Corsairin menee käsittääkseni psu:lle kiinni eikä ole ns. adapteri vaan uusi johto. Ja ne lähdöthän on kaksipäiselle pcie 8pin:lle(2x 2x150) eli luulisi olevan ok.Jos 8 pin on mitotettu 150w niin tuo 2 liittimen käyttäminen vaikuttaa hieman epäilyttävältä... se että tuleeko 4090 mallia varten update mallit kun nuissa adaptereissa lukee spekseissä että 3090:stä varten suunniteltu.

Ainakin EVGA:lla oli näin.

Tuo epätasainen kuorma vähän ihmetyttää. Onko tuo kolmepäinen adapteri jotenkin kustu vai eikö tuossa toimi hyvin yksinkertainen logiikka, että sieltä uudesta liittimestä jaettaisiin vaan ne kuusi 12v-johtoa kolmelle eli 2 per letku?

Piti kaivaa hetki että löysin aiheesta aiemmmin olleen jutun...Tuo epätasainen kuorma vähän ihmetyttää. Onko tuo kolmepäinen adapteri jotenkin kustu vai eikö tuossa toimi hyvin yksinkertainen logiikka, että sieltä uudesta liittimestä jaettaisiin vaan ne kuusi 12v-johtoa kolmelle eli 2 per letku?

This power adapter for EVGA RTX 3090 Ti Kingpin has FIVE 8-pin connectors - VideoCardz.com

EVGA PowerLink 52U for THE Kingpin EVGA showcases how to deal with new Kingpin GPU power requirements. The company recently announced its flagship RTX 3090 Kingpin graphics card will cost 2500 USD. This offer comes bundled with a 1600W power supply that supports as many as nine PEG power...

Itse mietin että voi olla kohta fiksumpaa ostaa toi evga adapteri ja kolvata yksi 12 pinninen pois tuosta niin saa laadukkaan adapterin.

- Liittynyt

- 14.10.2016

- Viestejä

- 22 657

NVIDIAn poropietariliitin ei ole yhteensopiva 12VHPWR:n kanssa vaikkei sideband-pinnejä otettaisikaan huomioon. Ei sovi samaan liittimeen.Piti kaivaa hetki että löysin aiheesta aiemmmin olleen jutun...

EVGA joutu lyömään väli elektroniikkaa adapteriin että saivat sen toimimaan tasaisesti ellen väärin käsittänyt...

This power adapter for EVGA RTX 3090 Ti Kingpin has FIVE 8-pin connectors - VideoCardz.com

EVGA PowerLink 52U for THE Kingpin EVGA showcases how to deal with new Kingpin GPU power requirements. The company recently announced its flagship RTX 3090 Kingpin graphics card will cost 2500 USD. This offer comes bundled with a 1600W power supply that supports as many as nine PEG power...videocardz.com

Itse mietin että voi olla kohta fiksumpaa ostaa toi evga adapteri ja kolvata yksi 12 pinninen pois tuosta niin saa laadukkaan adapterin.

Pff... noh ei kai auta kuin odotella jos tulee päivitetty versio...NVIDIAn poropietariliitin ei ole yhteensopiva 12VHPWR:n kanssa vaikkei sideband-pinnejä otettaisikaan huomioon. Ei sovi samaan liittimeen.

- Liittynyt

- 14.10.2016

- Viestejä

- 22 657

EVGAlta ei ole ainakaan tulossa, missasit vissiin uutisen reilu viikko sitten kun yhtiö ilmoitti että eivät tee enää mitään yhteistyötä NVIDIAn kanssa (pl jo julkaistujen näyttisten tuki)Pff... noh ei kai auta kuin odotella jos tulee päivitetty versio...

Kun kerta 40-sarjan FE-kortit käyttää 12VHPWR-liittimiä niin mikäs ongelma tässä nyt on? Toki ei käy 30-sarjan FE-korttiin tuo EVGA:n adapterin liitin.NVIDIAn poropietariliitin ei ole yhteensopiva 12VHPWR:n kanssa vaikkei sideband-pinnejä otettaisikaan huomioon. Ei sovi samaan liittimeen.

Ei oo Nvidian liittimet nämä:

Virtalähteiden valmistus jatkuu ja omasta mielestäni tämä ei koske virtalähteitä ja näiden adaptereita....EVGAlta ei ole ainakaan tulossa, missasit vissiin uutisen reilu viikko sitten kun yhtiö ilmoitti että eivät tee enää mitään yhteistyötä NVIDIAn kanssa (pl jo julkaistujen näyttisten tuki)

Kerta hankala myydä virtalähteitä jos ne ei käy mihinkään

- Liittynyt

- 14.10.2016

- Viestejä

- 22 657

Jaa toi olikin jo noille, luulin että NVIDIAn 12-pinnisille. Se muuttaa toki kaikenKun kerta 40-sarjan FE-kortit käyttää 12VHPWR-liittimiä niin mikäs ongelma tässä nyt on? Toki ei käy 30-sarjan FE-korttiin tuo EVGA:n adapterin liitin.

Ei oo Nvidian liittimet nämä:

Siihen on yleensä ratkaisuna uudet mallit 12VHPWR-tuella, näyttisvalmistajat miettii niitä adaptereita. Mutta tässä tosiaan tuli väärinkäsitys kun luulin tuon adapterin olevan 2xNV12pin eikä 2x12VHPWRVirtalähteiden valmistus jatkuu ja omasta mielestäni tämä ei koske virtalähteitä ja näiden adaptereita....

Kerta hankala myydä virtalähteitä jos ne ei käy mihinkään

Kyllä tässä härdellissä parhaillekkin virheitä sattuu...Jaa toi olikin jo noille, luulin että NVIDIAn 12-pinnisille. Se muuttaa toki kaiken

Siihen on yleensä ratkaisuna uudet mallit 12VHPWR-tuella, näyttisvalmistajat miettii niitä adaptereita. Mutta tässä tosiaan tuli väärinkäsitys kun luulin tuon adapterin olevan 2xNV12pin eikä 2x12VHPWR

Mutta tuo olisi mielenkiintoista kyllä nähdä jossain arvostelussa testattuna onko sillä vaikutusta kaapelien väliseen kuormitukseen... että tasaako tuo kaapelien välisen kuormituksen että yksi kaapeli ei ylikuormitu...

Muistelen että jossain testissä sen yhden 8 pinnisen kautta olisi mennyt yli 250w

- Liittynyt

- 31.10.2016

- Viestejä

- 459

Tää on Nvidia ketju ja paljon puhutaan 40x0 sarjan pettymyksestä ja aiemman sukupolven ostamisesta (mitä itsekin harkitsen), niin eikö porukkaa kiinnosta AMD:n puoli yhtään? Pidetäänkö Nvidiaa täällä yleisesti ykkösvaihtoehtona? Minua on kiinnostanut nyt 3080-3090 mallit ja niiden hinnanalennukset kovasti, mutta eikö esimerkiksi 6900 XT, 6950 XT tai huippucustom mallin 6800 XT olisi alennuksesta myös aika hyvä ostos? 6900 XT on saanut jopa jollain 800 eurolla varsinkin outleteista (ja tais olla myös hyvä Asus cashback kampanja vasta) ja se on kuitenkin about 3090 RTX tehoinen. Vai arvostaako porukka säteenseurantaa niin paljon, että vain Nvidia kelpaa? Itse todennäköisesti pärjäisin hyvin ilman kyseistä ominaisuutta ja joku 6900 XT 600-700 eurolla olisi jo aika kova. Myös nuo huippu 6800 XT mallit kellottuu samoihin tehoihin.

Pahoittelen jos on offtopiccia puhua AMD:stä.

Itse taidan nyt kuitenkin yrittää jaksaa tuonne AMD:n tulevien uutuuksien julkaisuun ja nähdä mitä markkinat silloin tarjoaa. Ellei tule ihan pirun hyviä tarjouksia ennen sitä. AMD tais vasta taas laskea hintoja lisää.

Pahoittelen jos on offtopiccia puhua AMD:stä.

Itse taidan nyt kuitenkin yrittää jaksaa tuonne AMD:n tulevien uutuuksien julkaisuun ja nähdä mitä markkinat silloin tarjoaa. Ellei tule ihan pirun hyviä tarjouksia ennen sitä. AMD tais vasta taas laskea hintoja lisää.

Tää on Nvidia ketju ja paljon puhutaan 40x0 sarjan pettymyksestä ja aiemman sukupolven ostamisesta (mitä itsekin harkitsen), niin eikö porukkaa kiinnosta AMD:n puoli yhtään? Pidetäänkö Nvidiaa täällä yleisesti ykkösvaihtoehtona? Minua on kiinnostanut nyt 3080-3090 mallit ja niiden hinnanalennukset kovasti, mutta eikö esimerkiksi 6900 XT, 6950 XT tai huippucustom mallin 6800 XT olisi alennuksesta myös aika hyvä ostos? 6900 XT on saanut jopa jollain 800 eurolla varsinkin outleteista (ja tais olla myös hyvä Asus cashback kampanja vasta) ja se on kuitenkin about 3090 RTX tehoinen. Vai arvostaako porukka säteenseurantaa niin paljon, että vain Nvidia kelpaa? Itse todennäköisesti pärjäisin hyvin ilman kyseistä ominaisuutta ja joku 6900 XT 600-700 eurolla olisi jo aika kova. Myös nuo huippu 6800 XT mallit kellottuu samoihin tehoihin.

Pahoittelen jos on offtopiccia puhua AMD:stä.

Itse taidan nyt kuitenkin yrittää jaksaa tuonne AMD:n tulevien uutuuksien julkaisuun ja nähdä mitä markkinat silloin tarjoaa. Ellei tule ihan pirun hyviä tarjouksia ennen sitä. AMD tais vasta taas laskea hintoja lisää.

AMD ei taida vieläkään oikein hanskata RT-pelejä?

- Liittynyt

- 17.09.2020

- Viestejä

- 280

NVidia hanskaa tosiaan RT:n paremmin. Pelit joissa RT:tä ei käytetä pyörii jo muutenkin niin hyvin, ettei kortilla ole enää juuri väliä. NVidialla on myös lähes monopoli AI laskennassa ja muissa hyötysovelluksissa CUDA:n vuoksi. Puhtaaseen pelaamiseen on AMD varmasti ihan toimva valinta.

Ehdottomasti täälläkin odottelemassa AMD:n julkaisua tämän 4000-sarjan flopin jälkeen. Toki kiire ei ole päivittää ja aina voi korttisukupolven skipatakin, jos ei kumpikaan leiri miellytä. Paria RT peliä pelannut nykyisellä 3070:lla, eikä ole päässyt ainakaan omalle kaivattujen grafiikkaominaisuuksien listalle.Tää on Nvidia ketju ja paljon puhutaan 40x0 sarjan pettymyksestä ja aiemman sukupolven ostamisesta (mitä itsekin harkitsen), niin eikö porukkaa kiinnosta AMD:n puoli yhtään? Pidetäänkö Nvidiaa täällä yleisesti ykkösvaihtoehtona? Minua on kiinnostanut nyt 3080-3090 mallit ja niiden hinnanalennukset kovasti, mutta eikö esimerkiksi 6900 XT, 6950 XT tai huippucustom mallin 6800 XT olisi alennuksesta myös aika hyvä ostos? 6900 XT on saanut jopa jollain 800 eurolla varsinkin outleteista (ja tais olla myös hyvä Asus cashback kampanja vasta) ja se on kuitenkin about 3090 RTX tehoinen. Vai arvostaako porukka säteenseurantaa niin paljon, että vain Nvidia kelpaa? Itse todennäköisesti pärjäisin hyvin ilman kyseistä ominaisuutta ja joku 6900 XT 600-700 eurolla olisi jo aika kova. Myös nuo huippu 6800 XT mallit kellottuu samoihin tehoihin.

Pahoittelen jos on offtopiccia puhua AMD:stä.

Itse taidan nyt kuitenkin yrittää jaksaa tuonne AMD:n tulevien uutuuksien julkaisuun ja nähdä mitä markkinat silloin tarjoaa. Ellei tule ihan pirun hyviä tarjouksia ennen sitä. AMD tais vasta taas laskea hintoja lisää.

Itse olen toisaalta hieman naimisissa Nvidian kanssa, kun vuoden 2019 B9 töllö on juuri sitä viimeistä vuosimallia, johon LG ei vaivautunut laittamaan kuin G-sync tuen. (Internetistä löytää joitakin kokemuksia joiden mukaan CRU:lla voisi saada toimimaan, mutta hirveä sählinki lähteä moista koittamaan, jos ei lopulta toimikaan.)

Alkaa hinnat vissiin tuleen pikku hiljaa korteille tietoon

www.verkkokauppa.com

www.verkkokauppa.com

www.verkkokauppa.com

www.verkkokauppa.com

Jimms:llä toistaiseksi place holder hinnat

www.jimms.fi

www.jimms.fi

Proshop listannut paljon korttien hintoja

www.proshop.fi

www.proshop.fi

Proshopin listassa tämä pisti silmään

www.proshop.fi

www.proshop.fi

MSI GeForce RTX 4090 SUPRIM X 24G -näytönohjain

GeForce RTX 40 -sarjan grafiikkasuorittimet antavat äärimmäisen suorituskyvyn niin pelaajien kuin luovan työn tekijöidenkin käyttöön.

Asus GeForce TUF-RTX4090-24G-GAMING -näytönohjain 2 199,99

Asus TUF Gaming GeForce RTX 4090 suunnittelussa on karsittu pois ylimääriset ominaisuudet ja keskitytty luomaan tuote, joka käyttää mahdollisimman laadukkaita komponentteja ja huippuluokan jäähdytystekniikkaa.

Jimms:llä toistaiseksi place holder hinnat

RTX 4090 - GeForce RTX pelaamiseen - Jimms.fi

Jimms.fi on asiantunteva tietotekniikan, komponenttien ja viihde-elektroniikan verkkokauppa. Tilauksiin aina saatavilla ilmainen toimitusvaihtoehto!

Proshop listannut paljon korttien hintoja

Näytönohjaimet - Osta uusi GPU / GFX pelaamista varten täältä

Proshopista löydät laajan valikoiman näytönohjaimia / GPU / GFX.

Proshopin listassa tämä pisti silmään

MSI GeForce RTX 4090 SUPRIM LIQUID X - 24GB GDDR6X RAM - Näytönohjaimet

2 340,45 € Näytönohjain, NVIDIA GeForce RTX 4090 Overclocked (Core clock 2230 MHz / Boost clock 2640 MHz), 16384 CUDA ydintä, voimanlähteenä von NVIDIA DLSS 3, 24 GB GDDR6X (Memory clock 21 GHz) - 384-bit, PCI-Express 4.0 x16, 3 x DisplayPort 1.4 / 1 x HDMI 2.1 liitännät, tukee NVIDIA G-Sync, 1...

Viimeksi muokattu:

bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 3 705

Alkaa hinnat vissiin tuleen pikku hiljaa korteille tietoon

MSI GeForce RTX 4090 SUPRIM X 24G -näytönohjain

GeForce RTX 40 -sarjan grafiikkasuorittimet antavat äärimmäisen suorituskyvyn niin pelaajien kuin luovan työn tekijöidenkin käyttöön.www.verkkokauppa.com

Asus GeForce TUF-RTX4090-24G-GAMING -näytönohjain 2 199,99

Asus TUF Gaming GeForce RTX 4090 suunnittelussa on karsittu pois ylimääriset ominaisuudet ja keskitytty luomaan tuote, joka käyttää mahdollisimman laadukkaita komponentteja ja huippuluokan jäähdytystekniikkaa.www.verkkokauppa.com

Onko verkkokaupan tuotetiedoissa virhe, vai onko Suprim X power limit huomattavasti pienempi kuin TUF? Suprim virtalähdesuositus 850W ja TUF 1200W...

- Liittynyt

- 16.07.2022

- Viestejä

- 79

Onko verkkokaupan tuotetiedoissa virhe, vai onko Suprim X power limit huomattavasti pienempi kuin TUF? Suprim virtalähdesuositus 850W ja TUF 1200W...

Hmm, näyttää olevan 850W myös MSI:n omilla sivuilla:

GeForce RTX™ 4090 SUPRIM X 24G

MSI GeForce RTX 4090 SUPRIM X 24 Gfeaturing a fresh new triple fan design with a sturdy brushed aluminum backplate reinforces the full length of graphics card while providing passive cooling by applying thermal pads.

Uutiset

-

Rentouttavaa ja tunnelmallista joulua 2024!

24.12.2024 09:59

-

Lenovon erikoiset CES-uutuuskannettavat vuotivat julki ennakkoon

20.12.2024 15:23

-

Joulun 2024 piparkakkutalokilpailu on käynnistynyt TechBBS-foorumilla!

20.12.2024 14:42

-

Lenovo valmistelee SteamOS:llä varustettuja käsikonsoliluokan Legion Go -tietokoneita

20.12.2024 14:05

-

Live: io-techin Tekniikkapodcast (51/2024)

20.12.2024 13:50

Uutisia lyhyesti

-

Taittuvanäyttöinen OnePlus Open 2 saatetaan nähdä vasta odotettua myöhemmin

- Juha Kokkonen

- Vastauksia: 0

-

Sony on saavuttanut 20 miljardin toimitetun kamerasensorin rajapyykin

- Kaotik

- Vastauksia: 5

-

-

-