-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2024 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

-

Hyvää joulua!

Osallistu io-techin piparikakkutalokilpailuun 2024 Linkki osallistumisketjuun >>>

SER-huutokaupat hyväntekeväisyyteen käynnissä! Linkki huutokauppaan >>>

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA-spekulaatioketju (Lovelace ja tulevat sukupolvet)

- Liittynyt

- 16.03.2017

- Viestejä

- 1 476

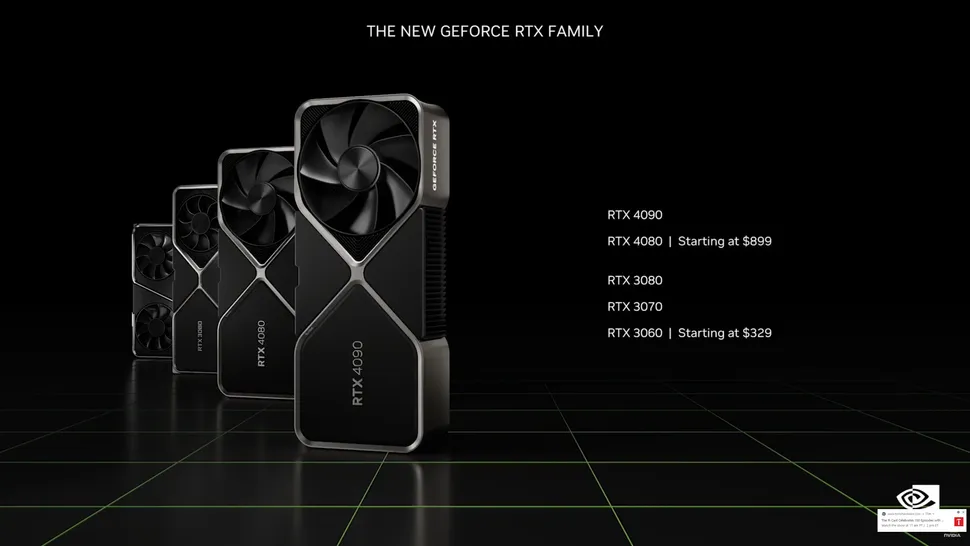

Varmaan 3080 10gb uudella paketilla jossa lukee 4070.Jos alunperin 4070:lle tarkoitettu piiri meni 12Gt 4080:een, mitäköhän 4070 sit tulee olemaan?

Hintalapussa 900e.Varmaan 3080 10gb uudella paketilla jossa lukee 4070.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 575

Ei ehkä tulekaan 4070:aa. Tulee varmaan 4080 SE, 4080 Mini tai 4080 EE (Enthusiast Edition)...Jos alunperin 4070:lle tarkoitettu piiri meni 12Gt 4080:een, mitäköhän 4070 sit tulee olemaan?

- Liittynyt

- 18.11.2016

- Viestejä

- 4 179

Eli vältetään normaali telkkari-motion-interpolaation tuomat järkyttävät latenssit koska uusin kuva on ennustus tilanteesta hieman ennen seuraavaa kuvaa, mutta ei silti muuta sitä ongelmaa että jos inputtia pollataan ja pelisimulaatiota päivitetään vain natiivinopeudella, ellei tuo nopeus ole tarpeeksi korkea, peli tuntuu lagiselta vaikka mittarissa olisi iso numero.

Eli kärjistäen: Jos peli pyörii natiivina 20fps, siitä normaali DLSS upscalella saadaan nostettua "oikea" päivitysnopeus 40fpsään niin sen jälkeen kun lisätään toiset 40fps ennustettuja frameja ja saadaan OMG 80fps!!! niin pelituntuma on silti edelleen sama kuin 40fps tilanteessa, vaikka sivustakatsoja voikin ihastella pehmeämpää ruudunpäivitystä ja isompaa numeroa mittarissa. Saa nähdä miten toimii käytännössä, mutta oma epäilys on että jos natiivi-päivitysnopeus ei ole riittävän korkea, DLSS3 ei tarjoa hyvää kokemusta.

Ja toisesta päästä tulee sitten se ongelma että tämän ennustetun kuvan generointi vie jonkin verran aikaa ja se todennäköisesti on kiinteä aika (resoluutiosta riippuvana) joka asettaa eräänlaisen capin siihen kuinka nopeasti peli voi pyöriä. Esimerkin perusteella ainakin jostain 40-50fps vauhdista (se cyperpunkki-esimerkki) saadaan tuplattua, mutta jos peli onkin nopeatempoista räiskintää ja mittarissa on natiivina vaikkapa 144fps, siitä tuskin saadaan 300fps sille hirmuiselle 360hz TN panelille ja vaikka saataisiin, edelleen inputteihin peli reagoi 144fps mukaan.

Nämä menee mulla aika vahvasti yli sen mitä ymmärrän ja tiedän ymmärtäväni, mutta kyllä tuo minusta lisää myös "enginen" päivitysnopeutta. Kuvan laskeminen, ja muun enginen pyörittäminen on osin rinnakkaista osin peräkkäistä. Jos kuvaa lasketaan nopeammin niin sillä säästyneellä ajalla saadaan puhtaasti prossun pyörittämästä enginestä lisää ulos. Ei kai sitä kuvaa voi minusta mitenkään irroittaa muusta enginestä. Siellä on kaikkea liikkuvaa joka voi osua mihin tahansa ja sitä kaikkea pitää laskea, muutoin ensimmäisenä kuva ja ääni ei vastaa toisiaan.

Tämä on tosiaan ainoa Ampere vs. Ada suorituskykyvertailu mitä tuossa oli. Noista kolme vasemmanpuolimmaista ei käytä mitään DLSS versiota, ja Resident Evil ainoana hyödyntää säteenseurantaa. Tuosta jos katsoo että varmaan harvinaiseksi jäänyt 3090 Ti vastaa aika hyvin 4080 12GB.

Hardware unboxedin 3090 Ti vertailusta se oli noin 24% nopeampi kuin 3080 10 GB. (ehkä 1440p olisi ollut järkevämpi katsoa jos 3090 Ti saa liikaa etua suuremmasta muistimäärästä. Jaa, 16% suorituskykyisempi, sehän näyttää paljon huonommalta)

Esim. 3080 oli vastaavassa 4k 32% nopeampi kuin 2080 Ti. Ja niiden listahinnat oli ihan eri luokkaa.

- Liittynyt

- 16.03.2017

- Viestejä

- 1 476

4070 PE (Poor Edition).Ei ehkä tulekaan 4070:aa. Tulee varmaan 4080 SE, 4080 Mini tai 4080 EE (Enthusiast Edition)...

Series^

Super huolto jumala

- Liittynyt

- 18.10.2016

- Viestejä

- 477

Jos ihmiset ei ostaisi näitä sika hintaisia näytönohjaimia, niin saataisiin hinnat tippumaan.

Ja jos ihmiset ei söis lihaa, niin ei ois lihateollisuuttakaan, ja jos ne lopettas autolla ajamisen ja massiivisen kuluttamisen niin ehkä liikenteen ja rahdin katoamisen myötä ilmasto paranisi! En sano että olet väärässä, mutta niin ikävää kuin se onkin tämmöinen ajattelu on täysin turhaa, koska myös näiden teknologiafirmojen osakkaina/johtokunnassa istuu ihmisiä, ja heitä kiinnostaa se rahasäkki eikä moraaliset utopiahaaveet.

Maksoin 2080ti:stä >tonnin maksoin 3070:sta ~tonnin ja nyt silmäilen 4090 blokin kanssa, rahoja siihen on varattu jo pitkään koska GTX1080 oston jälkeen hintakehityksen suunta on ollut (ainakin mulle) aika selkeä, ja tämä on sen hinta että saa nopeinta (sen mitä haluaa).

Ei se kivaa ole, mut näin se menee.

Maksoin 2080ti:stä >tonnin maksoin 3070:sta ~tonnin ja nyt silmäilen 4090 blokin kanssa, rahoja siihen on varattu jo pitkään koska GTX1080 oston jälkeen hintakehityksen suunta on ollut (ainakin mulle) aika selkeä, ja tämä on sen hinta että saa nopeinta (sen mitä haluaa).

Ei se kivaa ole, mut näin se menee.

Miksi muuten ylipäätään vaihdoit 2080 ti:stä 3070:een, kun ne kai on aika samantehoisia?

Series^

Super huolto jumala

- Liittynyt

- 18.10.2016

- Viestejä

- 477

Miksi muuten ylipäätään vaihdoit 2080 ti:stä 3070:een, kun ne kai on aika samantehoisia?

Vaihdoin ilmajäähdytyksestä vesijäähdytteiseen, ja koska tarkoitus oli louhia tavoittelin myös uutta pidempää takuuaikaa.

- Liittynyt

- 07.08.2018

- Viestejä

- 352

Taas on hyvä hetki äänestää lompakollaan. Totuus on kuitenkin luultavasti se, että jokainen kortti menee mitä kerkeävät tuottaa noilla hinnoilla.

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 283

On kyllä huikeaa jos menee. Euroopan ulkopuolella ehkä, mutta eurooppalaisten ostovoima tippuu tällä hetkellä lähes ennen näkemätöntä vauhtia samaan aikaan kun markkinoille tuodaan ennen näkemättömän kallista näytönohjainta.Taas on hyvä hetki äänestää lompakollaan. Totuus on kuitenkin luultavasti se, että jokainen kortti menee mitä kerkeävät tuottaa noilla hinnoilla.

Tuskin, tilanne oli ihan eri 3000 sarjan julkaisussa pelaajien ja mainareiden osalta.jokainen kortti menee mitä kerkeävät tuottaa noilla hinnoilla.

Samaa mieltä, että kaikki kortit menevät kaupaksi kyllä noihin hintoihin. Ja jos taustalla on edelleen sitä komponenttipulaa, niin miksi Nvidia tekisi liian edullisen kortin jos saavat paremmallakin katteella myötyä. Voi myydä isoja määriä pienemmällä katteella tai pienempiä määriä isommalla katteella, sama liikevoittoon voidaan päästä kummalla tavalla tahansa. Lisäksi pitämällä 40-sarjan alkaen hinnat korkealla saadaan myös vanhat 30-sarjan kortit vielä myytyä, koska niille jää oma ostajakunta, jolla ei ole varaa 40-sarjan kortteihin.Taas on hyvä hetki äänestää lompakollaan. Totuus on kuitenkin luultavasti se, että jokainen kortti menee mitä kerkeävät tuottaa noilla hinnoilla.

- Liittynyt

- 20.03.2018

- Viestejä

- 1 015

Joku jossain muualla sanoi että tää julkaisu ois enemmänkin suunnattu tonne ammattilaispuolelle kuin pelaajille (ja ei, en tarkoita e-sport "ammattilaisia"...)

Mitä ammattijuttuja sitten tuollaisilla hirmuilla tehdään, laskentaa? 3D mallinnusta?

Saa vastata jos yhtään tietoa, opin mielelläni uutta.

Mitä ammattijuttuja sitten tuollaisilla hirmuilla tehdään, laskentaa? 3D mallinnusta?

Saa vastata jos yhtään tietoa, opin mielelläni uutta.

- Liittynyt

- 28.10.2016

- Viestejä

- 459

Eikai näitä pelinäyttiksiä mitenkään pääsääntöisesti kukaan työkäyttöön osta, kun firmoille on Quadrot paremmalla feature setillä tarjolla?

Kyllä ostetaan. Näissä on tehoa Quadroihin nähden aika reilusti enemmän paremmalle hinta-laatusuhteella. Aika harvassa hommassa tarvitaan Quadrojen ominaisuuksia.

Sattu silmään niin laitetaan tännekkin

TLDR:

1. Asuksella patentoitu heatpipe kiinnitys tapa upottamalla. Kuulemma 5 astetta alemmat lämmöt vs tavallinen heatpipe toteutus.

2. Asus toimittaa näyttiksen matkassa tuki bracketin takapäähän. Kerta näytönohjain vääntyy ilman sitä ajan myötä.

3. Asus toimittaa virtalähde adapterin näyttiksien mukana

TLDR:

1. Asuksella patentoitu heatpipe kiinnitys tapa upottamalla. Kuulemma 5 astetta alemmat lämmöt vs tavallinen heatpipe toteutus.

2. Asus toimittaa näyttiksen matkassa tuki bracketin takapäähän. Kerta näytönohjain vääntyy ilman sitä ajan myötä.

3. Asus toimittaa virtalähde adapterin näyttiksien mukana

Kyllä ostetaan. Näissä on tehoa Quadroihin nähden aika reilusti enemmän paremmalle hinta-laatusuhteella. Aika harvassa hommassa tarvitaan Quadrojen ominaisuuksia.

Yleinen jekku 3D-ammattisoftia käyttävillä on että ostetaan yksi Quadro jolla voidaan reprota ongelmat ja näin valittaa tuetulla ajurilla ja kortilla softavalmistajille jos softat kusee, mutta kaikki muut koneet sisältävät GeForceja "unsupported"

Joku jossain muualla sanoi että tää julkaisu ois enemmänkin suunnattu tonne ammattilaispuolelle kuin pelaajille (ja ei, en tarkoita e-sport "ammattilaisia"...)

Mitä ammattijuttuja sitten tuollaisilla hirmuilla tehdään, laskentaa? 3D mallinnusta?

Saa vastata jos yhtään tietoa, opin mielelläni uutta.

AI/Neuroverkkoja, 3D mallinnusta/vfx, VR etc.

Itse vaihdan tod.näk ROG 3080 OC --> 4090 loppuvuodesta jahka nähnyt ettei ole mitään outoja yhteensopivuus/ajuri hässäköitä ohjelmien kanssa.

Eikai näitä pelinäyttiksiä mitenkään pääsääntöisesti kukaan työkäyttöön osta, kun firmoille on Quadrot paremmalla feature setillä tarjolla?

"Työkäytössä" näkemistäni korteista (firmat, freet, yliopistot) 95% korteista olleet "pelikortteja". Ainoa asia missä muistelen että aikoinaan "vaadittiin" quadroja oli jotkin suunnittelu/arkkitehtuuri laskelmat mitkä piti olla ns.täsmällisiä. En muista liittyikö asia jotenkin tuohon double precision laskentaan ja verifiointiin. Ihan ymmärrettävää että jotkin suunnittelut/piirrustukset vaativat tiukkoja toleransseja, en tiedä onko tuossa myös jotain lakipykäliä takana? Viisaammat jatkakoon..

Viimeksi muokattu:

- Liittynyt

- 13.01.2017

- Viestejä

- 2 112

Moni unohtaa sen että kysyntä määrittää hinnan. Toki nyt laitettu extraa lisää, mutta kun 3000-sarjalaiset revittiin käsistä varsinkin kun kysyntä ylitti saatavuuden oli soppa valmis.

Jos näitä ei osteta nykyhinnoilla niin tavaran ei voi jäädä hyllyyn lepäämään jolloin hinnat alkaa laskemaan.

Odotellaan rauhassa ei ne pelit mihinkään katoa.

Jos näitä ei osteta nykyhinnoilla niin tavaran ei voi jäädä hyllyyn lepäämään jolloin hinnat alkaa laskemaan.

Odotellaan rauhassa ei ne pelit mihinkään katoa.

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 265

Jos ihmiset ei ostaisi näitä sika hintaisia näytönohjaimia, niin saataisiin hinnat tippumaan.

Jos ihmiset ei ostais noita isoja kalliita kortteja niin niiden tekeminen loppuisi ja saisi vain sitä halvempaa kaupasta. Ei 4090:en BOM muutu siitä yhtään halvemmaksi osti niitä porukka tai ei. Jäis vain ad102 kokonaan tekemättä ja olis vain joku ad104 kaupassa. Vrt. jos jengi lopettaa ferrarin ostamisen niin ei niitä ferrareita maagisesti tule kauppaan toyotan hinnalla.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 575

Täällä mielenkiintoista tietoa AD102:sta:

AD102 sisältää fyysisesti 18,176 CUDA corea, joista 4090:ssa on käytössä 16384.

Tensor -coreja on 568 (4090: 512) ja RT-coreja 142 (4090: 128).

On siis jätetty kasvunvaraa RTX 4090 Ti:lle

www.techpowerup.com

www.techpowerup.com

AD102 sisältää fyysisesti 18,176 CUDA corea, joista 4090:ssa on käytössä 16384.

Tensor -coreja on 568 (4090: 512) ja RT-coreja 142 (4090: 128).

On siis jätetty kasvunvaraa RTX 4090 Ti:lle

NVIDIA RTX 4090 Doesn't Max-Out AD102, Ample Room Left for Future RTX 4090 Ti

The AD102 silicon on which NVIDIA's new flagship graphics card, the GeForce RTX 4090, is based, is a marvel of semiconductor engineering. Built on the 4 nm EUV (TSMC 4N) silicon fabrication process, the chip has a gargantuan transistor-count of 76.3 billion, a nearly 170% increase over the...

Tarkoitushan on juuri ettei näitä paljoa osteta näin alkuun. Ostajat ohjataan kohti isoa kasaa Ampere-kortteja joista pitäisi päästä eroon muttei kiinnosta dumpata puoli-ilmaiseksi. 3080, 3070 ja 3060 ei tule hetkeen korvautumaan, joskus keväällä vasta koska kysyntää noille ei ole erityisen paljon. Nvidia on varautunut että tilanne kestää kaksi neljännestä eli maalis-huhtikuulle asti. Siksi ne olivat 40-sarjan malliston alla eilisen julkaisun slideissa. Jos 40-sarja ei myy paljoa niin se ei nvidiaa hetkauta, piirejä voi myydä pari vuotta tästä eespäin. Hintaleikkuriin mennään vain jos myös ampere-korttien myynti ei vedä.Moni unohtaa sen että kysyntä määrittää hinnan. Toki nyt laitettu extraa lisää, mutta kun 3000-sarjalaiset revittiin käsistä varsinkin kun kysyntä ylitti saatavuuden oli soppa valmis.

Jos näitä ei osteta nykyhinnoilla niin tavaran ei voi jäädä hyllyyn lepäämään jolloin hinnat alkaa laskemaan.

Odotellaan rauhassa ei ne pelit mihinkään katoa.

BOM ei muuttuisi halvemmaksi, mutta nVidian profit margin tippuisi jonkin verran ja liikevaihto nousisi. Tekemättä se ei jäisi - 4090 ei käytä edes täyttä 102-piiriä, mutta sellainen menee ammattimallistoon.Ei 4090:en BOM muutu siitä yhtään halvemmaksi osti niitä porukka tai ei. Jäis vain ad102 kokonaan tekemättä ja olis vain joku ad104 kaupassa.

- Liittynyt

- 21.02.2017

- Viestejä

- 5 394

Artikkelissa taitaa olla virhe. 144 SM yksikköä on täydessä AD102 -sirussa (18432 CUDA ydintä, 576 Tensor ydintä).AD102 sisältää fyysisesti 18,176 CUDA corea, joista 4090:ssa on käytössä 16384.

Tensor -coreja on 568 (4090: 512) ja RT-coreja 142 (4090: 128).

On siis jätetty kasvunvaraa RTX 4090 Ti:lle

TPU:n sekaannus johtuu varmaankin siitä että RTX 6000:ssa on hitusen leikattu AD102, eli 142 SM yksikköä ja ovat speksit napanneet suoraan siitä.

Huomasin kyllä eilisestä tilaisuudesta olevani potentiaalista kohderyhmää, kun demottiin eniten mahtavaa FPS-lisäystä CP2077:ssa ja MS FlightSimissä. Molemmat pelejä joita pelailen melkeinpä päivittäin (jos nyt MSFS edes on peli perinteisessä mielessä). Tulevan talven sähkökustannukset yms. pitää kyllä huolen siitä että "vanha" 3080 10Gb peruskortti saa koneessani kelvata vielä vaikka kuinka kauan, koska ei ole varaa uuteen (myös vaikka ne veisikin vähemmän virtaa). 3080 on enemmän kun tarpeeksi riittävä 1440p:llä, ja varsinkaan MSFS ei välttämättä edes tarvi 9000 fps:ää kun lentelee reittiä 10 kilsan korkeudessa (laskeutuminen EGLL:ään ukkosmyrskyssä on sitten asia hieman erikseen).

Pitäkööt tunkkinsa (jos en nyt lotossa voita) .

.

Pitäkööt tunkkinsa (jos en nyt lotossa voita)

- Liittynyt

- 13.12.2016

- Viestejä

- 4 881

Joko täällä oli mainittu että eikös siinä keynotessa näytetty että ilman DLSS Cyberpunkissa 4090:lla tulee ~22fps RT päällä?

Eli aika kaukana ollaan vieläkin siitä että RT olisi riittävän nopeaa...

Ei ollu perus CP2077 RT moodi käytössä vaan joku överi RT OverDrive moodi. Paha toki sanoa, miten raskas tuo olisi esim. 3090:lla. Psycho RT asetuksilla 3440*1440 resolla ilman DLSS:ää toi oma 3090 pyörittää CP:tä muistaakseni jollain 30-40 FPS tasolla. Tuohon kun löyö 4k reson, niin ollaan jo helposti siellä 20 - 30 tasolla. Sitten jos mietiään, että lisätään vielä säteiden määrää/bounceja (RT overdrive), niin aletaan olla varmaan jossain 10 FPS tienoilla.

Joko täällä oli mainittu että eikös siinä keynotessa näytetty että ilman DLSS Cyberpunkissa 4090:lla tulee ~22fps RT päällä?

Eli aika kaukana ollaan vieläkin siitä että RT olisi riittävän nopeaa...

Se oli jollain tulevalla supermegaraskaalla RT moodilla, ei nykyisillä settareilla.

DXR Feature Testistä voi arpoa miten raskaaksi RT kuorman saa tarvittaessa, ei ole vaaraa ettäkö rauta jäisi käyttämättä, devaajat voivat lisätä hommia kyllä.

- Liittynyt

- 13.02.2021

- Viestejä

- 604

Tuossahan on klassinen hinnoittelu-kikka kyseessä, jota esim. starbucks käyttää kahvikokojen kanssa. Laitetaan 1 kallis jättikahvi, 1 vähän halvempi keskikokoinen, ja vähän halvempi selvästi pienin, jolloin suurin osa ihmisistä ostaa keskikokoisen. Nyt se pienin eli 4070* tulee olemaan niin paljon hitaampi mutta vain vähän halvempi kuin 4080, että moni valitsee tietenkin 4080. Paitsi että kahvivertaus ontuu tässä kohtaa, koska 4090 tulee olemaan reilusti 4080 tehokkaampi, eli moni päivittää 4090 asti, kun se ei ole enää paljoa kalliimpi. Bisnes-mielessä nerokasta Nvidia, pakko myöntää.

*4070 tarkoitan tästä eteenpäin 4080 12gb -versiota. Kieltäydyn käyttämästä tuosta 4080 12gb -nimitystä siihen asti kunnes 4070 launchaa. Ihan oikeasti Nvidia...

Ujosti haaveilin päivittäväni 4080, mutta ei perkule noissa hinnoissa ole enää mitään järkeä. 3070ti päivittämisestä tuli jo morkkis. Nyt on pakko skipata Nvidian porfolio. Lisää FPS kyllä 4k kaipaisi. Enter AMD. Oon jo luovuttanut kaiken munuaisista korviin, joten aika rajua perf / dollaria saa AMD tarjota, jotta päivitän.

Olipa erinomaisesti kiteytetty. Kyllä tässä yritetään kusta silmään nimenomaan hi-endiä periaatteesta vaativia pc-fanaatikkoja. Jatkuvasti luodaan uusia nopeampia piirejä ja nostetaan mallinumeroa entisen hi-endin yläpuolelle ja nyt yritetään saada x080-miehet ajattelemaan, että koska se 4080 onkin noin kallis, että 4090 on 'vain' muutaman satasen sitä kalliimpi niin ostanpa 4090:n. Pahoin pelkään, että moni pelimies tulee myös näin tekemään, että hyllystä lähtee 4080:n sijaan 4090, ja Nahkatakkimies hieroo käsiään. 4070 (Ti):n uudelleenbrändääminen alemman tason 4080:ksi oli kyllä mauton temppu.

Nvidia on kyllä ovela psykologisessa markkinoinnissaan. Varmasti se huhujen levittely yli 2000 USD:n lippulaivasta oli omiaan lisäämään käsien taputuksia, kun hinta olikin "vain" 1600 USD, kuten Greg Salazar totesi eilisellä videollaan.

Teknisestihän tuote vaikuttaa pätevältä. Melkein valitettavaa, että se olisi kaikkea mitä oma harrastukseni vaatii. Mutta hinta pistää kyllä miettimään ja empimään, että mikä on tämän harrastuksen suunta ja että onko tässä kaikessa kohta enää mitään järkeä?..

Ei tää nyt oikein hyvältä näytä kuluttajan kannalta. Hinnoittelu on sitä luokkaa, että AMD:lla on kerrankin oikeasti hyvä sauma iskeä ja yrittää ottaa reilumpi siivu markkinoista.

NVIDIA saattaa tässä ampua itseänsä jalkaan pitkässä juoksussa, kun kehittäjillä on aika vähän syitä ottaa uusia ominaisuuksia käyttöön, jos käyttäjillä ei ole niitä tukevaa rautaa.

NVIDIA saattaa tässä ampua itseänsä jalkaan pitkässä juoksussa, kun kehittäjillä on aika vähän syitä ottaa uusia ominaisuuksia käyttöön, jos käyttäjillä ei ole niitä tukevaa rautaa.

- Liittynyt

- 13.12.2016

- Viestejä

- 3 117

Ei tää nyt oikein hyvältä näytä kuluttajan kannalta. Hinnoittelu on sitä luokkaa, että AMD:lla on kerrankin oikeasti hyvä sauma iskeä ja yrittää ottaa reilumpi siivu markkinoista.

NVIDIA saattaa tässä ampua itseänsä jalkaan pitkässä juoksussa, kun kehittäjillä on aika vähän syitä ottaa uusia ominaisuuksia käyttöön, jos käyttäjillä ei ole niitä tukevaa rautaa.

Hinnoittelussa ei mitään järkeä, mutta tukea varmasti peleihin tulee. Ainakin niin kauan, kuin nvidialla on rahahanat auki tuen muodossa.

NVIDIA Vice President of Applied Deep Learning Research Bryan Catanzaro:

Eli tuosta voisi päätellä DLSS3 lisäävän viivettä. Vaikka FPS olisi korkea, niin tämä ei välttämättä välity pelikokemukseen. Tätä voi auttaa ottamalla käyttöön Nvidia Reflexin, jota myös vanhemmat kortit tukee. Onkohan tämä teknologia vähän kuin joku huiputus, millä saadaan fps testi näyttämään korkealta

NVIDIA Reflex removes significant latency from the game rendering pipeline by removing the render queue and more tightly synchronizing the CPU and GPU. The combination of NVIDIA Reflex and DLSS3 provides much faster FPS at about the same system latency.

Eli tuosta voisi päätellä DLSS3 lisäävän viivettä. Vaikka FPS olisi korkea, niin tämä ei välttämättä välity pelikokemukseen. Tätä voi auttaa ottamalla käyttöön Nvidia Reflexin, jota myös vanhemmat kortit tukee. Onkohan tämä teknologia vähän kuin joku huiputus, millä saadaan fps testi näyttämään korkealta

- Liittynyt

- 21.02.2017

- Viestejä

- 5 394

Kyllä mä mieluummin kattelen esim. 80fps kuvaa kuin 50fps kuva olkoonkin että input lag on identtinen. Mutta ei tosiaan jossain kilpailullisissa fps peleissä tms tuosta oikein iloa ole. Flight simulator hyvä esimerkki pelistä jossa toi on varmaan ihan kiva, kun ei input lagilla niin väliä. Olettaen toki ettei kuvanlaatu ole ihan skeidaa.Eli tuosta voisi päätellä DLSS3 lisäävän viivettä. Vaikka FPS olisi korkea, niin tämä ei välttämättä välity pelikokemukseen. Tätä voi auttaa ottamalla käyttöön Nvidia Reflexin, jota myös vanhemmat kortit tukee. Onkohan tämä teknologia vähän kuin joku huiputus, millä saadaan fps testi näyttämään korkealta

- Liittynyt

- 16.03.2017

- Viestejä

- 1 476

Eiköhän kohta tule G-SYNC 2 piirit, joissa tekoäly korjaa viivettäkin.NVIDIA Vice President of Applied Deep Learning Research Bryan Catanzaro:

Eli tuosta voisi päätellä DLSS3 lisäävän viivettä. Vaikka FPS olisi korkea, niin tämä ei välttämättä välity pelikokemukseen. Tätä voi auttaa ottamalla käyttöön Nvidia Reflexin, jota myös vanhemmat kortit tukee. Onkohan tämä teknologia vähän kuin joku huiputus, millä saadaan fps testi näyttämään korkealta

PÌÎUW®[ªøËrhl¾ÇÌ°1¿¼

MurottajaSince2004

- Liittynyt

- 19.10.2016

- Viestejä

- 5 707

Siinä olen nVidian lähestymistavasta samaa mieltä että tuo ainainen brute-forceaminen alkaa olemaan umpikujassa. Varsinkin kun siirrytään pikkuhiljaa path-tracingiin jossa yksi valonsäde voi periaatteessa pomppia äärettömästi skenessä. Tulevaisuus on entistä älykkäämmissä algoritmeissa jotka esim ennustaa yhdestä valon pompusta sen mitä valo tekisi miljoonalla pompulla. Onko se sitten AI vai miksi sitä haluaa sanoa joka sen yhden pompun jälkeen tietää että valo jakaantuu XYZ-käyrällä skeneen näin ja ohittaa neljä triljoonaa laskutoimitusta sillä päätelmällä.

- Liittynyt

- 17.10.2016

- Viestejä

- 5 724

Ei tää nyt oikein hyvältä näytä kuluttajan kannalta. Hinnoittelu on sitä luokkaa, että AMD:lla on kerrankin oikeasti hyvä sauma iskeä ja yrittää ottaa reilumpi siivu markkinoista.

NVIDIA saattaa tässä ampua itseänsä jalkaan pitkässä juoksussa, kun kehittäjillä on aika vähän syitä ottaa uusia ominaisuuksia käyttöön, jos käyttäjillä ei ole niitä tukevaa rautaa.

Eiköhän siellä ole tiedossa, että AMD:llä ei ole mitään lyödä nokittamaan 4090:aa. Epäilisin ettei välttämättä edes 4080 16 mallia. Ehkä sitten kilpailevat hinnalla ja wateilla tuosta alespäin. Hintatietoinen hipsteripelaaja toki ostaa ennemmin €/W teholta paremman kortin vaikka se häviäisi tehoissa ja sen merkitys sähkölaskussa koko 2v omistusajalta on luokkaa 50€.

Sellasta se on kun ei ole kilpailua niin voidaan pyytää mitä tykkää. Bisnestä nää firmat tekee eikä hyväntekeväisyyttä. 3080 @ 750€ on nvidialta hyvin ikävä floppi julkaisu bisneksen kannalta kun luulivat, että AMD:llä olisi ollut vastaavaa tarjota. Tällä kertaa on varmaankin viisastuttu ja kalastettu tiedot paremmin ettei tartte liian halpoja kortteja pistää myyntiin.

Nyt niillä on koko hinta haitarille korttia. Ikävä vaan, että se halvinkin pökäle 3050 maksaa jo 300€, mutta koska kilpailijankin vastaavat RX6500 ja 6600 osuu väliin 250-350€ niin miksi myydä halvemmalla?

RTX 4090 - GeForce RTX pelaamiseen - Jimms.fi

Jimms.fi on asiantunteva tietotekniikan, komponenttien ja viihde-elektroniikan verkkokauppa. Tilauksiin aina saatavilla ilmainen toimitusvaihtoehto!

Lieköhä täällä vielä oli mutta placeholdereita alettu jo laittelemaan... Mielenkiinnolla lopullisia hintoja odotellen.

- Liittynyt

- 08.08.2019

- Viestejä

- 2 460

Ja ne jotka näitä uusia näytönohjaimia tarvitsee niin kaks vaihtoehtoa.... Maksa ittes kipeäks julkasussa tai odota että hinnat järkevöityy.

Ne jotka tarvii varmasti ostaakin, moni heti launchista, RTX 4090 työkäyttöön, 4k-gamer entusiasteille jne, mutta kenelle noita RTX 4080 saadaan kaupaksi joskus 4 kuukauden kuluttua? RTX 3080 edelleen varastoissa (halvimmat amazon.com 700$ = varmaan ihan hyvää price/perf noihin uusiin verrattuna), ebay tulvii ethereum-muutoksen jälkeen käytettyjä kortteja, eli markkina on edelleen pullollaan kortteja, eikä uudet pysty tuomaan kovin hääviä price/perffiä tilalle. RTX 4090 paras näistä, ja varmaan myy pitkään, 4080 hintoja joudutaan leikata nopeasti veikkaan mä, varsinkin jos AMD lähtee hintasotaan.

Eiköhän siellä ole tiedossa, että AMD:llä ei ole mitään lyödä nokittamaan 4090:aa. Epäilisin ettei välttämättä edes 4080 16 mallia.

4090 ei välttämättä AMD lyö, mutta kyllä nyt 4080. Ei kai se vaadi AMD:lta mitään poppaskonsteja, kun ei 4080 ota hirveää hyppäystä vrt. RTX 3090ti, ~20-30% Valhalla ja The Division Nvidian slaideissa, ja nuokin voi olla hieman cherry-pickattu. En ole RDNA-arkkitehtuurin asiantuntija, mutta 50% perf/watt -parannus last.geniin kuulostaa siltä että 4080 lyödään kevyesti, ja jollain laboratorio-kellotaajuuksilla voidaan hipoa jopa 4090.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 278

DLSS3 games

...

- A Plague Tale: Requiem

- Warhammer 40,000: Darktide

Listoja on aina kiva tehdä. Taitaa olla edelleen pelejä jotka ei ole saanu DLSS tukea joihin se silloin DLSS:n alkutaipaleella luvattiin.

Ja kun tää nyt on taas tätä että ei toimi vanhemmalla raudalla, niin mielenkiinto pelin kehittäjillä tulee olemaan varmaan hiukan laimeaa tuon tuen lisäämiseksi koska laitekanta on suppeaa. Toki nvidian rahoittamana se lisätään ja siinä tapauksessa jos sen lisäämien DLSS2 rinnalle ei ole kovin työlästä.

Kyllä nvidia näillä DLSS sötöksillään aiheuttaa pelitaloille paljon päänvaivaa, varsinkin kun on 2 avointa tekniikkaa kilpailemassa. Olisikin kaikille paljon helpompaa jos nvidia antaisi tässä maailmanvalloitus teemassaan periksi ja mentäisiin avoimeen stantardiin jolloin olisi yksi kökkäre jota kaikki tukisi.

Hauska miten täysin samasta speksista ja esityksestä voi vetää niin monenlaista erilaista johtopäätöstä. Digital foundryn kommentteja alla. Tsekkasin huumorilla niin hardware unboxed:lla ei ole mitään 4090 matskua vielä tuubissa. pcworld, io-tech jne. kuitenkin kerkesivät jotain tekemään. Ehkä se amd bias siellä näkyy HUB:in päässä. Ei HUB ole jaksanut twiittiäkään nvidiasta laittaa. Oletin löytäväni naljailua dlss3:sta, mutta ehkä rytisee myöhemmin kunhan amd kerkeää päivitellä hub:lle talking pointit.

Itte en kyllä ole mieltänyt HUB mitenkään puolueelliseksi. Sen sijaan DF:n jutut on aika arveluttavia. Vaikuttaa että siellä pojat istuu papa J:n polvella varsin tukevasti kun jälleen kerran on uudet lelut pojilla paljon ennen muita.

Tuo on kyllä todella kaukana totuudesta... Mistä ihmeestä päättelit että HUB on jollain tavalla AMD bias? Yleensä jokaisessa vertailussa suosittelevat Nvidian korttia vaikka se on huomattavasti kalliimpi kuin AMD vastaava...

No helpostihan sitä biasta alkaa näkemään kun omaa rakkaudenkohdetta ei ylistetä joka käänteessä.

4090 ei välttämättä AMD lyö, mutta kyllä nyt 4080. Ei kai se vaadi AMD:lta mitään poppaskonsteja, kun ei 4080 ota hirveää hyppäystä vrt. RTX 3090ti, ~20-30% Valhalla ja The Division Nvidian slaideissa, ja nuokin voi olla hieman cherry-pickattu. En ole RDNA-arkkitehtuurin asiantuntija, mutta 50% perf/watt -parannus last.geniin kuulostaa siltä että 4080 lyödään kevyesti, ja jollain laboratorio-kellotaajuuksilla voidaan hipoa jopa 4090.

Aika vähän RDNA3 tihkunut vielä. Mutta jos toi lähes 4GHz kello vuoto pitää paikkaansa niin jos mietitään että RDNA2 kulki lähelle 3GHz, sanotaan nyt vaikka 2,7GHz ja RDNA3 menisi 3,7GHz niin tuosta tulee jo 37 pinnaa parannusta ja siihen sitten päällä shader lisät niin kyllä voisi olettaa että jerkkua on tulossa ja paljon.

Viimeksi muokattu:

Kaksi vuotta kulunut korttien julkistuksesta ja vieläkin kuvitellaan, ettei AMD:llä ole/ollut vastinetta 3000-sarjalleEiköhän siellä ole tiedossa, että AMD:llä ei ole mitään lyödä nokittamaan 4090:aa. Epäilisin ettei välttämättä edes 4080 16 mallia. Ehkä sitten kilpailevat hinnalla ja wateilla tuosta alespäin. Hintatietoinen hipsteripelaaja toki ostaa ennemmin €/W teholta paremman kortin vaikka se häviäisi tehoissa ja sen merkitys sähkölaskussa koko 2v omistusajalta on luokkaa 50€.

Sellasta se on kun ei ole kilpailua niin voidaan pyytää mitä tykkää. Bisnestä nää firmat tekee eikä hyväntekeväisyyttä. 3080 @ 750€ on nvidialta hyvin ikävä floppi julkaisu bisneksen kannalta kun luulivat, että AMD:llä olisi ollut vastaavaa tarjota. Tällä kertaa on varmaankin viisastuttu ja kalastettu tiedot paremmin ettei tartte liian halpoja kortteja pistää myyntiin.

Nyt niillä on koko hinta haitarille korttia. Ikävä vaan, että se halvinkin pökäle 3050 maksaa jo 300€, mutta koska kilpailijankin vastaavat RX6500 ja 6600 osuu väliin 250-350€ niin miksi myydä halvemmalla?

Ei ole mitään syytä epäillä etteikö RDNA3 tarjoaisi yhtä hyvää, ellei jopa parempaa kilpailua. Vai oliko nuo jotain omia mutuiluja, jotka perustuvat aikaan ennen RDNA2-kortteja?

Ei ole mitään syytä epäillä etteikö RDNA3 tarjoaisi yhtä hyvää, ellei jopa parempaa kilpailua. Vai oliko nuo jotain omia mutuiluja, jotka perustuvat aikaan ennen RDNA2-kortteja?Toisaalta parhainta haluaville voi tuo muutama FPS olla sen verran merkityksellisiä, ettei ego anna myöten ostaa niin heikkoa korttia kuin AMD näissä vertailuissa tarjoaa.

www.techpowerup.com

www.techpowerup.com

www.techpowerup.com

www.techpowerup.com

AMD Radeon RX 6950 XT Reference Design Review

The AMD Radeon RX 6950 XT Reference Design card not only looks great, but also achieves excellent performance, matching the GeForce RTX 3090, but at much better pricing. Because of good optimization and surprisingly good energy efficiency, AMD's thermal solution works very well, too.

AMD Radeon RX 6800 XT Review - NVIDIA is in Trouble

The Radeon RX 6800 XT is a worthy opponent to the NVIDIA GeForce RTX 3080. It offers similar performance at better power efficiency and lower noise levels. In our Radeon RX 6800 XT review, we also take a closer look at raytracing and "Rage Mode", a new 1-click method for overclocking.

Uutiset

-

Rentouttavaa ja tunnelmallista joulua 2024!

24.12.2024 09:59

-

Lenovon erikoiset CES-uutuuskannettavat vuotivat julki ennakkoon

20.12.2024 15:23

-

Joulun 2024 piparkakkutalokilpailu on käynnistynyt TechBBS-foorumilla!

20.12.2024 14:42

-

Lenovo valmistelee SteamOS:llä varustettuja käsikonsoliluokan Legion Go -tietokoneita

20.12.2024 14:05

-

Live: io-techin Tekniikkapodcast (51/2024)

20.12.2024 13:50

Uutisia lyhyesti

-

Taittuvanäyttöinen OnePlus Open 2 saatetaan nähdä vasta odotettua myöhemmin

- Juha Kokkonen

- Vastauksia: 0

-

Sony on saavuttanut 20 miljardin toimitetun kamerasensorin rajapyykin

- Kaotik

- Vastauksia: 5

-

-

-