- Liittynyt

- 12.09.2020

- Viestejä

- 2 229

Tässä ehtii vielä tapahtumaan paljon ennen 2027 alkua, toki voidaan tehdä kolmas 4nm refreshi. Sitten voidaan tuoda 10x frame generation ja kattoo miten kauppa käy.Kun katso mitä realistisia vaihtoehtoja on niin 3nm monoliitti ei toimine kun sram ja io ei skaalaa. 2026 2nm liian kallis. Jäljelle ei oikein jää kuin chiplet tai odotella vuosi/kaksi lisää että 2nm on järkevän hintainen

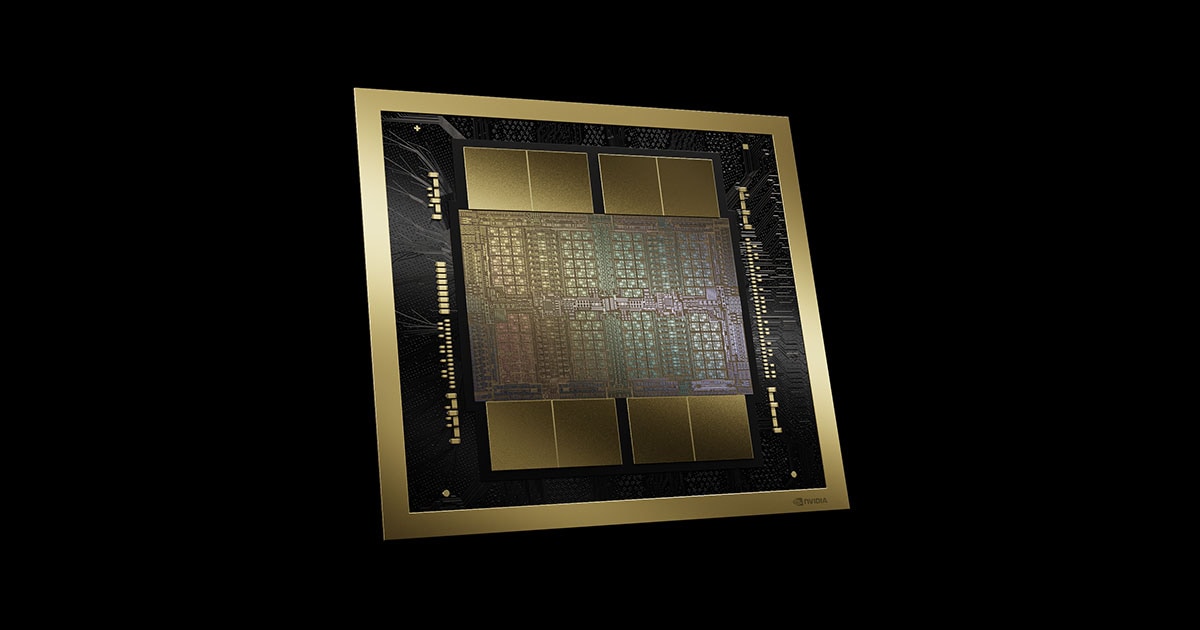

Rubin kertoo paljon miten nvidia ratkaisee sram skaalaamisongelman. Ehkä maaliskuussa gtc messuilla tietoa 3nm rubinista. Toinen vaihtoehto tehdä 2xtsmc 4np sirut ja niitata ne yhteen kuten blackwell konesalipiirissä on tehty. Konesalipiirissä 10TB/s väylä piirien välissä. Riittänee siihen että chiplet toimii kuten monoliitti.

Kuvan konesalipiiri 2 erillistä piiriä ja välissä 10TB/s väylä.

4090 ois paras ostos ikinä kun sillä pärjäis hyvin 6 vuotta melkein