- Liittynyt

- 13.09.2018

- Viestejä

- 808

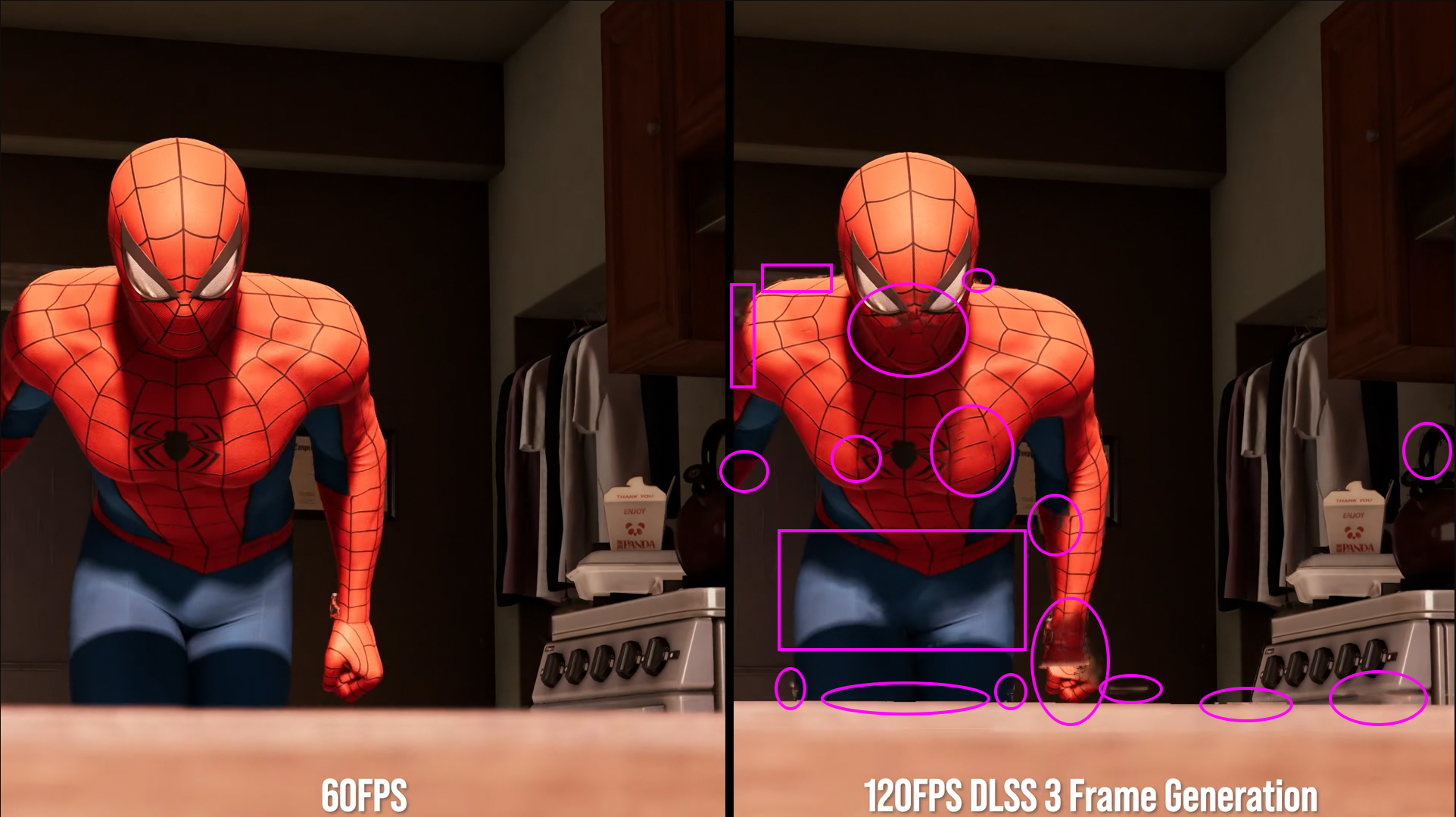

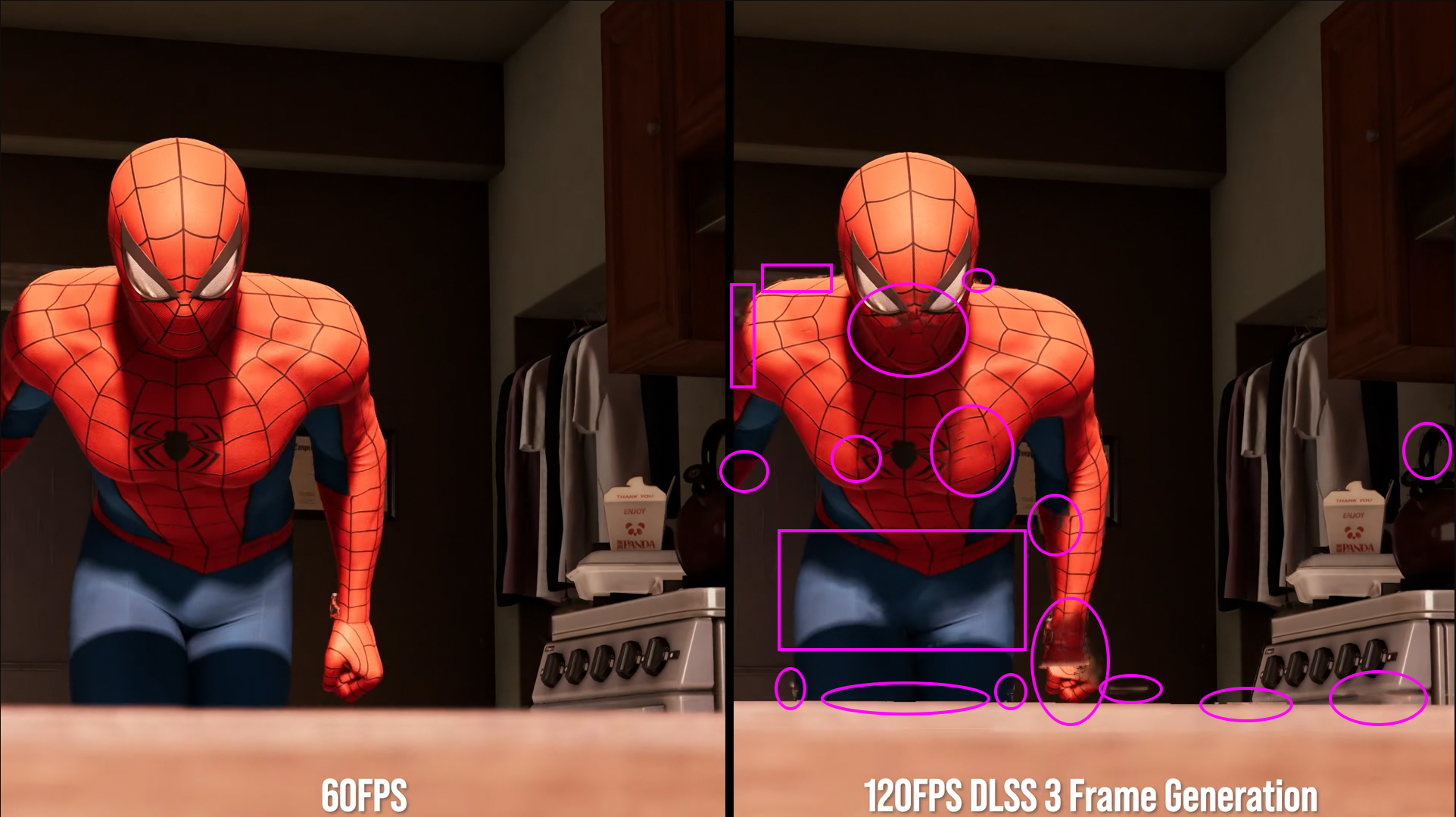

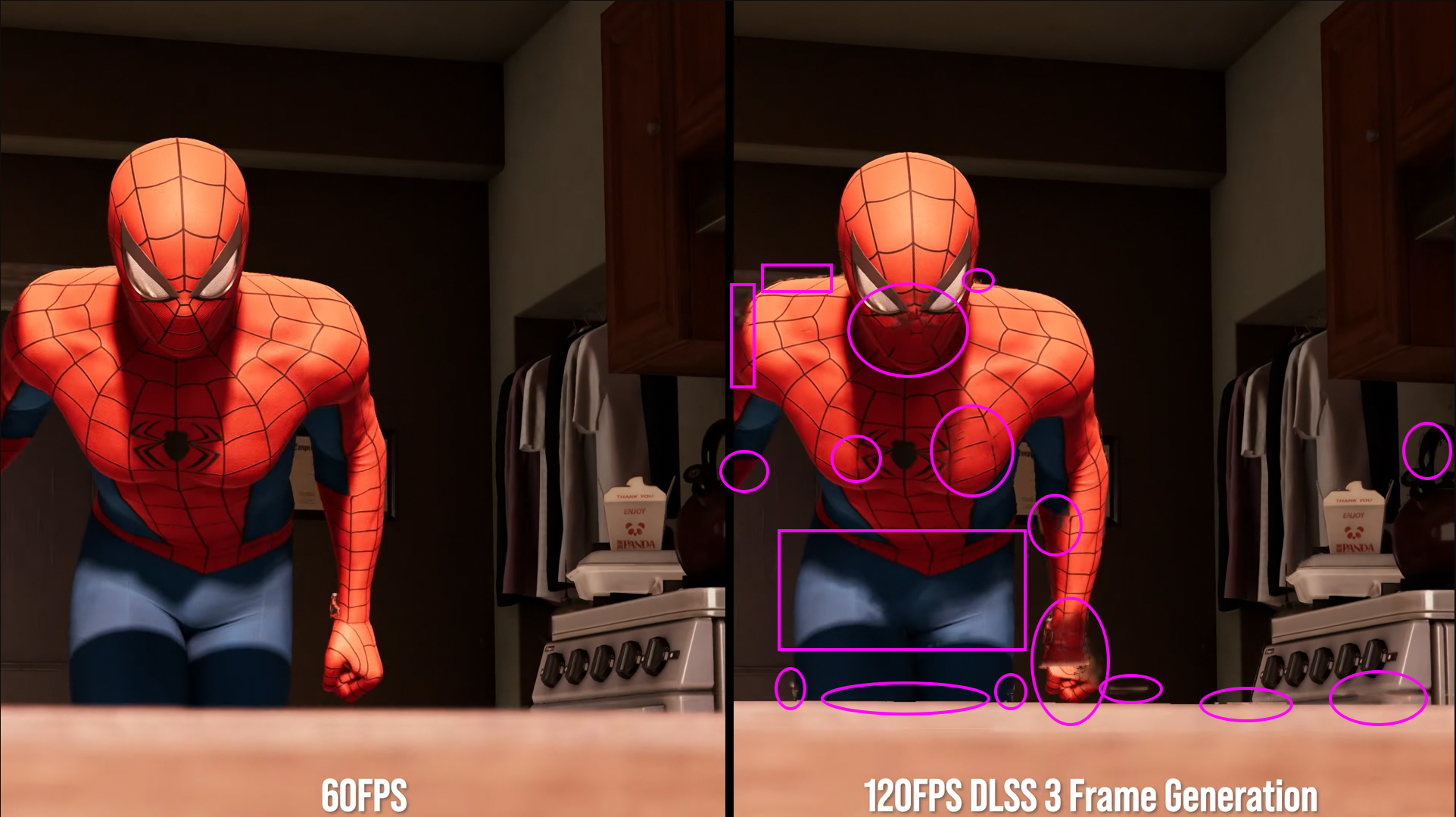

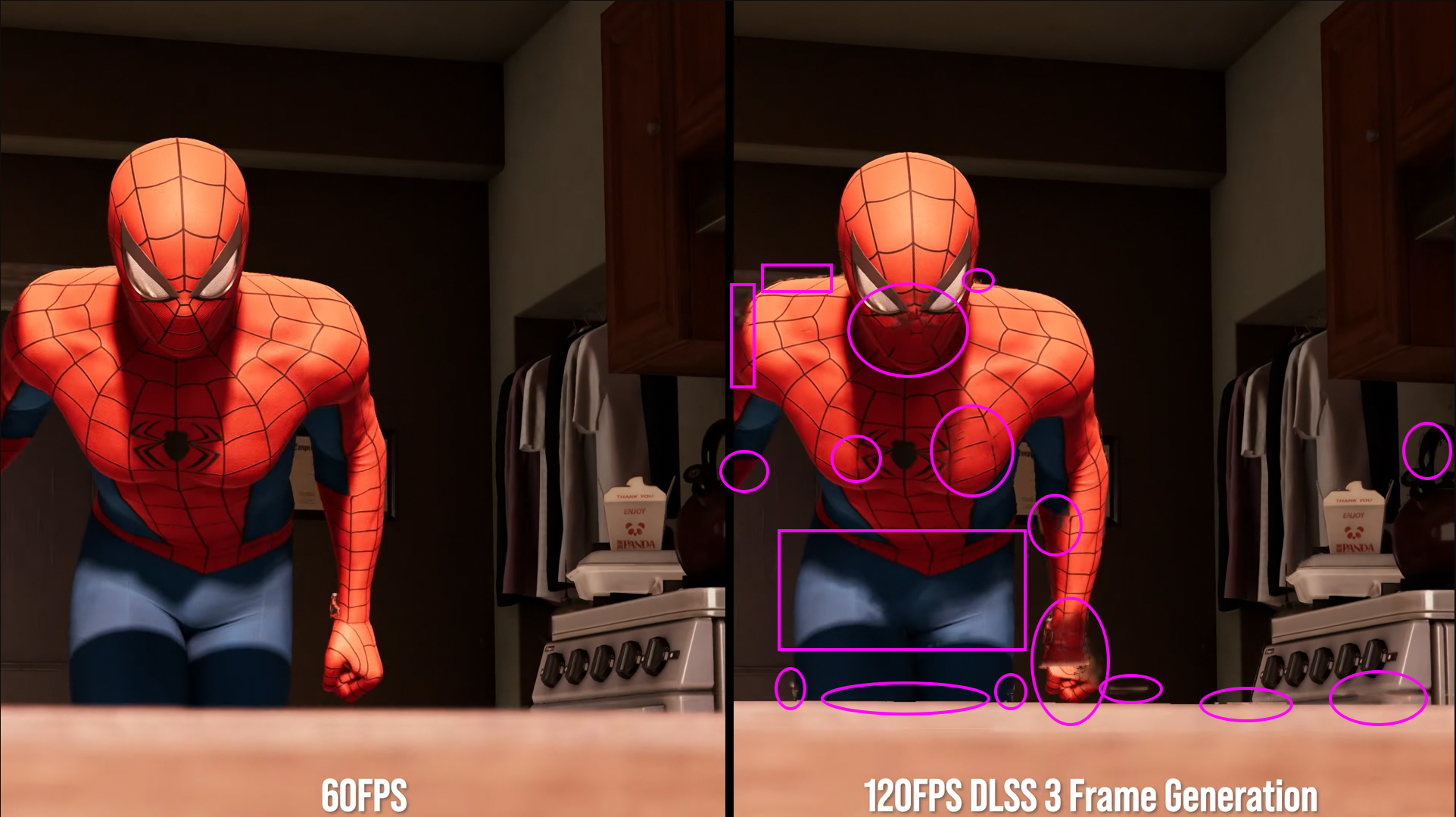

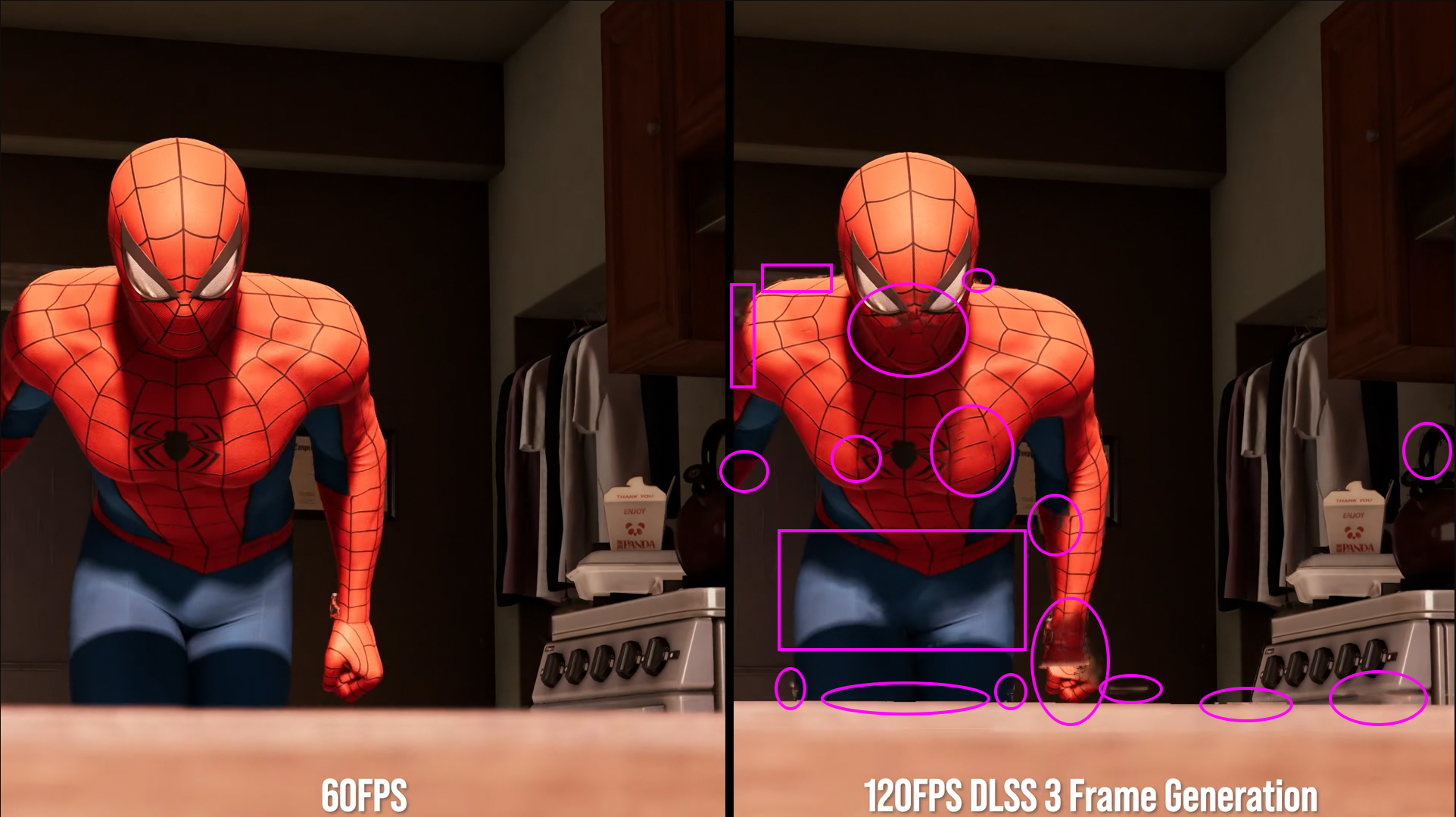

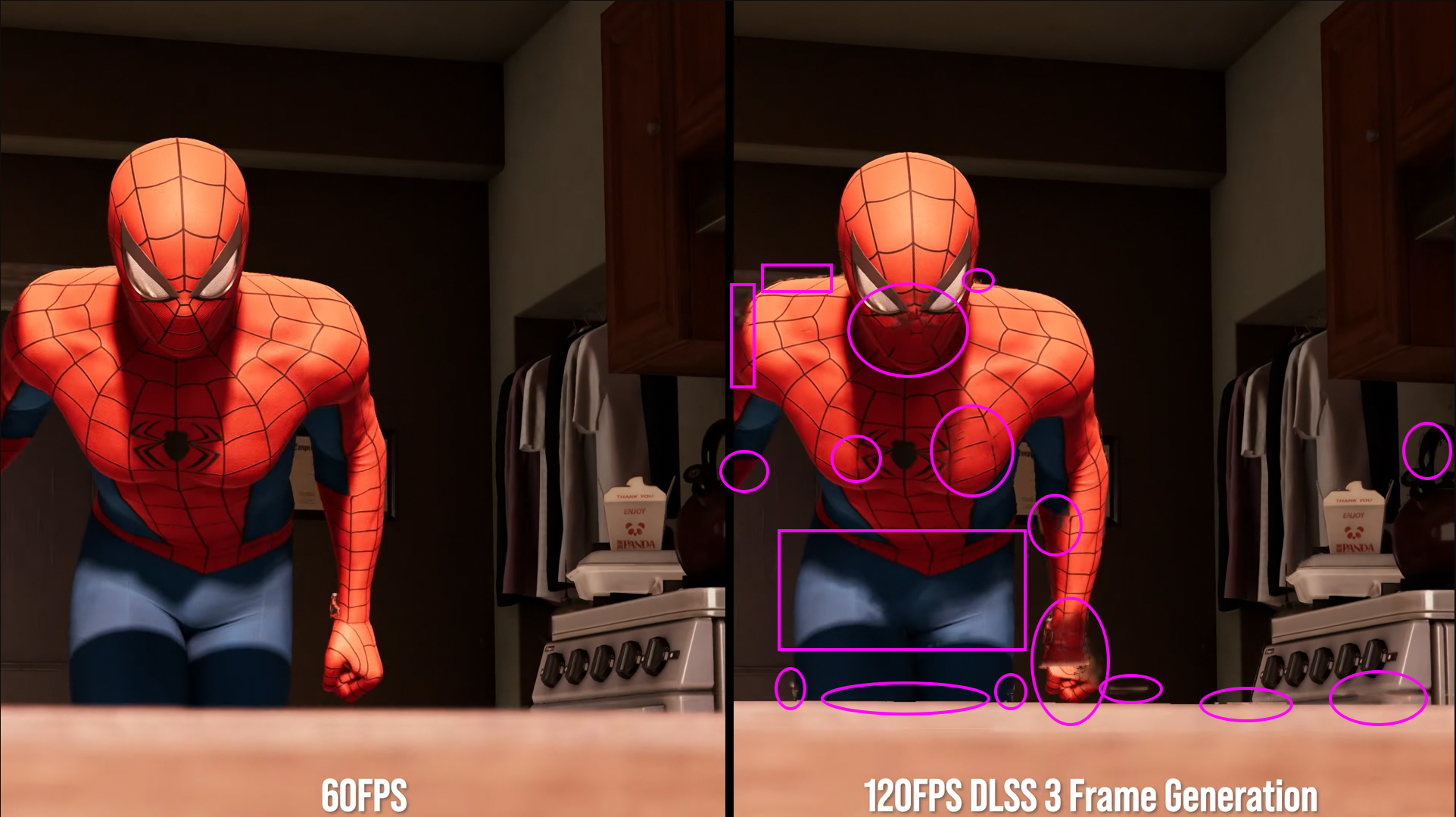

Mutta kuinka paljon huomaat ongelmat liikkeessä? Eli oikeasti pelatessa eikä yksittäisiä kuvia katsoessa.Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Mutta kuinka paljon huomaat ongelmat liikkeessä? Eli oikeasti pelatessa eikä yksittäisiä kuvia katsoessa.Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

Ei mistään huomaa, ei missään pelissä ole tavoitteena pysäyttää peliä ja zoomailla.Mutta kuinka paljon huomaat ongelmat liikkeessä? Eli oikeasti pelatessa eikä yksittäisiä kuvia katsoessa.

Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

EKWB:lla jo preorder auki. Tietenkään toimituspäivämäärä ei ole tiedossa. Search results for: 'EK-Quantum Vector² FE RTX 4090 D-RG' – EK Webshopkoskahan vesiversiot julkistetaan noista korteista? tuollainen tiiliskiven paksuinen näyttis on ehkä vähän liikaa ilmajäähdytteisenä hiljaisuutta hakevalle

Kyllähän noi aika pahalle näyttää, eihän siitä mihinkään pääse. Se täytyy kyllä sanoa, että Spidermanissä DLSS2 on myös aika huonosti toteutettu ja itse olen myös sen kanssa havainnut aika paljon grafiikkavirheitä, minkä vuoksi en sitä tuossa pelissä käytä. Se varmasti vaikuttaa myös tuohon DLSS3:n laatuun, koska se rakentuu aika pitkälti samojen peruspalikoiden päälle.

Katselin previewistä tuota hidastettuna, siinä näkee selvästi, milloin on generoitu ruutu, kun noita artefakteja pölähtää liikkeiden rajapintoihin ja seuraavasta framesta ne taas puuttuu. Eli olisi sen perusteella DLSS3.0 ongelma, eikä pelin yleinen DLSS ongelma.

Kyllä siinä oltaisiin enemmän kuin 1/2 framea myöhässä koska ollaan odotettu lähtökohtaisestikkin ne kaksi framea joiden väliin sitä kuvaa pitää alkaa laskemaan. Interpolaatiossa koko ketjua pitää viivästyttää vähintään sen yhden framen verran eli ollaan puolitoista framea myöhässä minimissään kun interpoloidaan kahden jo lasketun framen välille dataa. Tästä syystä televisioiden interpolaatio luo niin hirveän latenssin. Sama paradigma.jossa ennustamisen sijasta yritettäisiinkin kahden tunnetun framen väliin laskea interpoloitu frame. Tämä lisää latenssia, kun rendattua framea ei näytetä heti, vaan ensin interpoloitu eli ollaan 1/2 framea myöhässä.

Nähtäväksi jää mutta jos pullonkaula on CPU:n ja muistin välissä niin sitten varmasti hyötyä on nopeammasta muistista, mutta se että tuo näkyisi merkittävästi näyttiksen sisäisessä toiminnassa (fps/resoluutio) on kyseenalaista.Kiinnostaisi tietää miten tässä sarjalaisessa näkyy ddr4 ja ddr5 ero, luulisin että hyödyt uudemmista kammoista suurenee.Kait sekin tullaan näkemään kunhan saavat luvan julkaista testejä.

Olisi kiva nähdä 3090Ti 1% lows ja minimit niin saisi paremmin vertailtua. Sinällään ihan OK boosti jos 4090 absoluuttinen minimi fps on isompi mitä 3090Ti average fps.

Techpowerupin uutiskommenteista. Tämä oli kyllä aika karu pika-analyysi:

"If you compare the non-DLSS results between the 3090TI and 4090, its only a 62% increase in FPS, this is with the 4090 having 55% more CUDA cores, 40%~ more clock speed, and 90MB more L2 cache (96MB vs 6MB on the 3090TI). This does no bode well for the 4080 16GB results in comparison to the 3090TI in non DLSS or heavy RT performance."

Outo julkaisu kaikenkaikkiaan. Paukut on DLSS3.0 korissa ja AD102 piiri vaikuttaa omaavan parhaan perf/€ suhteen, joka on ennenkuulumatonta lippulaivamallille.

Olisi kiva nähdä 3090Ti 1% lows ja minimit niin saisi paremmin vertailtua. Sinällään ihan OK boosti jos 4090 absoluuttinen minimi fps on isompi mitä 3090Ti average fps.

Tuosta edellisestä kuvasta paistoi silmään kun molempia kortteja ajettu natiivina niin kulutus aika lailla samat, 461W ja 454W.

Epäilyttää nyt joku kohta, koska samalla kulutuksella silti 4090 käynyt 20C viileämpänä kuin 3090Ti, +50C vs +70C.

Lisäksi uusin uutinen maailmalta kertoo että Nahkatakki eli nVidia valehdellut KAIKILLE että 4000 sarjan kortit olisi valmistettu uusimmalla TSMC 4nm prosessilla.

Näin ei näköjään ole vaan GPU:t valmistettu itseasiassa TSMC 5nm prosessilla.

NVIDIA also clarified what TSMC 4N really means, which is not to be confused with N4. This process is a die shrink of TSMC 5N process, but it is still a 5nm architecture. The only problem with this ‘clarification’ is that NVIDIA themselves provide wrong information on 4nm process, as shown below (slide from this week’s Editors Day).

Ei paljon enää puutu mitoista että on samoja lukemia mitä synnytysosastolta lähtiessä kirjataan...No jimmsiltä speksit ois

Mitat: 357,6 x 149,3x 70,1mm / 3.5 slot

Paino: 2,503kg

2.5kg on kyllä sellainen massa

Kyllä ne on oikeita viivanleveyksiä (nm) joista puhutaan, tai joista pitäisi pelkästään puhua.

Toki joidenkin valmistajien tai asiakkaiden markkinointi puheista saa väärän käsityksen, mutta tarkemmassa tutkimuksessa nekin on fyysisesti valmistettu jollain mitattavalla tekniikalla.

4N ja N4 eri valmistus metodeja ja toinen on aito 4nm ja toinen on 5nm.

Intel noissa suurin vedättäjä, kehittelivät ainakin 5 vuotta 10nm prossuja ja kun muut meni (TSMC) ohi vuosien aikana niin nimesivät oman julkaistun tekniikan "7nm" prosessiksi koska kilpailijalla, AMD:llä oli "7nm" prosessorit.

Onhan noita, AMD Ryzenit kun tuli "7nm" tekniikalla, niin paljastui että vain tietyt osat olivat tehty 7nm ja muita osia prosessorista oli tehty vanhalla ja halvemmalla 12nm tekniikalla.

Eiköhän noissa tule support bracketit mukana toimituksessa, joissaki oli jo nyt erikseen mainittu. Hyvällä jäykällä rungolla saa hyvin myös tuettua korttia. 3080 Strixi oli melkein luotisuora, vaikka siinä ei tullu mukana mitään tukea. Toki painoa oli vähemmän, mutta ei sekään mikään keijukainen ole.

EDIT: Näyttää Suomen Proshopille tulleen jo varastoon Gigabyten 4090, saldo näyttää +15kpl. Paremmilla jäähyillä näyttää tosiaan hinta olevan vielä kevyet 500€ enemmän

Toinen on OC malli. Saat muutaman hertsin lisää 400 eurolla, ei hassumpaaSiellä oli tuffilla 2 hintaa. 1999 ja toinen joku 2390. Mikähän juttu.

Näytönohjaimet - Osta uusi GPU / GFX pelaamista varten täältä

Proshopista löydät laajan valikoiman näytönohjaimia / GPU / GFX.www.proshop.fi

Non-OC TUF oli joissain 30-sarjan korteissa kamppistuote jota myytiin Proshopissa ja Jimmsillä MSRP hintaan silloinkin kun hintataso oli taivaissa.Siellä oli tuffilla 2 hintaa. 1999 ja toinen joku 2390. Mikähän juttu.

Näytönohjaimet - Osta uusi GPU / GFX pelaamista varten täältä

Proshopista löydät laajan valikoiman näytönohjaimia / GPU / GFX.www.proshop.fi

Jos viime launchista voi jotain päätellä, noiden kahden mallin suurin ero on siinä, että non-OC-mallia ei valmisteta juuri yhtään, eli saatavuus voi olla heikko.Toinen on OC malli. Saat muutaman hertsin lisää 400 eurolla, ei hassumpaa

Meinasi varmaan, että GPU:n kellotaajuus korkeampi.. hertseissä mitattuna.Jos viime launchista voi jotain päätellä, noiden kahden mallin suurin ero on siinä, että non-OC-mallia ei valmisteta juuri yhtään, eli saatavuus voi olla heikko.

Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

Kaikki I/O tuotteet tehdään, oli sitten kyseessä muistipiiri, CPU, GPU tai vaikka äänipiiri tai kahvinkeittimen prosessori tietyllä alkuperäisellä viivanleveydellä ja noi nanometrit ovat todellisia mittoja, siis kun unohdetaan markkinahöpöt.Eikös se ole ollut jo pitkään tiedossa, että nuo ei todellakaan ole mitään oikeita mittoja? Tainnut myös tämä ADA:n valmistus tekniikka ole pitkään olla tiedossa, että se on NVIDIA optimoitu "5nm" TSMC:n prosessi?

Onko linkkiä tuohon vertailuun. Vissiin joku youtube video tai joku niin voisi katsoa läpi.Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

Onko linkkiä tuohon vertailuun. Vissiin joku youtube video tai joku niin voisi katsoa läpi.

Ai. No sitten. Kahlasin itsekkin läpi tuon tiiserin ja löysin tuon framen. Aika tarkkaan on joku katsonut kun tuossa kohtauksessa kun Spideri hyppää tuosta ikkunasta niin yksi frame tuolla välissä on tuommoinen vähän hullunkurinen. Yritin kymmenkunta kertaa saada sitä silmiin normaali nopeudella mutta ei onnistunut vaikka tiesi mihin kohtaan katsoa.Se on otettu siitä DF:n previkan tiiseristä.

Kyllä sellaset ihmiset huomaa noi helposti jotka tykkäävät pelata asetukset maksimissa ja ihastella tarkkuutta samalla kun pelaa. Itse en ole sellainen, mutta jos tuo kuva pitää paikkaansa, niin onhan tuo aika järkyttävää katseltavaa.Mutta kuinka paljon huomaat ongelmat liikkeessä? Eli oikeasti pelatessa eikä yksittäisiä kuvia katsoessa.

Jep, näkee ihan ilman hidastuksia tai pysäytyksiä, että DLSS3 kuvassa hahmon ympärillä on sellainen halo-efekti. Youtubesta 0.25 hidastus päälle, niin vielä paremmin näkee miten noita artefakteja generoituu hahmon ympärille. Onhan tuo paljon parempi, kuin televisioiden frame generation säädöt, mutta riittääkö laatu tosiaan ihan peleihin?Aika oksennusta toi DLSS3 jälki on, kattokaa tota nyt:

Housut, nyrkki, suu... yhtä sotkua.

Ei jatkoon..

Tietäjien, eli faktojen kannalta se on oikeasti 4070 (leikattu piiri, alempi piirisarja, muistikaistat onnetonta yms.).En kyllä ymmärrä yhtään RTX 4080 12GB:n nimeä ja hintaa. Muistiväyläkin vain 192-bittiä ja piiri on pienempi kuin Amperen vastaava. Watit silti maistuu.

Tietäjien, eli faktojen kannalta se on oikeasti 4070 (leikattu piiri, alempi piirisarja, muistikaistat onnetonta yms.).

Joten siitä AD104 piiristä saa sitten helposti leikattua 4070 10GB (160-bit muistiväylällä) kortin joulu/tammikuun julkaisuunTietäjät tietää että 4080 12GB on ainut julkaistuista korteista jossa ei ole leikattu piiri.

Hieman huvittaa kun huomioi minkä kokoinen GA104 on. AD104 on selvästi pienempi. En voi käsittää... RTX 4070 Ti:nä olisi juuri ja juuri mennyt, mutta ei hinnan puolesta. Onkohan tuon muistiohjain maksimissaan tuo 192-bit tuolla piirillä?Tietäjien, eli faktojen kannalta se on oikeasti 4070 (leikattu piiri, alempi piirisarja, muistikaistat onnetonta yms.).

Nahkatakki mies vain nimesi sen 4080 kortin "alakortiksi". Nimi kun myy enemmän kuin pelkkä mallinumero tai faktat.

4090 = 4090 (AD102 piiri)

4080 16Gb = 4080 (AD103 piiri)

4080 12Gb = 4070 (AD104 piiri), isompi "4080" nimi kun myy enemmän asiasta tietämättömille... :/

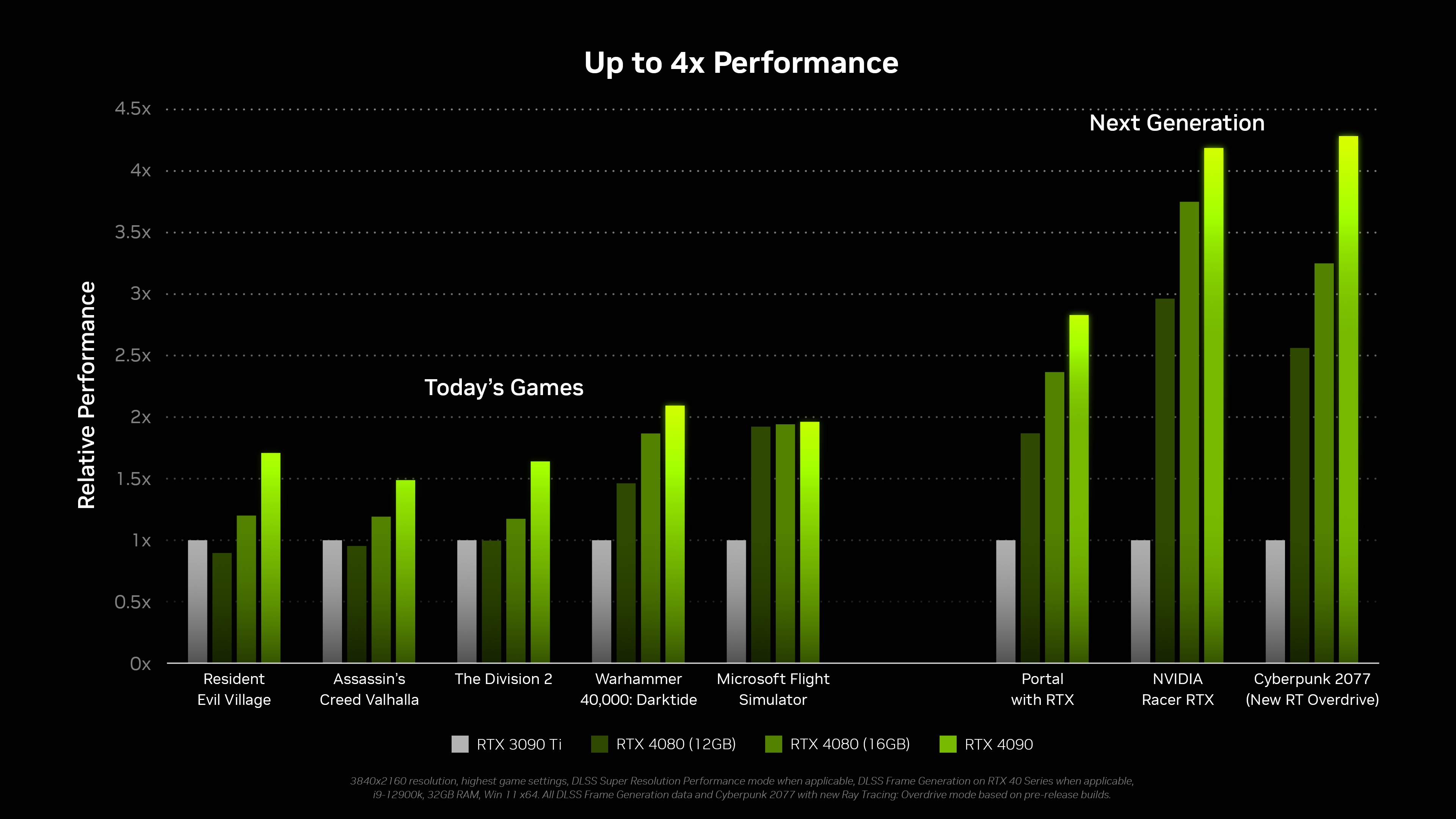

Lasketaanpa välillä oikea prosenttiparannus, ettei Techpowerupin uutisen jonkun kommentoijan väärin laskema arvo (62 %) leviä enempää.

Techpowerupin uutiskommenteista. Tämä oli kyllä aika karu pika-analyysi:

"If you compare the non-DLSS results between the 3090TI and 4090, its only a 62% increase in FPS, this is with the 4090 having 55% more CUDA cores, 40%~ more clock speed, and 90MB more L2 cache (96MB vs 6MB on the 3090TI). This does no bode well for the 4080 16GB results in comparison to the 3090TI in non DLSS or heavy RT performance."

Outo julkaisu kaikenkaikkiaan. Paukut on DLSS3.0 korissa ja AD102 piiri vaikuttaa omaavan parhaan perf/€ suhteen, joka on ennenkuulumatonta lippulaivamallille.

Muistanko väärin vai ilmoittiko Nvidia nopeusparannuksen olevan 2-4x? Olettaen että 2x olisi ilman DLSS ja sitten DLSS 3.0 kanssa voidaan päästä tuonne 3-4x lukemiin? Vai koskiko tuo Nvidian ilmoittama 2-4x vain DLSS 3.0 kanssa?Lasketaanpa välillä oikea prosenttiparannus, ettei Techpowerupin uutisen jonkun kommentoijan väärin laskema arvo (62 %) leviä enempää.

Oikea non-DLSS -parannus, 4090 vs. 3090 Ti:

(59,9 / 35,8 -1) * 100 % = 67,3 %.

Väittivät että 4090 on 2-4X nopeampi kuin 3090 Ti.Muistanko väärin vai ilmoittiko Nvidia nopeusparannuksen olevan 2-4x? Olettaen että 2x olisi ilman DLSS ja sitten DLSS 3.0 kanssa voidaan päästä tuonne 3-4x lukemiin? Vai koskiko tuo Nvidian ilmoittama 2-4x vain DLSS 3.0 kanssa?

Käytämme välttämättömiä evästeitä, jotta tämä sivusto toimisi, ja valinnaisia evästeitä käyttökokemuksesi parantamiseksi.