- Liittynyt

- 28.03.2017

- Viestejä

- 1 765

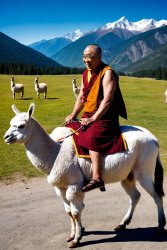

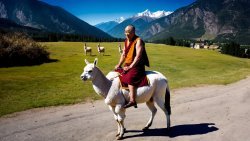

Tänään droppaapi SDXL 1.0. Yksi devaajista sanoi discordissa että weightsit n. 3h päästä eli klo 23 tietämillä. Varmaankin imuroitavissa osoitteesta stabilityai (Stability AI) kunhan laittavat tulille.

stabilityai/stable-diffusion-xl-base-1.0 · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

huggingface.co

stabilityai/stable-diffusion-xl-refiner-1.0 · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

huggingface.co

stabilityai/sd-vae-ft-mse-original at main

We’re on a journey to advance and democratize artificial intelligence through open source and open science.

huggingface.co

Siellä olis.