finWeazel

Chief Karpfen

- Liittynyt

- 15.12.2019

- Viestejä

- 8 007

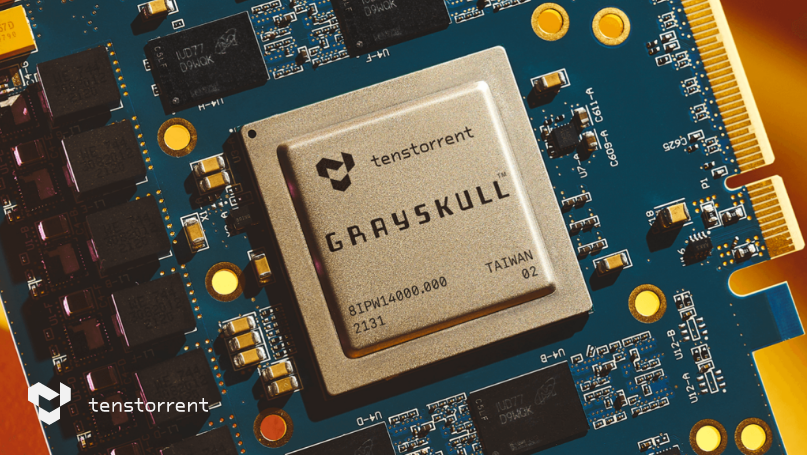

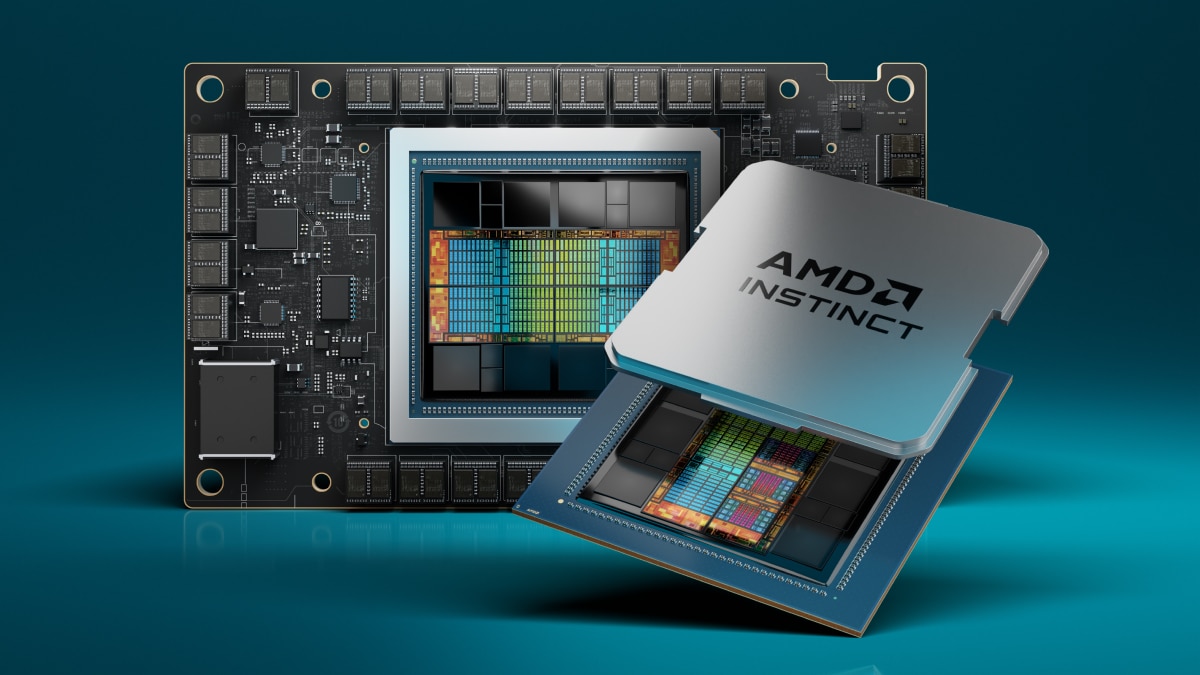

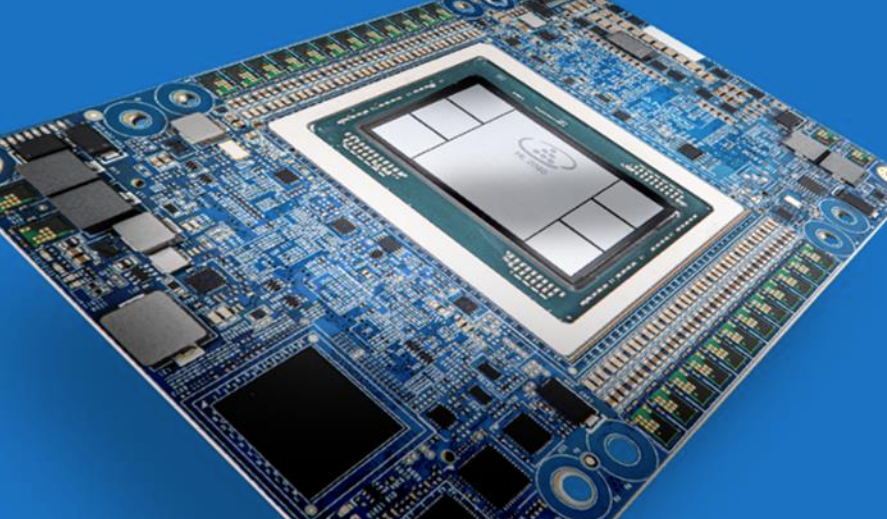

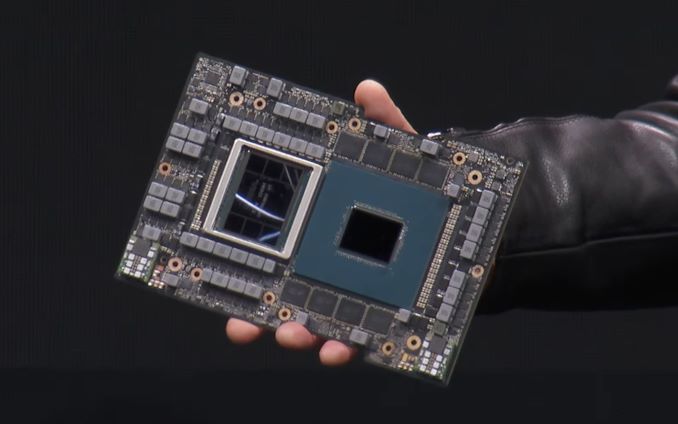

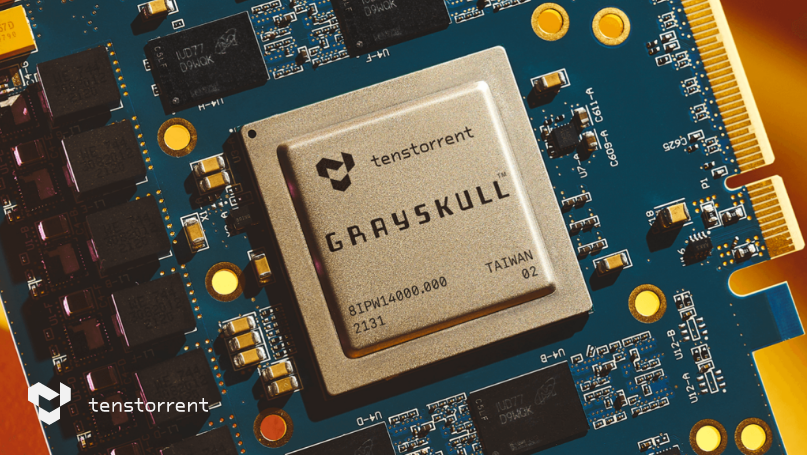

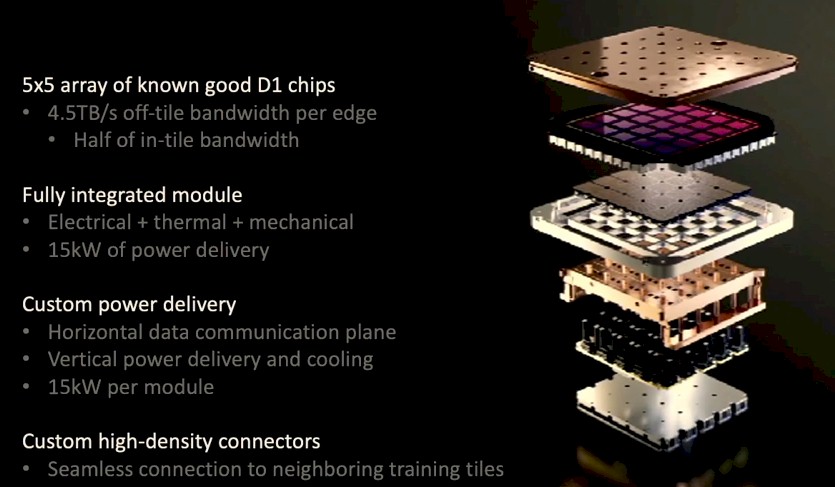

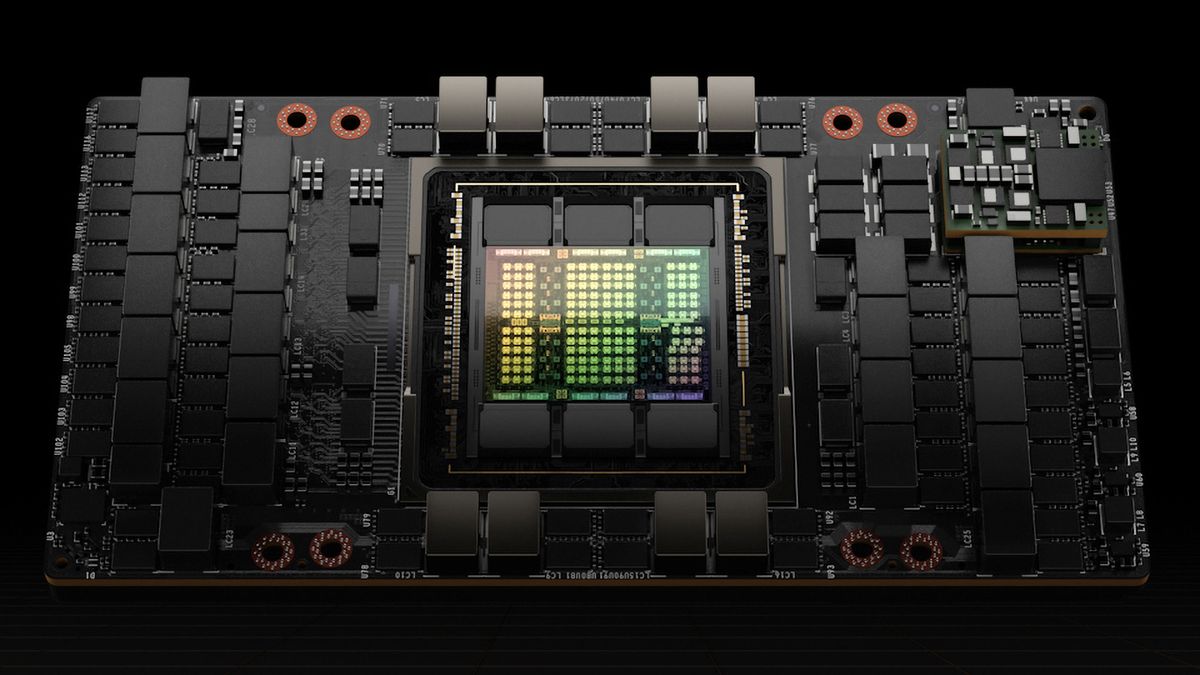

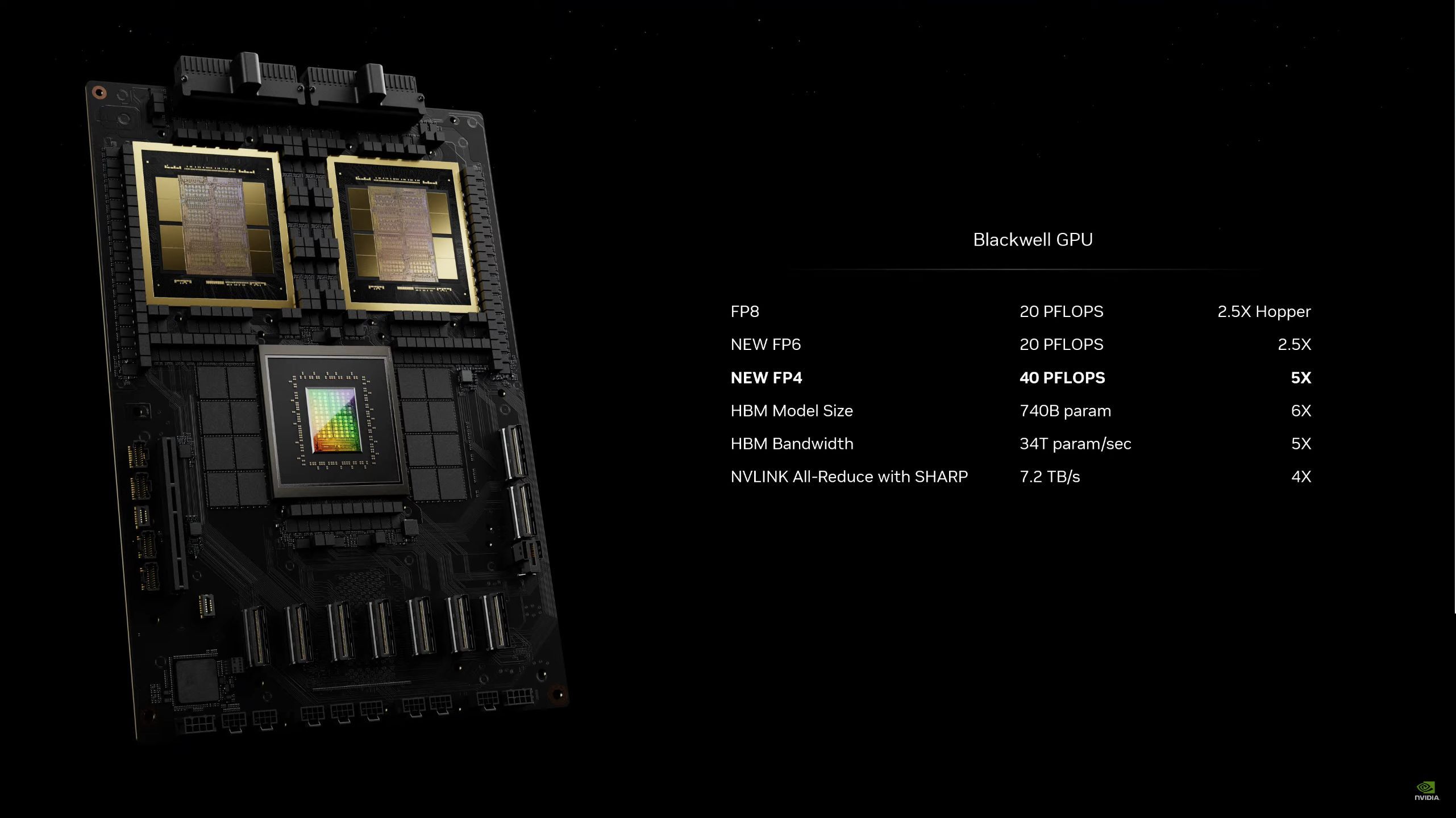

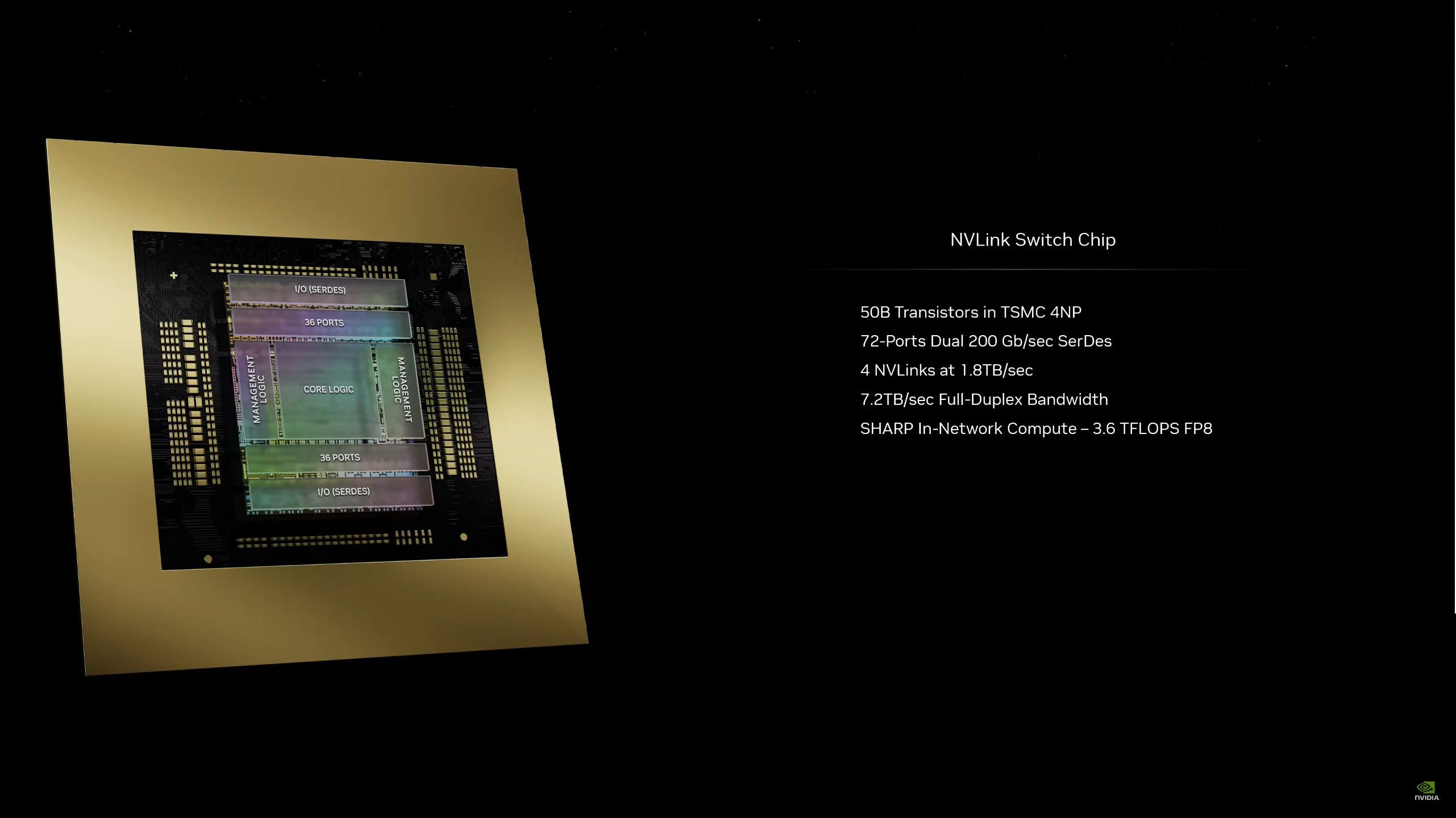

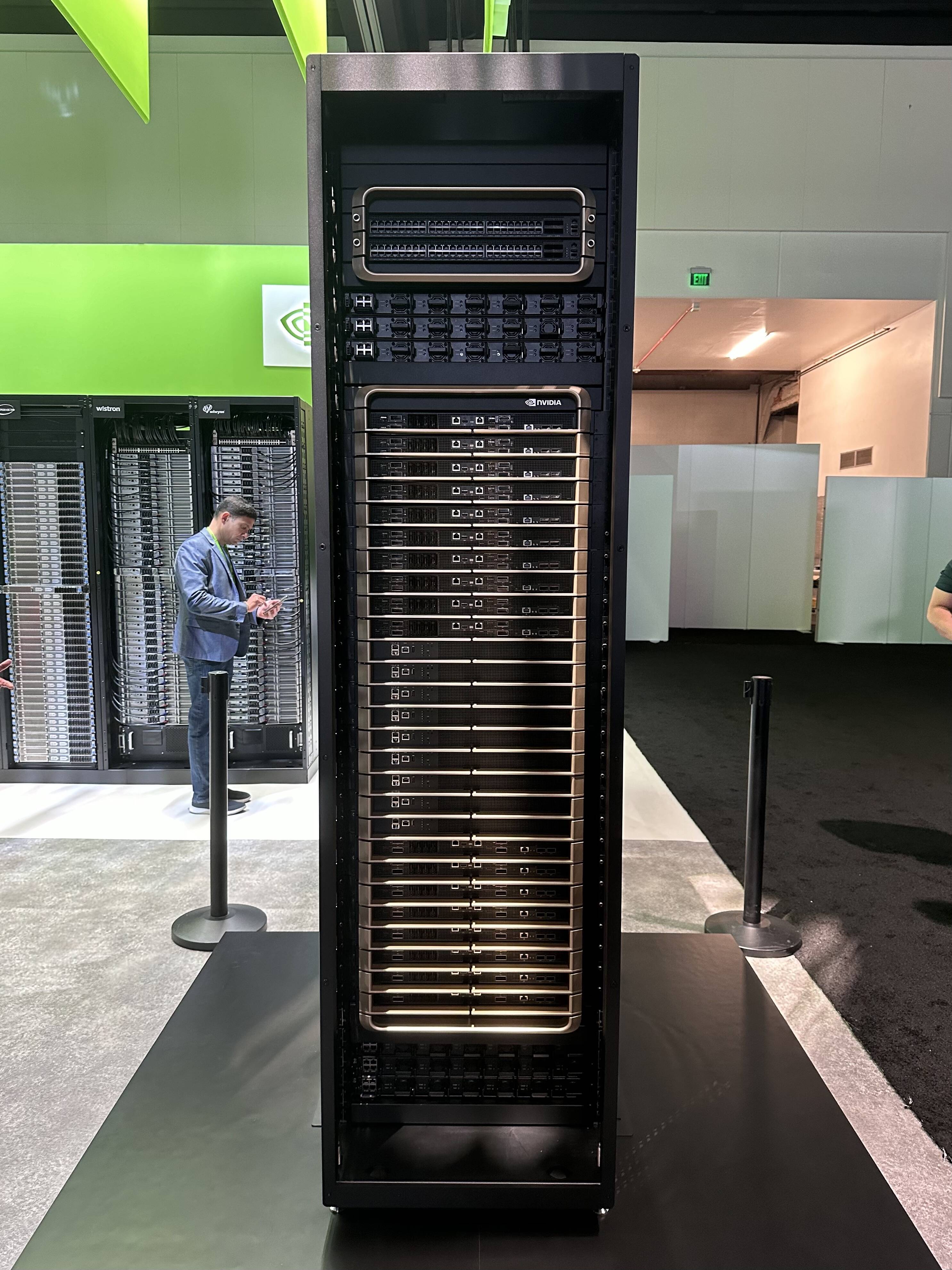

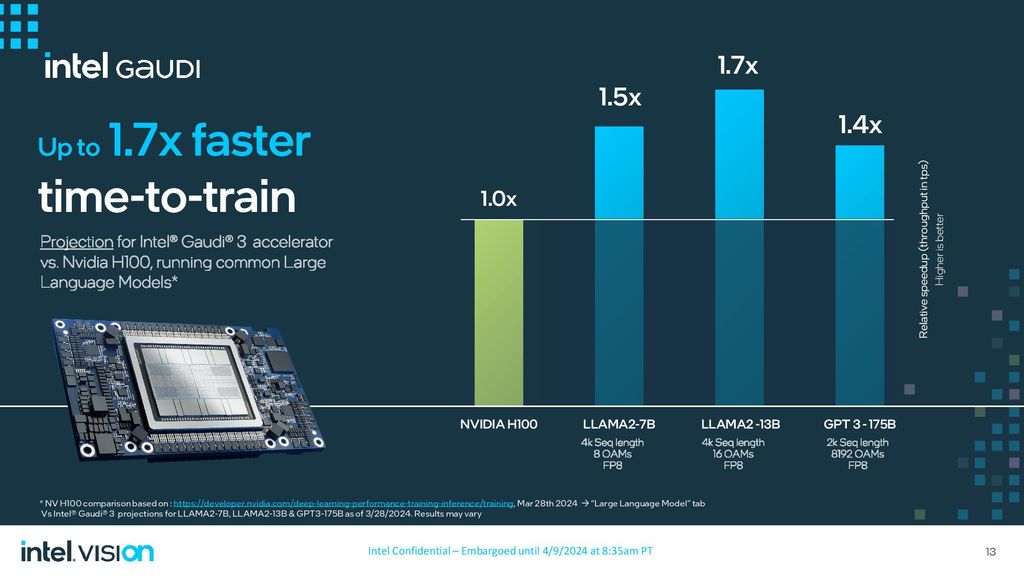

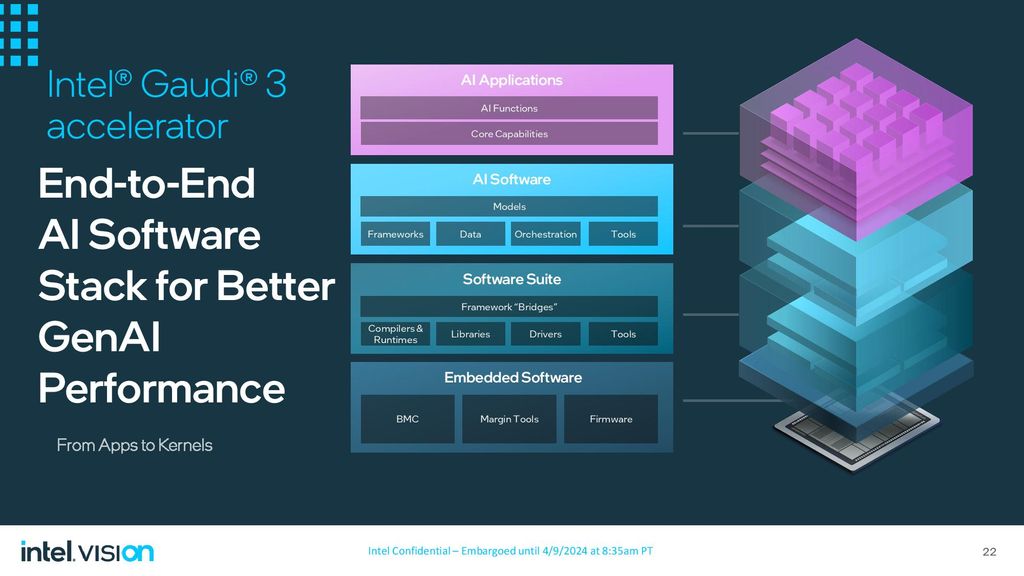

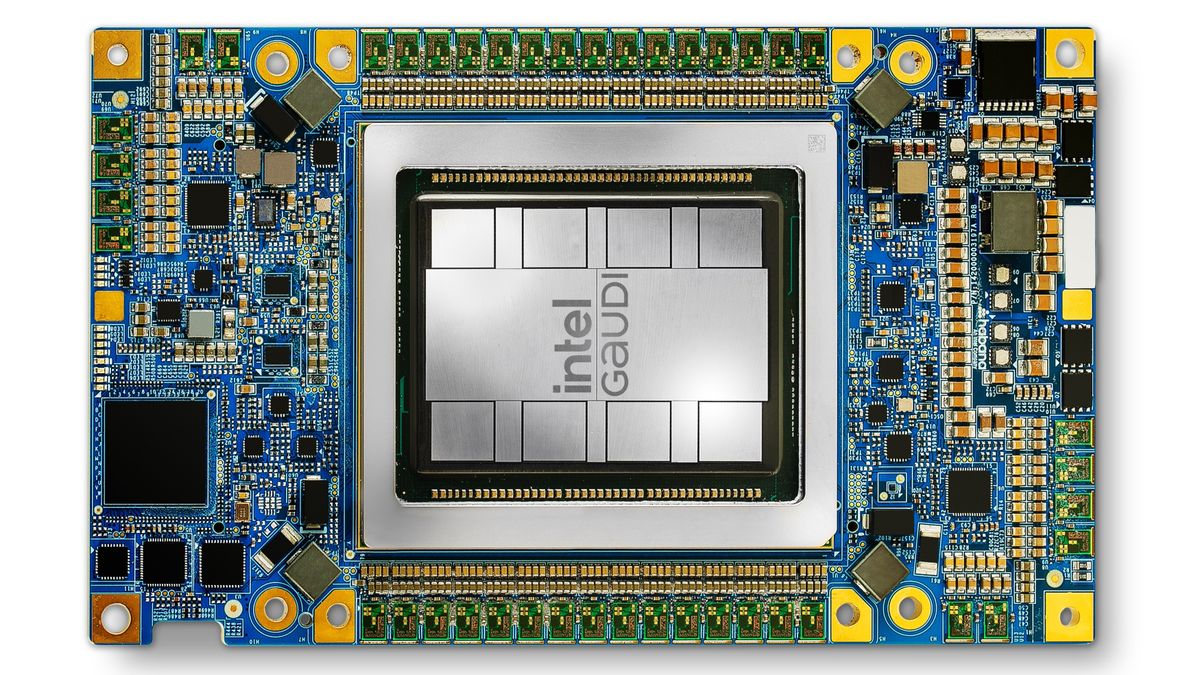

Keskustelua konesalitason AI-kiihdytimistä kuten AMD MI300, intel Gaudi3 ja Nvidia H100. Ketjussa voi keskustella tekninen kulma edellä yrityksistä kuten tenstorrent, konesalitason AI-kiihdyttimien spekseistä, kaupallisesta puolesta ja seuraavan generaation piirien huhuista. Myös yksittäisistä isot asennukset kuten AMD pohjainen El Capitan ovat tervetullut lisä keskusteluun.

Tein ketjun, koska konesalikiihdyttimet alkavat olemaan sellaisia ettei niistä järkevästi voi keskustella gpu-ketjussa. Ketjun aihe tarkoituksella laaja. En usko, että näin laajallakaan haavilla keskustelua syntyy runsaasti.

Tein ketjun, koska konesalikiihdyttimet alkavat olemaan sellaisia ettei niistä järkevästi voi keskustella gpu-ketjussa. Ketjun aihe tarkoituksella laaja. En usko, että näin laajallakaan haavilla keskustelua syntyy runsaasti.

Viimeksi muokattu:

.jpg)