Veikkaan että markkinointi on päästetty vauhtiin. Oli pressille ilmeisesti jaettu extra slideja joissa on 3070 vertailtu 2070 1440p resolla. En siis yllättyisi vaikka samalla resolla vertailu olisi "vahingossa" lipsahtanut myös tuota 2080Ti:tä vastaan jolloin ei ole mikään kovin suuri yllätys että tehot on about samat, varsinkin jos on sopivat pelit valittu että CPU pykii jo vastaan.

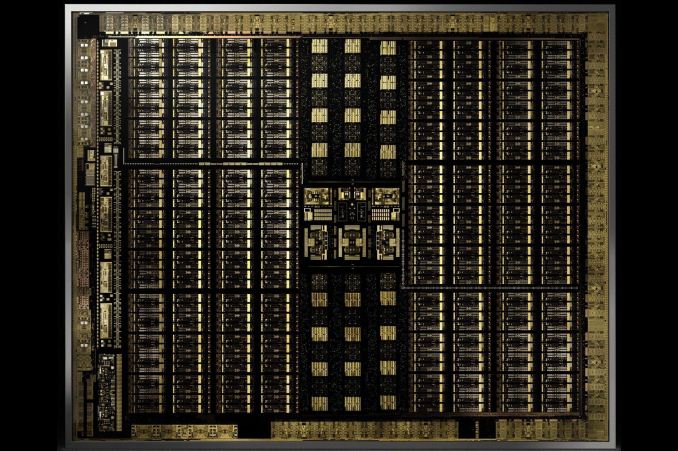

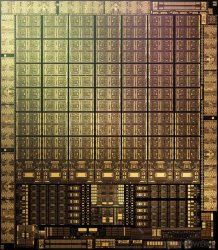

Veikkaampa että GA102 on 88SM:n siru. Nvidia on tykänny suunnitella noi piirit jo pitkään melko symmetriseen muotoon ja 82SM ei ole kovin hyvin jaollinen kun taas 88SM on esim 8:lla jos oletetaan että GA102 on suunnittelu noudattelee vaikka TU102:sta jossain määrin

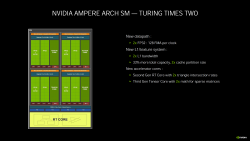

Varmaankin taas markkinointi ollut vauhdissa. Jotenkinhan se pitää aina koittaa perustella että miksi on tehty jotakin miten on tehty. Jossain oli juttua että turingiin olisi jo haluttu tehdä tää sama cuda rakenne, mutta jouduttiin karsimaan koska siru olisi kasvanut niin isoksi ettei sitä olisi ollut järkevää enää valmistaa.

Siis esim. 3080:ssä on 4352 cudaa detikoitu FP32 laskentaa, aivan samoin kuten on 2080Ti:ssä, mutta nyt amperessa on toiset 4352 cudaa rinnalla jotka voivat laskea joko FP32 tai INT32 kun taas turingissa se rinnalla oleva kykeni ainoastaan INT32 laskentaan.

Eli jossain pelkässä FP32 kuormassa siinä 3080 on teorissa tuplasti ruutia verrattuna 2080Ti, mutta jos sinne työnnetään laskentaa jossa puolet on FP32 ja puolet on INT32 niin se 3080 käyttäytyy aivan samoin kuin 2080Ti.

Lisäksi siellä voi olla jossain muualla sellaisia pullonkauloja että toi tuplateho ei tule missään realisoitumaan. Eli tämäkin on mielestäni enemmänkin markkinoiti temppu kuin oikeasti mullistava asia.

Kovin varovaisesti vielä henkseleitä paukuttelisin tuon 100% perf hypyn suhteen. Se voi jossain tilanteissa toteutua mutta realistisempi on varmaan joku 60-100% väliltä.