Harmi sulle, osta sä se kilpailijan paras.Eipä tarvi ihmetellä nykyisiä hintoja, kun hölmöläiset maksaa täälläkin melkeen tupla hinnan kilpailijan parhaaseen verrattuna tuhnu 5080. Samoissa tehoissa pyörii, jos ei DLSS lasketa mukaan ja ei sekään tupla hintaa ansaitse.. surullista menoa kyllä

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset Black Friday 2024 -tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

NVIDIA GeForce RTX 5090 & 5080 -ketju (Blackwell)

- Keskustelun aloittaja Sampsa

- Aloitettu

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 375

Aika hassusti muotoiltu kysymys. Ehkä parempi olisi kysyä mitkä pelit hyötyvät 5090:stä. Niitä pelejähän löytyy...On kyllä kalliiksi menneet näytönohjaimet, ei näillä hinnoilla huvita paljoa ostella. Mikä peli vaatii 5090 kortin?

- Liittynyt

- 21.01.2017

- Viestejä

- 585

Eli mikään peli ei sitä vaadi, mutta siitä voi hyötyä jotenkin?Aika hassusti muotoiltu kysymys. Ehkä parempi olisi kysyä mitkä pelit hyötyvät 5090:stä. Niitä pelejähän löytyy...

- Liittynyt

- 12.09.2020

- Viestejä

- 1 736

Ei mikään vaadi. Suurin kysyntä on AI hommat.On kyllä kalliiksi menneet näytönohjaimet, ei näillä hinnoilla huvita paljoa ostella. Mikä peli vaatii 5090 kortin?

Peleistä Alan Wake 2, Cyberpunk, Star Wars Outlaws, Black Myth Wukong saa ainakin koneen ku koneen kyykkyyn luokkaa 30 fps ilman DLSS.

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 375

Ei tietenkään. Jos katsos pelien minimejä niin ne ovat uusissakin usein luokkaa RTX 3060. En vieläkään ymmärrä kysymyksen asettelua.Eli mikään peli ei sitä vaadi, mutta siitä voi hyötyä jotenkin?

Jos peli pyörii 4090 jo vähän päälle 60fps DLSS kanssa ilman FG ja 5090 pääsee 80fps luokkaan niin joillekkin se on 3000€ arvoinen kokemus.

Itselläkin se kipuraja on tuolla +90fps paikkeilla milloin saa parhaimman kokemuksen, mutta en lähde maksamaan tuhansia tuollaisesta. Mielummin säätelen asetuksia vähän alas.

Itselläkin se kipuraja on tuolla +90fps paikkeilla milloin saa parhaimman kokemuksen, mutta en lähde maksamaan tuhansia tuollaisesta. Mielummin säätelen asetuksia vähän alas.

Ei osunut arpaonni itelle 5080 tilauksen suhteen. Korttia kuitenkin tarvin mahdollisimman nopeasti (eikä jaksa odotella kevääseen), niin tuli tilattua 4070TiSu 929e hintaan, mistä 2% pois hinnasta kun maksoi Morrowin kortilla. Toivottavasti tuo riittää 1440P resolle hyvillä grafiikoilla ja onhan tuo iso päivitys 2060 6GB -malliin.

- Liittynyt

- 20.11.2023

- Viestejä

- 22

Niinhän siinä kävi, että yllättäen 90-sarjalaisen olisi saanut tilattua Gigantista, mutta en mistään about MSRP RTX5080-mallia. Onkohan noita FE-malleja tulossa mahdollisesti lähipäivinä enää myyntiin vai onko ainoa vaihtoehto kansanmurha-kopterikaupan osto-oikeusarvonta?

Rane

Coordinator @ Diablo 4 clan "iotech"

- Liittynyt

- 01.11.2016

- Viestejä

- 3 142

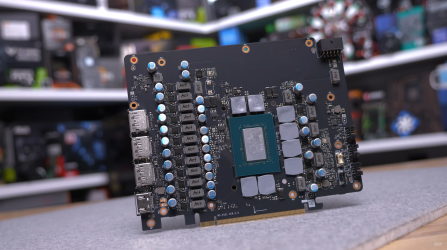

RTX 5080 TUFfin jäähy näyttäisi olevan kohdallaan: reilu 10 astetta viileämpi performance-modessa verrattuna FE:n.

www.guru3d.com

www.guru3d.com

5090 TUF:n artikkeleita odotellessa.

Review: ASUS TUF GeForce RTX 5080 Gaming OC edition (Page 6)

In the ever-evolving realm of graphics technology, the ASUS TUF Gaming GeForce RTX 5080 16GB GDDR7 OC Edition emerges. With a blend of technology and design, this graphics card is positioned in the premium class of RTX 5080 products.

5090 TUF:n artikkeleita odotellessa.

- Liittynyt

- 13.12.2016

- Viestejä

- 4 978

Ihan hyvin nuo 5080:t tuntuu kyllä kellittyvän.

- Liittynyt

- 27.12.2016

- Viestejä

- 198

Ihan hyvin nuo 5080:t tuntuu kyllä kellittyvän.

Erittäin hyvin tosiaan näyttää RTX 5080:n

AIB-versiot kellotuvan Techpowerupin mukaan. Päästään melko lähelle RTX 4090 suorituskykyä. Gen-2-Gen boosti ylikellotettuna 20-30% luokkaa.

Ettei vaan Nvidia ole tahallisesti jättänyt RTX 5080:n kelloja maltilliseksi, jotta saa reippaammin kellotetun Super-mallin myytyä vuoden päästä?

- Liittynyt

- 27.12.2016

- Viestejä

- 2 714

RTX 5080 TUFfin jäähy näyttäisi olevan kohdallaan: reilu 10 astetta viileämpi performance-modessa verrattuna FE:n.

Review: ASUS TUF GeForce RTX 5080 Gaming OC edition (Page 6)

In the ever-evolving realm of graphics technology, the ASUS TUF Gaming GeForce RTX 5080 16GB GDDR7 OC Edition emerges. With a blend of technology and design, this graphics card is positioned in the premium class of RTX 5080 products.www.guru3d.com

5090 TUF:n artikkeleita odotellessa.

Pitäisi olla sama jäähy, eli kysymyksenä lähinnä riittääkö se 600W kuormalle.

Rane

Coordinator @ Diablo 4 clan "iotech"

- Liittynyt

- 01.11.2016

- Viestejä

- 3 142

Pitäisi olla sama jäähy, eli kysymyksenä lähinnä riittääkö se 600W kuormalle.

Siihen pienet alivoltitukset ja 100w-200w pois, niin luulisi olevan samoissa lämmöissä.

- Liittynyt

- 18.10.2016

- Viestejä

- 1 410

RTX 5090 arvosteluissa erityisesti painotettiin 4K 240Hz tai 1440p 360/480Hz näytön omaaville. Varsinkin jos pelaa yksinpelejä eikä moninpelejä. Tällöin saa näytöstä täydet hyödyt pienillä ongelmilla (artifaktit). Ja arvosteluiden mukaan tämä toimii erittäin hyvin, kaikki herkut päälle, mukaanlukien säteenseuranta ja 4K:lla 240 FPS (sama kuin näyttö).Eli mikään peli ei sitä vaadi, mutta siitä voi hyötyä jotenkin?

Toki 32GB on myös aivan luxus esim. AI-malien pyöritykseen.

2500-3000€ on paljon rahaa mutta kaikki on suhteellista, todennäköisesti ne säästöt on muualta (elämäntavat), ja taivastelijat eivät huomioi että niin joo, viimeisen 5v aikana tullut käytyä X reissua ulkomailla, ajetaan >50k€ autolla, saattaa olla kesämökki, hieno pyörä, yms... niin, onko se 3000€ enää sitten paljon? Saattaa olla että taivastelija käyttänyt itse moninverroin rahaa, ei vaan huomaa sitä.

Yleisesti ottaen komponenttien jälleenmyyntiarvo on hyvä, vähintään 50%. Siksi on kallis mutta huoleton sijoitus.

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 375

Oli vähän pettymys huomata että uudet DLSS featuret toimivat niin harvassa pelissä. Kokeilin pikaisesti 4x fg:tä Cyberpunkissa ja se oli kyllä niin tahmeaa ettei tule koskaan enää täpättyä päälle. Nuo upscalingin laatu parannukset kyllä kiinnostavat paljonkin.

Rane

Coordinator @ Diablo 4 clan "iotech"

- Liittynyt

- 01.11.2016

- Viestejä

- 3 142

Multi Frame Generation toimii vain 5000-sarjan korteilla. Niilläkin pitää olla ilmeisesti jo tarpeeksi hyvä natiivi fps pohjalla, jotta ei mene tahmailuksi.Oli vähän pettymys huomata että uudet DLSS featuret toimivat niin harvassa pelissä. Kokeilin pikaisesti 4x fg:tä Cyberpunkissa ja se oli kyllä niin tahmeaa ettei tule koskaan enää täpättyä päälle. Nuo upscalingin laatu parannukset kyllä kiinnostavat paljonkin.

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 375

Juuh, 5080:llä kokeilin. Arvelin kyllä sen olevan noin, mutta pitihän se kokeilla että saa haukkua.Multi Frame Generation toimii vain 5000-sarjan korteilla. Niilläkin pitää olla ilmeisesti jo tarpeeksi hyvä natiivi fps pohjalla, jotta ei mene tahmailuksi.

- Liittynyt

- 18.10.2016

- Viestejä

- 1 410

Oli vähän pettymys huomata että uudet DLSS featuret toimivat niin harvassa pelissä. Kokeilin pikaisesti 4x fg:tä Cyberpunkissa ja se oli kyllä niin tahmeaa ettei tule koskaan enää täpättyä päälle. Nuo upscalingin laatu parannukset kyllä kiinnostavat paljonkin.

Juuri näin kuten Rane kirjoitti. Hardware Unboxed tosiaan teki tästä hyvän videon johon viittasin aiemmin:Multi Frame Generation toimii vain 5000-sarjan korteilla. Niilläkin pitää olla ilmeisesti jo tarpeeksi hyvä natiivi fps pohjalla, jotta ei mene tahmailuksi.

Voi toimia hyvin 5090 kanssa mutta 5080 nihkeä.

NVIDIA GeForce RTX 5090 & 5080 -ketju (Blackwell)

5090: - GB202 GPU - 21760 CUDA-ydintä - 512-bit - 32 Gt GDDR7 - 575W TDP - Suositushinta: 2455 € 5080: - GB203 GPU - 10752 CUDA-ydintä - 256-bit - 16 Gt GDDR7 - 360W TDP - Suositushinta: 1229 € Myynti alkaa 30. tammikuuta 2025. io-techin kirjoitettu testiartikkeli...

bbs.io-tech.fi

- Liittynyt

- 21.02.2017

- Viestejä

- 5 588

Eiköhän se ihan toimiva ole 5080:lläkin esim. jos monitorina 1440p tai jos laskee asetuksia sen verran siellä 4K:lla että saa sen pohja fps:n järkevämmäksi.Voi toimia hyvin 5090 kanssa mutta 5080 nihkeä.

FG on myös hyvin monessa Cyberpunkia paljon kevyemmässäkin pelissä, myös sellaisissa joissa ei ole mitään RT efektejä. Niissä helpompi saada joku järkevämmän tapainen 80fps -> 240fps lentoon.

Oliko millainen FPS pohjalla ilman FG:tä? Tuostahan on sanottu, että minimi jolla sitä voi käyttää on luokkaa 50-60fps, mielellään 80+ FPS ehkä. Muutoin latenssi (tahmeus) ja artifaktit käyvät todennäköisesti liialliseksi.Oli vähän pettymys huomata että uudet DLSS featuret toimivat niin harvassa pelissä. Kokeilin pikaisesti 4x fg:tä Cyberpunkissa ja se oli kyllä niin tahmeaa ettei tule koskaan enää täpättyä päälle. Nuo upscalingin laatu parannukset kyllä kiinnostavat paljonkin.

Tämä käytännössä rajoittaa multi-FG:n hyödyt 240Hz näytöille ja nopeammille, 120Hz näytön kanssa siitä ei ole iloa oikein missään tilanteessa. Käytännössä siis melkoisen ylihypetetty ominaisuus, eikä todellakaan mikään hopealuoti niinkuin nahkatakkimies hieman antoi ymmärtää (5070 = 4090).

kolistelija

Make ATK Great Again

- Liittynyt

- 17.02.2018

- Viestejä

- 1 375

Oli tuo aika ärsyttävä vielä 80 fps lähtö tasollakin. Minulla on tosin vain 175 Hz ruutu niin kokeilin mat alemmilla detskuilla vain 2x fg:tä. Eron viiveessä huomasi aika hyvin jo asetuksella joka ilman fg:tä pyöri siis noin 70-90 fps.Eiköhän se ihan toimiva ole 5080:lläkin esim. jos monitorina 1440p tai jos laskee asetuksia sen verran siellä 4K:lla että saa sen pohja fps:n järkevämmäksi.

FG on myös hyvin monessa Cyberpunkia paljon kevyemmässäkin pelissä, myös sellaisissa joissa ei ole mitään RT efektejä. Niissä helpompi saada joku järkevämmän tapainen 80fps -> 240fps lentoon.

Jos asetuksia joutuu laskemaan, niin silloin ei kannata yrittää käyttää FG:tä ensinnäkään. Siksihän tuo ominaisuus ei oikein vaikkapa RTX 5070:lle sovi, markkinoi Nvidia mitä tahansa.Eiköhän se ihan toimiva ole 5080:lläkin esim. jos monitorina 1440p tai jos laskee asetuksia sen verran siellä 4K:lla että saa sen pohja fps:n järkevämmäksi.

Miksei? Onhan esim. DLSS performancen käyttäminenkin asetuksen laskemista. Ei millään kortilla voi ajaa natiivia 4K kaikki herkut (Path tracing) päällä, oli FG:tä tai ei. Vähintään DLSS pitää olla, jossain siellä performance-tasolla.Jos asetuksia joutuu laskemaan, niin silloin ei kannata yrittää käyttää FG:tä ensinnäkään. Siksihän tuo ominaisuus ei oikein vaikkapa RTX 5070:lle sovi, markkinoi Nvidia mitä tahansa.

Mutta jos joku haluaa pelata oikein sulavalla 240 FPS yksinpeliä, ja tämä vaatii vaikka PT:n pudottamista RT Ultra tasolle, niin en näe miksi tätä ei kannattaisi FG:n kanssa tehdä.

Sieltä tuli päivitetty video jossa todetaan että on kaikista tuhnuin sarja viimeisen 10 vuoden aikana eikä kovalle hinnan nousulle löydy muuta selitystä kuin että Jensen tarvitsee uuden nahkatakin.

700e olisi se oikea hinta 5080 ilman Nvidia "veroa".

Intel tarjoaa 5070 vastaavilla spekseillä, mutta vanhemalla muistimallilla melkein puolet halvemmalla B580 mallia jota mahdollisesti myydään minimaalisella voitolla.

700e olisi se oikea hinta 5080 ilman Nvidia "veroa".

Intel tarjoaa 5070 vastaavilla spekseillä, mutta vanhemalla muistimallilla melkein puolet halvemmalla B580 mallia jota mahdollisesti myydään minimaalisella voitolla.

HUB arvosteluissa pisti silmään että Delta Force fps ainakin parani huomattavasti sitten FE arvostelun.Joku selitti syyksi muuttuneen arkkitehtuurin, joka vaatii ajuri- ja pelipäivityksiä. Saa nähdä paraneeko suorituskyky siis merkittävästi myöhemmin.

Sieltä tuli päivitetty video jossa todetaan että on kaikista tuhnuin sarja viimeisen 10 vuoden aikana eikä kovalle hinnan nousulle löydy muuta selitystä kuin että Jensen tarvitsee uuden nahkatakin.

700e olisi se oikea hinta 5080 ilman Nvidia "veroa".

Intel tarjoaa 5070 vastaavilla spekseillä, mutta vanhemalla muistimallilla melkein puolet halvemmalla B580 mallia jota mahdollisesti myydään minimaalisella voitolla.

Tuosta oli myös Paul's Hardware tehnyt videon, ja sinne taulukon joka mielestäni aika hyvin havainnollistaa eron edellisiin sukupolviin.

Kyllähän sitä voi hyvinkin käyttää, vaikka ei olisikaan asetukset tapissa, kunhan vain sitä käytetään oikein. Jos pohjalta FPS on hyvä, voi pelikokemus olla hyvinkin kelvollinen. Jos taas tehoja olisi muutenkin pyörittää peliä lähellä näytön maksiminopeuksia, saadaan reippaasti lisäviivettä, jos FG laitetaan liian isolle, ei sitä pakko ole väkisin yrittää laittaa liian suurelle. Kuvakaappaus Hardware Unboxedin videolta. Eli parhaassa tapauksessa framegenin latenssi on vain muutamia millisekunteja. Jos taas halutaan käyttää näytönohjainta pienemmällä teholla luomalla pirusti generoituja frameja, joita näyttö, tai näytönohjain ei tarvitse, päästään pahimmillaan yli 100ms latensseihin, jolla pelaaminen on jo kohtalaisen kamalaa. Perus FPS:n tippuessa 30 nurkille, odotellaan sitä seuraavaa kuvaa mistä generoidaan liian pitkään. Pakkohan sitä ei ole ikinä laittaa päälle, mutta ei ainakaan itsellä kovin montaa liikahdusta mene, että silmä tai käsi tottuu tuohon pieneen lisäviiveeseen ja kaikki pelittää normaalisti. En käyttäisi välttämättä jos pelaisin CS:ää kilpaa, mutta hyvähän tuo välillä on vaikka Indiana Jonesissa tai Cyberpunkissa, kun hakee pohjalta sen 60+ FPS, tämä siis 4000-sarjalaisella, mutta samalla tavalla noissa periaate menee kaikissa.

- Liittynyt

- 27.12.2016

- Viestejä

- 2 714

HUB arvosteluissa pisti silmään että Delta Force fps ainakin parani huomattavasti sitten FE arvostelun.

Tuosta oli redditiin joku kynäillyt:

Blackwell's Inconsistent Performance Could Be Caused By The AI Management Processor (AMP)

**Disclaimer (Please read this before up- or downvoting):** I'm reporting this early based on the limited info available to spread awareness and...

Disclaimer (Please read this before up- or downvoting): I'm reporting this early based on the limited info available to spread awareness and encourage more testing by qualified testers and analysis by qualified experts. That's why I've marked as a rumour even though it's not a rumour nor remotely close to settled facts. We're nowhere near knowing the true culprit(s) for Blackwell's performance inconsistency and this only neccessitates additional work and analysis so we can draw valid conclusions.

Not trying to push an agenda here or arm copers, just highlighting a potentially serious issue with the Blackwell's AMP logic unit that warrants investigation. If the AMP issue is real and can be fixed in software, then it'll require an army of NVIDIA software engineers to help rewrite application and game specific code and/or rework the NVIDIA driver stack.

Detailing The Performance Inconsistencies

Blackwell's overall performance consistency and application support is extremely lackluster compared RTX 40 series and resembles an Intel ARC launch more than a usual rock solid NVIDIA launch where relatively uniform uplifts are observed across the board and applications and every usually just works. Application performance sees the wildest inconsistencies but they do extend to gaming as well. The lackluster performance at 1080p and 1440p is an issue plaguing both the 5090 and 5080, that gets somewhat resolved at 4K.

With 50 series Delta Force and Counter-Strike 2 experience FPS regression from 4080S to 5080 as shown in Hardware Unboxed's 5080 review. In the same review TLOU and Spiderman manage atrocious 0% gains for 5080 vs 4080S at 1440p. The result of that is that when using upscalers the performance gains of 50 vs 40 series tank. And remember upscaling is almost mandatory for heavy RT games a key selling for NVIDIA graphics cards. But the worst example yet is probably TechPowerUp's Elden Ring ray tracing performance at 1080p where the 5080 trails even the 4070 Super, available >here<. In TechPowerUp's review Elden Ring at native 1080p both 5090 and 5080 fail with 5-8 FPS regression vs the 4090 and 4080S.

But the most odd thing so far has been that RT performance uplift was consistently worse than raster uplift in nearly every single 5080 review. This is clearly shown in the TechPowerUp review, available >here< where in the majority of games 5080 and 5090 saw larger penalties from turning on RT than equivalent 40 series cards.

Then there's the obvious lack of support for a ton of professional and AI applications where reviewers had to wait for an update adding Blackwell support, but that obviously didn't happen, not even a week later when the 5080 launched. IDK if this is just me but I don't recall this level of incompatability with professional applications for any of the previous launches (20-40 series), isn't it unprecedented for an NVIDIA generation?

And when applications work their performance is sometimes broken resulting in a 5090 loosing to even a RTX 4080. Just watch some of the professional workload centric reviews and you'll see how bad it is.

The most insane performance degradation I've seen is outside of professional workloads is the testing by Guru3D with 3D Mark ray tracing, available >here<. When testing the 5080 in 3D Mark Hybrid ray tracing benchmark they observed a 21% lead over the 4080S. But when they ran the full path tracing benchmark the 5080 was now 31% slower than the 4080S and could only match a 4070 Super. The 5090 has the same issue although to a lesser degree showing a lead vs the 4090 of 45% (Hybrid RT) vs 24% (Full PT).

The Possible Culprit

Thanks to NVIDIA's Blackwell GPU Architecture Whitepaper we might have a likely culprit, although it's likely it's not the only one, although probably still the most significant. The new AI Management Processor is in fact much more than just an AI workload scheduler:

"The AI Management Processor (AMP) is a fully programmable context scheduler on the GPU designed to offload scheduling of GPU contexts from the system CPU. AMP enhances the scheduling of GPU contexts in Windows to more efficiently manage different workloads running on the GPU. A GPU context encapsulates all the state information the GPU needs to execute one or more tasks."

"The AI Management Processor is implemented using a dedicated RISC-V processor located at the front of the GPU pipeline, and it provides faster scheduling of GPU contexts with lower latency than prior CPU-driven methods. The Blackwell AMP scheduling architecture matches the Microsoft architectural model that describes a configurable scheduling core on the GPU through Windows Hardware-Accelerated GPU Scheduling (HAGS), introduced in Windows 10 (May 2020 Update)."

AMP is a direct on-die RISC-V CPU context scheduler with extremely low latency and high bandwidth access to the Gigathread Engine. It sits in front of Gigathread engine and offloads context scheduling from the CPU and taps into Hardware Accelerated GPU Scheduling (HAGS) supported in Windows 10 and 11. This tight cointegration is crucial for MFG, neural rendering and LLM integration into video games, and beneficial to multitasking, content creation, and existing gaming experiences. It doesn't just magically work as intended and requires a proper code implementation and can be a double edged sword (more on that later).

Doing the largest redesign of the GPU wide frontend (not GPC level) since Fermi introduced the Gigathread Engine in 2010 without significant game and/or driver code rewrites is asking for trouble. On 40 series and prior the CPU communicated directly with the Gigathread Engine. But on 50 series, assuming no code rewrites, the CPU has to communicate to the Gigathread Engine through the AMP which adds significant latency and scheduling overhead or either partially or completely breaks scheduling. This results in severe performance degradation without code rewrites as seen with Elden Ring RT and 3D Mark Path tracing. It's also not surprising that when implementing a change this profound some applications just straight up refuse to work.

There's a Twitter post by "Osvaldo Pinali Doederlein" on AMP, where people are discussing why AMP could be causing Blackwell's inconsistent performance and how big the performance impact of Blackwell's new CPU -> AMP -> Gigathread scheduler paradigm is without code rewrites. Psst it's likely -10 to -20%.

The 5090 also seems to have worsened memory and SRAM latencies and L1 bandwidth regression vs the 4090 as reported by "harukaze5719" on Twitter. This is unrelated but could in some instances explain some of the 5090’s performance degradation (vs mean uplift).

(Conclusion): It's too early pass definitively judgment on Blackwell's performance issues, what's causing them, how likely the issues are to be either software and/or hardware related, and if they can even be fixed. With that said there's clearly a lot wrong and the issue spans across many games and many different types of compute and AI applications.

Getting 5080 gaming uplifts anywhere from sub -20% (Elden ring RT 1080p) to +40% (CB2077 HW Canucks 5080 Review) is unprecendented for an NVIDIA launch. NVIDIA Blackwell has severe performance inconsistencies and is reminiscent of ARC Battlemage. This shouldn't be dismissed as node stagnation or something to be expected. No there's clearly something wrong a fundamental level, which could be either a hardware flaw, broken software or a combination of both.

Hopefully NVIDIA can iron out the issues and improve Blackwell's overall performance and consistency over time, and improve it enough to deter AMD from doing something really stupid with RDNA 4's pricing.

Techpowerupissa AMP:stä:

The AI management processor (AMP) is what enables simultaneous AI and graphics workloads at the highest levels of the GPU, so it could be simultaneously rendering real time graphics for a game, while running an LLM, without either affecting the performance of the other. AMP is a specialized hardware scheduler for all the AI acceleration resources on the silicon.

Itse suhtaudun asiaan positiivisesti, että ajuri- ja softapätseillä asia kyllä korjaantuu ja suorituskyky paranee. Ei suorituskyky nytkään siis huono ole.

Näin käy kun ei ole uutta pienempää prosessia. Transistorien määrät aikasemmin kasvaneet, nyt ne tippui reilusti.Tuosta oli myös Paul's Hardware tehnyt videon, ja sinne taulukon joka mielestäni aika hyvin havainnollistaa eron edellisiin sukupolviin.

1080ti -> 2080 + 15%

2080ti -> 3080 + 52%

3090ti -> 4080 + 62%

4090 -> 5080 - 41%

edit: korjasin mallit oikein

Viimeksi muokattu:

finWeazel

Chief Karpfen - ruoKalan C&R

- Liittynyt

- 15.12.2019

- Viestejä

- 9 735

Kun miettii miksi ei 3nm niin tiedetään että io ja sram ei skaalannu juurikaan pienemmäksi.

GB202(5090) die shottia kun katsoo niin jos olisi halunnut tehdä 3nm:lla 512bit väyläisen piirin niin sen pitäisi olla yhtä iso kuin nykyinen GB202. Reunoilla olevat gddr7 muistiohjaimet eivät skaalannu pienemmäksi 3nm:ia käytettäessä.

Keskellä oleva iso cache ja gpc:eissä olevat pienemmät cachet eivät myöskään skaalaannu pienemmäksi. Aika pieni osa piiristä hyötyisi 3nm:sta. 3nm versio gb202:sta ei olisi mitenkään älyttömän paljon nopeampi, mutta hinta pompsahtaisi kuuhun. Ollaan ihan oikeasti pisteessä missä kuluttajahintaisissa laitteissa mooren laki on kuollut. Tarvitaan uusia temppuja, että saadan tehtyä yhä nopeampi kuluttajahintaisia pelikortteja.

imho. nvidia kaivoi ihan hyvän jäniksen dlss4:en paljon paremmasta kuvanlaadusta ja megageometriasta. Megageometria parantaa ilmeisesti aika hyvin suorituskykyä eilen julkaistussa alan wake2 patchissa samalla kun muistinkulutus ja cpu:n käyttöaste laskee. Fine wine kun dlss4, mega geometria jne. toimii kaikilla rtx korteilla.

Ei tietenkään tämän päivän peleissä näy mutta 50x0 sarjan triangle clusterit säteenseurannassa on kova juttu. Ne mahdollistavat about 100x nopeamman bvh-puun rakentamisen mikä helpottaa pelinkehittäjien elämää ja parantaa kuvanlaatua(lod, tiheä geometria jne. säteenseurannassa.

GB202(5090) die shottia kun katsoo niin jos olisi halunnut tehdä 3nm:lla 512bit väyläisen piirin niin sen pitäisi olla yhtä iso kuin nykyinen GB202. Reunoilla olevat gddr7 muistiohjaimet eivät skaalannu pienemmäksi 3nm:ia käytettäessä.

Keskellä oleva iso cache ja gpc:eissä olevat pienemmät cachet eivät myöskään skaalaannu pienemmäksi. Aika pieni osa piiristä hyötyisi 3nm:sta. 3nm versio gb202:sta ei olisi mitenkään älyttömän paljon nopeampi, mutta hinta pompsahtaisi kuuhun. Ollaan ihan oikeasti pisteessä missä kuluttajahintaisissa laitteissa mooren laki on kuollut. Tarvitaan uusia temppuja, että saadan tehtyä yhä nopeampi kuluttajahintaisia pelikortteja.

imho. nvidia kaivoi ihan hyvän jäniksen dlss4:en paljon paremmasta kuvanlaadusta ja megageometriasta. Megageometria parantaa ilmeisesti aika hyvin suorituskykyä eilen julkaistussa alan wake2 patchissa samalla kun muistinkulutus ja cpu:n käyttöaste laskee. Fine wine kun dlss4, mega geometria jne. toimii kaikilla rtx korteilla.

Ei tietenkään tämän päivän peleissä näy mutta 50x0 sarjan triangle clusterit säteenseurannassa on kova juttu. Ne mahdollistavat about 100x nopeamman bvh-puun rakentamisen mikä helpottaa pelinkehittäjien elämää ja parantaa kuvanlaatua(lod, tiheä geometria jne. säteenseurannassa.

No toki jos tilanne on tuo, että laskemalla hieman säteenseurantaa saat pelin pyörimään siellä >100fps, mutta ei tuohon taida RTX 5080:llä päästä monessakaan pelissä 4K:lla asetukset tapissa DLSS balancedilla.Miksei? Onhan esim. DLSS performancen käyttäminenkin asetuksen laskemista. Ei millään kortilla voi ajaa natiivia 4K kaikki herkut (Path tracing) päällä, oli FG:tä tai ei. Vähintään DLSS pitää olla, jossain siellä performance-tasolla.

Mutta jos joku haluaa pelata oikein sulavalla 240 FPS yksinpeliä, ja tämä vaatii vaikka PT:n pudottamista RT Ultra tasolle, niin en näe miksi tätä ei kannattaisi FG:n kanssa tehdä.

FPS-puristina yllätyin hieman, että 1x FG:llä saavutettu noin 110-120fps yksinpeliräiskinnässä on pienen totuttelun jälkeen vielä kohtalaisen hyvin pelattavissa. 5000-sarjalaisella melko hyväksi lähtötasoksi voisi tähdätä 80 fps + 2x FG -> 240 hieman nopeampaan yksinpeliräiskintään ja 60 fps + 3x FG -> 240 hitaampiin peleihin. Asetukset tarvittaessa hieman alle tappiin ja DLSS performanceen, mikä transformerilla näyttääkin jo yllättävän hyvältä.No toki jos tilanne on tuo, että laskemalla hieman säteenseurantaa saat pelin pyörimään siellä >100fps, mutta ei tuohon taida RTX 5080:llä päästä monessakaan pelissä 4K:lla asetukset tapissa DLSS balancedilla.

Harmittavasti menee 4090:llä 240hz 4K potentiaalia rutkasti hukkaan, frame genillä pääsee monesti vain johonkin 120-180 pintaan pelistä riippuen. Multiframe gen olisi poikaa. Aivan kuin olisin jostain lukenut että Nvidia vihjasi sen saattavan olevan tulevaisuudessa mahdollista myös 4000-sarjalle?

Uutiset

-

Live: io-techin Tekniikkapodcast (5/2025)

31.1.2025 12:24

-

NVIDIA App -hallintasovelluksen uusi versio sai DLSS-säätöjä ja muita uusia ominaisuuksia

31.1.2025 04:55

-

NVIDIA julkaisi uudet GeForce- ja Studio 572.16 -ajurit näytönohjaimilleen

31.1.2025 04:10

-

Uusi artikkeli: Testissä NVIDIA GeForce RTX 5080 Founders Edition

29.1.2025 17:33

-

NZXT julkaisi uudet Elite-versiot oheislaitteistaan

29.1.2025 04:52

Uutisia lyhyesti

-

-

-

Asus vastaa kritiikkiin Q-Release Slim -lukitusmekanismin ongelmista

- Kaotik

- Vastauksia: 1

-

AMD julkaisi ohjeet DeepSeek R1 -kielimallin ajoon paikallisesti

- Kaotik

- Vastauksia: 16