- Liittynyt

- 14.10.2016

- Viestejä

- 21 543

Kaotik kirjoitti uutisen/artikkelin:

NVIDIA on julkaissut ensimmäiset kolme GeForce RTX 30 -sarjan näytönohjainta ja saanut niistä myyntiin asti RTX 3080 10 Gt:n ja RTX 3090:n. Gigabyten verkkosivuille lipsahtaneet tiedot kuitenkin vihjasivat yhtiöllä olevan valmisteilla pitkä liuta muitakin RTX 30 -sarjan näytönohjaimia. Myös NVIDIAn oma whitepaper-julkaisu viittaa RTX 3080 -malliin nimenomaan 10 Gt:n versiona, mikä on kyseisissä julkaisuissa poikkeuksellista.

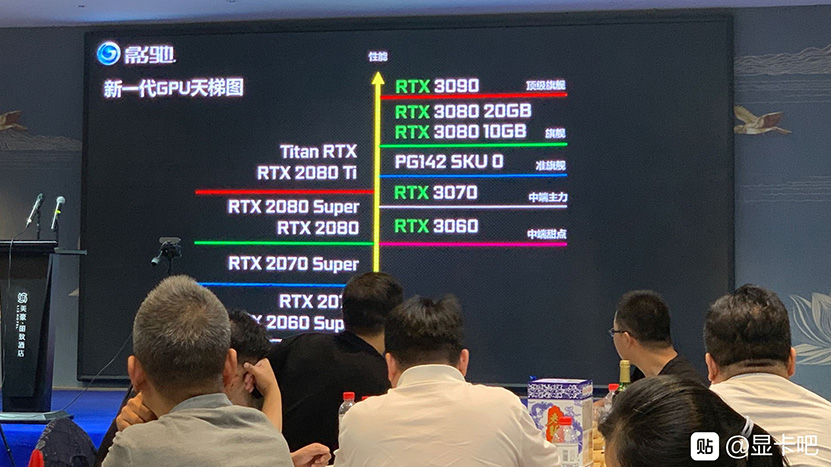

Nyt nettiin on vuotanut Galaxin tapahtumassa esitelty diagrammi, jossa on esillä jo julkaistujen näytönohjainten lisäksi kolme vielä julkaisematonta RTX 30 -sarjan jäsentä. Galaxin diassa RTX 30 -sarjan näytönohjaimet on asetettu rinnakkain RTX 20 -sarjan mallien kanssa suhteessa niiden suorituskykyyn.

Dian mukaan GeForce RTX 3070 tulisi jäämään jonkin verran jälkeen GeForce RTX 2080 Ti:stä, vaikka NVIDIA ehtikin jo mainostaa niiden olevan yhtä nopeita. Todennäköisesti NVIDIAn lupaus suorituskyvystä perustuikin vain Minecraft RTX- ja Quake II RTX -suorituskykyyn, kuten lupaus 3080:n kaksinkertaisesta nopeudesta RTX 2080:een nähden.

RTX 3070:n suorituskyvyn lisäksi taulukossa on kuitenkin myös mielenkiintoisia yksityiskohtia. GeForce RTX 3080:sta on listattu 10 Gt:n lisäksi myös 20 Gt:n versio, kuten odotettua, jonka lisäksi RTX 3080:n ja RTX 3070:n väliin on mahtumassa ”PG142 SKU 0”, josta ei ole vielä tarkempaa tietoa. Pakan pohjimmaiseksi listataan RTX 3060, joka tarjoaisi vastaavaa suorituskykyä, kuin GeForce RTX 2080.

Lähde: HXL @ Twitter

Linkki alkuperäiseen juttuun

Viimeksi muokattu: