- Liittynyt

- 18.10.2016

- Viestejä

- 4 699

Muistisplitti menee eri tavalla eri konsoleilla. XSX:llä jako on 10GB VRAM tai "GPU Optimized" memory ja 6GB general purpose memory. GP:stä 2.5GB menee käyttikselle ja 3.5GB peleille. Käytännössä kuitenkin nopeuserosta johtuen "VRAM käyttö" ei voi realistisesti kasvaa yli tuon 10GB rajan, sen sijaan pelit voivat joutua kasvamaan VRAM:n puolelle ja syömään tuota 10GB lohkoa. Täten siis maksimi realistisesti käytettävissä oleva VRAM olisi 10GB, mutta käytännössä se tulee menemään alle tuon koska tuo 3.5GB ei mitenkään tule riittämään kaikille peleille.Mä olen järkyttynyt jos tuo 10gb riittää edes 2 vuotta. Uusilla konsoleilla on nyt 16gb josta 4 on OS ja 10+2 käytännössä peleille, joten pelit optimoidaan tuon mukaan, tämä jo on semmonen asia joka takaa että 10gb ei tule riittämään loputtomiin.

PS5:lla ei ole tällaista jakoa vaan on vain yksi muisti joka on hitaampi kuin Xbox:n GPU Optimized ja nopeampi kuin GP. Ongelma on kuitenkin sama kun 16GB "kynttilää" yritetään polttaa molemmista päistä. Jokatapauksessa 3080 muisti on selvästi nopeampi kuin mikään kummankaan konsolin muisteista eikä noilla tule olemaan mitään saumaa 16/32GB RAM + RTX 3080 PC:tä vastaan pelisuorituskyvyssä.

Ymmärrätkö nyt ihan mistä puhut? Mitä tarkoittaa ylipäätään 1080p pelaaminen tai 4K pelaaminen tai "riittäminen"? Nuo on vain buzzwordeja joilla sivutetaan se että valitun renderöintiresoluution suorituskyky on riippuvainen kaikista muista asetuksista ja peleistä mitä pelataan. Miksi ylipäätään päivittää vanhasta kunnon 760:sta kun silläkin voi "pelata ihan hyvin" 1080p:llä tai vaikka Voodoo 5:sta?Kun puhutaan 5 vuotta niin lyön pääni pantiksi että ei riitä ellet pelaa 1080p, ja jos pelaat niin miks hankkia edes 3080 kun 1000 sarjasetki jaksaa hyvin 1080p.

Tai sitten ei. Tähän toki vielä DLSS ja RTX IO päälle niin tuskin realistisesti tullaa koko kortin elinkaaren aikana näkemään pullonkaulaa VRAM:n kohdalla tai ainakaan sitä ensimmäistä.Tällä hetkellä ihan uusimissa peleissä ja todn tulevat ns Triple A games 1-2 vuoden sisällä käyttävät about tuon 10gb jos pelaat 4k resollta tai ehkä jopa 1440p Ultrawide.

Edes tällä hetkellä mikään kortti ei kykene pyörittämään uusimpia top pelejä nupit kaakossa (Cyberpunk) eikä ole VRAM:sta kiinni joten siinä vaiheessa kun VRAM loppuu jos ikinä on "nupit kaakossa" aivan turha tavoite jo muutenkin.Kyllä toi 3080 VRAM määrä ajaa asiansa 2 vuotta kaikki nupit kaakossa, sen jälkeen en enään pidättäis henkeäni...

Eikä tämäkään pidä paikkansa.Tällä hetkellä tosin ainoo joka oikeesti käyttää eik' vain "allocate" tuon koko 10 GB ja vähä yli on Watch Dogs Legion 4k kaikki täysillä ja Ray Tracing.

MSI Afterburner can now display per process VRAM!

RT eats RAM because it adds BVHs to the mix and these can be huge. DLSS renders in lower resolution than your output resolution and this saves VRAM on render targets / frame buffers - but it won't be the same as rendering in the same native resolution because DLSS uses textures and MIPs for the...

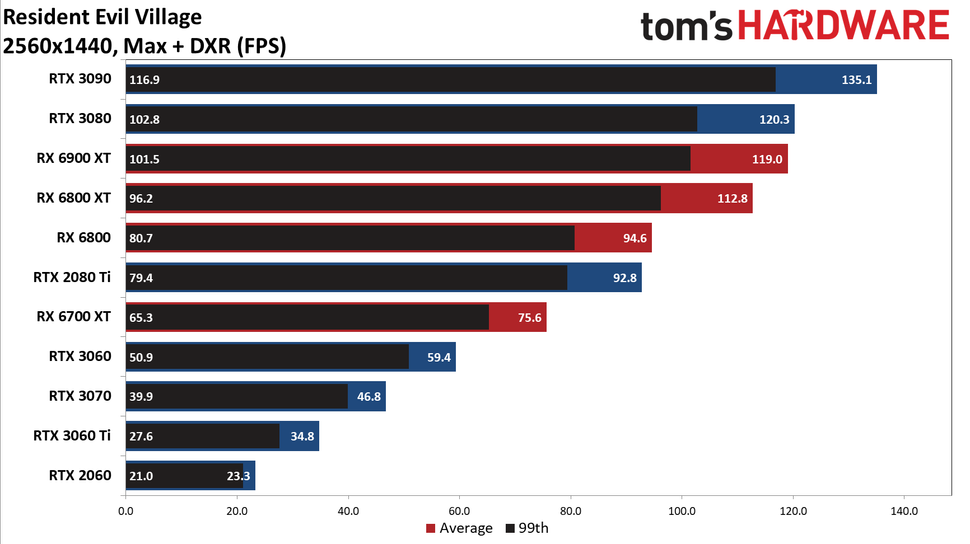

On muutenkin hiukan huvittavaa tutkia 3080 VRAM käyttöä RTX päällä jos vertaillaan konsoleihin tai AMD näyttiksiin kun näiden RT-suorituskyky on aivan käyttökelvottomalla tasolla. Edes teoreettisella VRAM loppumisella ei olisi mitään merkitystä siihen nähden jos näille vastineille asetetaisiin samat RT ja FPS vaatimukset.