Mitkä ajurit? Voisitko olla spesifimpi. Itse en kokemusasiantuntijana ole mitään huomannut koskaan.Asiaperäisesti noi radeonin ajurit on ihan täyttä shaibaa

-

PikanavigaatioAjankohtaista io-tech.fi uutiset Uutisia lyhyesti Muu uutiskeskustelu io-tech.fi artikkelit io-techin Youtube-videot Palaute, tiedotukset ja arvonnat

Tietotekniikka Prosessorit, ylikellotus, emolevyt ja muistit Näytönohjaimet Tallennus Kotelot ja virtalähteet Jäähdytys Konepaketit Kannettavat tietokoneet Buildit, setupit, kotelomodifikaatiot & DIY Oheislaitteet ja muut PC-komponentit

Tekniikkakeskustelut Ongelmat Yleinen rautakeskustelu Älypuhelimet, tabletit, älykellot ja muu mobiili Viihde-elektroniikka, audio ja kamerat Elektroniikka, rakentelu ja muut DIY-projektit Internet, tietoliikenne ja tietoturva Käyttäjien omat tuotetestit

Softakeskustelut Pelit, PC-pelaaminen ja pelikonsolit Ohjelmointi, pelikehitys ja muu sovelluskehitys Yleinen ohjelmistokeskustelu Testiohjelmat ja -tulokset

Muut keskustelut Autot ja liikenne Urheilu TV- & nettisarjat, elokuvat ja musiikki Ruoka & juoma Koti ja asuminen Yleistä keskustelua Politiikka ja yhteiskunta Hyvät tarjoukset Tekniikkatarjoukset Pelitarjoukset Ruoka- ja taloustarviketarjoukset Muut tarjoukset

Kauppa-alue

Navigation

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Huomio: This feature may not be available in some browsers.

Lisää vaihtoehtoja

Tyylin valinta

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Virallinen: NVIDIA vs AMD (vs Intel) keskustelu- ja väittelyketju

- Keskustelun aloittaja Sampsa

- Aloitettu

- Liittynyt

- 21.10.2016

- Viestejä

- 145

TsiigasinMitkä ajurit? Voisitko olla spesifimpi. Itse en kokemusasiantuntijana ole mitään huomannut koskaan.

Ja ongelmaketkusta et ihan kuraa on.

Hokasikko pointin.

oisqi

Rajat "VegaGOD" Monga ♿️

- Liittynyt

- 17.10.2016

- Viestejä

- 440

Lähinnä, kun viestien sävy on ”tekniikka on täysin käyttökelvoton koska artifaktit” ja on jo valmiiksi dumattu täysin paskaksi (ei siis vain keskustella mahdollisista ongelmista, vaan valmiiksi jo tehty mielipide) vaikka ei ole mitään kokemusta käytännössä. Hienosti poterouduttu omiin mielipiteisiin ja anti keskustelulle on siinä vaiheessa melko heikkoa.Miksi pitäisi olla ”kokemusasiantuntija” jotta voisi keskustella asioista asiaperäisesti?

- Liittynyt

- 15.11.2016

- Viestejä

- 119

Itseäni kyllä kiinnostaa AMD:n seuraava julkaisu. Nvidia toi juuri markkinoille (paperijulkaisu) tappiinsa asti kellotetut kortit pienillä muisteilla. Hintaa hilattu alas tekemällä korteista muistirajoitteisia. Nurkan takana odottaa 20GB 3080 ja 16GB 3070. Ehkä Nvidia on ottanut oppia 1080ti ajoilta, jolloin julkaisivat AMD peloissaan liian tehokkaan kortin markkinoille ja nyt tunnustelevat jäätä näillä korteilla, jotka ovat oletusarvoisesti liian pienillä muisteilla. Jos AMD tuo markkinoille järkevään hintaan tehokkaan ja isolla muistilla varustetun kortin, Nvidian on pakko julkaista 3080 ja 3070 malleista isommalla muistilla olevat versiot. Mikäli AMD pitää hinnan alhaalla, Nvidian uudet kortit ilman muistirajoituksia tulevat olemaan hinnaltaan järkeviä. Näin ollen en itse uskaltaisi ostaa Nvidian näyttistä atm, koska muistirampautetut kortit tulevat katoamaan markkinoilta ennemmin tai myöhemmin.

- Liittynyt

- 12.12.2016

- Viestejä

- 4 950

Itseäni kyllä kiinnostaa AMD:n seuraava julkaisu. Nvidia toi juuri markkinoille (paperijulkaisu) tappiinsa asti kellotetut kortit pienillä muisteilla.

Eipä ollut paperijulkaisu, tai sitten kaikki uuden arkkitehtuurin julkaisut ovat olleet paperijulkaisuja.

Gamers nexus selvitti asiaa ja nVidian oma lausunto oli että kortteja toimitettiin "saman verran kuin yleensäkin julkaisussa" ja AIB:t kommentoivat myös, että ne ovat saaneet piirejä ennen julkaisua saman verran kuin RTX 2000-sarjan kanssa pari vuotta sitten.

Nyt vaan on ollut historina kovin kysyntä uudella näyttissukupolvella ja kun normaalistikin kortit loppuvat muutamaksi päiväksi - viikoksi alun ostoryntäyksessä niin nyt tilanne on se, että ne ovat loppu useamman viikon.

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Mitä sää sillä muistilla teet, kaistaa ja raakaa tehoa sä tarttet.Itseäni kyllä kiinnostaa AMD:n seuraava julkaisu. Nvidia toi juuri markkinoille (paperijulkaisu) tappiinsa asti kellotetut kortit pienillä muisteilla. Hintaa hilattu alas tekemällä korteista muistirajoitteisia. Nurkan takana odottaa 20GB 3080 ja 16GB 3070. Ehkä Nvidia on ottanut oppia 1080ti ajoilta, jolloin julkaisivat AMD peloissaan liian tehokkaan kortin markkinoille ja nyt tunnustelevat jäätä näillä korteilla, jotka ovat oletusarvoisesti liian pienillä muisteilla. Jos AMD tuo markkinoille järkevään hintaan tehokkaan ja isolla muistilla varustetun kortin, Nvidian on pakko julkaista 3080 ja 3070 malleista isommalla muistilla olevat versiot. Mikäli AMD pitää hinnan alhaalla, Nvidian uudet kortit ilman muistirajoituksia tulevat olemaan hinnaltaan järkeviä. Näin ollen en itse uskaltaisi ostaa Nvidian näyttistä atm, koska muistirampautetut kortit tulevat katoamaan markkinoilta ennemmin tai myöhemmin.

bahis

Tukijäsen

- Liittynyt

- 06.03.2019

- Viestejä

- 4 127

Kyllä se 10GB riittää vielä pitkäksi aikaa jos ei 4k resolla pelaa. Ja tällä hetkellä 4K:lle riittää myös.Mitä sää sillä muistilla teet, kaistaa ja raakaa tehoa sä tarttet.

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Näimpä, sithän sen näkee kun huippumallit tulee isommalla muistilla. Hintaerokin voi olla sitä luokkaa, että sama päivittää joskus tulevaisuudessa tarpeeseen. Ja silloin voi olla jo muutenkin näpäkämpää tarjolla.Kyllä se 10GB riittää vielä pitkäksi aikaa jos ei 4k resolla pelaa. Ja tällä hetkellä 4K:lle riittää myös.

- Liittynyt

- 15.11.2016

- Viestejä

- 119

En varmaan mitään. Hassua vaan on se, että jos AMD tuo markkinoille 16GB kortit niin Nvidian on pakko reagoida. Sitten kun näiden "parempien" korttien muistit on min. 16GB, niin se määrittää uuden normin markkinoille. Veikkaan, että 10GB 3080 kohtalo on sama kuin 2080ti korttien. Tosin sillä erotuksella, että 2080ti piti arvonsa hyvin 2 vuotta.Mitä sää sillä muistilla teet, kaistaa ja raakaa tehoa sä tarttet.

oisqi

Rajat "VegaGOD" Monga ♿️

- Liittynyt

- 17.10.2016

- Viestejä

- 440

Entä jos AMD:n kortti ei yllä tehoissa lähellekään 3080:kymppistä?En varmaan mitään. Hassua vaan on se, että jos AMD tuo markkinoille 16GB kortit niin Nvidian on pakko reagoida. Sitten kun näiden "parempien" korttien muistit on min. 16GB, niin se määrittää uuden normin markkinoille. Veikkaan, että 10GB 3080 kohtalo on sama kuin 2080ti korttien. Tosin sillä erotuksella, että 2080ti piti arvonsa hyvin 2 vuotta.

- Liittynyt

- 15.11.2016

- Viestejä

- 119

Juuri siksi Nvidia julkaisi nämä muistirammat. Ei tarvi edes julkaista 20GB versiota, jos AMD sössii big navinsaEntä jos AMD:n kortti ei yllä tehoissa lähellekään 3080:kymppistä?

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Eiköhän noi ole ihan aikataulutettu noin, aina tulee piristetty malli.En varmaan mitään. Hassua vaan on se, että jos AMD tuo markkinoille 16GB kortit niin Nvidian on pakko reagoida. Sitten kun näiden "parempien" korttien muistit on min. 16GB, niin se määrittää uuden normin markkinoille. Veikkaan, että 10GB 3080 kohtalo on sama kuin 2080ti korttien. Tosin sillä erotuksella, että 2080ti piti arvonsa hyvin 2 vuotta.

Tai sitten vaihtoehtoisesti GA102 on Samsungin prosessilla halpaa kuin saippua ja kapasiteettia on tarjolla niin paljon, että on kannattavampaa myydä kortteja useammalle asiakkaalle halvemmalla, kuin kaupata sille 1% (RTX 2080 Ti osuus Steam Hardware Surveyssa) varakkaimmista PC-pelaajista?Juuri siksi Nvidia julkaisi nämä muistirammat. Ei tarvi edes julkaista 20GB versiota, jos AMD sössii big navinsa. Nvidian käyttäytymisestä kumminkin voimme päätellä, että AMD:ltä voi tulla jotain järkevää ulos. Jos Nvidia olisi 100% varma, että AMD ei pysty vastaamaan kilpailuun, 10GB 3080 olisi hinnaltaan 1200-1300e.

- Liittynyt

- 15.11.2016

- Viestejä

- 119

Epäilen vahvasti. Ja ei ne 750-1000e korttien omistajatkaan ole mikään massa steamissä. Kuuluvat siihen samaan varakkaiden pelaajien pieneen ryhmään.Tai sitten vaihtoehtoisesti GA102 on Samsungin prosessilla halpaa kuin saippua ja kapasiteettia on tarjolla niin paljon, että on kannattavampaa myydä kortteja useammalle asiakkaalle halvemmalla, kuin kaupata sille 1% (RTX 2080 Ti osuus Steam Hardware Surveyssa) varakkaimmista PC-pelaajista?

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Tuleehan sieltä muutakin. Täs mää kehittämässä uutta arkkitehtuuria minimi parannuksin, jolloin myynnitkin on pienempiä, kun ei tule sitä tarvetta päivittää.Epäilen vahvasti. Ja ei ne 750-1000e korttien omistajatkaan ole mikään massa steamissä. Kuuluvat siihen samaan varakkaiden pelaajien pieneen ryhmään.

Nyt on mihin päivittää ja varmasti kauppa käy.

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Asiaperäisesti noi radeonin ajurit on ihan täyttä shaibaa

Ja mun mielestä noi nvidian ajurit on ihan täyttä shaibaa

Tsiigasin https://www.amd.com/en/support/kb/release-notes/rn-rad-win-20-7-2

https://www.amd.com/en/support/kb/release-notes/rn-rad-win-20-7-2

Ja ongelmaketkusta et ihan kuraa on.

Hokasikko pointin.

Mä tsiigazin kanssa https://us.download.nvidia.com/Windows/456.38/456.38-win10-win8-win7-release-notes.pdf

Hirmu lista ongelmia eli täyttä kuraa on.

Hokasitko pointin?

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Sä et tajuuJa mun mielestä noi nvidian ajurit on ihan täyttä shaibaa

Mä tsiigazin kanssa https://us.download.nvidia.com/Windows/456.38/456.38-win10-win8-win7-release-notes.pdf

Hirmu lista ongelmia eli täyttä kuraa on.

Hokasitko pointin?

- Liittynyt

- 21.06.2017

- Viestejä

- 7 562

Sä et tajuu

Kyllä se on joku muu joka ei tajuu. Mitään muuta et ole tehnyt kuin räksyttänyt miten sontaa AMD:n ajurit on, muttet ole onnistunut mitenkään todistamaan että näin on. Linkkaat jotain ajuririen muutos logeja ja senkin feilaat niin että linkattu ajuri on jo pari kuukautta vanha.

Todennäköisesti et edes omaa mitään kokemusta AMD:n ajureista vaan louskutat täällä ihan vain huvikseen. Itse voin sanoa että ei ole mitään kokemusta nvidian ajureista yli 10v joten en ota kantaa miten ne toimii mutta jos käytetään ajurien muutoslogeja todistelun pohjana niin voidaan todeta että ongelmattomia ajureita ei ole kummallakaan.

- Liittynyt

- 21.10.2016

- Viestejä

- 145

Provoilu / nollapostaukset

Kiitos.Kyllä se on joku muu joka ei tajuu. Mitään muuta et ole tehnyt kuin räksyttänyt miten sontaa AMD:n ajurit on, muttet ole onnistunut mitenkään todistamaan että näin on. Linkkaat jotain ajuririen muutos logeja ja senkin feilaat niin että linkattu ajuri on jo pari kuukautta vanha.

Todennäköisesti et edes omaa mitään kokemusta AMD:n ajureista vaan louskutat täällä ihan vain huvikseen. Itse voin sanoa että ei ole mitään kokemusta nvidian ajureista yli 10v joten en ota kantaa miten ne toimii mutta jos käytetään ajurien muutoslogeja todistelun pohjana niin voidaan todeta että ongelmattomia ajureita ei ole kummallakaan.

AMD:n ajureissa ongelmat ovat olleet lähinnä että ne kannattaa poistaa erillisellä sovelluksella turvamoodissa. Tuntuvat jättävän jonkin verran tauhkaa jälkeensä.

Itse toimivuudessa ei itselläni vanhemmilla korteilla ole ollut AMD:llä ongelmaa. Jos 1060 ja 290x kortteja vertaa niin NVIDIAn väri ja resoluutio tiedot ei tahdo toimia vahvistimen läpi oikein. Resoluutiota pitää skaalata kun koko kuva ei mahdu ruudulle (vahvistimeen 1080p -> 4k telkkarille) eli se jostain syystä sössii jonkun kuvatiedon joten resoluutiota pitää erikseen manuaalisesti säätää hivenen pienemmäksi. Sen lisäksi HDR ei toimi oikein, eli jos se asettaa windowssissa päälle niin Steam sovellus ja videotiedostot ovat todella haalealla vaikka pelit toimivat ok. Vaikka värimoodin asettaa käsin niin silti suspendista kun herätään niin vahvistimen kautta ruutu pysyy pimeänä silloin tällöin. Pääsääntöisesti homma toimii kun koneen buuttaa kokonaan alusta asti käyntiin, mutta olohuonekoneessa tuo turhaa säätöä.

290x kortilla ei ole mitään näistä ongelmista, vaan värimäärityksen ja bittisyyden valinta pysyy, ruutu on koko ruudulla (ja skaalaus toimii oikein ) ja ruutu herää suspendin jälkeen aina oikein.

Vahvasti omien kokemusten mukaan AMD:n ajurit ovat siis paremmat. Siksi näissä ajurikysymyksiä kun käydään läpi niin aina muistetaan haukkua AMD:n ajureita. Jos jossain on ongelmaa ne ovat lähinnä pienestä markkinaosuudesta osittain johtuvia (NVIDIA on se kortti jota vastaan kortit testataan), ajurien uusien ominaisuuksien tuonnissa (ongelmarypäs XT korteilla johtui pitkälle tuosta) ja siitä että ajureista saattaa jäädä vanhaa tauhkaa jäljelle (siksi ddu tapaiset työkalut ovat tarpeen vaikka näin ei tietty pitäisi olla). Sanalla sanoen resurssiongelmia ollut.

Itse toimivuudessa ei itselläni vanhemmilla korteilla ole ollut AMD:llä ongelmaa. Jos 1060 ja 290x kortteja vertaa niin NVIDIAn väri ja resoluutio tiedot ei tahdo toimia vahvistimen läpi oikein. Resoluutiota pitää skaalata kun koko kuva ei mahdu ruudulle (vahvistimeen 1080p -> 4k telkkarille) eli se jostain syystä sössii jonkun kuvatiedon joten resoluutiota pitää erikseen manuaalisesti säätää hivenen pienemmäksi. Sen lisäksi HDR ei toimi oikein, eli jos se asettaa windowssissa päälle niin Steam sovellus ja videotiedostot ovat todella haalealla vaikka pelit toimivat ok. Vaikka värimoodin asettaa käsin niin silti suspendista kun herätään niin vahvistimen kautta ruutu pysyy pimeänä silloin tällöin. Pääsääntöisesti homma toimii kun koneen buuttaa kokonaan alusta asti käyntiin, mutta olohuonekoneessa tuo turhaa säätöä.

290x kortilla ei ole mitään näistä ongelmista, vaan värimäärityksen ja bittisyyden valinta pysyy, ruutu on koko ruudulla (ja skaalaus toimii oikein ) ja ruutu herää suspendin jälkeen aina oikein.

Vahvasti omien kokemusten mukaan AMD:n ajurit ovat siis paremmat. Siksi näissä ajurikysymyksiä kun käydään läpi niin aina muistetaan haukkua AMD:n ajureita. Jos jossain on ongelmaa ne ovat lähinnä pienestä markkinaosuudesta osittain johtuvia (NVIDIA on se kortti jota vastaan kortit testataan), ajurien uusien ominaisuuksien tuonnissa (ongelmarypäs XT korteilla johtui pitkälle tuosta) ja siitä että ajureista saattaa jäädä vanhaa tauhkaa jäljelle (siksi ddu tapaiset työkalut ovat tarpeen vaikka näin ei tietty pitäisi olla). Sanalla sanoen resurssiongelmia ollut.

Tuossa on sulla sellainen massiivinen ajatusvirhe, että oletat energiatehokkuuden olevan sama, kun säteenjäljitystä tehdään dedikoiduilla yksiköillä, kuin mitä se olisi shadereilla tehdessä.AMD:n RT voi olla ihan vertailukelpoista koska novideolla RT kun otetaan käyttöön niin se on heti pois shader tehoista koska RT-coret ja Tensor-coret on riippuvaisia siitä virtabudjetista joka kortilla on. Eli heti kun aletaan rouskuttaa RT-coreilla, niin shader teho tippuu. Ja siihen kun lisätään Tensor-coret niin shader teho tippuu entisestään.

En muista mikä saitti se oli joka tätä oli testannut, mutta 3080 hörppäsi 320W ilman RT ja DLSS, kun heitettiin RT päälle niin haukkasi edelleen 320W ja suorituskyky sakkasi rajusti. Sitten kun laitettiin DLSS myös päälle niin saatiin suorituskykyä ja hattiwatteja meni edelleen se 320W.

Eli novideon kortilla shadereitä ei pystytä käyttämään läheskään 100% kun noita RT ja Tensor coreja käytetään.

Jos vaikka nvidialla katoaa 40% shader tehosta, niin AMD voi about sen saman 40% shadereistä valjastaa RT käyttöön. Eli voi olla hyvinkin että AMD:n RT suorituskyky tulee olemaan pitkälti samanlainen tuhnu kuin nyt on nähty nvidialta.

Jos shadereilla framen laskemiseen menee 10 ms ja seuraavaksi pyydetäänkin laittamaan efektit joissa RT-laskentaan menee 20 ms, frame rate putoaa puoleen ja tuon toisen 10 ms shadereille ei ole juuri hyödyllistä työtä. Silloin tehonkulutuksesta ei voida suoraan päätellä että teho rajoittaisi kortin toimintaa ilman tarkempaa tietoa siitä miten laskenta-aika kortin sisällä rakentuu. Pelin/testin ja sen eri asetusten vaikutus tuleekin mahdollisesti vaihtelemaan eri näytönohjaimilla huomattavasti.

Tuon suhteen voimmekin ensi vuonna nähdä aika mielenkiintoisia eroja AMD:n ja Nvidian korttien välillä kun hyvin konsoleille optimoitujen kenties hieman kevyempien RT-ominaisuuksien voisi kuvitella sopivan AMD:n korteille erittäin hyvin. Jos spekulaatiot siitä että AMD ei kykene vielä täysin vastaamaan RT-puolella Nvidialle, voisi sitten ns. state of the art engineissä jotka on kehitetty ottamaan PC:llä kaikki koneesta irti voisivat olla edullisempia Nvidialle.

Tuon suhteen voimmekin ensi vuonna nähdä aika mielenkiintoisia eroja AMD:n ja Nvidian korttien välillä kun hyvin konsoleille optimoitujen kenties hieman kevyempien RT-ominaisuuksien voisi kuvitella sopivan AMD:n korteille erittäin hyvin. Jos spekulaatiot siitä että AMD ei kykene vielä täysin vastaamaan RT-puolella Nvidialle, voisi sitten ns. state of the art engineissä jotka on kehitetty ottamaan PC:llä kaikki koneesta irti voisivat olla edullisempia Nvidialle.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

GeForce RTX 3080: Inhaber berichten vermehrt von Abstürzen in Spielen

Viele Interessenten warten noch auf die Möglichkeit, eine RTX 3080 überhaupt kaufen zu können, da berichten erste Inhaber von Problemen.

RTX 3080:t kaatuilee oikeella ja vasemmalla minkä ehtivät

- Liittynyt

- 19.10.2016

- Viestejä

- 3 793

Saksan kieli ei ole mulle auennut vieläkään joten mitäs tuossa jutussa kerrotaan?

GeForce RTX 3080: Inhaber berichten vermehrt von Abstürzen in Spielen

Viele Interessenten warten noch auf die Möglichkeit, eine RTX 3080 überhaupt kaufen zu können, da berichten erste Inhaber von Problemen.www.computerbase.de

RTX 3080:t kaatuilee oikeella ja vasemmalla minkä ehtivät

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Että lukuisilla eri foorumeilla RTX 3080 -käyttäjät ovat huomanneet kaatumisia kun GPU:n kellotaajuus nousee yli 2 GHz:n, minkä se tekee monissa tapauksissa vakiona.Saksan kieli ei ole mulle auennut vieläkään joten mitäs tuossa jutussa kerrotaan?

Linkatut keskustelut:

RTX 3080 Crash

HI,Please Help I just bought a new powersupply and a new rtx 3080 . Whenever I play games it keep crashing ever 3 minutes or soo I have no idea whats the issue. I have reinstall the nvidia driver and it still keep crashing. I also found out that my power supply have some sort of whine sound. but ...

MSI GEFORCE RTX 3080 VENTUS 3X OC Problems

So i recently recieved my MSI GeForce RTX 3080 Ventus 3X OC and i'm getting crashing problems with it. So basically when im in game within the first few seconds of playing it crashes (not Blue screen crashes out of the game) and i believe the problem is the factory overclock is too high, as the...

MSI GeForce RTX 3080 Ventus 3X OC boostet bis zum Crash

Hallo zusammen, ich möchte auf mögliches Problem für alle (un)glücklichen Besitzer einer MSI GeForce RTX 3080 Ventus 3X OC hinweisen: Die Karte boostet mit Default-Settings in Spielen deutlich zu hoch ->zB. bis 2040 MHz nach wenigen Sekunden im AC:O Benchmark, was dann natürlich einen...

[SOLVED] - MSI GEFORCE RTX 3080 VENTUS 3X OC Problems

So i recently recieved my MSI GeForce RTX 3080 Ventus 3X OC and i'm getting crashing problems with it. So basically when im in game within the first few seconds of playing it crashes and i believe the problem is the factory overclock is too high, as the core clock speed boosts all the way up to...

Reddit - Netin sydän

Toistaiseksi toimivaksi hätäpaikaksi on todettu laittaa -100 MHz offsetillä GPU:lle

- Liittynyt

- 21.08.2018

- Viestejä

- 5 521

Msi Triot(3kpl)ei ainakaan +2000mhz kelloilla kaatuillut..

Kokeiltu myös pienimmällä powerilla joka täältä iteltä löytyy eli Asuksen 750w "on siis periaatteessa Focus+ asuksen moodaamalla jäähdytyksellä"

Mutta eipä saa kipattua millään rasitus testilläkään..

Ventusta olisi mielenkiintoista kokeilla saisiko sen kippaamaan kun kellot +2k ja virtalähteenä Super Flower 2000W Platinum.

Kokeiltu myös pienimmällä powerilla joka täältä iteltä löytyy eli Asuksen 750w "on siis periaatteessa Focus+ asuksen moodaamalla jäähdytyksellä"

Mutta eipä saa kipattua millään rasitus testilläkään..

Ventusta olisi mielenkiintoista kokeilla saisiko sen kippaamaan kun kellot +2k ja virtalähteenä Super Flower 2000W Platinum.

MSI Ventus 3X OC näyttää olevan pahimmissa ongelmissa, mutta ei ainut malli joka on kaatuillut.

Liekkö noita vaan ollut eniten saatavilla vai oisko et MSI on kädettänyt pahasti jännitteiden kanssa ja muut vähän vähemmän?

Ventuksia varmaan on aika hyvin ollut saatavilla. Monessa näistä ongelmista on kyse kädettömyydestä, mutta on siellä varmasti oikeitakin vikoja pohjalla.

Koputan puuta, mutta oma Ventus OC on toiminut hyvin, kilowatin virtalähteen kanssa.

oisqi

Rajat "VegaGOD" Monga ♿️

- Liittynyt

- 17.10.2016

- Viestejä

- 440

Eiköhän tuo ole vain huomattavasti paisuteltu ongelma. Varmasti suurin osa korteista toimii ongelmitta ja muutama viallinen vain pitää älämölöä. Mitään faktaahan ongelman yleisyydestä ei ole.

GeForce RTX 3080: Inhaber berichten vermehrt von Abstürzen in Spielen

Viele Interessenten warten noch auf die Möglichkeit, eine RTX 3080 überhaupt kaufen zu können, da berichten erste Inhaber von Problemen.www.computerbase.de

RTX 3080:t kaatuilee oikeella ja vasemmalla minkä ehtivät

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Jos avaat sen Chromella sen selaimen pitäisi tarjota kääntää se teksti kokonaan englanniksi. Sillä itse sen luin. Siinä luki, että monella käyttäjälle pelit kaatuu ja dumppaa työpöydälle. Silloin kun GPU kellotaajuus buustailee jossain 2+GHz. Kuitenkin sanovat ettei olisi ylikellottaneet. Ja joku ohje oli laskea GPU kelloja 100Mhz että ei kaatuisi.

Noh, muut voinee summata paremmin ja korjata virheeni. Mutta Chromella noita lueskelen, vaikka en muuten sitä käytäkään niin tuo integrointu Google translate toimii tuohon.

Videocardz teki computerbasen jutusta artikkelin ihan englanniksi:

ComputerBase has provided a quick overview of what users are reporting. At LinusTechTips forums users are reporting problems with ZOTAC GeForce RTX 3080 Trinity. Owners of MSI GeForce RTX 3080 Ventus 3X OC are also noticing this type of behavior, a thread on Overclockers.co.uk seems to suggest. Even on ComputerBase’s own forums, there are threads describing the same problem.

The threads also mention other custom boards such as MSI Gaming Trio or EVGA’s. You can find them on NVIDIA forums, Tom’s Hardware forums, Tweakers, and also Reddit.

The problem

This now clearly widespread, but still unexplored issue appears in a certain group of games when the boost clock exceeds 2.0 GHz. As soon as the clock speeds reach a certain level, the game crashes to desktop.

There is currently no official statement from any board partner, but ComputerBase has confirmed that they are in contact with the manufacturers. They were unable to reproduce this issue with at least three of the custom models they have.

It is currently unclear what is causing this problem. Whether this is a power supply issue, software bug, or maybe even too aggressive factory-overclocking from custom board partners, it is yet to be confirmed.

The solution

At the time of writing, there were no official solutions to this problem. However, if you are experiencing such issues with crashing in games at higher clock speeds it is recommended to manually downclock the GPU by 50 to 100 MHz. Undervolting may also be recommended, but this requires MSI Afterburner 4.6.3 Beta 2 (available here).

- Liittynyt

- 18.10.2016

- Viestejä

- 6 284

Jokuhan väitti, että 3080 tekisi hyvin nopeita ja kovia piikkejä tehonkulutukseen ja aiheuttaisi niiden takia ongelmia jos ne menevät poweri kestokyvyn yli. Väitteen mukaan juuri siksi tuolle 3080 suositeltaisiin niin isoa poweria kuin suositellaan. Tavalliset tehonkulutusmittarit ovat kuulema liian hitaita noiden piikkien näkemiseen

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Jokuhan väitti, että 3080 tekisi hyvin nopeita ja kovia piikkejä tehonkulutukseen ja aiheuttaisi niiden takia ongelmia jos ne menevät poweri kestokyvyn yli. Väitteen mukaan juuri siksi tuolle 3080 suositeltaisiin niin isoa poweria kuin suositellaan. Tavalliset tehonkulutusmittarit ovat kuulema liian hitaita noiden piikkien näkemiseen

Se voi olla, tai sitten binnaus on pettänyt ja kortit ei vain kestä niin kovia kelloja. Veikkaisin kyllä tuota virtapiikkiä.

Igorslab teki aikanaan noita mittauksia ja kyllä sellainen tulee vielä 3080:sta. Esim se parjattu 5700XT teki 1ms 328W piikkejä powerlimit tapissa, jotka voi olla liikaa 550W powerin pelikoneelle, jos prosu on kellotettu tai poweri on ikääntynyt.

Vega64, 1080TI ja 2080TI löytyivätkin kivasti kuvasta. Noilla powerlimiteillä on todellakin viive, jonka jälkeen ne reagoivat.

Edit: tekstiä poistettu, kun löytyi kuva joka kertoo saman asian paremmin.

Viimeksi muokattu:

- Liittynyt

- 18.10.2016

- Viestejä

- 6 284

Joka tapauksessa on mielenkiintoista, että 3080FE korteilla ei kuulema tuota ongemaa oleSe voi olla, tai sitten binnaus on pettänyt ja kortit ei vain kestä niin kovia kelloja. Veikkaisin kyllä tuota virtapiikkiä.

Igorslab teki aikanaan noita mittauksia ja kyllä sellainen tulee vielä 3080:sta. Esim se parjattu 5700XT teki 1ms 328W piikkejä powerlimit tapissa, jotka voi olla liikaa 550W powerin pelikoneelle, jos prosu on kellotettu tai poweri on ikääntynyt. Vega 64:llä maksimit oli 420W ja 0.3ms, 1080TI 375W 0.4ms, 2080TI vetää hetkittäin myös 400W. 3080W olisi ainakin seasonicin mukaan piikeissä 500W luokkaa.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Joka tapauksessa on mielenkiintoista, että 3080FE korteilla ei kuulema tuota ongemaa ole

Tähän tosiaan tuli lainausta, jonka poistin viestistä, kun löytyi sen paremmin summaava kuva. Tuo 3080FE onkin mielenkiintoisempi, se kyllä vähän viittaisi siihen, että AIB:it ovat ruuvanneet kelloja inasen liian korkealle. No täytyy odottaa alkaako noita ilmestyä enemmänkin ja tuleeko ajureihin vain joku korjaus, vai joku näkyvämpi lausunto aiheesta.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Videocardzin kommenteissa oli:

". No, it's not a PSU problem - people are reporting the same issue even with 1200W PSU

2. No, it's not just AIBs problem - on Nvidia forum people are reporting same issue with FE

There are some options:

1. drivers

2. not fully tested GDDR6x causing problems

3. people are overclocking too much

4. Samsung 8nm was pushed too hard by Nvidia

5. GDDR6x going too hot and causing issues

6. For reviewers were sent some golden samples and people are getting worse dies.

TIme will tell... "

Eli ei olisikaan vain AIB kellotus, tai virtapiikki. GDDR6x se tuskin on, eli eiköhän ole vain vähän liian agressivinen gpu boost 5.0 piirien binnaukseen nähden. Eli ne heikoimmat, mutta silti speksin rimaa hipoen täyttävät piirit taitavat kaatuilla. Saa nähdä saavatko korjattua vain ajurimuutoksella, kun biospäivitys olisi aika kova imagotappio.

". No, it's not a PSU problem - people are reporting the same issue even with 1200W PSU

2. No, it's not just AIBs problem - on Nvidia forum people are reporting same issue with FE

There are some options:

1. drivers

2. not fully tested GDDR6x causing problems

3. people are overclocking too much

4. Samsung 8nm was pushed too hard by Nvidia

5. GDDR6x going too hot and causing issues

6. For reviewers were sent some golden samples and people are getting worse dies.

TIme will tell... "

Eli ei olisikaan vain AIB kellotus, tai virtapiikki. GDDR6x se tuskin on, eli eiköhän ole vain vähän liian agressivinen gpu boost 5.0 piirien binnaukseen nähden. Eli ne heikoimmat, mutta silti speksin rimaa hipoen täyttävät piirit taitavat kaatuilla. Saa nähdä saavatko korjattua vain ajurimuutoksella, kun biospäivitys olisi aika kova imagotappio.

Vermon

Ph.D. in Wisdom Sciences

- Liittynyt

- 17.10.2016

- Viestejä

- 484

Jostain olin kuulevinani, että asia liittyisi virranhallintaan ja tehorajoihin.

Jotain sen tyylistä, että ensiksi kortti hakkaa tehorajoja vasten ja pudottaa tehoja, mutta tämän jälkeen reagoi liian nopeasti vapautuneeseen tehoreserviin ja heittää GPU:lle liikaa jerkkua, jolloin ylitetään piirin sisäiset turvarajat ja kaatuu koko vehe.

Toivottavasti oli tarpeeksi sekavasti selitetty.

Jos jostain edes tuon suuntaisesta on kyse, niin vian pitäisi olla onneksi softapäivityksellä korjattavissa.

Jotain sen tyylistä, että ensiksi kortti hakkaa tehorajoja vasten ja pudottaa tehoja, mutta tämän jälkeen reagoi liian nopeasti vapautuneeseen tehoreserviin ja heittää GPU:lle liikaa jerkkua, jolloin ylitetään piirin sisäiset turvarajat ja kaatuu koko vehe.

Toivottavasti oli tarpeeksi sekavasti selitetty.

Jos jostain edes tuon suuntaisesta on kyse, niin vian pitäisi olla onneksi softapäivityksellä korjattavissa.

Taisit kuvailla juuri Chernobylin onnettomuudenJostain olin kuulevinani, että asia liittyisi virranhallintaan ja tehorajoihin.

Jotain sen tyylistä, että ensiksi kortti hakkaa tehorajoja vasten ja pudottaa tehoja, mutta tämän jälkeen reagoi liian nopeasti vapautuneeseen tehoreserviin ja heittää GPU:lle liikaa jerkkua, jolloin ylitetään piirin sisäiset turvarajat ja kaatuu koko vehe.

Toivottavasti oli tarpeeksi sekavasti selitetty.

Jos jostain edes tuon suuntaisesta on kyse, niin vian pitäisi olla onneksi softapäivityksellä korjattavissa.

- Liittynyt

- 14.10.2016

- Viestejä

- 24 766

Joka tapauksessa on mielenkiintoista, että 3080FE korteilla ei kuulema tuota ongemaa ole

Myös 3080 FE -malleilla on samaa ongelmaa.Tähän tosiaan tuli lainausta, jonka poistin viestistä, kun löytyi sen paremmin summaava kuva. Tuo 3080FE onkin mielenkiintoisempi, se kyllä vähän viittaisi siihen, että AIB:it ovat ruuvanneet kelloja inasen liian korkealle. No täytyy odottaa alkaako noita ilmestyä enemmänkin ja tuleeko ajureihin vain joku korjaus, vai joku näkyvämpi lausunto aiheesta.

I'm using a 3080 FE, at first I played multiple games no issues. But then I started getting crashes and monitor flickering/instability. Underclocked via the Nvidia Tuner a bit and it seems to be helping during all the tests/games I've tried so far. Hopefully this can be addressed in the future without having to undervolt / underclock out of the box.

oisqi

Rajat "VegaGOD" Monga ♿️

- Liittynyt

- 17.10.2016

- Viestejä

- 440

Eiköhän tuo nyt ole edelleen paisuteltua ongelmaa. Odotellaan niitä oikeita faktoja ennen kuin lähdetään ihan hirveästi huutelemaan.Myös 3080 FE -malleilla on samaa ongelmaa.

- Liittynyt

- 18.10.2016

- Viestejä

- 6 284

Mutta noita ongelmia on vissiin postattu vähän joka foorumille eli se tuskin on tuulesta temmattua. Se mikä sen laajuus on onkin sitten jo eri asia. Joka tapauksessa tuo on huonoa mainosta nVidialle erityisesti kun markkinoita korteille olisi ainakin ollut. Olettaisin, että se korjataan heti kun pystytään jos sen biosilla tai ajureilla saa tehtyäEiköhän tuo nyt ole edelleen paisuteltua ongelmaa. Odotellaan niitä oikeita faktoja ennen kuin lähdetään ihan hirveästi huutelemaan.

Cirrus

Miksei maailma toimi asmilla?

- Liittynyt

- 16.10.2016

- Viestejä

- 3 388

AMD:n Frank Azor lupailee että AMD:n näyttisjulkaisu ei tule olemaan mikään paperlaunch

Ois oikeasti hyvä homma. Jos se siis tarkottaisi sitä vielä että aibt on täysillä mukana ja hyvä valikoima.

Eikä kyllä haittaisi jos koskisi zeni 3:sta myös.

- Liittynyt

- 23.10.2016

- Viestejä

- 90

AMD:llä on aivan mahtava sauma päästä peliin takaisin.

Verrattuna keskimääräiseen prosessihyppäykseen RTX 3000-sarja on pienoinen pettymys. Kyllä, se on tehokkaampi kuin 2000-sarja, mutta 2000-sarja ei itsessään ollut - RTX-ominaisuuksia lukuunottamatta - mitenkään järkyttävästi GTX 1000-sarjaa edellä. Suorituskykyä tuli lisää, mutta piirit on aika isoja ja virrankulutus on myös sen mukainen.

Vaikea sanoa mikä oikeastaan meni vikaan. Sampan 8 nm:n prosessi tai Amperen datakeskusjuuret voi tietenkin vaikuttaa tässä.

Vaikuttaa että tulossa on GCN 1.0 vs Kepler -saagan uusinta, mutta leirit on vaan vaihdettu. AMD julkaisi tuolloin ensimmäisenä HD7000-sarjan, jonka suorituskyky oli aiempaa huomattavasti parempi. HD7000-kortit oli kuitenkin suunniteltu datakeskus edellä. Perästä tuli nVidia, joka julkaisi huomattavasti halvemmat, vähävirtaisemmat,

pääasiassa pelikäyttöön suunnitellut GTX600-sarjan kortit joiden ei tarvinnut huomattavasti pienemmästä piirilevyn koosta hävetä suorituskyvyssä ollenkaan. GTX700-sarjan kortit eli "true kepler flagshipit" julkaistiin vasta huomattavasti myöhemmin - itse asiassa tuostahan se Titan-pelleily alkoikin.

Ei sillä että RTX 3080 mikään huono kortti olisi, ostaisin Founder's Editionin nVidian omilla hinnoilla jos vain pystyisin. Muut isommilla coolereilla varustetut, korkeammalla virrankulutuksella toimivat AIB-mallit (Founder's editionin binnaus?) jotka on vielä kalliimpia ei oikein omaan järkeen käy, varsinkin kun tehoeroa ei käytännössä kuitenkaan ole ja korttia pitäisi odottaa toista kuukautta.

Verrattuna keskimääräiseen prosessihyppäykseen RTX 3000-sarja on pienoinen pettymys. Kyllä, se on tehokkaampi kuin 2000-sarja, mutta 2000-sarja ei itsessään ollut - RTX-ominaisuuksia lukuunottamatta - mitenkään järkyttävästi GTX 1000-sarjaa edellä. Suorituskykyä tuli lisää, mutta piirit on aika isoja ja virrankulutus on myös sen mukainen.

Vaikea sanoa mikä oikeastaan meni vikaan. Sampan 8 nm:n prosessi tai Amperen datakeskusjuuret voi tietenkin vaikuttaa tässä.

Vaikuttaa että tulossa on GCN 1.0 vs Kepler -saagan uusinta, mutta leirit on vaan vaihdettu. AMD julkaisi tuolloin ensimmäisenä HD7000-sarjan, jonka suorituskyky oli aiempaa huomattavasti parempi. HD7000-kortit oli kuitenkin suunniteltu datakeskus edellä. Perästä tuli nVidia, joka julkaisi huomattavasti halvemmat, vähävirtaisemmat,

pääasiassa pelikäyttöön suunnitellut GTX600-sarjan kortit joiden ei tarvinnut huomattavasti pienemmästä piirilevyn koosta hävetä suorituskyvyssä ollenkaan. GTX700-sarjan kortit eli "true kepler flagshipit" julkaistiin vasta huomattavasti myöhemmin - itse asiassa tuostahan se Titan-pelleily alkoikin.

Ei sillä että RTX 3080 mikään huono kortti olisi, ostaisin Founder's Editionin nVidian omilla hinnoilla jos vain pystyisin. Muut isommilla coolereilla varustetut, korkeammalla virrankulutuksella toimivat AIB-mallit (Founder's editionin binnaus?) jotka on vielä kalliimpia ei oikein omaan järkeen käy, varsinkin kun tehoeroa ei käytännössä kuitenkaan ole ja korttia pitäisi odottaa toista kuukautta.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Eiköhän tuo nyt ole edelleen paisuteltua ongelmaa. Odotellaan niitä oikeita faktoja ennen kuin lähdetään ihan hirveästi huutelemaan.

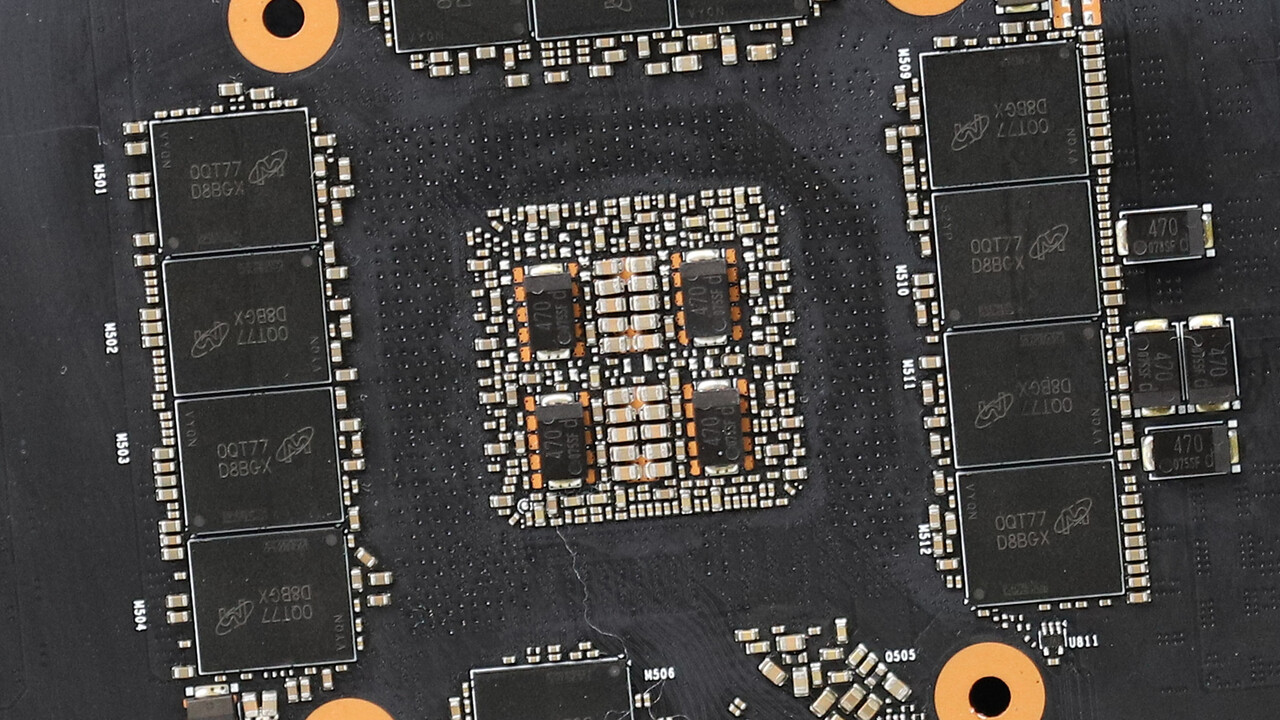

Lisähupia tuli siitä, että micron postasi gddr6x speksit:

Operating temperature 0-95c.

Maksimisäilytyslämpötila (eli ilman sähköjä) on 120c.

Max tjunctionia ei kerrota.

Igorslabin lämpökamerakuvien mukaan 3080FE:n muistit on about 104c. Ei tuo nyt pitkää elinikää lupaa, kun ajellaan yli suositusten, mutta ei vielä lämmöillä, jossa piirin suojamekanismit käynnistyy. Saa nähdä tuleeko ensimmäiset space invaders efektit ennen takuun päättymistä.

oisqi

Rajat "VegaGOD" Monga ♿️

- Liittynyt

- 17.10.2016

- Viestejä

- 440

Eiköhän nuo oikeasti ihan speksien mukaan rullaile. Nvidialla on kuitenkin paljon suurempi vastuu noissa FE-korteissa, eli aivan varmasti ovat kyllä lämmöt toleranssien ja speksien sisässä.Lisähupia tuli siitä, että micron postasi gddr6x speksit:

Operating temperature 0-95c.

Maksimisäilytyslämpötila (eli ilman sähköjä) on 120c.

Max tjunctionia ei kerrota.

Igorslabin lämpökamerakuvien mukaan 3080FE:n muistit on about 104c. Ei tuo nyt pitkää elinikää lupaa, kun ajellaan yli suositusten, mutta ei vielä lämmöillä, jossa piirin suojamekanismit käynnistyy. Saa nähdä tuleeko ensimmäiset space invaders efektit ennen takuun päättymistä.

- Liittynyt

- 20.10.2016

- Viestejä

- 4 277

Eiköhän nuo oikeasti ihan speksien mukaan rullaile. Nvidialla on kuitenkin paljon suurempi vastuu noissa FE-korteissa, eli aivan varmasti ovat kyllä lämmöt toleranssien ja speksien sisässä.

Ne menee mittausten mukaan piirivalmiistajan ilmoittaman kuluttajasovellusten käyttöälämpöjen yli, mutta ei vielä hakaa tjunctionia vasten, jossa piirin suojamekanismit laukeaa. Suomennettuna ne toimii, mutta se tapahtuu piirien eliniän kustannuksella. Tietty JOS tuo tarkoittaa, että laskennallinen 20v käyttöikä laskeekin 5v tasolle, niin se hajoaa jonkun käytetyistä osista kasatussa SER kokoonpanossa ja kestää mainiosti takuuajan yli. Tietty 5v ajassa mikä tahansa kortti voi päätyä jätelavalle tuulettimen laakereidenkin takia.

Uutiset

-

Huawei julkisti kattauksen uusia tuotteita Madridissa – juoksijoille uusi Watch GT Runner 2 -älykello

26.2.2026 16:30

-

NVIDIAn päättynyt neljännes rikkoi jälleen yhtiön ennätyksiä

26.2.2026 12:00

-

Samsung esitteli Galaxy Unpackedissa uudet Galaxy Buds4 -sarjan nappikuulokkeet

25.2.2026 21:58

-

Lenovo varoittaa tietokoneidensa hintojen pomppaavan maaliskuussa

25.2.2026 20:23

-

Samsung julkisti uudet Galaxy S26 -sarjan puhelimensa vuoden 2026 ensimmäisessä Unpacked-tilaisuudessa

25.2.2026 20:00

Uusimmat viestit

-

-

-

Avaruus-ketju (keskustelua tähtitieteestä, havainnoista ym.)

- Viimeisin: Puhelinkoppi