- Liittynyt

- 02.01.2017

- Viestejä

- 1 633

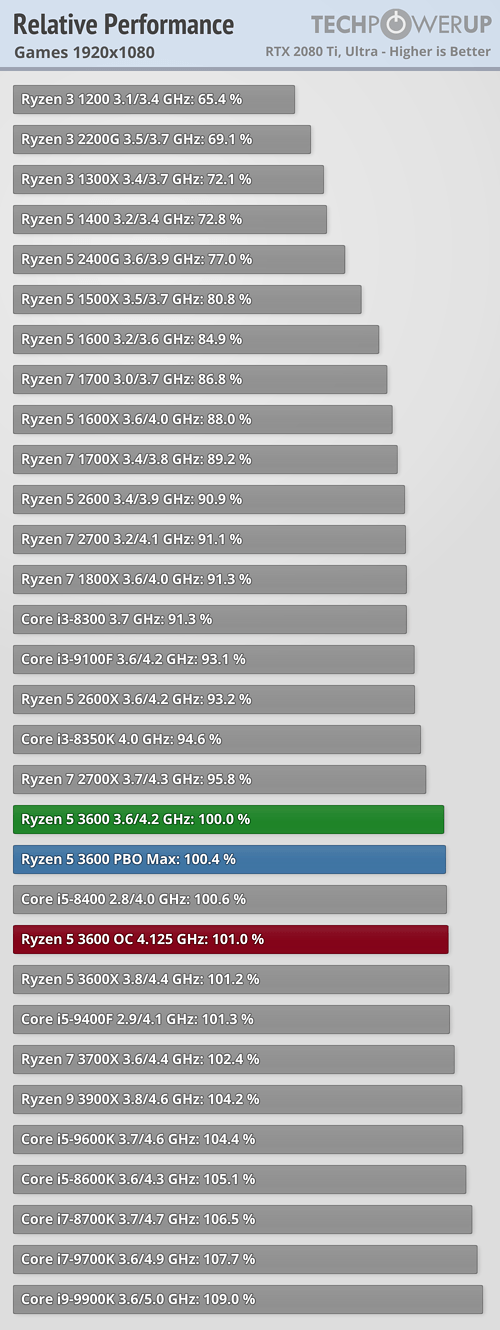

Hyvin potkii Ryzen.

Mutta eihän tuo i5-9400F mikään huono ole sekään pelikäyttöön, yhtä nopea kuin R5 3600 mutta maksaa 27% vähemmän, ts. 3600 on 38% kalliimpi mutta pelikäytössä saman tehoinen. Pelikäytössä tuolla 60€ hintaerolla saa jo paremman näytönohjaimen, kun puhutaan noin 700€ paketeista joka on aika yleinen hintahaarukka.

Kiitos artikkelista.

60€ hintaero? 9400f maksaa halvimmillaan 163,7€ toimitettuna kun powerilta sai 199€, njuu 36€ hintaero mutta HT/SMT tuki puuttuu. Lisäksi vanhoilla ryyzenin omistajilla upgrade tulee huomattavasti halvemmaksi kun ei tarvii ostaa lankkua, tällöin ryzen 3600 + emo on halvempi kuin 9400f + emo. Jos taas lähtee puhtaalta pöydältä liikkeelle niin silloin voisi ehkä 9400f olla perusteltavissa, mutta kuinka futureproof se olisi?