- Liittynyt

- 13.10.2016

- Viestejä

- 13 049

Näytönohjainvalmistajat ilmoittavat nykyään näytönohjaimien näyttömuistin nopeuden siirtonopeutena (Gbps, gigabittiä per sekunti) ja myös io-tech alkaa noudattaa jatkossa samaa käytäntöä.

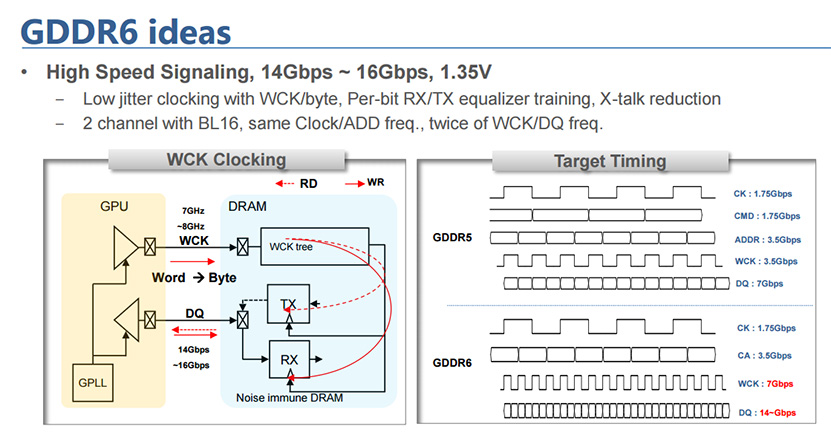

Miksi sitten perinteisestä yksittäisestä kellotaajuusarvosta on siirrytty käyttämään siirtonopeutta? Uusimmissa grafiikkamuistitekniikoissa, kuten GDDR5, GDDR5X ja GDDR6, muistipiirissä on sisäisesti käytössä useita eri kellotaajuuksia.

Esimerkiksi GDDR5-muistipiirissä käytetään command clock (CK) ja write clock (WCK) kellotaajuuksia, joista esimerkiksi 7 Gbps:n siirtonopeudella toimivassa muistipiirissä CK-taajuus on 1,75 GHz ja WCK-taajuus 3,5 GHz. Muistin tehollinen kellotaajuus on 7 GHz (QDR, Quad Data Rate), jolla viitataan mahdollisuuteen siirtää tietoa neljä kertaa kellojaksossa.

Kun puhutaan muistin siirtonopeudesta, viitataan yksittäisen data- eli I/O-pinnin siirtonopeuteen gigabitteinä sekunnissa. Vaikka GDDR5-piireissä on yhteensä 170 ja ja GDDR5X-piireissä 190 liitäntäpinniä, molemmissa on sama määrä eli 32 kpl I/O-pinnejä. Muistipiirin kokonaispinnien lukumäärällä ei ole yhtälössä merkitystä.

Muistiväylän kokonaiskaistanleveys saadaan laskettua kertolaskulla: siirtonopeus per pinni * yhden muistipiirin I/O-pinnien lukumäärä * muistipiirien lukumäärä ja bitit saadaan muunnettua tavuiksi jakamalla kahdeksalla. Esimerkkinä GeForce GTX 1080 Ti ja 11 Gbps siirtonopeus GDDR5X-muisteilla:

(11 Gbps/pin * 32 pin * 11 kpl) / 8 = 484 Gt /s

Tässä muutamia esimerkkejä AMD:n ja NVIDIAn näytönohjaimien siirtonopeuksista:

- GeForce GTX 1080 Ti: 11 Gbps (GDDR5X)

- AMD Radeon RX 580: 8 Gbps (GDDR5)

- GeForce GTX 1050 Ti: 7 Gbps (GDDR5)

Kerro kommenteissa, mitä mieltä olet uudesta muistien nopeuden ilmoituskäytännöstä?

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Viimeksi muokattu: