- Liittynyt

- 14.10.2016

- Viestejä

- 24 711

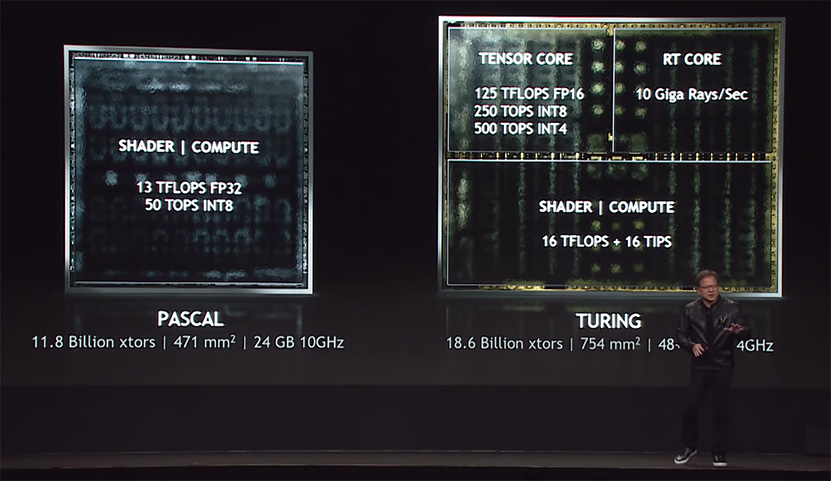

NVIDIA on julkaissut Turing-arkkitehtuuristaan grafiikkapiirejä sekä RT- ja tensoriytimillä varustettuna että ilman niitä. Keskusteluissa onkin spekuloitu paljon sitä, kuinka paljon RT- (Ray tracing) ja tensoriytimet todellisuudessa vaikuttavat grafiikkapiirin kokoon.

NVIDIA esitteli Turing-arkkitehtuurin julkaisun yhteydessä kuvaa, jossa huippupiiri TU102 oli jaoteltu tensoriytimiin, RT-ytimiin ja CUDA-ytimiin. Kuvan mukaan RT- ja tensoriytimet veisivät kumpikin neljänneksen alasta, kun CUDA-ytimet veisivät puolet piirin alasta. Sanomattakin on selvää, että kyseessä oli fiktiivinen jaottelu, eikä piiriä ole jaettu kuvan kaltaisiin osiin millään tasolla, vaan RT- ja tensoriytimet ovat integroitu tiiviisti CUDA-ytimet sisältäviin TPC- (Thread Processing Cluster) ja SM-yksiköihin (Streaming Multiprocessor).

Kun Turing-arkkitehtuurista julkaistiin ensimmäiset versiot ilman edellä mainittuja ytimiä, heräsi keskustelu uudelleen niiden vaatimasta pinta-alasta. Jonkinmoista selvyyttä tilanteeseen saatiin lopulta piirien valokuvauksesta tutun Fritzchens Fritzin julkaisemien TU106- ja TU116-grafiikkapiirien infrapunakuvien myötä.

Redditissä nimimerkillä Qesa tunnettu käyttäjä otti asiakseen selvittää, kuinka paljon RT- ja tensoriytimet todella vievät tilaa kyseisten kuvien pohjalta. Qesan laskelmien mukaan yksi TPC-yksikkö, joka sisältää kaksi SM-yksikköä ja RT-ydintä sekä joukon tensoriytimiä vie TU106-grafiikkapiirillä tilaa 10,89 mm2. Vastaava TPC-yksikkö TU116-grafiikkapiirillä, jossa ei ole lainkaan RT-ytimiä ja tensoriytimet on korvattu FP16-CUDA-ytimillä, vie puolestaan tilaa 8,94 mm2, mikä tarkoittaisi 1,95 mm2 eroa. Qesan arvion mukaan tensoriytimet vievät piiriltä tilaa noin 1,25 mm2 enemmän kuin FP16-ytimet, kun RT-ytimet vaatisivat tilaa noin 0,7 mm2. Koska tensoriytimet on integroitu niin tiukasti CUDA-ydinten rinnalle SM-yksikössä, sisältää niiden vaikutus TPC:n kokomuutokseen myös mahdolliset vaaditut muutokset muihin TPC:n osiin kuten välimuisteihin ja tehtävien vuorottajaan (scheduler).

Lyhyemmin ilmaistuna FP16-ydinten vaihtaminen RT- ja tensoriytimiin kasvattaisi kunkin TPC-yksikön kokoa hieman alle 22 prosenttia. Karkean laskukaavan mukaan TU116:n tapaan FP16-ytimillä varustetun TU102:n pinta-ala kutistuisi 754 mm2:sta 684 mm2:een, TU104:n 545 mm2:sta 498 mm2:een ja TU106:n 445 mm2:sta 410 mm2:een. Kuten luvuista näkee, olisivat kyseiset grafiikkapiirit erittäin kookkaita myös ilman tensori- ja RT-ytimiä. Uutisessa käytetyt lukemat ovat valistuneita arvioita saatavilla olevasta materiaalista, eikä tarkkoja lukuja saada luultavasti ikinä tietää, ellei NVIDIA niitä erikseen lähde paljastamaan.

Lähde: Reddit, Fritzchens Fritz @ Flickr

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Palautelomake: Raportoi kirjoitusvirheestä

Viimeksi muokattu: