- Liittynyt

- 14.10.2016

- Viestejä

- 23 727

Kaotik kirjoitti uutisen/artikkelin:

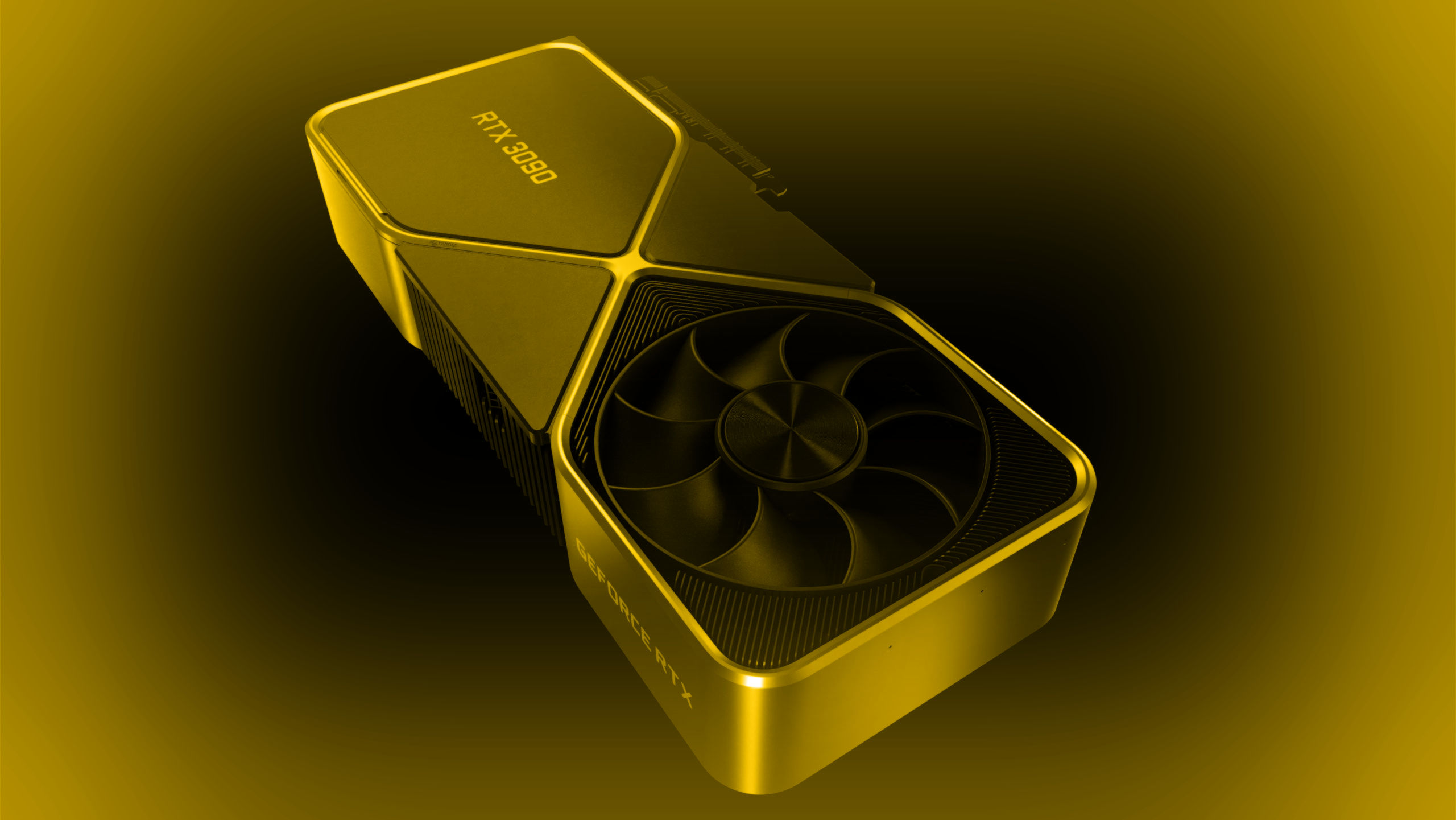

NVIDIAn ”BFGPU” eli GeForce RTX 3090 saapuu myyntiin ja arvosteluihin huomenna. Yhtiö on nyt julkaissut artikkelin, jossa se kertoo mitä näytönohjaimen julkaisulta on syytä odottaa.

GeForce RTX 3080:n myyntiintulo ei sujunut niin kuin toivottiin. Markkinoiden normaalia korkeampi kysyntä yhdistettynä vain normaalin julkaisun varastosaldoihin, botteihin ja trokareihin sai kaikki tahot myymään eioota. Nyt NVIDIA varoittaa jo valmiiksi, että RTX 3090 -näytönohjaimia tulee olemaan saatavilla vain rajoitetusti ja selvästi vähemmän, kuin pelaajille suunnattuja RTX 3080 -näytönohjaimia.

NVIDIAn mukaan GeForce RTX on suunniteltu Titan RTX:n korvaajaksi raskaaseen renderöintiin, sisällöntuotantoon ja tekoälykehitykseen, unohtamatta 8K-pelaamisen perään haikailevia harrastajia. Titan-sarjan jatkajana sen kohdemarkkinat ovat kuitenkin pelinäytönohjaimia kapeammat, minkä vuoksi myös sen saatavuus tulee olemaan heikompaa. NVIDIAn mukaan se työskentelee ahkerasti kumppaneidensa kanssa saadakseen myös RTX 3090 -näytönohjaimia enemmän tuotantoon tulevien viikkojen aikana.

Kenties hieman erikoisestikin, NVIDIA paljasti myös mitä näytönohjaimen pelisuorituskyvyltä on odotettavissa huomenna. Yhtiön mukaan GeForce RTX 3090 tulee peittoamaan RTX 3080:n 4K-resoluutiolla vain noin 10 – 15 %:n erolla huolimatta yli kaksinkertaisesta suositushinnastaan. Titan RTX:ään eroa syntyy yhtiön mukaan parhaimmillaan noin 50 %. NVIDIAn lupaukset suorituskyvystä osuvat varsin hyvin yksiin ensimmäisten testitulosvuotojen kanssa, sillä ne ovat lupailleet noin 10 – 20 %:n eroa.

io-tech tulee julkaisemaan huomenna Asuksen TUF Gaming RTX 3090-, Gigabyten RTX 3090 Gaming OC- ja MSI RTX 3090 Gaming X Trio -näytönohjaimiin pureutuvan arvostelun, mutta Founders Edition -malli saapuu testilaboratorioomme vasta hieman myöhemmin.

Lähde: NVIDIA

Linkki alkuperäiseen juttuun

Viimeksi muokattu: