- Liittynyt

- 14.10.2016

- Viestejä

- 21 611

Kaotik kirjoitti uutisen/artikkelin:

NVIDIAn nahkatakkinen toimitusjohtaja Jensen Huang on käynnistänyt Kalifornian San Josessa kevään 2024 GTC- eli GPU Technology Conference -tapahtuman keynote-esityksellään. Kuten odotettua oli, julkistettiin tapahtumassa uusi Blackwell-arkkitehtuuri ja siihen perustuvat järeät laskentapiirit.

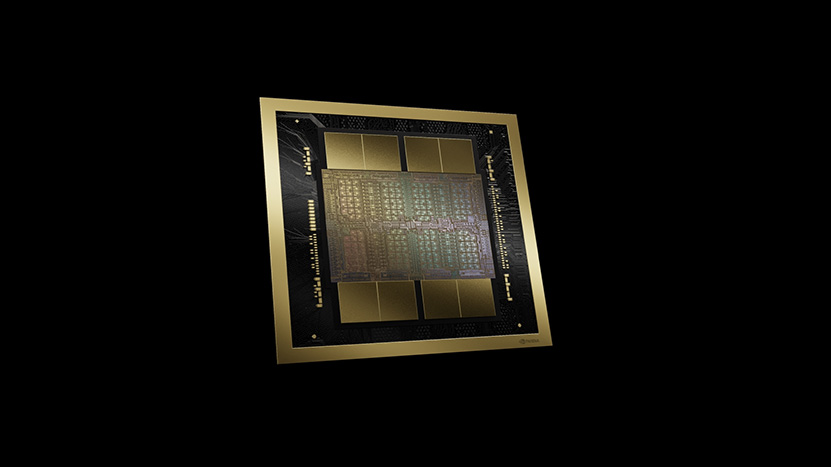

NVIDIAn diojen mukaan TSMC:n 4NP-prosessilla valmistettava 104 miljardin transistorin Blackwell olisi suurin mahdollinen siru, mitä voidaan valmistaa. Se ei kuitenkaan ole yhtiölle riittänyt, vaan piirejä on ladottu kuhunkin paketointiin kaksin kappalein. Piirit toimivat diojen mukaan yhtenä GPU:na ja ne ovat keskenään välimuistikoherentteja, joten yhdessä B200:ssa on kaksi sirua ja yhteensä kahdeksan 24 Gt:n HBM3e-muistipinoa. 192 Gt:n muistiin on yhteensä jopa 8 Tt/s muistikaistaa, kun molempien sirujen kaistat ynnätään yhteen. NVIDIA on päivittänyt Blackwellissä myös yhdysväylän uuteen NVLink 5 -versioon, mikä 18 linkillä tarjoaa nyt 1800 Gt/s kaistaa, kun Hopper-sukupolvessa sitä oli vain 900 Gt/s.

NVIDIA ei ole hiiskunut B200:n tarkemmasta konfiguraatiosta, kuten CUDA- ja Tensor-ytimien määristä tai kellotaajuuksista vielä mitään. Se mitä tiedetään, on teoreettinen suorituskyky tensorilaskennassa, perinteisistä vektorilaskennoista ei hiiskuttu mitään. Merkinnöissä suluissa Hopper-sukupolven H100:n vastaavat lukemat.

- B200 FP64: 40 TFLOPS (H100 67 TFLOPS)

- B200 TF32: 1100 TFLOPS (H100 495 TFLOPS)

- B200 FP16: 2250 TFLOPS (H100 990 TFLOPS)

- B200 INT8/FP8: 4500 T(F)LOPS (H100 1980 TOPS)

- FP4: 9 PFLOPS

[gallery link="file" columns="2" size="medium" ids="95618,95619"]

Blackwellistä tulee saataville kolme varianttia sekä kaksi HGX-palvelinversiota: B100, B200, GB200 ja HGX B100 sekä B200. Yllä listatut suorituskykylukemat ovat 1000 watin B200:lle, kun B100:ssa kulutus on rajattu 700 wattiin, mikä syö samalla neljänneksen suorituskykyä. GB200:n kulutukseksi kerrotaan parhaimmillaan peräti 2700 wattia, mutta se on varustettu kahdella B200-versiolla sekä Grace-prosessorilla. HGX-palvelimissa on tuttuun tapaan kahdeksan B100:aa tai B200:aa. Lisäksi yhtiö esitteli uuden GB200 NVL72:n, mikä on käytännössä palvelinräkki yhteensä 36 GB200:lla.

Samaan syssyyn julkaistiin myös uusi NVLink Switch -piiri, jota ei sitäkään voi turhan pieneksi haukkua. Se rakentuu jopa 50 miljardista transistorista ja valmistetaan samalla TSMC 4NP -prosessilla kuin Blackwell. Se on varustettu yhteensä 72-porttisella Dual 200 Gb/s SerDes -kytkimellä ja neljällä 1,8 Tt/s NVLinkillä. Se tarjoaa jopa 7,2 Tt/s yhteiskaistaa ja osaa vielä päälle tarjota SHARP In-Network Compute -laskentakykyä 3,6 TFLOPSin edestä FP8-tarkkuudella. Se mahdollistaa yhtiön mukaan kaikkien siihen kytkettyjen piirien toimimisen kuin ne olisivat yksi suuri GPU.

Suosittelemme arkkitehtuurista lähemmin kiinnostuneille esimerkiksi AnandTechin syväluotaavampaa artikkelia.

Lähde: NVIDIA

Linkki alkuperäiseen juttuun