- Liittynyt

- 14.10.2016

- Viestejä

- 21 919

NVIDIA sivuutti Turing-julkaisutilaisuudessaan täysin todelliset suorituskykymittaukset uusilla näytönohjaimillaan. Pian julkaisun jälkeen nettiin saatiin ensimmäiset, vähemmän mairittelevat lukemat Shadow of the Tomb Raider -pelistä, mutta ilman vertailukohtaa ja beetatason säteenseurantaefektit käytössä johtopäätösten teko niistä oli turhaa.

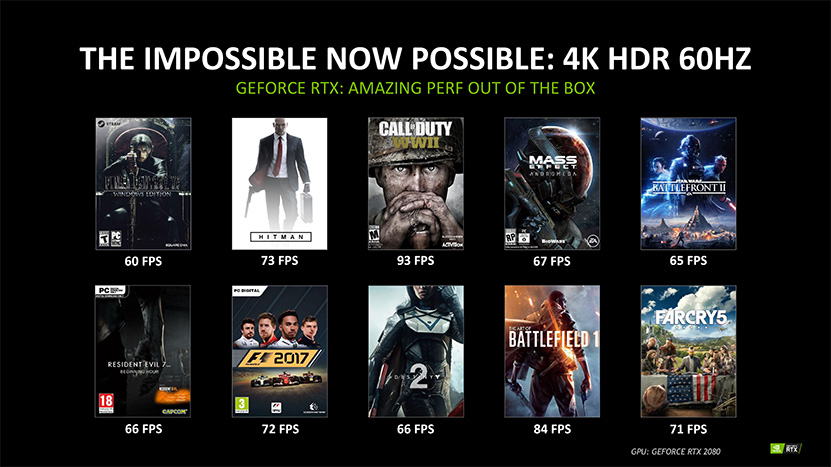

Nyt NVIDIA on julkaissut omassa blogissaan ensimmäiset yhtiön viralliset, omat testitulokset. Samalla se lupaa GeForce RTX 2080:n kykenevän 4K-resoluutiolla yli 60 FPS:n keskimääräiseen ruudunpäivitysnopeuteen yhteensä kymmenessä AAA-luokan pelissä HDR-renderöinti päällä: Final Fantasy XV Windows Edition, Hitman, Call of Duty: WWII, Mass Effect: Andromeda, Star Wars: Battlefront II, Resident Evil 7: Beginning Hour, F1 2017, Destiny 2, Battlefield 1 ja FarCry 5.

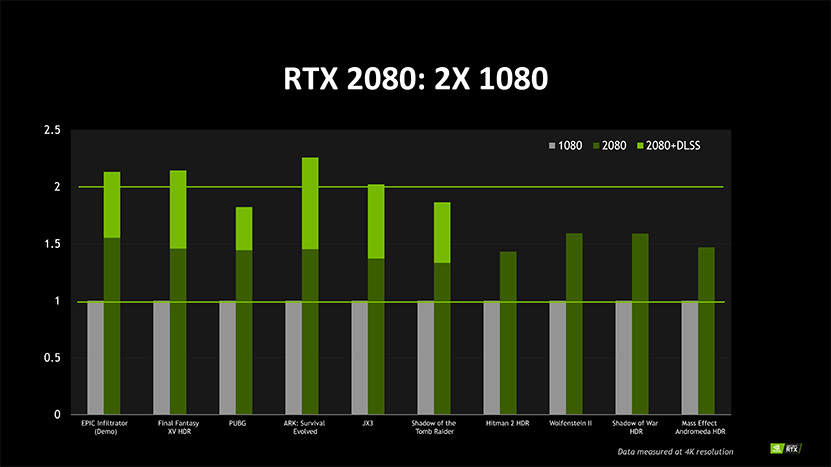

Itse suorituskykyvertailussa GeForce RTX 2080 peittoaa edeltäjänsä identtisin asetuksin 4K-resoluutiolla noin 30 - 50 prosentin erolla. Valitettavasti yhtiö ei julkaissut käytettyjä asetuksia. NVIDIA liitti mukaan myös RTX 2080:n tulokset kuudessa DLSS-teknologiaa (Deep-Learning Super Sampling) tukevassa pelissä, jolloin ero GTX 1080:een venähti noin 70 – 120 %:n välimaastoon. NVIDIA on kertonut Deep-Learning Super Sampling -teknologiastaan tähän mennessä sen verran, että se analysoi renderöintiprosessia ja tuottaa ruudulle tarkkapiirtoisia mutta sileitä objekteja parantaen siten kuvan laatua. DLSS vaatii peliltä erillisen tuen.

Koska NVIDIA ei ole kertonut DLSS-teknologiansa todellisia saloja, jättää tulokset paljon arvailun varaan. Ottaen huomioon kuitenkin sen, että teknologia parantaa suorituskykyä merkittävästi on sen tehtävä jokin osa renderöintiprosessista selvästi nopeammin. Ottaen huomioon objektien reunojen parantamisen, mahdollisia selityksiä olisivat esimerkiksi pelin renderöinti todellisuudessa matalammalla resoluutiolla ja sen skaalaaminen tekoälyn avulla ”vastaamaan” 4K-resoluutiolla renderöityä kuvaa, tai vaihtoehtoisesti testit olisi ajettu normaalisti super sampling -reunojenphemennys käytössä ja DLSS-tulokset kuvastaisivat kuinka paljon nopeammin tekoälyllä saa vastaavan kuvan oikomalla tekoälyllä perinteisen ”supersamplauksen” sijasta.

Lisäksi NVIDIA on julkistanut listan peleistä, joihin on tulossa tuki joko säteenseurantaefekteille tai DLSS-teknologialle. Osaan peleistä ominaisuudet ollaan lisäämässä jälkikäteen päivityksillä. Kokosimme pelit alta löytyvään taulukkoon, vihreää ruutu merkitsee pelin tukevan kyseistä ominaisuutta.

Lähde: NVIDIA

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Palautelomake: Raportoi kirjoitusvirheestä

Viimeksi muokattu:

Noh katsotaan silti 3-osapuolen testit vielä rauhassa ennen lopullista leimaa.

Noh katsotaan silti 3-osapuolen testit vielä rauhassa ennen lopullista leimaa.