- Liittynyt

- 13.10.2016

- Viestejä

- 12 586

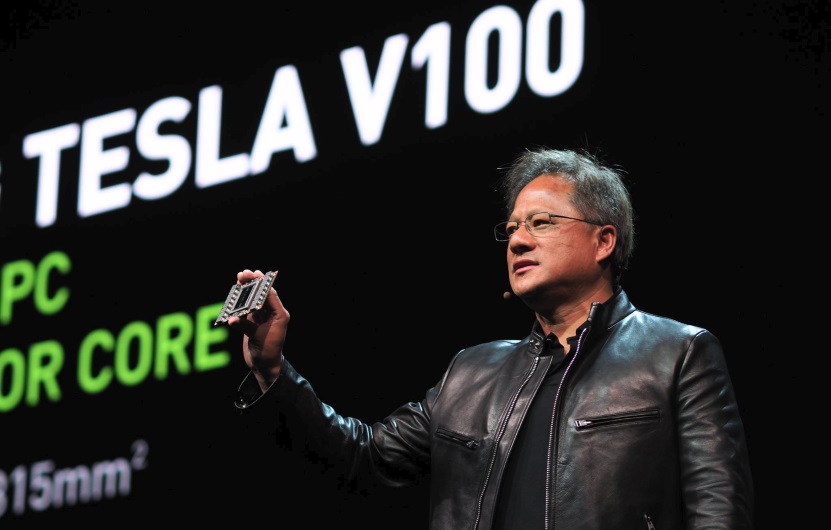

Käytössä on Volta-arkkitehtuuriin perustuva GV100-grafiikkapiiri, joka rakentuu 21,1 miljardista transistorista ja sen pinta-ala on 815 neliömillimetriä. Grafiikkapiiri valmistetaan TSMC:n 12 nanometrin FFN-prosessilla, joka on kustomoitu NVIDIAlle ja piisiru on niin iso kuin valmistuksessa käytettävä fotolitografia tällä hetkellä mahdollistaa.

Tesla V100:n grafiikkapiiri toimii 1455 MHz:n Boost-taajuudella ja siitä on kytketty pois käytöstä neljä SM-yksikköä eli käytössä on 5120 CUDA-ydintä ja 320 tekstuuriyksikköä. Grafiikkapiirin rinnalla on 16 gigatavua Samsungin valmistamaa HBM2-muistia, joka tarjoaa muistiväylän kaistanleveydeksi 900 gigatavua / sekunnissa. Todellisuudessa GV100-grafiikkapiirissä on 84 SM-yksikköä ja erikseen 5376 FP32-ydintä ja 5376 INT32-ydintä, 2688 FP64-ydintä, 672 Tensor-ydintä ja 336 tekstuuriyksikköä.

Uutta V100:n SM-yksiköissä ovat Tensor-ytimet. Tensor-ytimet ovat koneoppimiselle pyhitettyjä yksiköitä, jotka ovat erikoistuneet tensoreiden laskentaan. Käytännössä kukin Tensor-ydin suorittaa "D = A x B + C" -laskutoimituksia 4 x 4 -matriiseilla ja kykenee yhteensä 64 FMA-operaatioon ((Fused Multiply-Add) FP16-kertolasku, FP32-akkumulaatio) kellojaksossa. NVIDIAn mukaan erikoistuneet yksiköt mahdollistavat peräti 12-kertaisen suorituskyvyn viime sukupolven P100:n nähden opetus- ja päättelytehtävissä (FP32) tai kuusinkertaisen suorituskyvyn syväoppimisessa (FP16).

FP32-suorituskyvyksi kerrottiin 15 TeraFLOPSia ja FP64-suorituskyvyksi 7,5 TeraFLOPSia.

SXM2-kokoluokan kiihdyttimessä piirilevyllä on BGA-koteloitu interposer-alusta, jonka päällä on GV100-grafiikkapiiri ja HBM2-muistit. Grafiikkapiirin molemmilla puolin on virransyöttö. Tesla V100 on yhteydessä muihin grafiikkapiireihin NVLink 2-väylän kautta, joka mahdollistaa teoriassa maksimissaan 300 Gt/s tiedonsiirtonopeuden. Maximum Performance -tilassa kiihdyttimen TDP-arvo on 300 wattia.

Tesla V100:n tutkimus- ja kehitysbudjetiksi kerrottiin 3 miljardia dollaria. Kiihdyttimet ovat käytössä muun muassa 149 000 dollarin hintaisessa neuroverkkojen käsittelyyn tarkoitetussa DGX-1V-supertietokoneessa, joka on varustettu kahdeksalla Tesla V100:lla.

Lähde: NVIDIA

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Viimeksi muokattu: