- Liittynyt

- 14.10.2016

- Viestejä

- 22 495

Kaotik kirjoitti uutisen/artikkelin:

NVIDIA kertoi DLSS-skaalausteknologian julkaisussa myös erillisestä DLSS 2X -tilasta, joka toimisi natiiviresoluutiolla uutena reunojenpehmennystapana. Sen jälkeen teknologiasta ei olekaan juuri kuultu yhtiön linjattua, että DLSS:ää saisi käyttää vain tilanteissa, joissa se parantaa suorituskykyä.

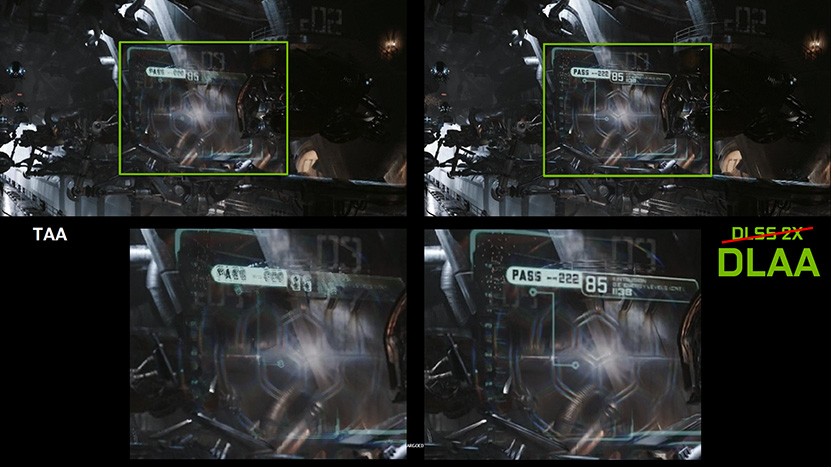

NVIDIA aikoo ilmeisesti pitää linjauksestaan kiinni jatkossakin, sillä joko DLSS 2X -tilan DLSS 2.x -variantti tai ainakin hyvin samankaltainen teknologia on tulossa markkinoille DLAA- eli Deep Learning Anti-Aliasing -nimellä.

Teknologian tarkemmasta toteutuksesta ei tiedetä vielä muuta, kuin että se perustuu DLSS-teknologiaan ja tarjoaa pelkän reunojenpehmennyksen ilman kuvan skaalaamista korkeammalle resoluutiolle. DLAA:n ensimmäinen versio on jo käytössä Elder Scrolls Online -pelin testipalvelimilla, mutta laatuvertailuja siitä ei ole vielä tullut saataville. Pelin kehittäjä ZeniMax Onlinen edustaja Rich Lambert kehuu laatua kuitenkin paremmaksi kuin ESO:n nykyiset reunojenpehmennysmetodit ja yhtiön grafiikkapuolen johtaja Alex Tardiff toteaa puolestaan Twitterissä pelin olevan otollinen testialustaksi, koska pelin suorituskyky on riittävä ilman skaalaustakin. DLAA vaatii luonnollisesti myös veronsa, mutta suorituskykyvertailujakaan ei ole vielä saatavilla.

Lähteet: NVIDIA, Alex Tardiff @ Twitter

Linkki alkuperäiseen juttuun

Viimeksi muokattu:

.

.