- Liittynyt

- 13.10.2016

- Viestejä

- 13 049

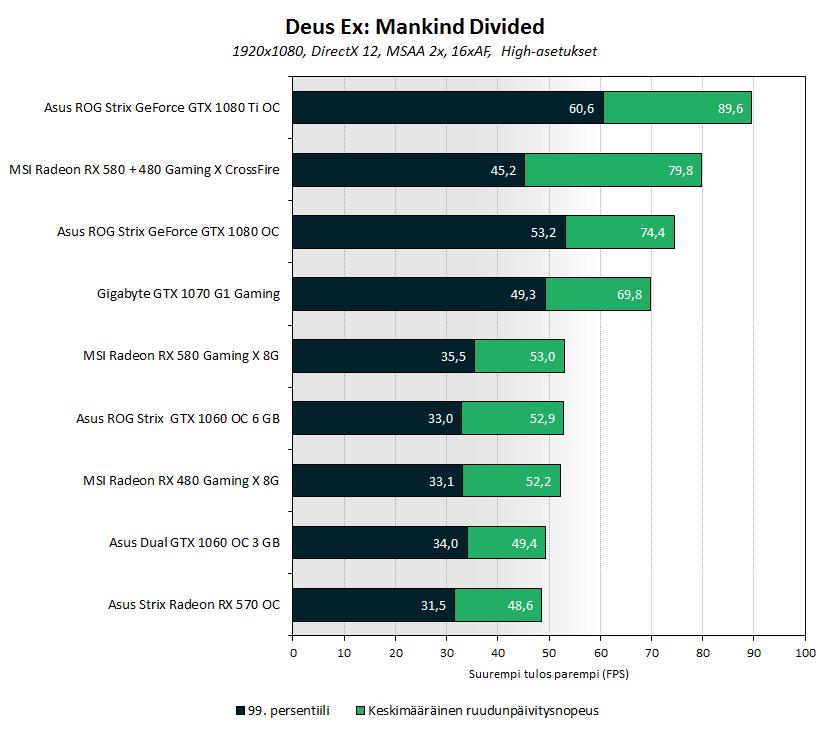

Lukijoiden pyynnöstä testasimme Polaris-arkkitehtuurin MSI:n Radeon RX 580 Gaming X- ja Radeon RX 480 Gaming X -näytönohjaimien toimivuutta rinnakkain käytännössä.

Artikkelissa on mukaiset suorituskykytestit, ruutujen renderöintiaikojen analyysi sekä tehonkulutus-, lämpötila- ja melumittaukset.

Ajoimme mukaan tulokset myös GeForce GTX 1070-, 1080- ja 1080 Ti -näytönohjaimilla, jotta CrossFire-konfiguraation suorituskykyä olisi helpompi suhteuttaa suorituskykyisempiin yhden grafiikkapiirin näytönohjainmalleihin.

Lue artikkeli: MSI Radeon RX 580 + 480 CrossFire

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Viimeksi muokattu: