- Liittynyt

- 14.10.2016

- Viestejä

- 22 445

Kaotik kirjoitti uutisen/artikkelin:

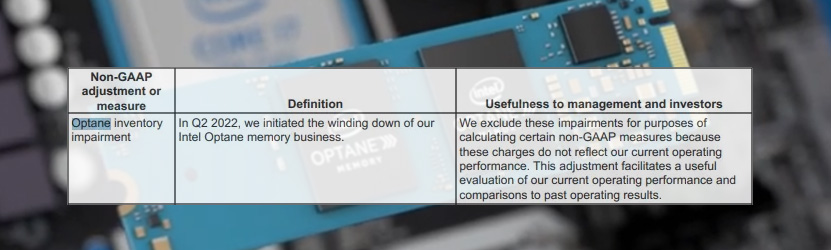

Intel ja Micron kehittivät yhteistyönä 3D XPoint -muistit, joiden oli tarkoitus täyttää DRAM-muistien ja SSD-asemien välinen ammottava aukko uudella musitikerroksella. 3D XPoint muistit tunnetaan parhaiten Intel Optane -nimestä, vaikka Micronkin sai ainakin yhden aseman markkinoille asti.

Intel on nyt ilmoittanut lopettavansa koko Optane-sarjansa lopullisesti, mikä tarkoittaa samalla 3D XPoint -teknologian hautajaisia. Intel ja Micron lopettivat aiemmin yhteistyönsä 3D XPointin parissa, mutta kumpikin sai oikeuden jatkokehittää muisteja omien tarpeittensa mukaan. Micron ilmoitti lopettavansa 3D XPointin kehityksen omalta osaltaan jo viime vuoden keväänä.

Tom’s Hardwaren Inteliltä saaman lausunnon mukaan IDM 2.0 -strategiaan kuuluu yhtiön portfolion järkeistäminen, eli käytännössä kannattamattomien yksiköiden eliminointi mahdollisuuksien mukaan. Yhtiö lupaa kuitenkin huolehtia nykyisten Optane-asiakkaittensa tarpeista siirtymäkaudella muihin muisteihin.

Intelin Optane-asemat eivät saavuttaneet ikinä merkittävää suosiota kuluttajapuolella ja suurin osa menekistä olikin esiasennettujen välimuistilevyjen saralla. Yrityspuolella Optanelle oli enemmänkin kysyntää, mutta Intelin tuore päätös kertoo selvää kieltä sen kannattavuudesta.

Lähde: Tom's Hardware

Linkki alkuperäiseen juttuun