Juha Kokkonen

Ylläpidon jäsen

- Liittynyt

- 17.10.2016

- Viestejä

- 13 959

Xiaomi on esitellyt Pekingissä uudet Mi 9 Pro 5G- ja Mi MIX Alpha -lippulaivapuhelimensa sekä MIUI 11 -käyttöliittymäpäivityksen. Etenkin Mi MIX Alphassa käytetään erittäin poikkeuksellista muotoilua ja materiaaleja ja se onkin eräänlainen konseptilaite Xiaomin osaamisesta ensimmäisen sukupolven Mi MIX:in tapaan.

Kaksikosta Mi MIX Alpha on erittäin poikkeuksellisen näköinen TC4-titaaniseosrungon ja laitteen kylkien yli takakuoreen asti kaartuvan 7,92-tuumaisen (2088 x 2250) Flexible OLED -näytön myötä. Xiaomin mukaan näytön toteuttaminen, virhekosketusten estäminen sekä kaikkien antennien integroiminen puhelimeen oli suuri tekninen haaste. Näyttö tukee paineentunnistusta kyljissä ja kylkipainikkeet ovat toteutettu ohjelmistopohjaisesti ja lineaarisella moottorilla toteutetulla värinäpalautteella.

Puhelin havaitsee missä asennossa se on kädessä ja kytkee automaattisesti taustapuolelle jäävän näytön pois päältä. Takakuoressa kamerat on sijoitettu pystysuuntaiseen näytöttömään keraamikaistaleeseen. Etukamera on jätetty pois, koska takakameroita ja näytön takaosaa voidaan käyttää omakuvien ottamiseen. Puhelin osaa myös näyttää takakuoren puolella tekoälyn ja sijainnin avulla mukautettua sisältöä.

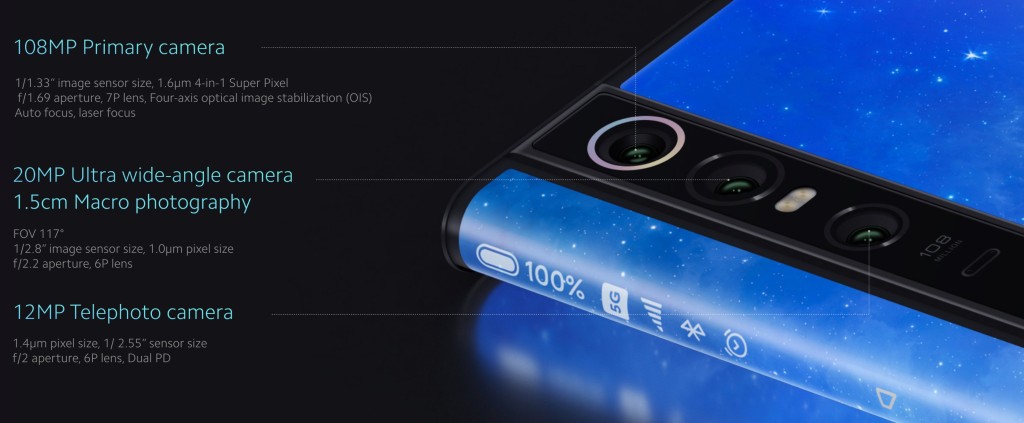

Kamerapuolella Mi MIX Alpha on ensimmäinen älypuhelin, joka käyttää yli 100 megapikselin kamerasensoria. Käytössä on Samsungin valmistama 1/1,33-tuumainen 108 megapikselin Quad Bayer -sensori (12032 x 9024 pikseliä). Sen parina on f1.69-aukkosuhteen optisesti vakautettu objektiivi. Lisäksi takaa safiirilasin alle suojattuna löytyy 20 megapikselin ultralaajakulmakamera f2.2-aukkosuhteella sekä 12 megapikselin telekamera 1,4 um pikselikoolla, 2x zoomilla sekä f2.0-aukkosuhteella.

Rautapuolelta Mi MIX Alphasta löytyy lisäksi Snapdragon 855+ -järjestelmäpiiri, 12 Gt RAM-muistia, 512 Gt UFS 3.0 -tallennustilaa, 4050 mAh nano-piikatodiakku sekä 40 watin pikalataustuki.

Mi MIX Alpha tulee tuotantoon ensin pientuotantoerinä ja yritys pyrkii aloittamaan massatuotannon vielä ennen vuoden loppua. Laitteen suositushinta pientuotantona on 19 999 yuania, eli noin 2560 euroa.

Mi 9 Pro 5G on toteutukseltaan perinteisempi älypuhelin perustuen alkuvuodesta julkaistuun Mi 9 -malliin. Super AMOLED -näyttö on edelleen 6,39-tuumainen Full HD+ -tarkkuudella ja kolmoistakakamera perustuu edelleen 48, 12 ja 16 megapikselin sensoreihin kolmella eri polttovälillä.

Järjestelmäpiiri on päivitetty uusimpaan Snapdragon 855+ -versioon ja sen jäähdytys on toteutettu höyrykammioratkaisulla. Varustukseen kuuluu jopa 12 Gt RAM-muistia, 512 Gt tallennustilaa ja 5G-yhteydet. Mi 9 Pro 5G:stä löytyy myös uusi tehokkaampi kaiutintoteutus sekä voimakkaampi lineaarinen värinämoottori.

Akun kokoa on kasvatettu 700 mAh:lla 4000 mAh:iin, mikä on kaivattu parannus. Latausnopeuksia on kasvatettu ja langallinen lataus onnistuu nyt mukana toimitettavalla 45 watin laturilla, langaton lataaminen lisävarusteena myytävällä jäähdytetyllä laturitelakalla 30 watin teholla ja käänteinen langaton lataus 10 watin teholla. Johdolla akku latautuu tyhjästä täyteen 48 minuutissa ja langattomasti 69 minuutissa.

Mi 9 Pro tulee saataville Kiinassa viikon sisällä 3699-4299 yuanin hintahaarukassa (475-550 euroa). Tarjolle tulee myös 4G-versio, vaikka sitä ei mainittukaan julkaisun yhteydessä.

Xiaomi esitteli tilaisuudessa myös MIUI-käyttöjärjestelmänsä tuoreimman 11-version, joka perustuu Android 10:een. Käyttöliittymän ulkoasua on päivitetty, fonttia vaihdettu ja äänimaailmaa päivitetty. Ominaisuuspuolella uutta on mm. Mi Work -toimistosovellus ja tiedostonhallintakokonaisuus, Mi Go -matkustusapuri, monipuolisempi Always On Display ja ilmaiseksi muutettu teemasovellus. MIUI:n avoin beeta alkaa syyskuun 27. päivä ja viralliset päivitykset alkavat Kiinassa lokakuun puolivälissä.

Lähde: YouTube, Twitter

Huom! Foorumiviestistä saattaa puuttua kuvagalleria tai upotettu video.

Linkki alkuperäiseen uutiseen (io-tech.fi)

Palautelomake: Raportoi kirjoitusvirheestä

Viimeksi muokattu:

.

.