- Liittynyt

- 14.10.2016

- Viestejä

- 24 535

Kaotik kirjoitti uutisen/artikkelin:

DDR5-muistit ovat saapumassa markkinoille vielä kuluvan vuoden aikana, kun Intel julkaisee niitä tukevat Alder Lake -prosessorit. AMD:n puolella DDR5-tukea odotetaan ensimmäisiin AM5-kantaan sopiviin prosessoreihin, olivat ne sitten Zen 3 -päivitysversioita tai Zen 4 -prosessoreita.

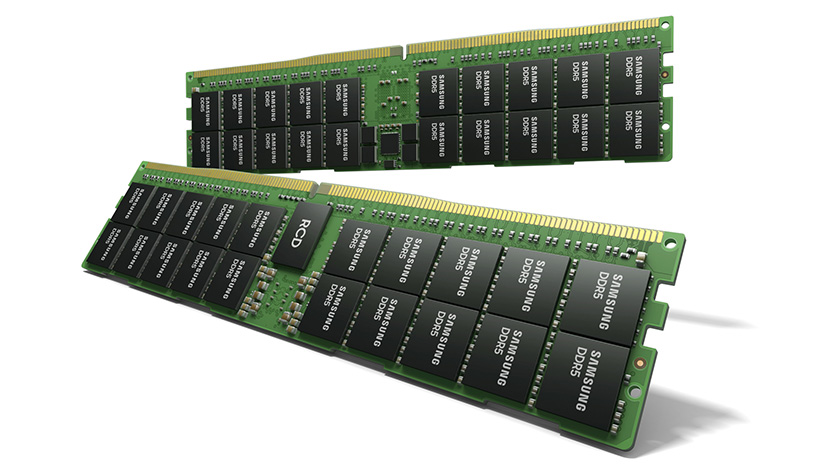

Innokkaimmat muistivalmistajat ovat ehtineet jo esittelemään ja julkaisemaankin ensimmäiset DDR5-muistinsa. Nyt joukkoon liittyy myös Samsung, joskin astetta edelle ehtineitä julkistuksia järeämmin asein. Yhtiö tähtääkin nyt esitellyillä muisteilla lähinnä Intelin Sapphire Rapids- ja AMD:n Genoa-palvelinalustoille.

Samsungin julkistamat DDR5-muistit tulevat saataville 512 Gt:n kapasiteetilla ja parhaimmillaan DDR5-7200-nopeudella. Ne ovat ensimmäiset HKMG-prosessia (High-K Metal Gate, Korkean K-arvon metallihila)) hyödyntävät DDR5-muistit, mutta Samsungilla on aiemmin kokemusta HKMG:n käytöstä yhtiön GDDR6-muisteissa. Korkeaan kapasiteettiin per muistikampa on päästy hyödyntämällä TSV-läpivientejä (Through-Silicon-Via) ja pinoamalla päällekäin kahdeksan 16 gigabitin DDR5-muistisirua ja muistikammalle yhteensä jopa 40 DDR5-muistipiiriä. Ylimääräiset kahdeksan muistipiiriä selittyvät muistien ECC-virheenkorjauksella, jota ei tule sekoittaa DDR5-muistien sisäiseen ECC-virheenkorjaukseen.

Lähde: Samsung

Linkki alkuperäiseen juttuun