- Liittynyt

- 14.10.2016

- Viestejä

- 22 495

Kaotik kirjoitti uutisen/artikkelin:

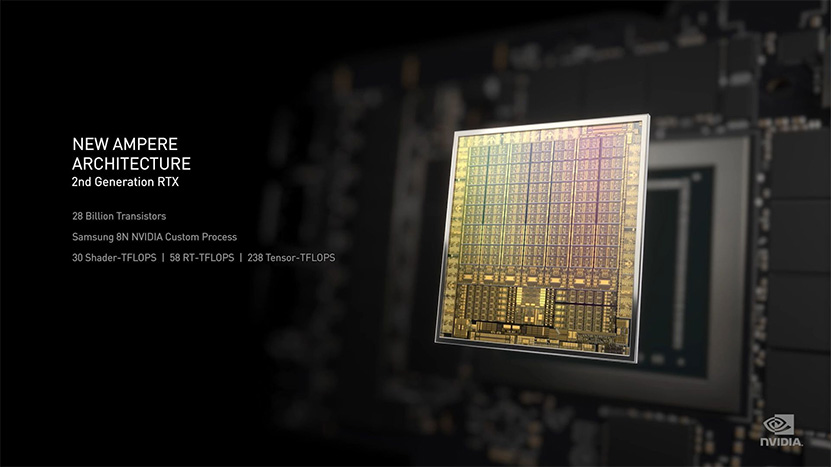

NVIDIA julkaisi edellispäivänä uudet Ampere-arkkitehtuuriin perustuvat GeForce RTX 30 -sarjan näytönohjaimet. Itse keynote-tilaisuudessa näytönohjaimet ja niiden ominaisuudet esiteltiin lähinnä pintapuolisesti ja nyt yhtiö on vastannut joihinkin kysymyksiin uusista näytönohjaimista Redditissä.

NV_Tim -nimimerkillä Redditissä liikkuva NVIDIAn edustaja on koostanut yhteen postaukseen yhtiön muiden edustajien tiivistetyt vastaukset monien kysymiin kysymyksiin uusista GeForce-näytönohjaimista. Vastaukset antavat uutta tietoa myös arkkitehtuurin sisäisitä piirteistä, mutta paljon pureksittavaa on jäämässä myöhemmin julkaistavaan whitepaper-julkaisuun sekä näytönohjainten arvosteluihin.

NVIDIAn rajusti kasvanut CUDA-ydinten määrä nostatti useita kulmakarvoja ja Tony Tamasi avasi Ampere-arkkitehtuurissa tehtyjä muutoksia, mitkä johtivat uusiin lukuihin. Turing-arkkitehtuurissa NVIDIAn SM-yksiköt rakentuvat yhteensä neljästä elementistä, joista kussakin on kaksi datapolkua: yksi FP32-CUDA-ytimille ja toinen INT32-ytimille. Amperessa on edelleen samat kaksi datapolkua, mutta nyt toinen poluista voi laskea pelkkien INT32-laskujen sijasta joko INT32- tai FP32-laskuja. Turingin SM-yksikön elementit kykenivät siis yhdessä kellojaksossa 16 FP32- ja 16 INT32-laskuun, kun Amperen kykenevät joko 32 FP32-laskuun tai 16 FP32- ja 16 INT32-laskuun. NVIDIA laskee CUDA-ytimiksi vain FP32:een kykenevät yksiköt, minkä myötä niiden määrä siruissa on nyt kaksinkertaistunut. Tulemme pureutumaan aiheeseen tarkemmin Ampere-arkkitehtuuria käsittelevässä artikkelissamme myöhemmin.

Moni on ihmetellyt myös RTX 3080:n ”vain” 10 gigatavun muistia, etenkin kun RTX 3090 -mallissa sitä on peräti 24 Gt. NVIDIAn näkemyksen mukaan 10 Gt on riittävä nykyisille ja tuleville peleille 4K-resoluutiolle asti. Yhtiön mukaan useimmat pelit käyttäisivät todellisuudessa vain 4 – 6 Gt muistia kyseisellä resoluutiolla. Myös muistin hinnalla on ollut luonnollisesti merkitystä, eikä näytönohjainta olisi voitu julkaista samaan hintaan suuremmalla muistimäärällä.

NVIDIA varmisti lisäksi, että heidän käyttämänsä HDMI 2.1 -linkki tukee täyttä 48 Gbps:n nopeutta sekä Display Stream Compression -teknologiaa. Ne riittävät parhaimmillaan 8K-resoluution 60 hertsin virkistystaajuudella ja 12-bittisillä HDR-väreillä ilman kroman alinäytteistystä. Videonpakkauksesta Amperessa huolehtii sama 7. sukupolven NVENC-versio, kuin Turingeissa, mutta purkupuolesta on vastuussa uusi 5. sukupolven NVDEC, mihin on lisätty tuki AV1-purulle.

Väylänopeuksiin liittyvä ihmetyksen aihe on PCI Expressin nopeus, tai pikemminkin rajoittaako PCI Express 3.0 uusia näytönohjaimia. NVIDIAn edustajan mukaan suorituskykyero PCIe 3.0:n ja 4.0:n välillä on useimmiten vain muutamia prosentteja ja käytettävän prosessorin suorituskyvyn merkitsevän enemmän, kuin näytönohjaimen väylän nopeuden.

NVIDIAn eksoottinen jäähdytysratkaisu RTX 3080- ja RTX 3090 -malleissa on myös herättänyt paljon keskustelua ja kysymyksiä. NVIDIAn mukaan jäähdytys tulee toimimaan normaalisti kotelossa kuin kotelossa riippumatta näytönohjaimen varsinaisesta asennosta, kunhan kotelosta löytyy tuuletin syöttämään näytönohjaimelle viileää ilmaa ja toinen puhaltamaan kuumaa ilmaa ulos kotelosta, kun näytönohjaimen taaempi tuuletin on ensin imenyt sen jäähdytysrivaston läpi. RTX 3090:n ”The Silencer” -coolerin kerrotaan olevan hiljaisempi kuin Titan RTX:n tai RTX 2080 Superin Founders Edition -versiot, mutta yhtiö ei lähtenyt vertaamaan sitä näytönohjainvalmistajien omiin jäähdytysratkaisuihin.

RTX IO:n osalta yhtiö varmisti, että teknologia tulee olemaan tuettu vain Windows 10 -käyttöjärjestelmällä ja vaativan NVMe-teknologiaan perustuvan SSD-aseman. Syykin tälle on selvä, sillä RTX IO:n hyödyntämiseen vaadittu DirectStorage-rajapinta on tulossa vain Windows 10 -käyttöjärjestelmille. Lisäksi pelinkehittäjien pitää tukea DirectStorage-rajapintaa erikseen, eikä se ole automaattisesti tuettu kaikissa uusissa peleissä.

NVIDIA Broadcast -sovellus poikkeaa merkittävästi siitä kuvasta, mikä siitä annettiin keynote-lähetyksessä. Sen sijasta, että kyse olisi kilpailijasta esimerkiksi OBS:n streamaussovellukselle, kyse on lisätyökalusta Streamlabsin ja muiden vastaavien tueksi. NVIDIA Broadcastia käytetään välikerroksena, johon voidaan liittää esimerkiksi webbikameran ja mikrofonin sisääntulot erilaisten tekoälypohjaisten efektien, kuten virtuaalisen greenscreenin, käyttöön. Sen jälkeen sovellus luo virtuaalilaitteet, mitä voidaan käyttää lähteenä esimerkiksi Streamlabsissa tai muussa vastaavassa sovelluksessa.

Lähde: Reddit

Linkki alkuperäiseen juttuun