- Liittynyt

- 14.10.2016

- Viestejä

- 22 495

Kaotik kirjoitti uutisen/artikkelin:

New World on Amazon Gamesin kehittämä MMO-peli, joka on tällä hetkellä edennyt beetavaiheeseen. Kaikki ei ole kuitenkaan sujunut kuin ruusulla tanssien, sillä nyt nettiin on alkanut valua ikäviä ja suorastaan outoja raportteja sen tiimoilta: peli hajottaa näytönohjaimia.

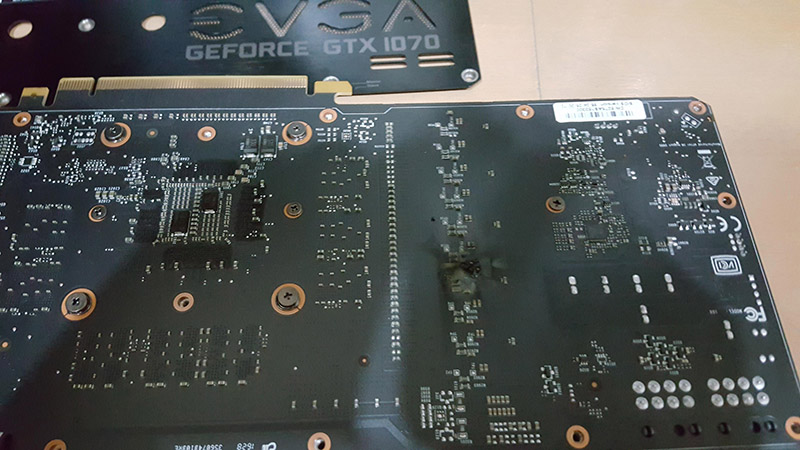

Useiden eri käyttäjäraporttien mukaan New Worldin beetaversio voi kirjaimellisesti hajottaa ainakin GeForce RTX 3090 -näytönohjaimia. Yhden käyttäjän tapauksessa pelin alfaversio oli jo tappanut yhden RTX 3090:n ja nyt beetaversio toisen. Suurimmassa osassa raportoiduista tapauksista kyseessä on EVGA:n GeForce RTX 3090 FTW3 Ultra -malli, mutta mukaan mahtuu myös Gigabyten näytönohjaimia sekä NVIDIAn Founders Edition -malleja.

Windows Centralin mukaan muiden RTX 3090 -mallien käyttäjät ovat lisäksi raportoineet ylikuumenemisista ja virtapiikeistä, vaikkei näytönohjaimet olekaan hajonneet. Tämän perusteella vaikuttaa siltä, että viritetyimmillä ja/tai heikoimmilla piirilevyillä varustetuilla RTX 3090 -näytönohjaimilla ne ovat yksinkertaisesti liikaa, eivätkä näytönohjainten suojamekanismit toimi, kuten niiden pitäisi.

Yleisimmän teorian mukaan ongelmien takaa löytyisi pelin valikoiden ja odotustilan rajoittamaton ruudunpäivitysnopeus. Osalle käyttäjistä ongelmat ovat ilmaantuneet kuitenkin vasta itse pelin puolella, eikä ruudunpäivitysnopeuden rajoittaminen V-Syncillä tai muilla rajoittimilla ilmeisesti auta tilanteeseen mitenkään, mikä syö maata yleisimmän teorian alta.

Peli julkaistaan näillä näkymin 31. elokuuta, mutta sen suljettuun beetaan pääsee mukaan ostamalla pelin ennakkoon. Tässä vaiheessa onkin syytä kehottaa GeForce RTX 3090 -käyttäjiä varovaisuuteen kyseisen pelin kohdalla.

Lähteet: New World, Reddit, Windows Central

Linkki alkuperäiseen juttuun

Viimeksi muokattu:

eli vielä ei ole varsinaisesti AMD kortteja hajonnut. En ainakaan äkkiseltää googlaamalla löytänyt. Itellä ei fps menny menussa yli 144 fps vaikka vsync pois pelistä ja fps unlocked. Varmaan ajureissa joku muu päällä..

eli vielä ei ole varsinaisesti AMD kortteja hajonnut. En ainakaan äkkiseltää googlaamalla löytänyt. Itellä ei fps menny menussa yli 144 fps vaikka vsync pois pelistä ja fps unlocked. Varmaan ajureissa joku muu päällä..